人工智能的基石——张量的介绍与应用

你有没有想过人工智能(AI)算法是如何处理各种非结构化数据的?比如当你输入音频数据,或者让算法处理图像或文本时会发生什么。其实,这并不是什么高深的火箭科学。它只是将这些数据作为张量来处理。

如果你上过一些大学数学或者大学物理课,你应该对张量有所了解。但这并不是理解本文的必要条件。这篇文章就是为了解释这一点;在这里,你将了解什么是张量以及它们是如何在构建AI系统中使用的。

一、准备阶段

为了充分利用本文,你应该:

- 掌握使用Python编程语言进行编码的知识。

- 熟悉用于深度学习的PyTorch框架。然而,这不是一个严格的要求,因为本课程中的PyTorch代码将被详细解释,基本的Python理解就足够了。

- 不要被AI算法背后的数学所吓倒(这里没有数学恐惧!)。 现在让我们开始吧!

二、什么是张量?

就像 Python 中的数组和矩阵一样,张量是人工智能中的基本数据结构,提供了在模型中存储输入和输出数据的方法。

从技术的角度来看,张量可以根据它们所代表的数据在维数上变化。例如,一个单一的标量值被认为是一个零维张量,而一个值数组被认为是一个一维张量。更复杂的数据,如图像或视频帧,存储为高维张量,从而能够有效地处理大型数据集。

张量表示一种结构化的格式,用于组织神经网络操作所必需的信息。无论是在神经网络中表示输入数据、权值还是偏差,张量都为处理各种形式的数据提供了通用的框架。

三、神经网络的解剖

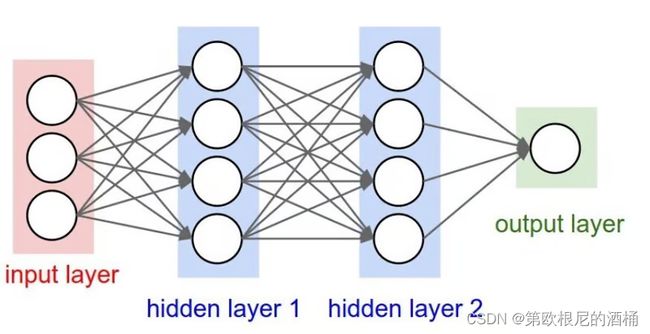

理解神经网络的解剖对于掌握张量在AI中的实际应用至关重要。神经网络是一种AI算法,它接受数据作为输入,执行计算任务,并返回输出。这些输入可能包括猫和狗的图像或文本消息。任务可能包括将图像分类为狗或猫,或将文本消息分类为垃圾邮件或非垃圾邮件。

四、神经网络的层次

1.输入层(Input Layer):输入层接收数据,通常以张量的形式表示,并将其传递给后续层进行处理。

2.隐藏层(Hidden Layers):隐藏层位于输入层和输出层之间,通过加权连接和激活函数对输入数据进行复杂的转换。

3.输出层(Output Layer):输出层基于处理后的输入数据产生最终的预测或分类。

五、张量在神经网络中的作用

张量在神经网络中的作用 在计算机能够理解数据输入中发生的事情之前,它们需要将其表示为数字。换句话说,对数据进行数值编码是必不可少的。张量作为编码这些数据的手段,存储了神经网络中的权重、偏置和中间计算。随着神经网络通过其层处理数据,张量促进了数据的高效操纵和信息传播,使网络能够学习并作出预测。

六、处理张量

欢迎来到本文的编码部分!现在你已经了解了什么是张量以及它们如何影响AI,让我们开始使用张量吧。

理解张量操作对于使用PyTorch或TensorFlow这样的深度学习框架至关重要。张量操作是对多维数组进行的基本数学操作。掌握这些操作有助于高效实现神经网络、数据预处理和模型训练。

在调试、优化性能和理解机器学习算法背后的数学原理方面,熟练掌握张量操作至关重要。

我们将使用 PyTorch 来实现张量操作。如果您不熟悉 PyTorch,它是一个深度学习框架,可以将 AI 从研究无缝转换到部署。它很容易理解,特别是如果您对 Python 有基本的理解。

在本教程中,我将使用 Google Colab。原因是 Google Colab 预先安装了 PyTorch 和其他必要的框架,省去了我们再次安装它们的麻烦。如果您更喜欢在本地机器上使用 PyTorch,可以参考 PyTorch 文档中的这个指南。

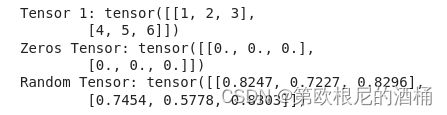

创建张量

在PyTorch中创建张量与在NumPy中处理数组类似。然而,在PyTorch中,我们使用torch.tensor类。

import torch

# 从 Python 列表中创建张量

tensor1 = torch.tensor([[1, 2, 3], [4, 5, 6]])

# 创建一个带形状(2,3)的零张量

zeros_tensor = torch.zeros(2, 3)

# 创建一个带形状(2,3)的随机值张量

random_tensor = torch.rand(2, 3)

# 打印张量

print("Tensor 1:", tensor1)

print("Zeros Tensor:", zeros_tensor)

print("Random Tensor:", random_tensor)结果

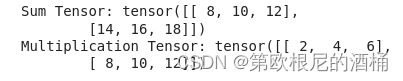

张量基本运算

使用 PyTorch,您可以对张量执行各种算术运算:

# 相加

tensor2 = torch.tensor([[7, 8, 9], [10, 11, 12]])

sum_tensor = tensor1 + tensor2

# 相乘

mul_tensor = tensor1 * 2

print("Sum Tensor:", sum_tensor)

print("Multiplication Tensor:", mul_tensor)结果:

重塑张量

你可以改变张量的尺寸。在这个例子中,我将把原始张量(有两行和三列)转换成一个有三行和两列的张量。

# 将tensor1重新塑造成(3,2)的形状

reshaped_tensor = tensor1.view(3, 2)

print("Original Tensor:", tensor1)

print("Reshaped Tensor:", reshaped_tensor)结果:

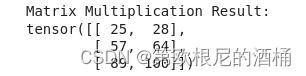

矩阵相乘

您可以使用 PyTorch 中的 torch.matmul ()函数执行矩阵乘法。这个函数以两个张量作为输入,并返回它们的矩阵乘法结果。

# 矩阵相乘

tensor3 = torch.tensor([[1, 2], [3, 4], [5, 6]])

tensor4 = torch.tensor([[7, 8], [9, 10]])

# 执行矩阵乘法

matmul_result = torch.matmul(tensor3, tensor4)

print("Matrix Multiplication Result:")

print(matmul_result)结果

索引和切片

类似于 NumPy 数组和 Python 列表,PyTorch 中的张量支持索引和切片操作。这意味着您可以访问张量中的特定元素或元素子集。让我告诉你怎么做:

# 索引

element = tensor3[0, 1] # Access element at row 0, column 1

# 切片

slice_tensor = tensor3[:, 1] # Slice all rows, only the second column

print("Indexed Element:", element)

print("Sliced Tensor:")

print(slice_tensor)

结果

这些基本操作奠定了基础,为更先进的张量操作,因为你钻研各种人工智能算法。理解这些基础知识对于有效地使用张量和在张量的基础上处理人工智能中更复杂的任务是至关重要的。

七、总结

张量是人工智能模型的核心,是学习和决策所需的关键信息的容器。无论是识别图像、理解语言还是预测趋势,张量在人工智能的各个方面都是不可或缺的。

通过掌握张量运算,你已经迈出了精通人工智能的第一步。但请记住,在这个领域总有更多的东西需要探索和学习。因此,继续实验,继续构建,继续推进人工智能的界限。谁知道呢?下一个突破可能就在拐角处!

因此,当你探索人工智能时,保持好奇心,保持创造力,最重要的是,享受这个过程。编码愉快!