- 转的网络资料

hemmingway

DeepLearning(深度学习):ufldl的2个教程(这个没得说,入门绝对的好教程,Ng的,逻辑清晰有练习):一ufldl的2个教程(这个没得说,入门绝对的好教程,Ng的,逻辑清晰有练习):二Bengio团队的deeplearning教程,用的theano库,主要是rbm系列,搞python的可以参考,很不错。deeplearning.net主页,里面包含的信息量非常多,有software,

- 神经网络常用的训练方式,神经网络是怎么训练的

小六oO

智能写作神经网络机器学习深度学习

深度神经网络是如何训练的?Coursera的Ng机器学习,UFLDL都看过。没记错的话Ng的机器学习里是直接给出公式了,虽然你可能知道如何求解,但是即使不知道完成作业也不是问题,只要照着公式写就行。反正我当时看的时候心里并没能比较清楚的明白。我觉得想了解深度学习UFLDL教程-Ufldl是不错的。有习题,做完的话确实会对深度学习有更加深刻的理解,但是总还不是很清晰。后来看了LiFeiFei的Sta

- 反向传播是怎么回事?详细教程2019-05-22

loveevol

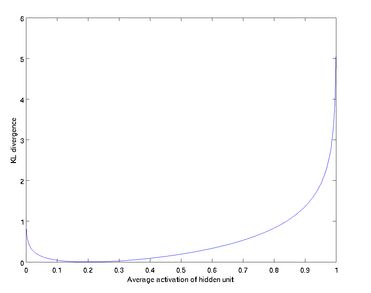

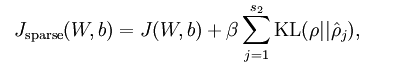

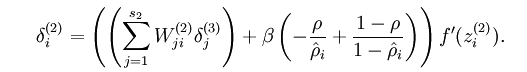

反向传播的详细推导一文弄懂神经网络中的反向传播法——BackPropagation最近在看深度学习的东西,一开始看的吴恩达的UFLDL教程,有中文版就直接看了,后来发现有些地方总是不是很明确,又去看英文版,然后又找了些资料看,才发现,中文版的译者在翻译的时候会对省略的公式推导过程进行补充,但是补充的又是错的,难怪觉得有问题。反向传播法其实是神经网络的基础了,但是很多人在学的时候总是会遇到一些问题,

- UFLDL新版教程与编程练习(六):Multi-Layer Neural Network(多层神经网络)

赖子啊

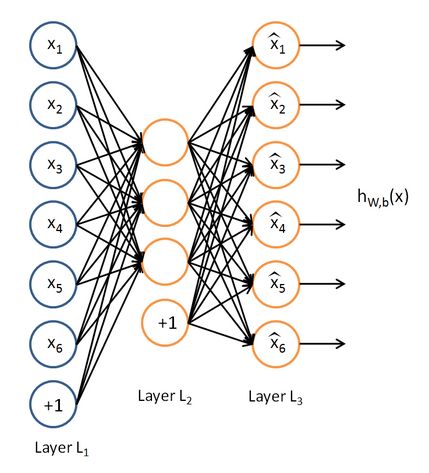

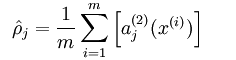

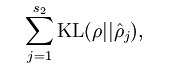

UFLDL是吴恩达团队编写的较早的一门深度学习入门,里面理论加上练习的节奏非常好,每次都想快点看完理论去动手编写练习,因为他帮你打好了整个代码框架,也有详细的注释,所以我们只要实现一点核心的代码编写工作就行了,上手快!我这里找不到新版对应这块的中文翻译了,-_-,趁早写一下,否则又没感觉了!第六节是:Multi-LayerNeuralNetwork(多层神经网络)多层神经网络,其实讲的就是全连接层

- git使用指令集

lxlchick

gitcommit-m'第一次修改'

[email protected]:lxl-2404/UFLDL_Python.gitgitRemoteRepository或者gitclonehttps://github.com/lxl-2404/UFLDL_Python.gitgitRemoteRepository最后的‘gitRemoteRepository’是给本地分支起的名字,新建的仓库文件

- 数据预处理之数据归一化

sunny冰青

机器学习算法Matlab算法机器学习数据预处理

转载来自ufldl.stanford.edu/wiki/index.php/数据预处理一、简单缩放分为:最大值缩放和均值缩放在简单缩放中,我们的目的是通过对数据的每一个维度的值进行重新调节(这些维度可能是相互独立的),使得最终的数据向量落在[0,1]或[−1,1]的区间内(根据数据情况而定)。例子:在处理自然图像时,我们获得的像素值在[0,255]区间中,常用的处理是将这些像素值除以255,使它们

- 机器学习

_铁憨憨

DeepLearning(深度学习):ufldl的2个教程(这个没得说,入门绝对的好教程,Ng的,逻辑清晰有练习):一ufldl的2个教程(这个没得说,入门绝对的好教程,Ng的,逻辑清晰有练习):二Bengio团队的deeplearning教程,用的theano库,主要是rbm系列,搞python的可以参考,很不错。deeplearning.net主页,里面包含的信息量非常多,有software,

- softmax

有花落蝶

https://www.zhihu.com/question/41252833http://ufldl.stanford.edu/wiki/index.php/Softmax%E5%9B%9E%E5%BD%92屏幕快照2018-04-08下午11.26.14.png其中p为真实分布,q非真实分布。(q越接近p交叉熵的值越低)在softmax分类算法中,使用交叉熵来进行样本预测(交叉熵越低,样本预测

- 本人常用资源整理(ing...)

weixin_34085658

DeepLearning(深度学习):ufldl的2个教程(这个没得说,入门绝对的好教程,Ng的,逻辑清晰有练习):一ufldl的2个教程(这个没得说,入门绝对的好教程,Ng的,逻辑清晰有练习):二Bengio团队的deeplearning教程,用的theano库,主要是rbm系列,搞python的可以参考,很不错。deeplearning.net主页,里面包含的信息量非常多,有software,

- 深度学习 Deep Learning UFLDL 最新Tutorial 学习笔记 5:Softmax Regression

songrotek

DeepLearningdeeplearningmachinelearningmatlab深度学习gradient

SoftmaxRegressionTutorial地址:http://ufldl.stanford.edu/tutorial/supervised/SoftmaxRegression/从本节开始,难度开始加大了,我将更详细地解释一下这个Tutorial。1SoftmaxRegression介绍前面我们已经知道了LogisticRegression,简单的说就判断一个样本属于1或者0,在应用中比如手

- 深度学习 Deep Learning UFLDL 最新Tutorial 学习笔记 3:Vectorization

songrotek

DeepLearningmachinelearning深度学习UFLDLdeeplearning

1Vectorization简述Vectorization翻译过来就是向量化,各简单的理解就是实现矩阵计算。为什么MATLAB叫MATLAB?大概就是MatrixLab,最根本的区别于其他通用语言的地方就是MATLAB可以用最直观的方式实现矩阵运算,MATLAB的变量都可以是矩阵。通过Vectorization,我们可以将代码变得极其简洁,虽然简洁带来的问题就是其他人看你代码就需要研究一番了。但任

- 深度学习 Deep Learning UFLDL 最新 Tutorial 学习笔记 1:Linear Regression

aofan9566

1前言AndrewNg的UFLDL在2014年9月底更新了。对于開始研究DeepLearning的童鞋们来说这真的是极大的好消息!新的Tutorial相比旧的Tutorial添加了ConvolutionalNeuralNetwork的内容。了解的童鞋都知道CNN在ComputerVision的重大影响。而且从新编排了内容及exercises。新的UFLDL网址为:http://ufldl.stan

- 机器学习--神经网络算法系列--BackPropagation算法

日有所进

机器学习机器学习算法神经网络

一文弄懂神经网络中的反向传播法——BackPropagation最近在看深度学习的东西,一开始看的吴恩达的UFLDL教程,有中文版就直接看了,后来发现有些地方总是不是很明确,又去看英文版,然后又找了些资料看,才发现,中文版的译者在翻译的时候会对省略的公式推导过程进行补充,但是补充的又是错的,难怪觉得有问题。反向传播法其实是神经网络的基础了,但是很多人在学的时候总是会遇到一些问题,或者看到大篇的公式

- 神经网络训练的一般步骤,神经网络的训练与测试

aifans_bert

神经网络神经网络深度学习机器学习dnn

深度神经网络是如何训练的?Coursera的Ng机器学习,UFLDL都看过。没记错的话Ng的机器学习里是直接给出公式了,虽然你可能知道如何求解,但是即使不知道完成作业也不是问题,只要照着公式写就行。反正我当时看的时候心里并没能比较清楚的明白。我觉得想了解深度学习UFLDL教程-Ufldl是不错的。有习题,做完的话确实会对深度学习有更加深刻的理解,但是总还不是很清晰。后来看了LiFeiFei的Sta

- UFLDL教程(四)之Softmax回归

weixin_30509393

数据结构与算法人工智能

关于AndrewNg的machinelearning课程中,有一章专门讲解逻辑回归(Logistic回归),具体课程笔记见另一篇文章。下面,对Logistic回归做一个简单的小结:给定一个待分类样本x,利用Logistic回归模型判断该输入样本的类别,需要做的就是如下两步:①计算逻辑回归假设函数的取值hθ(x),其中n是样本的特征维度②如果hθ(x)>=0.5,则x输入正类,否则,x属于负类或者直

- 深度神经网络的训练过程,深度神经网络训练方法

普通网友

神经网络

深度神经网络是如何训练的?Coursera的Ng机器学习,UFLDL都看过。没记错的话Ng的机器学习里是直接给出公式了,虽然你可能知道如何求解,但是即使不知道完成作业也不是问题,只要照着公式写就行。反正我当时看的时候心里并没能比较清楚的明白。我觉得想了解深度学习UFLDL教程-Ufldl是不错的。有习题,做完的话确实会对深度学习有更加深刻的理解,但是总还不是很清晰。后来看了LiFeiFei的Sta

- 训练神经网络的详细步骤,神经网络训练过程图解

普通网友

神经网络深度学习机器学习

深度神经网络是如何训练的?Coursera的Ng机器学习,UFLDL都看过。没记错的话Ng的机器学习里是直接给出公式了,虽然你可能知道如何求解,但是即使不知道完成作业也不是问题,只要照着公式写就行。反正我当时看的时候心里并没能比较清楚的明白。我觉得想了解深度学习UFLDL教程-Ufldl是不错的。有习题,做完的话确实会对深度学习有更加深刻的理解,但是总还不是很清晰。后来看了LiFeiFei的Sta

- BP神经网络的实现详解

CaiziLee

MachineLearning神经网络

本文主要详解BP神经网络编程实现,旨在一步一步解析BP神经网络细节,希望能形象明了的阐述BP神经网络,实现原理源自于斯坦福UFLDL教程,原理公式推导不再赘述,但会有些说明,本文程序由C++11实现,矩阵计算基于Eigen3(不熟悉的可以去网上搜索Eigen的使用方法,本文不做叙述),那么我们开始吧!为了给算法列一个提纲,首先截一个UFLDL教程上关于BP算法的步骤,做个引导:下面是神经网络一次批

- 机器学习 网站大全--陆续更新中

lizz2276

机器学习人工智能

1、neuralnetworksanddeeplearning.com2、deeplearningbook.org3、ufldl.Stanford.edu/tutorial/4、Coursera.org/learn/machine-learning/resources/NrY2G5、MachineLearningCrashCourse|GoogleDevelopers6、AnalyticsVidh

- 深度学习参考资料

xiaogss

深度学习深度学习

DeepLearning(深度学习)ufldl的2个教程(这个没得说,入门绝对的好教程,Ng的,逻辑清晰有练习):一ufldl的2个教程(这个没得说,入门绝对的好教程,Ng的,逻辑清晰有练习):二Bengio团队的deeplearning教程,用的theano库,主要是rbm系列,搞python的可以参考,很不错。deeplearning.net主页,里面包含的信息量非常多,有software,r

- 深度学习资料链接整理

mydear_11000

DeepLearning(深度学习)ufldl的2个教程(这个没得说,入门绝对的好教程,Ng的,逻辑清晰有练习):一ufldl的2个教程(这个没得说,入门绝对的好教程,Ng的,逻辑清晰有练习):二Bengio团队的deeplearning教程,用的theano库,主要是rbm系列,搞python的可以参考,很不错。deeplearning.net主页,里面包含的信息量非常多,有software,r

- lenet5卷积神经网络过程_卷积神经网络(一):LeNet5的基本结构

有木桑

lenet5卷积神经网络过程

在机器视觉,图像处理领域,卷积神经网络取得了巨大的成功。本文将参考UFLDL和DEEPLEARNING.NET的教程,结合自己的理解,梳理一下卷积神经网络的构成以及其BP算法的求解。虽然利用theano可以方便的实现LeNet5,但是不利于学习和理解卷积神经网络,所以最后会自己动手用Python实现一个简单的LeNet5,并尝试利用python的PyCUDA库进行加速。首先看LeNet5的结构,如

- 【深度学习——ANN】一文读懂BP神经网络

Lily_9

深度学习BP神经网络

转自一位懂生活的女神的博客园的文章。http://www.cnblogs.com/charlotte77/p/5629865.html最近在看深度学习的东西,一开始看的吴恩达的UFLDL教程,有中文版就直接看了,后来发现有些地方总是不是很明确,又去看英文版,然后又找了些资料看,才发现,中文版的译者在翻译的时候会对省略的公式推导过程进行补充,但是补充的又是错的,难怪觉得有问题。反向传播法其实是神经网

- CV&DL&ML等资源整理

magic_andy

DeepLearningPatternRecognitionMachineLearning资料整理

原文地址:http://www.cnblogs.com/tornadomeetDeepLearning(深度学习):ufldl的2个教程(这个没得说,入门绝对的好教程,Ng的,逻辑清晰有练习):一ufldl的2个教程(这个没得说,入门绝对的好教程,Ng的,逻辑清晰有练习):二Bengio团队的deeplearning教程,用的theano库,主要是rbm系列,搞python的可以参考,很不错。de

- Machine Learning 网络资源

jianwushuang

其他

转自:http://www.cnblogs.com/tornadomeet/archive/2012/05/24/2515980.html本人常用资源整理(ing...)DeepLearning(深度学习):ufldl的2个教程(这个没得说,入门绝对的好教程,Ng的,逻辑清晰有练习):一ufldl的2个教程(这个没得说,入门绝对的好教程,Ng的,逻辑清晰有练习):二Bengio团队的deeplea

- 深度学习资料链接整理(囊括ML,DL,CV团队,网站,优秀博客,实验室等大堆资料集)

ciky奇

深度学习/机器学习计算机视觉DLMLCV

下面内容是转自:https://blog.csdn.net/mydear_11000/article/details/50864405要些牛逼的话,估计这些得看完了就成仙了!DeepLearning(深度学习)ufldl的2个教程(这个没得说,入门绝对的好教程,Ng的,逻辑清晰有练习):一ufldl的2个教程(这个没得说,入门绝对的好教程,Ng的,逻辑清晰有练习):二Bengio团队的deeple

- 深度学习资料整理(压缩感知)

曼陀罗彼岸花

深度学习

近这两年里deeplearning技术在图像识别和跟踪等方面有很大的突破,是一大研究热点,里面涉及的数学理论和应用技术很值得深入研究,这系列博客总结了深度学习的博客,原理等资料,供大家学习讨论。一、深度学习资料整理(博客类)二、深度学习资料整理(文章类)三、深度学习资料整理(软件资源)四、深度学习原理(关键技术总结,斯坦福大学UFLDL教程)五、深度学习资料整理(深度神经网络理解)六、深度学习资料

- 机器学习、深度学习、数据挖掘各种资源整理

GarfieldEr007

机器学习机器学习深度学习数据挖掘资源整理

DeepLearning(深度学习):ufldl的2个教程(这个没得说,入门绝对的好教程,Ng的,逻辑清晰有练习):一ufldl的2个教程(这个没得说,入门绝对的好教程,Ng的,逻辑清晰有练习):二Bengio团队的deeplearning教程,用的theano库,主要是rbm系列,搞python的可以参考,很不错。deeplearning.net主页,里面包含的信息量非常多,有software,

- AI-图书馆(一)

ailib

知识整理库深度学习计算机视觉自然语言处理人工智能-神经网络算法

本文章有转载自其它博文,也有自己发现的新库添加进来的,如果发现有新的库,可以推荐我加进来转自:http://blog.csdn.net/sherry_gp/article/details/51436627DeepLearning(深度学习):ufldl的2个教程(这个没得说,入门绝对的好教程,Ng的,逻辑清晰有练习):一ufldl的2个教程(这个没得说,入门绝对的好教程,Ng的,逻辑清晰有练习):

- cnn输出每一类的概率matlab,[Deep Learning]两层CNN的MATLAB实现

楚予微茫

想自己动手写一个CNN很久了,论文和代码之间的差距有一个银河系那么大。在实现两层的CNN之前,首先实现了UFLDL中与CNN有关的作业。然后参考它的代码搭建了一个一层的CNN。最后实现了一个两层的CNN,码代码花了一天,调试花了5天,我也是醉了。这里记录一下通过代码对CNN加深的理解。首先,dataset是MNIST。这里层的概念是指convolution+pooling,有些地方会把convol

- 如何用ruby来写hadoop的mapreduce并生成jar包

wudixiaotie

mapreduce

ruby来写hadoop的mapreduce,我用的方法是rubydoop。怎么配置环境呢:

1.安装rvm:

不说了 网上有

2.安装ruby:

由于我以前是做ruby的,所以习惯性的先安装了ruby,起码调试起来比jruby快多了。

3.安装jruby:

rvm install jruby然后等待安

- java编程思想 -- 访问控制权限

百合不是茶

java访问控制权限单例模式

访问权限是java中一个比较中要的知识点,它规定者什么方法可以访问,什么不可以访问

一:包访问权限;

自定义包:

package com.wj.control;

//包

public class Demo {

//定义一个无参的方法

public void DemoPackage(){

System.out.println("调用

- [生物与医学]请审慎食用小龙虾

comsci

生物

现在的餐馆里面出售的小龙虾,有一些是在野外捕捉的,这些小龙虾身体里面可能带有某些病毒和细菌,人食用以后可能会导致一些疾病,严重的甚至会死亡.....

所以,参加聚餐的时候,最好不要点小龙虾...就吃养殖的猪肉,牛肉,羊肉和鱼,等动物蛋白质

- org.apache.jasper.JasperException: Unable to compile class for JSP:

商人shang

maven2.2jdk1.8

环境: jdk1.8 maven tomcat7-maven-plugin 2.0

原因: tomcat7-maven-plugin 2.0 不知吃 jdk 1.8,换成 tomcat7-maven-plugin 2.2就行,即

<plugin>

- 你的垃圾你处理掉了吗?GC

oloz

GC

前序:本人菜鸟,此文研究学习来自网络,各位牛牛多指教

1.垃圾收集算法的核心思想

Java语言建立了垃圾收集机制,用以跟踪正在使用的对象和发现并回收不再使用(引用)的对象。该机制可以有效防范动态内存分配中可能发生的两个危险:因内存垃圾过多而引发的内存耗尽,以及不恰当的内存释放所造成的内存非法引用。

垃圾收集算法的核心思想是:对虚拟机可用内存空间,即堆空间中的对象进行识别

- shiro 和 SESSSION

杨白白

shiro

shiro 在web项目里默认使用的是web容器提供的session,也就是说shiro使用的session是web容器产生的,并不是自己产生的,在用于非web环境时可用其他来源代替。在web工程启动的时候它就和容器绑定在了一起,这是通过web.xml里面的shiroFilter实现的。通过session.getSession()方法会在浏览器cokkice产生JESSIONID,当关闭浏览器,此

- 移动互联网终端 淘宝客如何实现盈利

小桔子

移動客戶端淘客淘寶App

2012年淘宝联盟平台为站长和淘宝客带来的分成收入突破30亿元,同比增长100%。而来自移动端的分成达1亿元,其中美丽说、蘑菇街、果库、口袋购物等App运营商分成近5000万元。 可以看出,虽然目前阶段PC端对于淘客而言仍旧是盈利的大头,但移动端已经呈现出爆发之势。而且这个势头将随着智能终端(手机,平板)的加速普及而更加迅猛

- wordpress小工具制作

aichenglong

wordpress小工具

wordpress 使用侧边栏的小工具,很方便调整页面结构

小工具的制作过程

1 在自己的主题文件中新建一个文件夹(如widget),在文件夹中创建一个php(AWP_posts-category.php)

小工具是一个类,想侧边栏一样,还得使用代码注册,他才可以再后台使用,基本的代码一层不变

<?php

class AWP_Post_Category extends WP_Wi

- JS微信分享

AILIKES

js

// 所有功能必须包含在 WeixinApi.ready 中进行

WeixinApi.ready(function(Api) {

// 微信分享的数据

var wxData = {

&nb

- 封装探讨

百合不是茶

JAVA面向对象 封装

//封装 属性 方法 将某些东西包装在一起,通过创建对象或使用静态的方法来调用,称为封装;封装其实就是有选择性地公开或隐藏某些信息,它解决了数据的安全性问题,增加代码的可读性和可维护性

在 Aname类中申明三个属性,将其封装在一个类中:通过对象来调用

例如 1:

//属性 将其设为私有

姓名 name 可以公开

- jquery radio/checkbox change事件不能触发的问题

bijian1013

JavaScriptjquery

我想让radio来控制当前我选择的是机动车还是特种车,如下所示:

<html>

<head>

<script src="http://ajax.googleapis.com/ajax/libs/jquery/1.7.1/jquery.min.js" type="text/javascript"><

- AngularJS中安全性措施

bijian1013

JavaScriptAngularJS安全性XSRFJSON漏洞

在使用web应用中,安全性是应该首要考虑的一个问题。AngularJS提供了一些辅助机制,用来防护来自两个常见攻击方向的网络攻击。

一.JSON漏洞

当使用一个GET请求获取JSON数组信息的时候(尤其是当这一信息非常敏感,

- [Maven学习笔记九]Maven发布web项目

bit1129

maven

基于Maven的web项目的标准项目结构

user-project

user-core

user-service

user-web

src

- 【Hive七】Hive用户自定义聚合函数(UDAF)

bit1129

hive

用户自定义聚合函数,用户提供的多个入参通过聚合计算(求和、求最大值、求最小值)得到一个聚合计算结果的函数。

问题:UDF也可以提供输入多个参数然后输出一个结果的运算,比如加法运算add(3,5),add这个UDF需要实现UDF的evaluate方法,那么UDF和UDAF的实质分别究竟是什么?

Double evaluate(Double a, Double b)

- 通过 nginx-lua 给 Nginx 增加 OAuth 支持

ronin47

前言:我们使用Nginx的Lua中间件建立了OAuth2认证和授权层。如果你也有此打算,阅读下面的文档,实现自动化并获得收益。SeatGeek 在过去几年中取得了发展,我们已经积累了不少针对各种任务的不同管理接口。我们通常为新的展示需求创建新模块,比如我们自己的博客、图表等。我们还定期开发内部工具来处理诸如部署、可视化操作及事件处理等事务。在处理这些事务中,我们使用了几个不同的接口来认证:

&n

- 利用tomcat-redis-session-manager做session同步时自定义类对象属性保存不上的解决方法

bsr1983

session

在利用tomcat-redis-session-manager做session同步时,遇到了在session保存一个自定义对象时,修改该对象中的某个属性,session未进行序列化,属性没有被存储到redis中。 在 tomcat-redis-session-manager的github上有如下说明: Session Change Tracking

As noted in the &qu

- 《代码大全》表驱动法-Table Driven Approach-1

bylijinnan

java算法

关于Table Driven Approach的一篇非常好的文章:

http://www.codeproject.com/Articles/42732/Table-driven-Approach

package com.ljn.base;

import java.util.Random;

public class TableDriven {

public

- Sybase封锁原理

chicony

Sybase

昨天在操作Sybase IQ12.7时意外操作造成了数据库表锁定,不能删除被锁定表数据也不能往其中写入数据。由于着急往该表抽入数据,因此立马着手解决该表的解锁问题。 无奈此前没有接触过Sybase IQ12.7这套数据库产品,加之当时已属于下班时间无法求助于支持人员支持,因此只有借助搜索引擎强大的

- java异常处理机制

CrazyMizzz

java

java异常关键字有以下几个,分别为 try catch final throw throws

他们的定义分别为

try: Opening exception-handling statement.

catch: Captures the exception.

finally: Runs its code before terminating

- hive 数据插入DML语法汇总

daizj

hiveDML数据插入

Hive的数据插入DML语法汇总1、Loading files into tables语法:1) LOAD DATA [LOCAL] INPATH 'filepath' [OVERWRITE] INTO TABLE tablename [PARTITION (partcol1=val1, partcol2=val2 ...)]解释:1)、上面命令执行环境为hive客户端环境下: hive>l

- 工厂设计模式

dcj3sjt126com

设计模式

使用设计模式是促进最佳实践和良好设计的好办法。设计模式可以提供针对常见的编程问题的灵活的解决方案。 工厂模式

工厂模式(Factory)允许你在代码执行时实例化对象。它之所以被称为工厂模式是因为它负责“生产”对象。工厂方法的参数是你要生成的对象对应的类名称。

Example #1 调用工厂方法(带参数)

<?phpclass Example{

- mysql字符串查找函数

dcj3sjt126com

mysql

FIND_IN_SET(str,strlist)

假如字符串str 在由N 子链组成的字符串列表strlist 中,则返回值的范围在1到 N 之间。一个字符串列表就是一个由一些被‘,’符号分开的自链组成的字符串。如果第一个参数是一个常数字符串,而第二个是type SET列,则 FIND_IN_SET() 函数被优化,使用比特计算。如果str不在strlist 或st

- jvm内存管理

easterfly

jvm

一、JVM堆内存的划分

分为年轻代和年老代。年轻代又分为三部分:一个eden,两个survivor。

工作过程是这样的:e区空间满了后,执行minor gc,存活下来的对象放入s0, 对s0仍会进行minor gc,存活下来的的对象放入s1中,对s1同样执行minor gc,依旧存活的对象就放入年老代中;

年老代满了之后会执行major gc,这个是stop the word模式,执行

- CentOS-6.3安装配置JDK-8

gengzg

centos

JAVA_HOME=/usr/java/jdk1.8.0_45

JRE_HOME=/usr/java/jdk1.8.0_45/jre

PATH=$PATH:$JAVA_HOME/bin:$JRE_HOME/bin

CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar:$JRE_HOME/lib

export JAVA_HOME

- 【转】关于web路径的获取方法

huangyc1210

Web路径

假定你的web application 名称为news,你在浏览器中输入请求路径: http://localhost:8080/news/main/list.jsp 则执行下面向行代码后打印出如下结果: 1、 System.out.println(request.getContextPath()); //可返回站点的根路径。也就是项

- php里获取第一个中文首字母并排序

远去的渡口

数据结构PHP

很久没来更新博客了,还是觉得工作需要多总结的好。今天来更新一个自己认为比较有成就的问题吧。 最近在做储值结算,需求里结算首页需要按门店的首字母A-Z排序。我的数据结构原本是这样的:

Array

(

[0] => Array

(

[sid] => 2885842

[recetcstoredpay] =&g

- java内部类

hm4123660

java内部类匿名内部类成员内部类方法内部类

在Java中,可以将一个类定义在另一个类里面或者一个方法里面,这样的类称为内部类。内部类仍然是一个独立的类,在编译之后内部类会被编译成独立的.class文件,但是前面冠以外部类的类名和$符号。内部类可以间接解决多继承问题,可以使用内部类继承一个类,外部类继承一个类,实现多继承。

&nb

- Caused by: java.lang.IncompatibleClassChangeError: class org.hibernate.cfg.Exten

zhb8015

maven pom.xml关于hibernate的配置和异常信息如下,查了好多资料,问题还是没有解决。只知道是包冲突,就是不知道是哪个包....遇到这个问题的分享下是怎么解决的。。

maven pom:

<dependency>

<groupId>org.hibernate</groupId>

<ar

- Spark 性能相关参数配置详解-任务调度篇

Stark_Summer

sparkcachecpu任务调度yarn

随着Spark的逐渐成熟完善, 越来越多的可配置参数被添加到Spark中来, 本文试图通过阐述这其中部分参数的工作原理和配置思路, 和大家一起探讨一下如何根据实际场合对Spark进行配置优化。

由于篇幅较长,所以在这里分篇组织,如果要看最新完整的网页版内容,可以戳这里:http://spark-config.readthedocs.org/,主要是便

- css3滤镜

wangkeheng

htmlcss

经常看到一些网站的底部有一些灰色的图标,鼠标移入的时候会变亮,开始以为是js操作src或者bg呢,搜索了一下,发现了一个更好的方法:通过css3的滤镜方法。

html代码:

<a href='' class='icon'><img src='utv.jpg' /></a>

css代码:

.icon{-webkit-filter: graysc

![]()