大数据处理之道(实验方法篇<一>)

(1)做大数据处理,清洗数据结束后,就是现象分析,再建立Model模型,在验证自己模型的有效性

(2)大数据试验验证模型有效性的指标:

Accuracy(正确率);Precision(查准率或准确率);Recall(查全率或召回率);F1-Measure

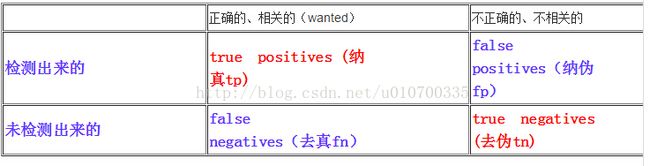

True Positives, True Negatives, False Positives, False Negatives 下面分别进行表述:

(3)详细介绍:查全率和查准率是目前衡量检索效果的相对合理的指标

查全率=(检索出的相关信息量/系统中的相关信息总量)*100%

查准率=(检索出的相关信息量/检索出的信息总量)*100%前者是衡量检索系统和检索者检出相关信息的能力,后者是衡量检索系统和检索者拒绝非相关信息的能力。两者合起来,即表示检索效率。

True Positive (真正, TP)被模型预测为正的正样本;可以称作判断为真的正确率True Negative(真负 , TN)被模型预测为负的负样本 ;可以称作判断为假的正确率

False Positive (假正, FP)被模型预测为正的负样本;可以称作误报率False Negative(假负 , FN)被模型预测为负的正样本;可以称作漏报率

(4)用图表说话:

表格中的翻译比较重要 true positives (纳真) false positives(纳伪) false negatives(去真)true negatives (去伪)

其中false positives(纳伪)也通常称作误报,false negatives也通常称作漏报!

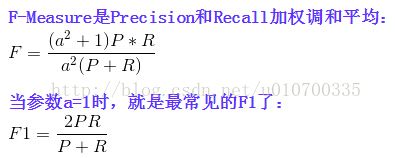

计算方法:

Precision = tp/(tp + fp);

Recall = tp / (tp + fn).

然而在实际当中,我们当然希望检索的结果P越高越好,R也越高越好;事实上这两者在某些情况下是矛盾的。比如,我们只搜出了一个结果,且是准确的,

那么P就是100%,但是R就很低;而如果我们把所有结果都返回,那么必然R是100%,但是P很低。因此在不同的场合中需要自己判断希望P比较高还是R比

较高。如果是做实验,可以绘制Precision-Recall曲线来帮助分析。

实际例子:

例如:一个数据集合里面有100个待检测的数据,结果用我们的方法检测出来了10个(其中,8个是那100个待检测数据中的,2个不是),还有90个没有检测

出来;此时precision = 8/10 = 80%, 而 Recall = 8 / 100 = 8%;

很容易理解,F1综合了P和R的结果,当F1较高时则比较说明实验方法比较理想。

部分摘自:http://blog.csdn.net/t710smgtwoshima/article/details/8215037

(6)查全率和查准率都有局限性

查全率的局限性主要表现在:它是检索出的相关信息量与存储在检索系统中的全部相关信息量之比,但系统中相关信息量究竟有多少一般是不确知的,只

能估计;另外,查全率或多或少具有“假设”的局限性,这种“假设”是指检索出的相关信息对用户具有同等价值,但实际并非如此,对于用户来说,信息的相关

程度在某种意义上比它的数量重要得多。

查准率的局限性主要表现在:如果检索结果是题录式而非全文式,由于题录的内容简单,用户很难判断检索到的信息是否与课题密切相关,必须找到该题录

的全文,才能正确判断出该信息是否符合检索课题的需要;同时,查准率中所讲的相关信息也具有“假设”的局限性。 实验证明,在查全率和查准率之间存

在着相反的相互依赖关系--如果提高输出的查全率,就会降低其查准率,反之亦然。

对用户来说,影响检索效果的主要因素有文献标引的广泛性和用户检索标识的专指性。

(7) 综述

在信息检索,如搜索引擎、自然语言处理和检测分类中经常会使用这些参数,因为介于语言翻译上的原因理解难免出现误差