- 延迟vector计算。

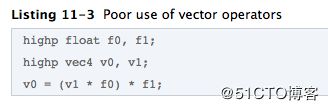

例:不好的用法。

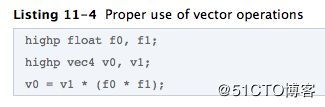

优化后的用法。-

去冗余计算, vector整体计算。

例:良好的用法。

-

避免分支。(避免if语句)

分支语句性能排序:

a) 最佳:编译期确定的常量

b) 可接受:uniform变量

c) 可能很差:在shader内计算的变量

解决方案:将各个分支作为单独的shader。(会增加一点工作量及复杂度)

实践参考:在性能和工量入复杂度之间作一个权衡。

因受寄存器限制,SL的编译代码越短,效率越高。另外,因为是海量计算,所以细徽的优化会带来革命性的性能改善。

4.使用glsl_optimizer 优化工具进行优化

glsl_optimizer 是一个免费开源的glsl优化器。可以生成GPU无关的shader优化代码。

可以进行非常多的优化项目,比如 函数内联,死代码删除,常量折叠,常量传递,数学优化等等。

GitHub地址(在 projects 目录下已经有生成好的工程文件)

其命令行格式为:

Usage: glsloptimizerCL -in

-in 输入的文件名.

-out 输出的文件名 (如果优化成功)

-说明优化的shader类型:GL_VERTEX_SHADER (默认) 或 GL_FRAGMENT_SHADER.

-help 显示帮助信息

值得注意的是,在main.cpp中 有一行代码:

ctx = glslopt_initialize(true)

函数的原型为

glslopt_ctx* glslopt_initialize (bool openglES);

显然它默认是当做 GL ES 来优化的,如果想针对 GL 优化,需要将参数改为 false。

最后,举个使用的栗子:

./glsl_optimizer_bin -in vertex.glsl -out vertex.glsl -profile GL_VERTEX_SHADER

./glsl_optimizer_bin -in fragment.glsl -out fragment.glsl -profile GL_FRAGMENT_SHADER

5.只计算需要计算的东西

尽量减少无用的顶点数据, 比如贴图坐标, 如果有Object使用2组有的使用1组, 那么不要将他们放在一个vertex buffer中, 这样可以减少传输的数据量;

避免过多的顶点计算,比如过多的光源, 过于复杂的光照计算(复杂的光照模型);

避免 VS 指令数量太多或者分支过多, 尽量减少 VS 的长度和复杂程度;

6.尽量在 VS 中计算

通常,需要渲染的像素比顶点数多,而顶点数又比物体数多很多。所以如果可以,尽量将运算从 FS 移到 VS,或直接通过 script 来设置某些固定值;

7.浮点数精度相关:

float:最高精度,通常32位

half:中等精度,通常16位,-60000到60000,

fixed:最低精度,通常11位,-2.0到2.0,1/256的精度。

尽量使用低精度。对于 color 和 unit length vectors,使用fixed,其他情况,根据取值范围尽量使用 half,实在不够则使用 float 。

在移动平台,关键是在 FS 中尽可能多的使用低精度数据。另外,对于多数移动GPU,在低精度和高精度之间转换是非常耗的,在fixed上做swizzle操作也是很费事的。

8.Alpha Test

Alpha test 和 clip() 函数,在不同平台有不同的性能开销。

通常使用它来剔除那些完全透明的像素。

但是,在 iOS 和一些 Android 上使用的 PowerVR GPUs上面,alpha test非常的昂贵。

9.Color Mask

在移动设备上,Color Mask 也是非常昂贵的,所以尽量别使用它,除非真的是需要。

- For和If不一定意味着动态分支

在GPU上的分支语句(for,if-else,while),可以分为三类。

Branch的Condition仅依赖编译期常数

此时编译器可以直接摊平分支,或者展开(unloop)。对于For来说,会有个权衡,如果For的次数特别多,或者body内的代码特别长,可能就不展开了,因为会指令装载也是有限或者有耗费的

额外成本可以忽略不计

Branch的Condition仅依赖编译期常数和Uniform变量

一个运行期固定的跳转语句,可预测

同一个Warp内所有micro thread均执行相同分支

额外成本很低

Branch 的 Condition 是动态的表达式

这才是真正的“动态分支”

会存在一个Warp的 Micro Thread 之间各自需要走不同分支的问题

- 跳转本身的成本非常低

随着IP/EP(Instruction Pointer/Execution Pointer)的引入,现代GPU在执行指令上的行为,和CPU没什么两样。跳转仅仅是重新设置一个寄存器。

12.Micro Thread 走不同分支时的处理

GPU本身的执行速度快,是因为它一条指令可以处理多个 Micro Thread 的数据(SIMD)。但是这需要多个 Micro Thread 同一时刻的指令是相同的。

如果不同,现代GPU通常的处理方法是,按照每个Micro Thread的不同需求多次执行分支。

x = tex.Load();

if(x == 5)

{

// Thread 1 & 2 使用这个路径

out.Color = float4(1, 1, 1, 1);

}

else

{

// Thread 3 & 4 使用这个路径

out.Color = float4(0, 0, 0, 0);

}

比如在上例中,两个分支的语句Shader Unit都会执行,只是不同的是如果在执行if分支,那么计算结果将不会写入到thread 3 和 4的存储中(无副作用)。

这样做就相当于运算量增加了不少,这是动态分支的主要成本。

但是如果所有的线程,都走的是同一分支,那么另外一个分支就不用走了。这个时候Shader Unit也不会去×××一样的执行另外一个根本不需要执行的分支。此时性能的损失也不多。并且,在实际的Shader中,除非特殊情况,大部分Warp内的线程,即便在动态分支的情况下,也多半走的是同一分支。

- 动态分支和代码优化难度有相关性

这一点经常被忽视,就是有动态分支的代码,因为没准你要读写点什么,前后还可能有依赖,往往也难以被优化。比如说你非要闹这样的语句出来:

if(x == 1)

{

color = tex1.Load(coord);

}

else if(x == 2)

{

color = tex2.Load(coord);

}

...

你说编译器怎么给你优化。

说句题外话,为啥要有TextureArray呢?也是为了这个场合。TextureArray除了纹理不一样,无论格式、大小、坐标、LoD、偏移,都可以是相同的。这样甚至可以预见不同Texture Surface上取数据的内存延迟也是非常接近的。这样有很多的操作都可以合并成SIMD,就比多个Texture分别来取快得多了。这就是一个通过增加了约束(纹理格式、大小、寻址坐标)把SISD优化成SIMD的例子