hadoop+zookeeper实现高可用

zookeeper

ZooKeeper是一个分布式的,开放源码的分布式应用程序协调服务,是Google的Chubby一个开源的实现,是Hadoop和Hbase的重要组件。它是一个为分布式应用提供一致性服务的软件,提供的功能包括:配置维护、域名服务、分布式同步、组服务等。

ZooKeeper的目标就是封装好复杂易出错的关键服务,将简单易用的接口和性能高效、功能稳定的系统提供给用户。

ZooKeeper包含一个简单的原语集, [1] 提供Java和C的接口。

ZooKeeper代码版本中,提供了分布式独享锁、选举、队列的接口,代码在zookeeper-3.4.3\src\recipes。其中分布锁和队列有Java和C两个版本,选举只有Java版本。

zookeeper工作原理

ZooKeeper是以Fast Paxos算法为基础的,Paxos 算法存在活锁的问题,即当有多个proposer交错提交时,有可能互相排斥导致没有一个proposer能提交成功,而Fast Paxos作了一些优化,通过选举产生一个leader (领导者),只有leader才能提交proposer,具体算法可见Fast Paxos。因此,要想弄懂ZooKeeper首先得对Fast Paxos有所了解。

ZooKeeper的基本运转流程:

1、选举Leader。

2、同步数据。

3、选举Leader过程中算法有很多,但要达到的选举标准是一致的。

4、Leader要具有最高的执行ID,类似root权限。

5、集群中大多数的机器得到响应并接受选出的Leader。

配置高可用

实验环境:五台虚拟机

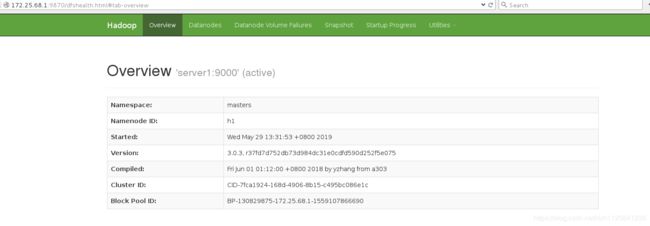

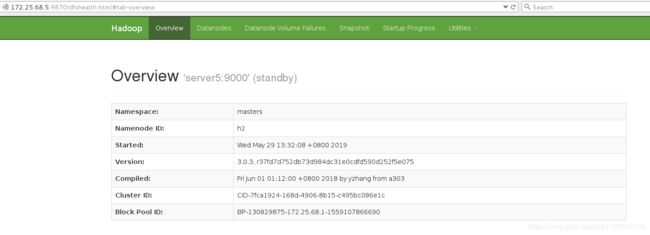

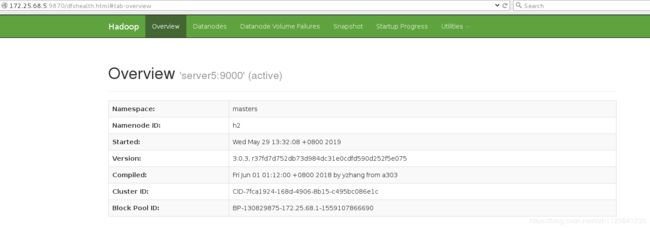

server1和server5是namenode,用来做主备

server2、server3、server4是datanode,用来存储

其他四台虚拟机都通过nfs挂载server1的/home/hadoop

1.关闭之前的服务,并清理环境

[hadoop@server1 hadoop]$ sbin/stop-yarn.sh

[hadoop@server1 hadoop]$ sbin/stop-dfs.sh

[hadoop@server1 hadoop]$ jps

1652 Jps

##1-4server都执行

[hadoop@server1 hadoop]$ rm -fr /tmp/*

2.搭建zookeeper 添加从节点信息

[hadoop@server2 ~]$ tar zxf zookeeper-3.4.9.tar.gz

[hadoop@server2 ~]$ cd zookeeper-3.4.9/conf

[hadoop@server2 conf]$ cp zoo_sample.cfg zoo.cfg

[hadoop@server2 conf]$ vim zoo.cfg

server.1=172.25.68.2:2888:3888

server.2=172.25.68.3:2888:3888

server.3=172.25.68.4:2888:3888

3.各节点配置文件相同,并且需要在/tmp/zookeeper 目录中创建 myid 文件,写入一个唯一的数字,取值范围在 1-255

[hadoop@server2 conf]$ mkdir /tmp/zookeeper

[hadoop@server3 conf]$ mkdir /tmp/zookeeper

[hadoop@server4 conf]$ mkdir /tmp/zookeeper

[hadoop@server2 conf]$ echo 1 > /tmp/zookeeper/myid

[hadoop@server3 conf]$ echo 2 > /tmp/zookeeper/myid

[hadoop@server4 conf]$ echo 3 > /tmp/zookeeper/myid

##这里的1 2 3 和zoo.cfg中server.后面的数字对应

4.开启服务

[hadoop@server2 zookeeper-3.4.9]$ bin/zkServer.sh start

[hadoop@server3 zookeeper-3.4.9]$ bin/zkServer.sh start

[hadoop@server4 zookeeper-3.4.9]$ bin/zkServer.sh start

并查看各节点状态

[hadoop@server2 zookeeper-3.4.9]$ bin/zkServer.sh status

ZooKeeper JMX enabled by default

Using config: /home/hadoop/zookeeper-3.4.9/bin/../conf/zoo.cfg

Mode: follower ##从

##3是主

[hadoop@server3 zookeeper-3.4.9]$ bin/zkServer.sh status

ZooKeeper JMX enabled by default

Using config: /home/hadoop/zookeeper-3.4.9/bin/../conf/zoo.cfg

Mode: leader ##主

[hadoop@server4 zookeeper-3.4.9]$ bin/zkServer.sh status

ZooKeeper JMX enabled by default

Using config: /home/hadoop/zookeeper-3.4.9/bin/../conf/zoo.cfg

Mode: follower ##从

5.在server2进入命令行

[hadoop@server2 bin]$ ls

README.txt zkCli.cmd zkEnv.cmd zkServer.cmd zookeeper.out

zkCleanup.sh zkCli.sh zkEnv.sh zkServer.sh

[hadoop@server2 bin]$ pwd

/home/hadoop/zookeeper-3.4.9/bin

[hadoop@server2 bin]$ ./zkCli.sh 连接zookeeper

[zk: localhost:2181(CONNECTED) 0] ls /

[zookeeper]

[zk: localhost:2181(CONNECTED) 1] ls /zookeeper

[quota]

[zk: localhost:2181(CONNECTED) 2] ls /zookeeper/quota

[]

[zk: localhost:2181(CONNECTED) 3] get /zookeeper/quota

cZxid = 0x0

ctime = Thu Jan 01 08:00:00 CST 1970

mZxid = 0x0

mtime = Thu Jan 01 08:00:00 CST 1970

pZxid = 0x0

cversion = 0

dataVersion = 0

aclVersion = 0

ephemeralOwner = 0x0

dataLength = 0

numChildren = 0

6.进行hadoop的配置详解

[hadoop@server1 hadoop]$ vim core-site.xml

##指定 hdfs 的 namenode 为 masters (名称可自定义)

fs.defaultFS

hdfs://masters

##指定 zookeeper 集群主机地址

ha.zookeeper.quorum

172.25.68.2:2181,172.25.68.3:2181,172.25.68.4:2181

[hadoop@server1 hadoop]$ vim hdfs-site.xml

dfs.replication

3

##指定 hdfs 的 nameservices 为 masters,和 core-site.xml 文件中的设置保持一致

dfs.nameservices

masters

##masters 下面有两个 namenode 节点,分别是 h1 和 h2

dfs.ha.namenodes.masters

h1,h2

##指定 h1 节点的 rpc 通信地址

dfs.namenode.rpc-address.masters.h1

172.25.68.1:9000

##指定 h1 节点的 http 通信地址

dfs.namenode.http-address.masters.h1

172.25.68.1:9870

##指定 h2 节点的 rpc 通信地址

dfs.namenode.rpc-address.masters.h2

172.25.68.5:9000

##指定 h2 节点的 http 通信地址

dfs.namenode.http-address.masters.h2

172.25.68.5:9870

##指定 NameNode 元数据在 JournalNode 上的存放位置

dfs.namenode.shared.edits.dir

qjournal://172.25.68.2:8485;172.25.68.3:8485;172.25.68.4:8485/masters

##指定 JournalNode 在本地磁盘存放数据的位置

dfs.journalnode.edits.dir

/tmp/journaldata

##开启 NameNode 失败自动切换

dfs.ha.automatic-failover.enabled

true

##配置失败自动切换实现方式

dfs.client.failover.proxy.provider.masters

org.apache.hadoop.hdfs.server.namenode.ha.ConfiguredFailoverProxyProvider

##配置隔离机制方法,每个机制占用一行

dfs.ha.fencing.methods

sshfence

shell(/bin/true)

##使用 sshfence 隔离机制时需要 ssh 免密码

dfs.ha.fencing.ssh.private-key-files

/home/hadoop/.ssh/id_rsa

##配置 sshfence 隔离机制超时时间

dfs.ha.fencing.ssh.connect-timeout

30000

7.启动 hdfs 集群(按顺序启动)在三个 DN 上依次启动 zookeeper 集群

[hadoop@server2 hadoop]$ pwd

/home/hadoop/hadoop

[hadoop@server2 hadoop]$ jps

3204 Jps

3015 QuorumPeerMain

3165 JournalNode

[hadoop@server3 hadoop]$ jps

3142 JournalNode

3181 Jps

3039 QuorumPeerMain

[hadoop@server4 hadoop]$ jps

3124 JournalNode

3016 QuorumPeerMain

3163 Jps

8.传递配置文件搭建高可用

[hadoop@server1 hadoop]$ pwd

/home/hadoop/hadoop

[hadoop@server1 hadoop]$ bin/hdfs namenode -format

[hadoop@server1 hadoop]$ scp -r /tmp/hadoop-hadoop 172.25.68.5:/tmp

[hadoop@server5 ~]$ ls /tmp

hadoop-hadoop

9.格式化 zookeeper (只需在 h1 上执行即可)

[hadoop@server1 hadoop]$ bin/hdfs zkfc -formatZK

10.启动 hdfs 集群(只需在 h1 上执行即可)

[hadoop@server1 hadoop]$ sbin/start-dfs.sh

[hadoop@server1 hadoop]$ jps

6116 DFSZKFailoverController

5767 NameNode

6167 Jps

[hadoop@server5 ~]$ jps

2249 NameNode

2393 Jps

2314 DFSZKFailoverController

12.停掉server1,server5的状态就变成了active

[hadoop@server1 hadoop]$ jps

6178 Jps

6116 DFSZKFailoverController

5767 NameNode

[hadoop@server1 hadoop]$ kill 5767

[hadoop@server1 hadoop]$ jps

6193 Jps

6116 DFSZKFailoverController

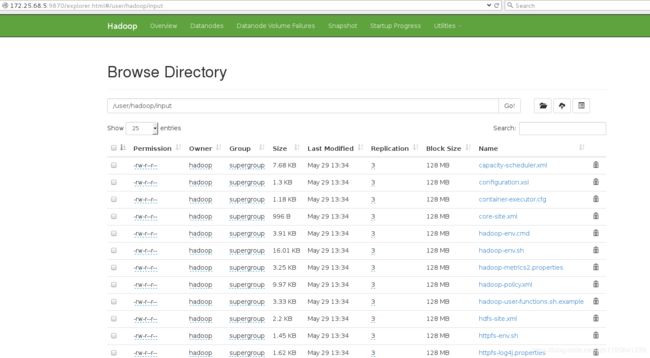

13.1虽然关了,但是还是可以上传,是通过5上传的

[hadoop@server1 hadoop]$ bin/hdfs dfs -mkdir -p /user/hadoop

[hadoop@server1 hadoop]$ bin/hdfs dfs -mkdir input

[hadoop@server1 hadoop]$ bin/hdfs dfs -put etc/hadoop/* input

14.重新打开1.变成standby

[hadoop@server1 hadoop]$ bin/hdfs --daemon start namenode

[hadoop@server1 hadoop]$ jps

6116 DFSZKFailoverController

6532 NameNode

6566 Jps