- flink实时集成利器 - apache seatunnel - 核心架构详解

24k小善

flinkapache架构

SeaTunnel(原名Waterdrop)是一个分布式、高性能、易扩展的数据集成平台,专注于大数据领域的数据同步、数据迁移和数据转换。它支持多种数据源和数据目标,并可以与ApacheFlink、Spark等计算引擎集成。以下是SeaTunnel的核心架构详解:SeaTunnel核心架构SeaTunnel的架构设计分为以下几个核心模块:1.数据源(Source)功能:负责从外部系统读取数据。支持的

- DS缩写乱争:当小海豚撞上AI顶流,技术圈也逃不过“撞名”修罗场

数据库

DS缩写风云:从“小海豚”到“深度求索”的魔幻现实曾几何时,技术圈提到DS,人们脑海中浮现的是一只灵动的“小海豚”——ApacheDolphinScheduler(简称DS)。这个2019年诞生的分布式任务调度系统,凭借可视化DAG界面、多租户支持和对Hadoop/Spark生态的深度集成,一度是大数据工程师的“梦中情工”。然而,命运的齿轮在2025年初突然加速转动:杭州AI公司DeepSeek(

- 如何在Java中实现高效的分布式计算框架:从Hadoop到Spark

省赚客app开发者

javahadoopspark

如何在Java中实现高效的分布式计算框架:从Hadoop到Spark大家好,我是微赚淘客系统3.0的小编,是个冬天不穿秋裤,天冷也要风度的程序猿!今天我们来探讨如何在Java中实现高效的分布式计算框架,重点介绍Hadoop和Spark这两个在大数据处理领域中广泛使用的技术。一、Hadoop:基础分布式计算框架Hadoop是一个开源的分布式计算框架,最早由Apache开发,旨在处理海量数据。它的核心

- Spark源码分析

数据年轮

Sparkspark源码spark大数据源码分析

过程描述:1.通过Shell脚本启动Master,Master类继承Actor类,通过ActorySystem创建并启动。2.通过Shell脚本启动Worker,Worker类继承Actor类,通过ActorySystem创建并启动。3.Worker通过Akka或者Netty发送消息向Master注册并汇报自己的资源信息(内存以及CPU核数等),以后就是定时汇报,保持心跳。4.Master接受消息

- Spark 源码 | 脚本分析总结

董可伦

spark源码脚本

前言最初是想学习一下Spark提交流程的源码,比如SparkOnYarn、Standalone。之前只是通过网上总结的文章大概了解整体的提交流程,但是每个文章描述的又不太一样,弄不清楚到底哪个说的准确,比如Client和CLuster模式的区别,Driver到底是干啥的,是如何定义的,为了彻底弄清楚这些疑问,所以决定学习一下相关的源码。因为不管是服务启动还是应用程序启动,都是通过脚本提交的,所以我

- Spark性能调优-----常规性能调优(一)最优资源配置

weidajiangjiang

spark性能调优常规资源配置

1.1.1常规性能调优一:最优资源配置Spark性能调优的第一步,就是为任务分配更多的资源,在一定范围内,增加资源的分配与性能的提升是成正比的,实现了最优的资源配置后,在此基础上再考虑进行后面论述的性能调优策略。资源的分配在使用脚本提交Spark任务时进行指定,标准的Spark任务提交脚本如代码清单2-1所示:代码清单2-1标准Spark提交脚本/usr/opt/modules/spark/bin

- Spark性能调优系列:Spark资源模型以及调优

Mr Cao

大数据sparkSpark性能调优

Spark资源模型Spark内存模型Spark在一个Executor中的内存分为三块,execution内存、storage内存、other内存。execution内存是执行内存,join、aggregate都在这部分中执行,shuffle的数据也会先缓存在这个内存中,满了再写入磁盘,能够减少IO,Map过程也是在这个内存中执行的。(0.25)storage内存是存储broadcast,cache

- spark 性能调优 (一):执行计划

LevenBigData

spark性能调优spark大数据

在Spark中,explain函数用于提供数据框(DataFrame)或SQL查询的逻辑计划和物理执行计划的详细解释。它可以帮助开发者理解Spark是如何执行查询的,包括优化过程、转换步骤以及它将采用的物理执行策略。1.逻辑计划(LogicalPlan)逻辑计划代表了Spark将应用于处理数据的抽象操作序列。它是基于用户提供的DataFrameAPI或SQL查询,经过优化前的中间表示。未优化的逻辑

- spark技术基础知识

24k小善

spark服务器

1.Spark的宽窄依赖划分Q:Spark中如何划分宽依赖和窄依赖?A:窄依赖:父RDD的每个分区最多被一个子RDD的分区依赖(如map、filter),不会触发shuffle。宽依赖:父RDD的每个分区可能被多个子RDD的分区依赖(如groupByKey、reduceByKey),会触发shuffle。Q:宽依赖和窄依赖对性能的影响是什么?A:窄依赖:计算效率高,数据不需要跨节点传输。宽依赖:涉

- Spark图书数据分析系统 Springboot协同过滤-余弦函数推荐系统 爬虫1万+数据 大屏数据展示 + [手把手视频教程 和 开发文档]

QQ-1305637939

毕业设计大数据毕设图书数据分析sparkspringboot爬虫

Spark图书数据分析系统Springboot协同过滤-余弦函数推荐系统爬虫1万+数据大屏数据展示+[手把手视频教程和开发文档]【亮点功能】1.Springboot+Vue+Element-UI+Mysql前后端分离2.Echarts图表统计数据,直观展示数据情况3.发表评论后,用户可以回复评论,回复的评论可以被再次回复,一级评论可以添加图片附件4.爬虫图书数据1万+5.推荐图书列表展示,推荐图书

- 计算机毕业设计hadoop+spark+hive新能源汽车数据分析可视化大屏 汽车推荐系统 新能源汽车推荐系统 汽车爬虫 汽车大数据 机器学习 大数据毕业设计 深度学习 知识图谱 人工智能

qq+593186283

hadoop大数据人工智能

(1)设计目的本次设计一个基于Hive的新能源汽车数据仓管理系统。企业管理员登录系统后可以在汽车保养时,根据这些汽车内置传感器传回的数据分析其故障原因,以便维修人员更加及时准确处理相关的故障问题。或者对这些数据分析之后向车主进行预警提示车主注意保养汽车,以提高汽车行驶的安全系数。(2)设计要求利用Flume进行分布式的日志数据采集,Kafka实现高吞吐量的数据传输,DateX进行数据清洗、转换和整

- 【spark】【在YARN上运行Spark】【Running Spark on YARN】

资源存储库

spark

目录RunningSparkonYARN在YARN上运行SparkSecurity安全LaunchingSparkonYARN在YARN上启动SparkAddingOtherJARs添加其他JARPreparations筹备工作Configuration配置DebuggingyourApplication调试应用程序SparkProperties【Spark属性】Availablepatterns

- 在Jupyter Notebook中进行大数据分析:集成Apache Spark

范范0825

jupyter数据分析apache

在JupyterNotebook中进行大数据分析:集成ApacheSpark介绍JupyterNotebook是一款广泛使用的数据科学工具,结合ApacheSpark后,能够处理和分析大规模数据。ApacheSpark是一个快速的统一分析引擎,支持大数据处理和分布式计算。本教程将详细介绍如何在JupyterNotebook中集成和使用Spark进行大数据分析。前提条件基本的Python编程知识基本

- 知识图谱智能应用系统:数据分析与挖掘技术文档

光芒再现0394

知识图谱数据分析人工智能

一、概述在知识图谱智能应用系统中,数据分析与挖掘模块是实现知识发现和智能应用的核心环节。该模块负责处理和分析来自数据采集与预处理模块的结构化和半结构化数据,提取有价值的知识,并将其转化为可用于知识图谱构建和应用的三元组数据。本技术文档详细介绍了数据分析与挖掘模块中使用到的关键技术,包括SparkML、StanfordNLP、JNA、Jena、Python调用以及定时调度。二、技术栈介绍(一)Spa

- spark性能优化点(超详解!!!珍藏版!!!)

深漠大侠

sparkspark性能优化

spark性能优化点分配更多的资源1.1分配哪些资源1.2在哪里可以设置这些资源1.3参数调节到多大,算是最大分配更多的资源:它是性能优化调优的王道,就是增加和分配更多的资源,这对于性能和速度上的提升是显而易见的,基本上,在一定范围之内,增加资源与性能的提升,是成正比的;写完了一个复杂的spark作业之后,进行性能调优的时候,首先第一步,就是要来调节最优的资源配置;在这个基础之上,如果说你的spa

- spark1.6.0分布式安装

问道9527

sparkspark分布式集群

1.概述本文是对spark1.6.0分布式集群的安装的一个详细说明,旨在帮助相关人员按照本说明能够快速搭建并使用spark集群。2.安装环境本安装说明的示例环境部署如下:IP外网IPhostname备注10.47.110.38120.27.153.137iZ237654q6qZMaster、Slaver10.24.35.51114.55.56.190iZ23pd81xqaZSlaver10.45.

- spark安装与环境配置

Handoking

大数据进阶中sparkpython安装

1.安装spark官网http://spark.apache.org/downloads.html考虑到spark之后要结合hadoop一起使用,所以下载和已经安装hadoop版本均兼容的spark(首先安装好hadoop选择伪分布式配置(因为我是单机运行,有集群的朋友查看集群环境搭建的方法。)```)搭建pyspark库,连接Linux。

哈哈哈哈q

+sparkspark大数据分布式

类库:一堆别人写好的代码,可以直接导入使用,pandas框架:可以独立运行,软件产品,如sparkpandas用于:小规模数据集spark用于:大规模数据集pysparkpython的运行类库,内置了完全的sparkapi,可以通过pyspark类库类库来编写spark应用程序。并将其提交到spark集群中运行。搭建。。很麻烦,本地需要pycharm专业版,利用shh连接Linux中的ana库。测

- 案例1.spark和flink分别实现作业配置动态更新案例

wguangliang

Sparkflinkspark大数据分布式flinketl工程师

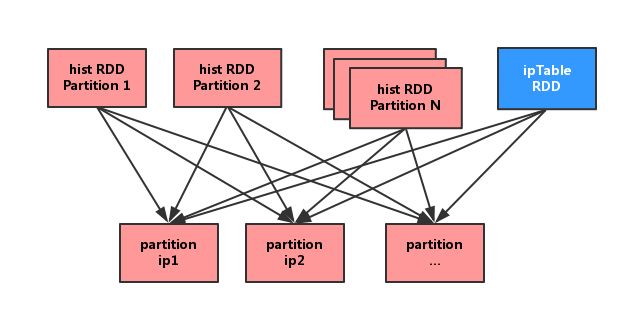

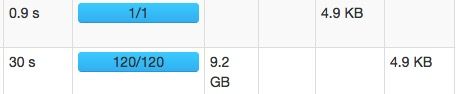

目录目录一、背景二、解决1.方法1:sparkbroadcast广播变量a.思路b.案例①需求②数据③代码2.方法2:flinkRichSourceFunctiona.思路b.案例①需求②数据③代码④测试验证测试1测试2测试3一、背景在实时作业(如SparkStreaming、Flink等流处理作业)中,通过外部配置管理系统动态修改配置,有以下优点:1.无需重启作业,实现配置热更新好处:实时作业通

- .getClass.getClassLoader.getResourceAsStream的方式加载文件,总是为null加载不到数据

抛砖者

idea

记录一个问题,我在用如下的代码加载配置文件的时候,总是加载不到数据,文件位置的对的SparkSessionBase.getClass.getClassLoader.getResourceAsStream(“spark-conf.properties”)解决这个问题的思路第一肯定是要去确定下,target目录下有没有这个文件,一般情况下八层是因为因为在编译的时候没有把配置文件给加载进来导致的,所以就

- 大数据-267 实时数仓 - ODS Lambda架构 Kappa架构 核心思想

m0_74823336

面试学习路线阿里巴巴大数据架构

点一下关注吧!!!非常感谢!!持续更新!!!Java篇开始了!MyBatis更新完毕目前开始更新Spring,一起深入浅出!目前已经更新到了:Hadoop(已更完)HDFS(已更完)MapReduce(已更完)Hive(已更完)Flume(已更完)Sqoop(已更完)Zookeeper(已更完)HBase(已更完)Redis(已更完)Kafka(已更完)Spark(已更完)Flink(已更完)Cl

- 一文带你了解Spark4新特性,开启大数据处理新篇章

敏叔V587

大数据

一文带你了解Spark4新特性,开启大数据处理新篇章在大数据处理的广袤天地中,ApacheSpark始终是熠熠生辉的存在,宛如一颗璀璨的明星框架,吸引着无数开发者与数据分析师的目光。技术的车轮滚滚向前,Spark4.0在万众瞩目中荣耀登场,携带着一系列令人热血沸腾的新特性,如同为大数据领域开启了一扇通往新世界的大门,带来了前所未有的变革。今天,就让我们一同踏上这场探索之旅,深入剖析Spark4.0

- 当大模型遇上Spark:解锁大数据处理新姿势

敏叔V587

spark大数据分布式

大模型与Spark:技术初印象在当今数字化浪潮中,大模型和Spark无疑是备受瞩目的两大技术。它们各自在人工智能和大数据处理领域大放异彩,而当这两者相遇,又会碰撞出怎样的火花呢?让我们先来分别认识一下大模型和Spark。大模型,即大规模机器学习模型,是利用海量数据和强大算力训练出来的“大参数”模型。其发展历程可谓是一部科技创新的传奇史。从20世纪中叶人工智能概念的提出,到2006年深度学习技术崭露

- 深度解读Kafka数据可靠性

程序の之道

kafkahiveyarnsparkhadoop

Kafka起初是由LinkedIn公司开发的一个分布式的消息系统,后成为Apache的一部分,它使用Scala编写,以可水平扩展和高吞吐率而被广泛使用。目前越来越多的开源分布式处理系统如Cloudera、ApacheStorm、Spark等都支持与Kafka集成。1概述Kafka与传统消息系统相比,有以下不同:•它被设计为一个分布式系统,易于向外扩展;•它同时为发布和订阅提供高吞吐量;•它支持多订

- 如何处理大规模数据集中的数据处理:Spark和ApacheFlink

AI天才研究院

DeepSeekR1&大数据AI人工智能大模型自然语言处理人工智能语言模型编程实践开发语言架构设计

文章目录1.简介2.基本概念术语说明数据处理(DataProcessing)任务调度(TaskScheduling)HadoopApacheSparkApacheFlink3.核心算法原理和具体操作步骤以及数学公式讲解1.MapReduce(1)概述(2)算法原理分布式文件系统Map阶段Shuffle阶段Reduce阶段MapReduce的流程示意图Map阶段Shuffle阶段Reduce阶段执行

- Spark Container killed by YARN for exceeding memory limits. 11.1 GB of 11 GB physical memory used

Called_Kingsley

BigDataSparksparkyarn

公司SparkSql运行出现问题同事要求帮忙排查下原因日志:19-10-202110:12:06CSTSPARK_SQL-1632390310963INFO-SLF4J:Seehttp://www.slf4j.org/codes.html#multiple_bindingsforanexplanation.19-10-202110:12:06CSTSPARK_SQL-1632390310963IN

- apache ftpserver-CentOS config

gengzg

apache

<server xmlns="http://mina.apache.org/ftpserver/spring/v1"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="

http://mina.apache.o

- 优化MySQL数据库性能的八种方法

AILIKES

sqlmysql

1、选取最适用的字段属性 MySQL可以很好的支持大数据量的存取,但是一般说来,数据库中的表越小,在它上面执行的查询也就会越快。因此,在创建表的时候,为了获得更好的 性能,我们可以将表中字段的宽度设得尽可能小。例如,在定义邮政编码这个字段时,如果将其设置为CHAR(255),显然给数据库增加了不必要的空间,甚至使用VARCHAR这种类型也是多余的,因为CHAR(6)就可以很

- JeeSite 企业信息化快速开发平台

Kai_Ge

JeeSite

JeeSite 企业信息化快速开发平台

平台简介

JeeSite是基于多个优秀的开源项目,高度整合封装而成的高效,高性能,强安全性的开源Java EE快速开发平台。

JeeSite本身是以Spring Framework为核心容器,Spring MVC为模型视图控制器,MyBatis为数据访问层, Apache Shiro为权限授权层,Ehcahe对常用数据进行缓存,Activit为工作流

- 通过Spring Mail Api发送邮件

120153216

邮件main

原文地址:http://www.open-open.com/lib/view/open1346857871615.html

使用Java Mail API来发送邮件也很容易实现,但是最近公司一个同事封装的邮件API实在让我无法接受,于是便打算改用Spring Mail API来发送邮件,顺便记录下这篇文章。 【Spring Mail API】

Spring Mail API都在org.spri

- Pysvn 程序员使用指南

2002wmj

SVN

源文件:http://ju.outofmemory.cn/entry/35762

这是一篇关于pysvn模块的指南.

完整和详细的API请参考 http://pysvn.tigris.org/docs/pysvn_prog_ref.html.

pysvn是操作Subversion版本控制的Python接口模块. 这个API接口可以管理一个工作副本, 查询档案库, 和同步两个.

该

- 在SQLSERVER中查找被阻塞和正在被阻塞的SQL

357029540

SQL Server

SELECT R.session_id AS BlockedSessionID ,

S.session_id AS BlockingSessionID ,

Q1.text AS Block

- Intent 常用的用法备忘

7454103

.netandroidGoogleBlogF#

Intent

应该算是Android中特有的东西。你可以在Intent中指定程序 要执行的动作(比如:view,edit,dial),以及程序执行到该动作时所需要的资料 。都指定好后,只要调用startActivity(),Android系统 会自动寻找最符合你指定要求的应用 程序,并执行该程序。

下面列出几种Intent 的用法

显示网页:

- Spring定时器时间配置

adminjun

spring时间配置定时器

红圈中的值由6个数字组成,中间用空格分隔。第一个数字表示定时任务执行时间的秒,第二个数字表示分钟,第三个数字表示小时,后面三个数字表示日,月,年,< xmlnamespace prefix ="o" ns ="urn:schemas-microsoft-com:office:office" />

测试的时候,由于是每天定时执行,所以后面三个数

- POJ 2421 Constructing Roads 最小生成树

aijuans

最小生成树

来源:http://poj.org/problem?id=2421

题意:还是给你n个点,然后求最小生成树。特殊之处在于有一些点之间已经连上了边。

思路:对于已经有边的点,特殊标记一下,加边的时候把这些边的权值赋值为0即可。这样就可以既保证这些边一定存在,又保证了所求的结果正确。

代码:

#include <iostream>

#include <cstdio>

- 重构笔记——提取方法(Extract Method)

ayaoxinchao

java重构提炼函数局部变量提取方法

提取方法(Extract Method)是最常用的重构手法之一。当看到一个方法过长或者方法很难让人理解其意图的时候,这时候就可以用提取方法这种重构手法。

下面是我学习这个重构手法的笔记:

提取方法看起来好像仅仅是将被提取方法中的一段代码,放到目标方法中。其实,当方法足够复杂的时候,提取方法也会变得复杂。当然,如果提取方法这种重构手法无法进行时,就可能需要选择其他

- 为UILabel添加点击事件

bewithme

UILabel

默认情况下UILabel是不支持点击事件的,网上查了查居然没有一个是完整的答案,现在我提供一个完整的代码。

UILabel *l = [[UILabel alloc] initWithFrame:CGRectMake(60, 0, listV.frame.size.width - 60, listV.frame.size.height)]

- NoSQL数据库之Redis数据库管理(PHP-REDIS实例)

bijian1013

redis数据库NoSQL

一.redis.php

<?php

//实例化

$redis = new Redis();

//连接服务器

$redis->connect("localhost");

//授权

$redis->auth("lamplijie");

//相关操

- SecureCRT使用备注

bingyingao

secureCRT每页行数

SecureCRT日志和卷屏行数设置

一、使用securecrt时,设置自动日志记录功能。

1、在C:\Program Files\SecureCRT\下新建一个文件夹(也就是你的CRT可执行文件的路径),命名为Logs;

2、点击Options -> Global Options -> Default Session -> Edite Default Sett

- 【Scala九】Scala核心三:泛型

bit1129

scala

泛型类

package spark.examples.scala.generics

class GenericClass[K, V](val k: K, val v: V) {

def print() {

println(k + "," + v)

}

}

object GenericClass {

def main(args: Arr

- 素数与音乐

bookjovi

素数数学haskell

由于一直在看haskell,不可避免的接触到了很多数学知识,其中数论最多,如素数,斐波那契数列等,很多在学生时代无法理解的数学现在似乎也能领悟到那么一点。

闲暇之余,从图书馆找了<<The music of primes>>和<<世界数学通史>>读了几遍。其中素数的音乐这本书与软件界熟知的&l

- Java-Collections Framework学习与总结-IdentityHashMap

BrokenDreams

Collections

这篇总结一下java.util.IdentityHashMap。从类名上可以猜到,这个类本质应该还是一个散列表,只是前面有Identity修饰,是一种特殊的HashMap。

简单的说,IdentityHashMap和HashM

- 读《研磨设计模式》-代码笔记-享元模式-Flyweight

bylijinnan

java设计模式

声明: 本文只为方便我个人查阅和理解,详细的分析以及源代码请移步 原作者的博客http://chjavach.iteye.com/

import java.util.ArrayList;

import java.util.Collection;

import java.util.HashMap;

import java.util.List;

import java

- PS人像润饰&调色教程集锦

cherishLC

PS

1、仿制图章沿轮廓润饰——柔化图像,凸显轮廓

http://www.howzhi.com/course/retouching/

新建一个透明图层,使用仿制图章不断Alt+鼠标左键选点,设置透明度为21%,大小为修饰区域的1/3左右(比如胳膊宽度的1/3),再沿纹理方向(比如胳膊方向)进行修饰。

所有修饰完成后,对该润饰图层添加噪声,噪声大小应该和

- 更新多个字段的UPDATE语句

crabdave

update

更新多个字段的UPDATE语句

update tableA a

set (a.v1, a.v2, a.v3, a.v4) = --使用括号确定更新的字段范围

- hive实例讲解实现in和not in子句

daizj

hivenot inin

本文转自:http://www.cnblogs.com/ggjucheng/archive/2013/01/03/2842855.html

当前hive不支持 in或not in 中包含查询子句的语法,所以只能通过left join实现。

假设有一个登陆表login(当天登陆记录,只有一个uid),和一个用户注册表regusers(当天注册用户,字段只有一个uid),这两个表都包含

- 一道24点的10+种非人类解法(2,3,10,10)

dsjt

算法

这是人类算24点的方法?!!!

事件缘由:今天晚上突然看到一条24点状态,当时惊为天人,这NM叫人啊?以下是那条状态

朱明西 : 24点,算2 3 10 10,我LX炮狗等面对四张牌痛不欲生,结果跑跑同学扫了一眼说,算出来了,2的10次方减10的3次方。。我草这是人类的算24点啊。。

然后么。。。我就在深夜很得瑟的问室友求室友算

刚出完题,文哥的暴走之旅开始了

5秒后

- 关于YII的菜单插件 CMenu和面包末breadcrumbs路径管理插件的一些使用问题

dcj3sjt126com

yiiframework

在使用 YIi的路径管理工具时,发现了一个问题。 <?php

- 对象与关系之间的矛盾:“阻抗失配”效应[转]

come_for_dream

对象

概述

“阻抗失配”这一词组通常用来描述面向对象应用向传统的关系数据库(RDBMS)存放数据时所遇到的数据表述不一致问题。C++程序员已经被这个问题困扰了好多年,而现在的Java程序员和其它面向对象开发人员也对这个问题深感头痛。

“阻抗失配”产生的原因是因为对象模型与关系模型之间缺乏固有的亲合力。“阻抗失配”所带来的问题包括:类的层次关系必须绑定为关系模式(将对象

- 学习编程那点事

gcq511120594

编程互联网

一年前的夏天,我还在纠结要不要改行,要不要去学php?能学到真本事吗?改行能成功吗?太多的问题,我终于不顾一切,下定决心,辞去了工作,来到传说中的帝都。老师给的乘车方式还算有效,很顺利的就到了学校,赶巧了,正好学校搬到了新校区。先安顿了下来,过了个轻松的周末,第一次到帝都,逛逛吧!

接下来的周一,是我噩梦的开始,学习内容对我这个零基础的人来说,除了勉强完成老师布置的作业外,我已经没有时间和精力去

- Reverse Linked List II

hcx2013

list

Reverse a linked list from position m to n. Do it in-place and in one-pass.

For example:Given 1->2->3->4->5->NULL, m = 2 and n = 4,

return

- Spring4.1新特性——页面自动化测试框架Spring MVC Test HtmlUnit简介

jinnianshilongnian

spring 4.1

目录

Spring4.1新特性——综述

Spring4.1新特性——Spring核心部分及其他

Spring4.1新特性——Spring缓存框架增强

Spring4.1新特性——异步调用和事件机制的异常处理

Spring4.1新特性——数据库集成测试脚本初始化

Spring4.1新特性——Spring MVC增强

Spring4.1新特性——页面自动化测试框架Spring MVC T

- Hadoop集群工具distcp

liyonghui160com

1. 环境描述

两个集群:rock 和 stone

rock无kerberos权限认证,stone有要求认证。

1. 从rock复制到stone,采用hdfs

Hadoop distcp -i hdfs://rock-nn:8020/user/cxz/input hdfs://stone-nn:8020/user/cxz/运行在rock端,即源端问题:报版本

- 一个备份MySQL数据库的简单Shell脚本

pda158

mysql脚本

主脚本(用于备份mysql数据库): 该Shell脚本可以自动备份

数据库。只要复制粘贴本脚本到文本编辑器中,输入数据库用户名、密码以及数据库名即可。我备份数据库使用的是mysqlump 命令。后面会对每行脚本命令进行说明。

1. 分别建立目录“backup”和“oldbackup” #mkdir /backup #mkdir /oldbackup

- 300个涵盖IT各方面的免费资源(中)——设计与编码篇

shoothao

IT资源图标库图片库色彩板字体

A. 免费的设计资源

Freebbble:来自于Dribbble的免费的高质量作品。

Dribbble:Dribbble上“免费”的搜索结果——这是巨大的宝藏。

Graphic Burger:每个像素点都做得很细的绝佳的设计资源。

Pixel Buddha:免费和优质资源的专业社区。

Premium Pixels:为那些有创意的人提供免费的素材。

- thrift总结 - 跨语言服务开发

uule

thrift

官网

官网JAVA例子

thrift入门介绍

IBM-Apache Thrift - 可伸缩的跨语言服务开发框架

Thrift入门及Java实例演示

thrift的使用介绍

RPC

POM:

<dependency>

<groupId>org.apache.thrift</groupId>