pix2pixHD

Abstract

我们提出了一种使用条件生成对抗网络(条件GAN)从语义标签图合成高分辨率照片真实图像的新方法。 条件GAN已经启用了各种应用程序,但结果通常仅限于低分辨率并且仍远非现实。 在这项工作中,我们生成2048×1024视觉上吸引人的结果,具有新颖的对抗性损失,以及新的多尺度发生器和鉴别器架构。此外,我们将框架扩展到具有两个附加功能的交互式视觉操作。 首先,我们合并了对象实例分段信息,它可以实现对象操作,例如删除/添加对象和更改对象类别。 其次,我们提出了一种方法,在给定相同输入的情况下生成不同的结果,允许用户以交互方式编辑对象外观。 人类的观点研究表明,我们的方法明显优于现有方法,提高了深度图像合成和编辑的质量和分辨率。

Introduction

由于必须明确地模拟几何,材料和光传输,因此涉及使用标准图形技术的照片般逼真的图像渲染。 尽管现有的图形算法在任务方面表现优异,但构建和编辑虚拟环境既昂贵又耗时。 那是因为我们必须明确地模拟世界的每个方面。 如果我们能够使用从数据中学习的模型渲染逼真的图像,我们可以将图形渲染过程转变为模型学习和推理问题。 然后,我们可以通过在新数据集上训练模型来简化创建新虚拟世界的过程。 我们甚至可以通过允许用户简单地指定整体语义结构而不是建模几何,材料或照明来更容易地定制环境。

在本文中,我们讨论了一种从semantic label maps生成高分辨率图像的新方法。 该方法具有广泛的应用。 例如,我们可以使用它来创建用于训练视觉识别算法的综合训练数据,因为为所需场景创建语义标签要比生成训练图像容易得多。 使用语义分割方法,我们可以将图像转换为语义标签域,编辑标签域中的对象,然后将它们转换回图像域。 此方法还为我们提供了用于更高级别图像编辑的新工具,例如,向图像添加对象或更改现有对象的外观。

为了从语义标签合成图像,可以使用pix2pix方法,一种图像到图像的翻译框架[21],它利用条件设置中的生成对抗网络(GAN)[16]。最近,陈和Koltun [5]认为,对抗性训练可能不稳定,并且容易出现高分辨率图像生成任务的失败。相反,他们采用修改的感知损失[11,13,22]来合成图像,这些图像是高分辨率的,但通常缺乏精细的细节和逼真的纹理。

在这里,我们讨论了上述最先进方法的两个主要问题:(1)使用GAN生成高分辨率图像的难度[21]和(2)以前缺乏细节和逼真纹理高分辨率结果[5]。我们展示了通过新的,强大的adversarial learning objective togethr以及新的多尺度发生器和鉴别器架构,我们可以合成2048×1024分辨率的照片般逼真的图像,这些图像比以前的方法计算的更具视觉吸引力。 [5,21]。我们首先仅通过adversarial training 获得我们的结果,而不依赖于任何手工制造的损失[44]或预先训练的网络(例如VGGNet [48])的感知损失[11,22](图9c,10b) 。然后我们表明,如果预先训练好的网络是可用的,那么在预先训练的网络[48]中增加感知损失可以在某些情况下略微改善结果(图9d,10c)。两种结果都基本上在图像质量方面优于以前的工作。

(重要实现)此外,为了支持交互式语义操作,我们将方法扩展到两个方向。首先,我们使用实例级对象分段信息,它可以分隔同一类别中的不同对象实例。这样可以实现灵活的对象操作,例如添加/删除对象和更改对象类型。第二,我们提出了一种方法,在给定相同的输入标签图的情况下生成不同的结果,允许用户以交互方式编辑同一对象的外观。

我们比较了最先进的视觉合成系统[5,21],并表明我们的方法在定量评估和人类感知研究方面都优于这些方法。我们还对培训目标和实例级细分信息的重要性进行了消融研究。除了语义操作之外,我们还在edge2photo应用程序上测试了我们的方法(图2,13),这显示了我们方法的普遍性。代码和数据可在我们的网站上获得

Related work

生成性对抗网络生成性对抗网络(GAN)[16]旨在通过强制生成的样本与natural image 不可区分来模拟natural image分布。 GAN支持各种应用,如图像生成[1,42,62],representation learning[45],图像处理[64],物体检测[33]和视频应用[38,51,54]。已经提出了各种coarse-to-fine schemes[4] [9,19,26,57]在unconditional的设置中合成更大的图像(例如256×256)。受其成功的启发,我们提出了一种新的粗到精发生器和多尺度鉴别器架构,适用于以更高分辨率生成条件图像。

图像到图像的翻译许多研究人员利用对抗性学习进行图像到图像的翻译[21],其目的是将输入图像从输入输出图像对转换为另一个域作为训练数据。与通常导致模糊图像的L1 loss相比[21,22],adversarial loss[16]已成为许多图像到图像任务的流行选择[10,24,25,32,41,46,55] ,60,66]。原因是鉴别器可以学习可训练的损失函数并自动适应目标域中生成和真实图像之间的差异。例如,最近的pix2pix框架[21]使用图像条件GAN [39]用于不同的应用程序,例如将Google地图转换为卫星视图并从用户草图生成猫。在没有训练对的情况下,还提出了各种方法来学习图像到图像的转换[2,34,35,47,50,52,56,65]。

最近,Chen和Koltun [5]认为,由于训练不稳定性和优化问题,有条件的GAN可能很难产生高分辨率的图像。 为了避免这种困难,他们使用基于感知损失的直接回归目标[11,13,22]并产生可以合成2048×1024图像的第一个模型。 生成的结果是高分辨率,但往往缺乏精细的细节和逼真的纹理。 在他们的成功的推动下,我们展示了使用我们的新目标函数以及新颖的多尺度生成器和鉴别器,我们不仅在很大程度上稳定了高分辨率图像上条件GAN的训练,而且与以下相比也取得了明显更好的结果。 Chen和Koltun [5]。 并排比较清楚地显示了我们的优势(图1,9,8,10)。

深度视觉操作最近,深度神经网络在各种图像处理任务中获得了有希望的结果,例如样式转移[13],修复[41],着色[58]和恢复[14]。但是,大多数这些工作缺少用户调整当前结果或探索输出空间的界面。为了解决这个问题,朱等人。 [64]开发了一种优化方法,用于根据GAN学习的先验来编辑对象外观。最近的作品[21,46,59]还提供了用户界面,用于从低级线索(如颜色和草图)创建新颖的图像。所有先前的工作都报告了低分辨率图像的结果。我们的系统与过去的工作具有相同的精神,但我们专注于对象级语义编辑,允许用户与整个场景交互并操纵图像中的单个对象。因此,用户可以轻松地快速创建新场景。我们的界面受到先前数据驱动图形系统的启发[6,23,29]。但是我们的系统允许更灵活的操作并实时产生高分辨率结果。

3Instance-Level Image Synthesis

我们提出了一种CGAN,用于从semantic label image生成高分辨率照片般逼真的图像。 我们首先回顾一下我们的基线模型pix2pix(第3.1节)。 然后,我们描述了如何通过改进的目标函数和网络设计来增加照片级的真实感和分辨率(第3.2节)。 接下来,我们使用额外的实例级对象语义信息来进一步提高图像质量(第3.3节)。 最后,我们引入了一个实例级特征嵌入方案,以更好地处理图像合成的多模态特性,从而实现交互式对象编辑(第3.4节)。

(工作)1)基础模型-pix2pix 3.1 2)改进目标函数与网络架构实现高分辨率3.2 3)实例语义图像信息3.3 4)实例嵌入实现交互3.4

3.1.The pix2pix Baseline

pix2pix方法[21]是用于图像到图像转换的条件GAN框架。它由G和鉴别D.对于我们的任务,G的目标是把语义标签映射到逼真的图像,而鉴别D旨在从翻译者区分真实图像。该框架在监督环境中运作。换句话说,训练数据集是作为一组对应图像{(si,xi)}给出的,其中si是语义标签图,xi是对应的自然照片。条件GAN旨在通过input semantic label maps模拟real image的条件分布,通过以下

min max LGAN(G, D)

其中目标函数LGAN(G,D)1由下式给出

E(s,x)[log D(s, x)] + Es[log(1 − D(s, G(s))].

pix2pix方法采用U-Net [43]作为生成器,采用基于patch的完全卷积网络[36]作为鉴别器。D的input是semantic label map和相关的通图像的一个channelwise concatenation。然而,Cityscapes [7]上生成的图像的分辨率高达256×256。我们直接应用pix2pix框架测试生成高分辨率图像,但发现训练不稳定,生成图像质量不理想。因此,我们将描述如何改进pix2pix框架在下一小节中。

3.2Improving Photorealism and Resolution

我们通过使用coarse-to-fine生成器,multi-scale鉴别器架构和强大的对抗性学习目标函数来改进pix2pix框架。

coarse-to-fine G我们将生成器分解为两个子网:G1和G2。我们将G1称为全局生成器网络,将G2称为本地增强器网络。然后由图3中可视化的元组G = {G1,G2}给出生成器。全局生成器网络以1024×512的分辨率运行,并且本地增强器网络输出具有分辨率的图像。 4×前一个输出尺寸(沿每个图像尺寸2倍)。为了以更高的分辨率合成图像,可以使用其他本地增强器网络。例如,发生器G = {G1,G2}的输出图像分辨率是2048×1024,并且G = {G1,G2,G3}的输出图像分辨率是4096×2048。

我们的全局G建立在所提出的架构之上约翰逊等人(参考)。 [22],已证明成功用于高达512×512的图像上的神经样式传递。它由3个分量组成:concolutional fron-end G1(F),a set of residual blocksG1(R)[18],和transposed convolutional back-endG1(B)。分辨率1024×512的语义标签图顺序通过3个分量,以输出分辨率为1024×512的图像。

本地增强器网络还包括3个部分:concolutional fron-end G2(F),a set of residual blocksG2(R)[18],和transposed convolutional back-endG2(B)。 输入标签映射到G2的分辨率是2048×1024。与全局生成器网络不同,residual blocksG2(R)的输入是两个特征映射的元素和:G2(F)的输出特征映射,和全局G1(B)的back-end的最后一个特征映射。 这有助于整合G1到G2的全球信息

在训练过程中,我们首先训练全局G,然后按照它们的分辨率训练本地增强器。 然后,我们联合微调所有网络。 我们使用此G设计有效地聚合图像合成任务的全局和本地信息。 我们注意到,这种多分辨率流水线在计算机视觉中是一种成熟的实践[4],并且双尺度通常就足够了[3]。 在最近的无条件GAN [9,19]和条件图像生成[5,57]中可以找到类似的想法但不同的架构(参考)。

Multi-scale D

高分辨率图像合成对GAN鉴别器设计提出了重大挑战。为了区分高分辨率真实和合成图像,鉴别器需要具有大的感受野。这将需要更深的网络或更大的卷积内核,这两者都会增加网络容量并可能导致过度拟合。此外,这两种选择都需要更大的内存占用,这对于高分辨率图像生成来说已经是稀缺资源。

为了解决这个问题,我们建议使用multi-scale D。我们使用3个具有相同网络结构但在不同图像scale下工作的鉴别器。我们将鉴别器称为D1,D2和D3。具体来说,我们将真实和合成的高分辨率图像下采样2倍和4倍,以创建3个尺度的图像金字塔。然后训练D,D1,D2和D3以分别在3个不同的scale上区分真实和合成图像。虽然具有相同的结构,但以the coarsest scale运行的结构具有最大的接收场。它具有更全局的图像视图,可以指导生成器生成全局一致的图像。另一方面,the finest scaleD鼓励G产生更精细的细节。这也使得粗到细发生器的训练更容易,因为将低分辨率模型扩展到更高的分辨率只需要在最精细的水平上添加鉴别器,而不是从头开始重新训练。没有多尺度鉴别器,我们观察到生成的图像中经常出现许多重复的图案。

使用鉴别器,方程式中的学习问题。 然后成为一个多任务学习问题Multi-task

min maxG k=1,2,3LGAN(G, Dk ). (3)

在无条件的GAN中已经提出了使用相同图像尺度的多个GAN鉴别器[12]。 Iizuka等。(参考) [20]将全局图像分类器添加到条CGAN以合成用于修复的全局相干内容。在这里,我们将设计扩展到不同图像尺度的多个鉴别器,以便对高分辨率图像进行建模。

改善对抗性损失

我们改善了方程式中的GAN损失。 (2)通过结合基于鉴别器的特征匹配损失。这种损失稳定了培训,因为G必须在多个尺度上产生自然统计数据。具体来说,我们从鉴别器的多个层中提取特征,并学习如何匹配来自真实和合成图像的这些中间表示。为了便于呈现,我们将鉴别器Dk的第i层特征提取器表示为D(i)(从输入到Dk的第i层)。然后将特征匹配损失LFM(G,Dk)计算为:

其中T是层的总数,Ni表示每层中的元素数。我们的GAN鉴别器特征匹配损失与感知损失有关[11,13,22],已经证明它对图像超分辨率[32]和样式转移[22]有用。在我们的实验中,我们讨论了鉴别器特征匹配损失和感知损失如何共同用于进一步改善性能。我们注意到在VAE-GAN中使用了类似的损失[30]。

我们的完整目标将GAN损失和特征匹配损失结合起来:

其中λ控制着两个术语的重要性。请注意,对于特征匹配损失LFM,Dk仅用作特征提取器,并且不会使丢失LFM最大化

3.3Using Instance Maps

图4:使用实例映射:(a)典型的语义标签映射。 请注意,所有连接的汽车都有相同的标签,

这让人很难分开。 (b)提取的

实例边界图。 有了这些信息,就分开了

不同的对象变得更容易

(a) Semantic labels (b) Boundary map

图5:没有和在姿势图中的结果之间的比较。 可以看出,当添加实例边界时,相邻的车辆具有更清晰的边界。

现有的图像合成方法仅利用语义标签图[5,21,25],其中每个像素值表示像素的对象类。此map不区分同一类别的对象。另一方面,实例级语义标签映射包含每个单独对象的唯一对象ID。要合并实例映射,可以直接将其传递到网络中,或将其编码为单热矢量。然而,这两种方法在实践中难以实现,因为不同的图像可能包含相同类别的不同数量的对象。或者,可以为每个类预先分配固定数量的信道(例如,10),但是当该数量设置得太小时该方法失败,并且当该数量太大时浪费存储器。

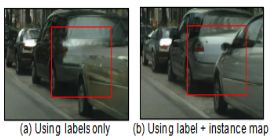

相反,我们认为实例映射提供的最重要的信息(在语义标签映射中不可用)是对象边界。例如,当同一个类的对象彼此相邻时,单独查看语义标签映射不能区分它们。对于街道场景尤其如此,因为许多停放的汽车或步行的行人通常彼此相邻,如图4a所示。但是,使用实例映射,分离这些对象变得更容易。

因此,为了提取这些信息,我们首先计算实例边界图(图4b)。在我们的实现中,(1boundary map 获得)如果实例边界映射中的像素的对象ID与其任何4个邻居不同,则该实例边界映射中的像素为1,否则为0。(2过程)然后将instance boundary map与semantic label map的one-hot vector表示连接,并馈送到G中。类似地,D的input是instance boundary map,semantic label map和真实/合成图像的通道顺序连接。图5b显示了通过使用对象边界来演示改进的示例。我们的用户研究在Sec。图4还示出了使用实例边界图训练的模型呈现更多照片般逼真的对象边界。

3.4Learning an Instance-level Feature Embedding

来自语义标签映射的图像合成是一对多映射问题。理想的图像合成算法应该能够使用相同的语义标签映射生成各种逼真的图像。最近,一些作品学习了在给定相同输入[5,15]的情况下产生固定数量的离散输出,或者合成由编码整个图像的潜码控制的不同模式[66]。虽然这些方法解决了多模态图像合成问题,但它们不适合我们的图像处理任务,主要有两个原因。首先,用户无法直观地控制模型将生成哪种图像[5,15]。其次,这些方法专注于全局颜色和纹理变化,并且不允许对生成的内容进行对象级控制。

为了生成不同的图像并允许实例级控制,我们建议添加额外的低维特征通道作为生G的输入。我们表明,通过操纵这些特征,我们可以灵活地控制图像合成过程。此外,请注意,由于特征通道是连续的数量,因此我们的模型原则上能够生成无限多的图像。

为了生成低维特征,我们训练编码器网络E以找到对应于图像中每个实例的地面实况目标的低维特征向量。我们的特征编码器架构是标准的编码器 - 解码器网络。为了确保每个实例中的特征一致,我们在编码器的输出中添加一个instance-wise average pooling layer,以计算对象实例的平均特征。然后将平均特征广播到实例的所有像素位置。图6显示了编码特征的示例。

我们用方程式中的G(s,E(x))代替G(s)。 (5)并与G和D一起训练encoder。 在训练encoder之后,我们在训练图像中的所有实例上运行它并记录所获得的特征。 然后,我们针对每个语义类别对这些功能执行K-means聚类。 因此,每个群集编码特定样式的特征,例如道路的沥青或鹅卵石纹理。 在推理时,我们随机选择一个聚类中心并将其用作编码特征。 这些功能与标签贴图连接在一起,并用作生成器的输入。 我们试图在特征空间上强制执行Kullback-Leibler损失[28],以便在最近的工作[66]中使用更好的测试时间采样,但发现用户可以直接调整每个对象的潜在向量。 相反,对于每个对象实例,我们提供K模式供用户选择。

4Results

我们首先提供与第二节中引导方法的定量比较。 4.1。然后,我们报告了一个主观的人类感知研究。 4.2。最后,我们在Sec中展示了几个交互式对象编辑结果的例子。 4.3。

实施细节我们使用LSGAN [37]进行稳定的培训。在所有实验中,我们设定K =平均值的权重λ= 10(Eq。(5))和K = 10。我们使用三维向量来编码每个对象实例的特征。我们尝试添加感知损失

我们的目标(方程(5)),其中λ= 10,F(i)表示第i层

与VGG网络的Mi元素。我们观察到这种损失略微改善了结果。我们将这两个变体命名为我们和我们的(没有VGG损失)。请在附录中找到更多培训和架构详细信息。

数据集我们对Cityscapes数据集[7]和NYU Indoor RGBD数据集[40]进行了广泛的比较和消融研究。我们报告了ADE20K数据集[63]和Helen Face数据集[31,49]的其他定性结果。

基线我们将我们的方法与两种最先进的算法进行比较:pix2pix [21]和CRN [5]。我们使用默认设置在高分辨率图像上训练pix2pix模型。我们通过作者的公开模型生成高分辨率CRN图像。

4.1。定量比较

我们采用与之前的图像到图像翻译工作相同的评估协议[21,65]。为了量化我们的结果质量,我们对合成图像进行语义分割,并比较预测片段与输入的匹配程度。直觉是,如果我们能够产生对应于输入标签图的真实图像,那么现成的语义分割模型(例如,我们使用的PSPNet [61])应该能够预测地面真实标签。表1报告了计算的分段准确度。可以看出,对于像素精度和平均交叉结合(IoU),我们的方法大大优于其他方法。而且,我们的结果非常接近原始图像的结果,即我们可以实现的现实主义的理论“上限”。这证明了我们的算法的优越性。

4.2。人类知觉研究

我们通过人类主观研究进一步评估我们的算法。我们在Cityscapes数据集[7]上执行部署在Amaon zon Mechanical Turk(MTurk)平台上的成对A / B测试。我们遵循Chen和Koltun [5]中描述的相同实验程序。更具体地,进行两种不同类型的实验:无限时间和有限时间,如下所述。

无限时间对于此任务,工作人员一次获得两个图像,每个图像由相同标签图的不同方法合成。我们给他们无限的时间来选择哪个图像看起来更自然。 leftright顺序和图像顺序是随机的,以确保公平的比较。所有500个Cityscapes测试图像比较10次,每种方法产生5,000个人类判断。在本实验中,我们仅使用在标签上训练的模型(没有实例图)来确保公平比较。表2显示我们的方法的两个变体都显着优于其他方法。

有限的时间接下来,在限时实验中,我们将结果与CRN和原始图像(地面实况)进行比较。在每次比较中,我们在短时间内显示两种方法的结果。我们随机选择1/8秒到8秒之间的持续时间,这是之前的工作[5]所采用的。这评估了可以感知图像之间的差异的速度。图7显示了不同时间间隔的比较结果。随着给定时间变得越来越长,这三种图像之间的差异变得更加明显且更容易观察。图9和10显示了一些示例结果。

损失函数的分析我们还使用无限时间实验研究每个术语在我们的目标函数中的重要性。具体来说,我们的最终损失包含三个组成部分:GAN损失,基于鉴别器的特征匹配丢失和VGG感知损失。我们使用(1)仅GAN损失和(2)GAN +特征匹配损失(即,没有VGG损失)将我们的最终实现与结果进行比较。获得的优惠率分别为68.55%和58.90%。可以看出,添加特征匹配损失实质上改善了性能,而增加感知损失进一步增强了结果。然而,请注意,使用感知损失并不重要,并且即使没有它,我们仍然能够产生视觉上吸引人的结果(例如,图9c,10b)。

使用实例映射我们使用实例映射将结果与结果进行比较而不使用它们。我们突出显示图像中的汽车区域,并要求参与者选择哪个区域看起来更逼真。我们获得了64.34%的偏好率,这表明使用实例映射可以改善结果的真实性,特别是在对象边界附近。

G的分析我们将不同发电机的结果与所有其他固定的组件进行比较。特别是,我们将我们的发电机与两种最先进的发电机架构进行比较:U-Net [21,43]和CRN [5]。我们评估语义分段分数和人类感知研究结果的表现。表3和表4显示,我们的粗到精发电机大大优于其他网络。

鉴别器的分析接下来,我们还使用我们的多尺度鉴别器和仅使用一个鉴别器的结果来比较结果,同时保持发生器和损耗函数的固定。 Cityscapes [7](表5)的细分分数表明,使用多尺度鉴别器有助于产生更高质量的结果并稳定对抗训练。我们还在Amazon Mechanical Turk平台上执行成对A / B测试。 69.2%的参与者更喜欢我们的多尺度结果

其他数据集为了进一步评估我们的方法,我们对NYU数据集进行无限时间比较。我们分别获得了对pix2pix和CRN的86.7%和63.7%。图8显示了一些示例图像。最后,我们在ADE20K [63]数据集上显示结果(图11)。

4.3。交互式对象编辑

我们的特征编码器允许我们对生成的图像执行交互式实例编辑。例如,我们可以更改图像中的对象标签,以快速创建新的场景,例如用建筑物替换树木(图1b)。我们还可以改变单个车辆的颜色或道路的纹理(图1c)。请在我们的网站上查看我们的互动演示。

此外,我们在Helen Face数据集上实现了交互式对象编辑功能,其中可以获得不同面部部位的标签[49](图12)。这使得编辑人类肖像变得容易,例如,改变面部颜色以模仿不同的化妆效果或者向脸部添加胡须。

5.讨论和结论

本文的结果表明,条件GAN可以合成高分辨率的照片般逼真的图像,而不会产生任何手工制作的损失或预先训练好的网络。我们观察到,结合感知损失[22]可以略微改善结果。我们的方法允许许多应用,并且可能对需要高分辨率结果但没有预训练网络的领域有用(例如,医学成像[17]和生物学[8])。

本文还表明,图像到图像合成流水线可以扩展以产生不同的输出,并在适当的训练输入 - 输出对(例如,我们的情况下的实例图)中实现交互式图像处理。在没有被告知什么是“纹理”的情况下,我们的模型学习了不同对象的样式化,这也可以推广到其他数据集(即,使用一个数据集中的纹理来合成另一个数据集中的图像)。我们相信这些扩展可能会应用于其他图像合成问题。

致谢我们感谢Taesung Park,Phillip Isola,Tinghui Zhou,Richard Zhang,Rafael Valle和Alexei

A.Efros的有用评论。我们还要感谢Chen和Koltun [5]以及Isola等人。 [21]用于分享他们的代码。 JYZ得到Facebook毕业生奖学金的支持。

6.Training Details

使用Adam解算器[27]并且学习率为0.0002,从头开始训练所有网络。我们在前100个时期保持相同的学习率,并在接下来的100个时期内将速率线性衰减为零。权重从高斯分布初始化,平均值为0,标准差为0.02。我们在配备24GB GPU内存的NVIDIA Quadro M6000 GPU上训练所有型号。

在具有11GB GPU内存的NVIDIA 1080Ti GPU上,每2048×1024输入图像的推理时间在20~30毫秒之间。这种实时性能使我们能够开发交互式图像编辑应用程序。

下面我们讨论我们使用的数据集的细节。

•Cityscapes数据集[7]:来自Cityscapes训练集的2975个训练图像,图像大小为2048×1024。我们使用Cityscapes验证集进行测试,其中包含500个图像。

•纽约大学室内RGBD数据集[40]:1200个训练图像和249个测试图像,分辨率为561×427。

•ADE20K数据集[63]:20210个训练图像和2000个具有不同图像大小的测试图像。在训练和推断之前,我们将所有图像的宽度缩放到512。

•Helen Face数据集[31,49]:2000个训练图像和330个具有不同图像大小的测试图像。在训练和推断之前,我们将所有图像的大小调整为1024×1024。

7Generator Architectures

我们的发电机由全球发电机网络和本地增强器网络组成。我们遵循Johnson el al中使用的命名约定。 [22]和CycleGAN [65]。令c7s1-k表示7×7卷积 - 实例范数[53] - 具有k个滤波器和步幅1的ReLU层.dk表示具有k个滤波器的3×3卷积 - 实例范数 - ReLU层,并且

我们使用反射填充来减少边界伪影。 Rk表示包含两个3×3卷积层的残余块,在两个层上具有相同数量的滤波器。 uk表示带有k个滤波器的3×3分数跨度卷积 - 实例范数 - ReLU层,并且步长为1/2

回想一下,我们有两个生成器:全局生成器和本地增强器。

我们的全球网络:

c7s1-64,d128,d256,d512,d1024,R1024,R1024,R1024,R1024,R1024,R1024,R1024,R1024,R1024,u512,u256,u128,u64,c7s1-3

我们的本地增强器:

c7s1-32,D642,R64,R64,R64,U32,c7s1-3

8.Discriminator Architectures

对于鉴别器网络,我们使用70×70 Patch-GAN [21]。设Ck表示具有k个滤波器和步幅2的4×4卷积 - 实例范数 - LeakyReLU层。在最后一层之后,我们应用卷积来产生1维输出。我们不将InstanceNorm用于第一个C64层。我们使用斜率为0.2的泄漏ReLU。我们所有的三个鉴别器都具有如下相同的架构:

C64-C128,C256-C512

D.Change日志

v1初始预打印版本

v2 CVPR相机就绪,为边缘到照片示例添加了更多结果。

9.figure and table

图1:我们提出了一种生成对抗框架,用于从语义标签图((a)中的左下角)合成2048×1024图像。 与之前的作品[5]相比,我们的结果表达了更自然的纹理和细节。 (b)我们可以更改原始标签图中的标签以创建新场景,例如用建筑物替换树木。 (c)我们的框架还允许用户编辑场景中各个对象的外观,例如, 改变汽车的颜色或道路的纹理。 请访问我们的网站进行更多的并排比较以及交互式编辑演示。

图2:使用我们的框架将边缘转换为高分辨率自然照片的示例结果,使用CelebA-HQ [26]和网络猫图像。

图3:我们的发电机的网络架构。 我们首先在较低分辨率图像上训练残余网络G1。 然后,将另一个剩余网络G2附加到G1,并且在高分辨率图像上联合训练两个网络。 具体地,G2中残差块的输入是来自G2的特征图和来自G1的最后特征图的元素和。

图4:使用实例映射:(a)典型的语义标签映射。 请注意,所有连接的汽车都有相同的标签,这使得很难区分它们。 (b)提取的实例边界图。 有了这些信息,分离不同的对象变得更加容易。

图5:没有和有实例映射的结果之间的比较。 可以看出,当添加实例边界信息时,相邻车辆具有更清晰的边界。

图6:除了用于生成图像的标签之外,还使用实例方式的功能。

表1:Cityscapes数据集上不同方法对结果的语义分段得分[7]。 我们的结果大大优于其他方法,并且非常接近原始图像(即oracle)的准确度。

表2:Cityscapes数据集的成对比较结果[7](无限时间)。 每个单元格列出了我们的结果优先于其他方法的百分比。 机会是50%。

图7:限时比较结果。 每行显示一种方法优先于另一种方法的百分比。

表3:使用Cityscapes数据集上不同生成器的结果的语义分段分数[7]。 我们的发电机得分最高。

表4:Cityscapes数据集的成对比较结果[7]。 每个单元格列出了我们的结果优先于其他方法的百分比。 机会是50%。

表5:使用Cityscapes数据集上的单个鉴别器(单个D)或多尺度鉴别器(多尺度Ds)对结果进行语义分段评分[7]。 使用多尺度鉴别器有助于提高分割分数。

图8:纽约大学数据集的比较[40]。 我们的方法比其他方法生成更逼真和丰富多彩的图像。

(c)我们的(没有VGG损失)(d)我们(带有VGG损失)

图9:Cityscapes数据集的比较[7]((a)中左下角显示的标签图)。 对于没有和有VGG损失的情况,我们的结果比其他两种方法更加真实。 请放大细节。

图10:城市景观数据集上与CRN [5]的其他比较结果。 同样,我们的结果在合成汽车,树木,建筑物等方面都有更精细的细节。请放大细节。

图11:ADE20K数据集的结果[63]((a)中左下角显示的标签图)。 我们的方法以与原始图像相似的逼真度生成图像。

图12:Helen Face数据集[49]的不同结果(标签图显示在左下角)。 通过我们的界面,用户可以实时编辑各个面部部件的属性,例如改变肤色或添加眉毛和胡须。 有关详情,请参阅我们的视频。

图13:CelebA-HQ数据集上的边对面结果示例[26](左下角显示的边缘图)。