3.1.1特征抽取

特征抽取,就是逐条将原始数据转化为特征向量的形式,这个过程同时涉及对数据特征的量化表示;而特征筛选则更进一步,在高维度、已量化的特征向量中选择对指定任务更有效的特征组合,进一步提升模型性能。

3.1.1.1特征抽取

原始数据的种类有很多种,除了数字化的信号数据(声纹、图像),还有大量符号化的文本。然而,我们无法直接将符号化的文字本身用于计算任务,而是需要通过某些处理手段,预先将文本量化为特征向量。

有些用符号表示的数据特征已经相对结构化,并且以字典这种数据结构进行存储。这时,我们使用DictVectorizer对特征进行抽取和向量化。

DictVectorizer对使用字典存储的数据进行特征抽取与向量化

#定义一组字典列表,用来表示多个数据样本(每个字典代表一个数据样本)。

measurements=[{'city':'Dubai','temperature':33.},{'city':'London','temperature':12.},{'city':'San Fransisco','temperature':18.}]

from sklearn.feature_extraction import DictVectorizer

#初始化DictVectorizer特征抽取器

vec=DictVectorizer()

#输出转化之后的特征矩阵

print(vec.fit_transform(measurements).toarray())

#输出各个维度的特征含义

print(vec.get_feature_names())

[[ 1. 0. 0. 33.]

[ 0. 1. 0. 12.]

[ 0. 0. 1. 18.]]

['city=Dubai', 'city=London', 'city=San Fransisco', 'temperature']

在特征向量化的过程中,DictVectorizer对于类别型与数值型特征的处理方式有很大差异。由于类别型特征无法直接数字化表示,因此需要借助原特征的名称,组合产生新的特征,并采用0/1二值方式进行量化;而数值型转化则相对方便,一般情况下只需要维持原始特征值即可。

另外一些文本数据则表现得更为原始,几乎没有使用特殊的数据结构进行存储,只是一系列字符串。我们处理这些数据,比较常用的文本特征表示方法为词袋法:顾名思义,不考虑词语出现的顺序,只是将训练文本中的每个出现过的词汇单独视作一列特征。我们称这些不重复的词汇集合为词表,于是每条训练文本都可以在高维度的词表上映射出一个特征向量。而特征数值的常见计算方式有两种,分别是:CountVectorizer和TfidfVectorizer。对于每一条训练文本,CountVectorizer只考虑每种词汇(Term)在该条训练样本中出现的频率(Term Frequency)。而TfidfVectorizer除了考量某一词汇在当前文本中出现的频率(Term Frequency)之外,同时关注包含这个词汇的文本条数的倒数。相比之下,训练文本的条目越多,TfidfVectorizer这种特征量化方式就更有优势。因为我们计算词频(Term Frequency)的目的在于找出对所有文本的含义就更有贡献的重要词汇。然而,如果一个词汇几乎在每篇文本中出现,说明这是一个常用词汇,反而不会帮助模型对文本的分类;在训练样本较多的时候,利用TfidfVectorizer压制这些常用词汇的对分类决策的干扰,往往可以起到提升模型性能的作用。

我们通常称这些在每条文本中都出现的常用词汇为停用词(Stop Words),如英文中的the、a等。这些停用词在文本特征抽取中经常以黑名单的方式过滤掉,并且用来提高模型的性能表现。

使用CountVectorizer并且不去掉停用词的条件下,对文本特征进行量化的朴素贝叶斯分类性能测试

from sklearn.datasets import fetch_20newsgroups

#从互联网上即时下载新闻样本,subset=‘all’参数代表下载全部近2万条文本存储在变量news中。

news=fetch_20newsgroups(subset='all')

from sklearn.cross_validation import train_test_split

X_train,X_test,y_train,y_test=train_test_split(news.data,news.target,test_size=0.25,random_state=33)

from sklearn.feature_extraction.text import CountVectorizer

#采用默认的配置CountVectorizer进行初始化(默认配置不去除英文停用词),并且赋值给变量count_vec。

count_vec=CountVectorizer()

#只使用词频统计的方式将原始训练和测试文本转化为特征向量。

X_count_train=count_vec.fit_transform(X_train)

X_count_test=count_vec.transform(X_test)

from sklearn.naive_bayes import MultinomialNB

#采用默认的配置进行初始化

mnb_count=MultinomialNB()

#使用朴素贝叶斯分类器,对CountVectorizer(不去除停用词)后的训练样本进行参数学习。

mnb_count.fit(X_count_train,y_train)

#输出模型准确性结果

print('The accuracy of classifying 20newsgroups using Naive Bayes(CountVectorizer without filtering stopwords):',mnb_count.score(X_count_test,y_test))

The accuracy of classifying 20newsgroups using Naive Bayes(CountVectorizer without filtering stopwords): 0.839770797963

#将分类预测结果存储在变量y_count_predict中。

y_count_predict=mnb_count.predict(X_count_test)

from sklearn.metrics import classification_report

#输出更加详细的其他评价分类性能的指标

print(classification_report(y_test,y_count_predict,target_names=news.target_names))

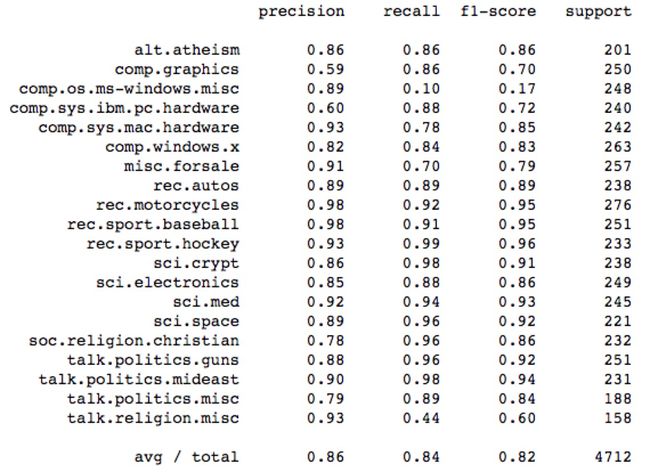

使用CountVectorizer在不去掉停用词的条件下,对训练和测试样本进行特征量化,并利用默认配置的朴素贝叶斯分类器,在测试文本可以得到83.977%的预测准确性。而且,平均精度、召回率和F1指标,分别是0.86、0.84以及0.82。

使用TfidfVectorizer并且不去掉停用词的条件下,对文本特征进行量化的朴素贝叶斯分类性能测试

#采用默认的配置TfidfVectorizer进行初始化(默认配置不去除英文停用词),并且赋值给变量tfidf_vec。

from sklearn.feature_extraction.text import TfidfVectorizer

tfidf_vec=TfidfVectorizer()

#只使用tfidf的方式将原始训练和测试文本转化为特征向量。

X_tfidf_train=tfidf_vec.fit_transform(X_train)

X_tfidf_test=tfidf_vec.transform(X_test)

#依然使用默认配置的朴素贝叶斯分类器,在相同的训练和测试数据上,对新的特征量化方式进行性能评估。

mnb_tfidf=MultinomialNB()

#使用朴素贝叶斯分类器,对TfidfVectorizer(不去除停用词)后的训练样本进行参数学习。

mnb_tfidf.fit(X_tfidf_train,y_train)

#输出模型准确性结果

print('The accuracy of classifying 20newsgroups using Naive Bayes(TfidfVectorizer without filtering stopwords):',mnb_tfidf.score(X_tfidf_test,y_test))

The accuracy of classifying 20newsgroups using Naive Bayes(TfidfVectorizer without filtering stopwords): 0.846349745331

#将分类预测结果存储在变量y_tfidf_predict中。

y_tfidf_predict=mnb_tfidf.predict(X_tfidf_test)

#输出更加详细的其他评价分类性能的指标

print(classification_report(y_test,y_tfidf_predict,target_names=news.target_names))

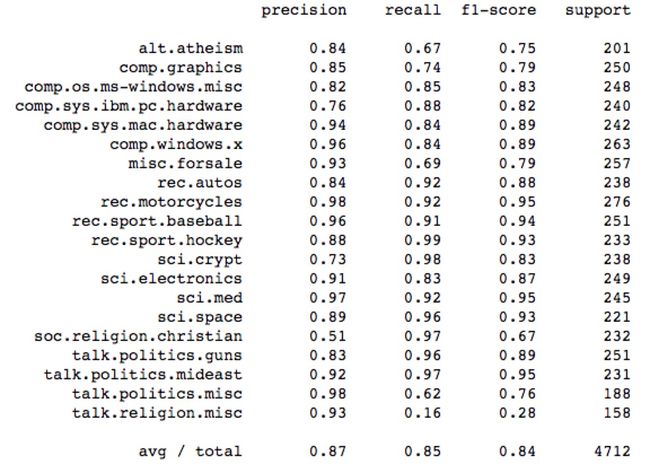

使用TfidfVectorizer在不去掉停用词的条件下,对训练和测试样本进行特征量化,并利用默认配置的朴素贝叶斯分类器,在测试文本可以得到比CountVectorizer更加高的预测准确性,即从83.977%提升到84.635%。而且,平均精度、召回率和F1指标,分别是0.86、0.84以及0.82。

使用CountVectorizer与TfidfVectorizer,并且不去掉停用词的条件下,对文本特征进行量化的朴素贝叶斯分类性能测试

count_filter_vec,tfidf_filter_vec=CountVectorizer(analyzer='word',stop_words='english'),TfidfVectorizer(analyzer='word',stop_words='english')

#使用带有停用词过滤的CountVectorizer对训练和测试文本分别进行量化处理

X_count_filter_train=count_filter_vec.fit_transform(X_train)

X_count_filter_test=count_filter_vec.transform(X_test)

#使用带有停用词过滤的TfidsVectorizer对训练和测试文本分别进行量化处理

X_tfidf_filter_train=tfidf_filter_vec.fit_transform(X_train)

X_tfidf_filter_test=tfidf_filter_vec.transform(X_test)

mnb_count_filter=MultinomialNB()

mnb_count_filter.fit(X_count_filter_train,y_train)

print('The accuracy of classifying 20newsgroups using Naive Bayes(CountVectorizer by filtering stopwords):',mnb_count_filter.score(X_count_filter_test,y_test))

y_count_filter_predict=mnb_count_filter.predict(X_count_filter_test)

mnb_tfidf_filter=MultinomialNB()

mnb_tfidf_filter.fit(X_tfidf_filter_train,y_train)

print('The accuracy of classifying 20newsgroups using Naive Bayes(TfidfVectorizer by filtering stopwords):',mnb_tfidf_filter.score(X_tfidf_filter_test,y_test))

y_tfidf_filter_predict=mnb_tfidf_filter.predict(X_tfidf_filter_test)

The accuracy of classifying 20newsgroups using Naive Bayes(CountVectorizer by filtering stopwords): 0.863752122241

The accuracy of classifying 20newsgroups using Naive Bayes(TfidfVectorizer by filtering stopwords): 0.882640067912

from sklearn.metrics import classification

print(classification_report(y_test,y_count_filter_predict,target_names=news.target_names))

print(classification_report(y_test,y_tfidf_filter_predict,target_names=news.target_names))

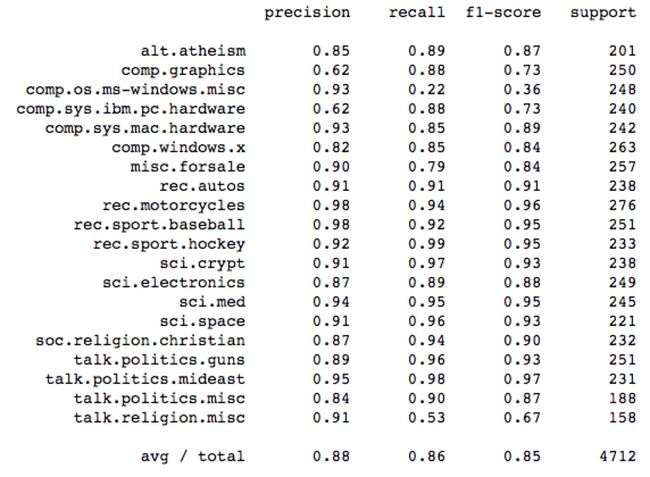

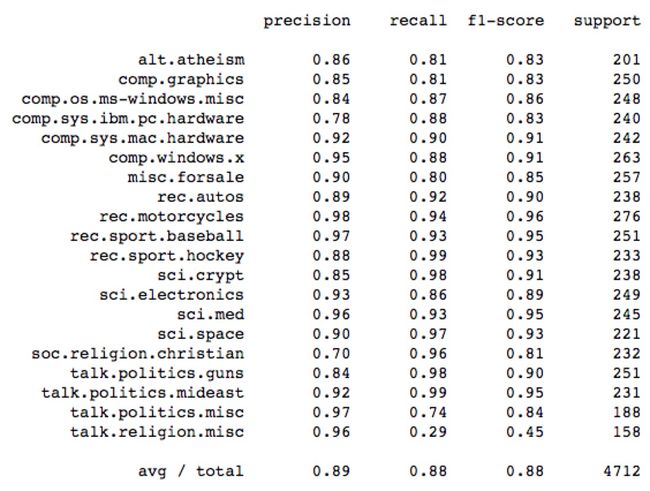

结果证明TfidfVectorizer的特征抽取和量化方法更加具备优势;对停用词进行过滤的文本特征抽取方法,平均要比不过滤停用词的模型综合性能高出3%~4%。