前言

本文章内容参考自RocketMQ系统精讲,经受历年双十一狂欢节考验的分布式消息中间件,对已有内容进行修改,精简部分内容,并且使用spring-cloud-starter-stream-rocketmq来代替B站视频中的spring-boot集成包。修改后的个人完整demo地址:github

1. MQ介绍

1.1 为什么要用MQ

消息队列是一种“先进先出”的数据结构

其应用场景主要包含以下3个方面

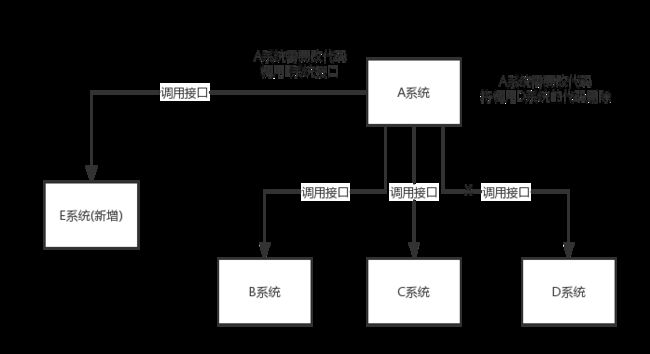

- 应用解耦

系统的耦合性越高,容错性就越低。以电商应用为例,用户创建订单后,如果耦合调用库存系统、物流系统、支付系统,任何一个子系统出了故障或者因为升级等原因暂时不可用,都会造成下单操作异常,影响用户使用体验。

使用消息队列解耦合,系统的耦合性就会提高了。比如物流系统发生故障,需要几分钟才能来修复,在这段时间内,物流系统要处理的数据被缓存到消息队列中,用户的下单操作正常完成。当物流系统回复后,补充处理存在消息队列中的订单消息即可,终端系统感知不到物流系统发生过几分钟故障。

- 流量削峰

应用系统如果遇到系统请求流量的瞬间猛增,有可能会将系统压垮。有了消息队列可以将大量请求缓存起来,分散到很长一段时间处理,这样可以大大提到系统的稳定性和用户体验。

一般情况,为了保证系统的稳定性,如果系统负载超过阈值,就会阻止用户请求,这会影响用户体验,而如果使用消息队列将请求缓存起来,等待系统处理完毕后通知用户下单完毕,这样总不能下单体验要好。

处于经济考量目的:

业务系统正常时段的QPS如果是1000,流量最高峰是10000,为了应对流量高峰配置高性能的服务器显然不划算,这时可以使用消息队列对峰值流量削峰

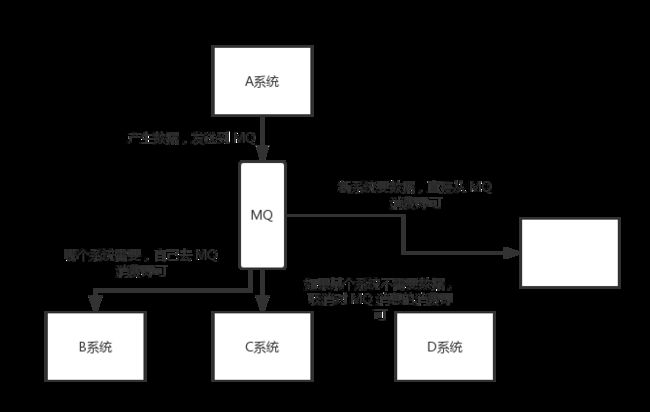

- 数据分发

通过消息队列可以让数据在多个系统更加之间进行流通。数据的产生方不需要关心谁来使用数据,只需要将数据发送到消息队列,数据使用方直接在消息队列中直接获取数据即可

1.2 MQ的优点和缺点

优点:解耦、削峰、数据分发

缺点包含以下几点:

系统可用性降低

系统引入的外部依赖越多,系统稳定性越差。一旦MQ宕机,就会对业务造成影响。

如何保证MQ的高可用?

系统复杂度提高

MQ的加入大大增加了系统的复杂度,以前系统间是同步的远程调用,现在是通过MQ进行异步调用。

如何保证消息没有被重复消费?怎么处理消息丢失情况?那么保证消息传递的顺序性?

一致性问题

A系统处理完业务,通过MQ给B、C、D三个系统发消息数据,如果B系统、C系统处理成功,D系统处理失败。

如何保证消息数据处理的一致性?

2. RocketMQ快速入门

RocketMQ是阿里巴巴2016年MQ中间件,使用Java语言开发,在阿里内部,RocketMQ承接了例如“双11”等高并发场景的消息流转,能够处理万亿级别的消息。

2.1 安装RocketMQ

2.1.1 在虚拟机上安装docker

参考我的博客中docker安装的文章CentOS下docker安装

2.1.2 创建目录结构以及编写docker-compose文件

完整文件目录结构如下(自行忽略无用部分。。。):

version: "3.5"

services:

#RocketMQ

rmqnamesrv:

image: foxiswho/rocketmq:server-4.5.2

container_name: rmqnamesrv

ports:

- 9876:9876

volumes:

- ./data/rocketmq/namesrv/logs:/opt/logs

- ./data/rocketmq/namesrv/store:/opt/store

environment:

JAVA_OPT_EXT: "-Duser.home=/opt -Xms128m -Xmx128m -Xmn128m"

restart: always

networks:

rmq:

aliases:

- rmqnamesrv

rmqbroker:

image: foxiswho/rocketmq:broker-4.5.2

container_name: rmqbroker

ports:

- 10909:10909

- 10911:10911

volumes:

- ./data/rocketmq/broker/logs:/opt/logs

- ./data/rocketmq/broker/store:/opt/store

- ./rocketmq/broker.conf:/etc/rocketmq/broker.conf

environment:

JAVA_OPT_EXT: "-Duser.home=/opt -server -Xms128m -Xmx128m -Xmn128m"

command: ["/bin/bash","mqbroker","-c","/etc/rocketmq/broker.conf","-n","rmqnamesrv:9876","autoCreateTopicEnable=true"]

restart: always

depends_on:

- rmqnamesrv

networks:

rmq:

aliases:

- rmqbroker

rmqconsole:

image: styletang/rocketmq-console-ng

container_name: rmqconsole

ports:

- 8180:8080

environment:

JAVA_OPTS: "-Drocketmq.namesrv.addr=rmqnamesrv:9876 -Dcom.rocketmq.sendMessageWithVIPChannel=false"

depends_on:

- rmqnamesrv

networks:

rmq:

aliases:

- rmqconsole

networks:

rmq:

name: rmq

driver: bridgebroker.conf配置文件内容

# 所属集群名字

brokerClusterName=DefaultCluster

# broker 名字,注意此处不同的配置文件填写的不一样,如果在 broker-a.properties 使用: broker-a,

# 在 broker-b.properties 使用: broker-b

brokerName=broker-a

# 0 表示 Master,> 0 表示 Slave

brokerId=0

# nameServer地址,分号分割

# namesrvAddr=rocketmq-nameserver1:9876;rocketmq-nameserver2:9876

# 启动IP,如果 docker 报 com.alibaba.rocketmq.remoting.exception.RemotingConnectException: connect to <192.168.0.120:10909> failed

# 解决方式1 加上一句 producer.setVipChannelEnabled(false);,解决方式2 brokerIP1 设置宿主机IP,不要使用docker 内部IP

brokerIP1=my.service.com

# 在发送消息时,自动创建服务器不存在的topic,默认创建的队列数

defaultTopicQueueNums=4

# 是否允许 Broker 自动创建 Topic,建议线下开启,线上关闭 !!!这里仔细看是 false,false,false

autoCreateTopicEnable=true

# 是否允许 Broker 自动创建订阅组,建议线下开启,线上关闭

autoCreateSubscriptionGroup=true

# sql过滤支持

enablePropertyFilter = true

# Broker 对外服务的监听端口

listenPort=10911

# 删除文件时间点,默认凌晨4点

deleteWhen=04

# 文件保留时间,默认48小时

fileReservedTime=120

# commitLog 每个文件的大小默认1G

mapedFileSizeCommitLog=1073741824

# ConsumeQueue 每个文件默认存 30W 条,根据业务情况调整

mapedFileSizeConsumeQueue=300000

# destroyMapedFileIntervalForcibly=120000

# redeleteHangedFileInterval=120000

# 检测物理文件磁盘空间

diskMaxUsedSpaceRatio=88

# 存储路径

# storePathRootDir=/home/ztztdata/rocketmq-all-4.1.0-incubating/store

# commitLog 存储路径

# storePathCommitLog=/home/ztztdata/rocketmq-all-4.1.0-incubating/store/commitlog

# 消费队列存储

# storePathConsumeQueue=/home/ztztdata/rocketmq-all-4.1.0-incubating/store/consumequeue

# 消息索引存储路径

# storePathIndex=/home/ztztdata/rocketmq-all-4.1.0-incubating/store/index

# checkpoint 文件存储路径

# storeCheckpoint=/home/ztztdata/rocketmq-all-4.1.0-incubating/store/checkpoint

# abort 文件存储路径

# abortFile=/home/ztztdata/rocketmq-all-4.1.0-incubating/store/abort

# 限制的消息大小

maxMessageSize=65536

# flushCommitLogLeastPages=4

# flushConsumeQueueLeastPages=2

# flushCommitLogThoroughInterval=10000

# flushConsumeQueueThoroughInterval=60000

# Broker 的角色

# - ASYNC_MASTER 异步复制Master

# - SYNC_MASTER 同步双写Master

# - SLAVE

brokerRole=ASYNC_MASTER

# 刷盘方式

# - ASYNC_FLUSH 异步刷盘

# - SYNC_FLUSH 同步刷盘

flushDiskType=ASYNC_FLUSH

# 发消息线程池数量

# sendMessageThreadPoolNums=128

# 拉消息线程池数量

# pullMessageThreadPoolNums=1282.1.3 执行docker-compose up -d等待执行完成

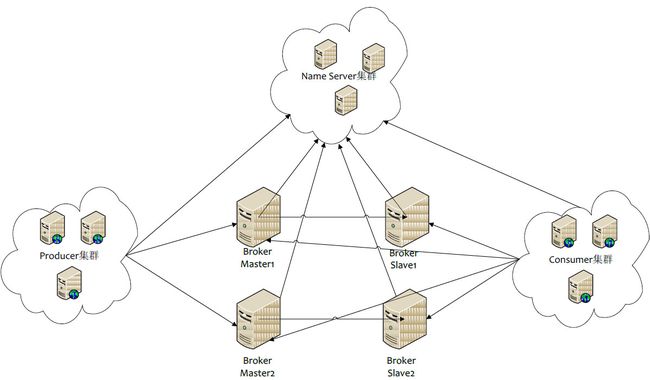

3. RocketMQ集群搭建

3.1 各角色介绍

- Producer:消息的发送者;举例:发信者

- Consumer:消息接收者;举例:收信者

- Broker:暂存和传输消息;举例:邮局

- NameServer:管理Broker;举例:各个邮局的管理机构

- Topic:区分消息的种类;一个发送者可以发送消息给一个或者多个Topic;一个消息的接收者可以订阅一个或者多个Topic消息

- Message Queue:相当于是Topic的分区;用于并行发送和接收消息

3.2 集群搭建方式

3.2.1 集群特点

NameServer是一个几乎无状态节点,可集群部署,节点之间无任何信息同步。

- Broker部署相对复杂,Broker分为Master与Slave,一个Master可以对应多个Slave,但是一个Slave只能对应一个Master,Master与Slave的对应关系通过指定相同的BrokerName,不同的BrokerId来定义,BrokerId为0表示Master,非0表示Slave。Master也可以部署多个。每个Broker与NameServer集群中的所有节点建立长连接,定时注册Topic信息到所有NameServer。

- Producer与NameServer集群中的其中一个节点(随机选择)建立长连接,定期从NameServer取Topic路由信息,并向提供Topic服务的Master建立长连接,且定时向Master发送心跳。Producer完全无状态,可集群部署。

Consumer与NameServer集群中的其中一个节点(随机选择)建立长连接,定期从NameServer取Topic路由信息,并向提供Topic服务的Master、Slave建立长连接,且定时向Master、Slave发送心跳。Consumer既可以从Master订阅消息,也可以从Slave订阅消息,订阅规则由Broker配置决定。

3.2.3 集群模式

1)单Master模式

这种方式风险较大,一旦Broker重启或者宕机时,会导致整个服务不可用。不建议线上环境使用,可以用于本地测试。

2)多Master模式

一个集群无Slave,全是Master,例如2个Master或者3个Master,这种模式的优缺点如下:

- 优点:配置简单,单个Master宕机或重启维护对应用无影响,在磁盘配置为RAID10时,即使机器宕机不可恢复情况下,由于RAID10磁盘非常可靠,消息也不会丢(异步刷盘丢失少量消息,同步刷盘一条不丢),性能最高;

- 缺点:单台机器宕机期间,这台机器上未被消费的消息在机器恢复之前不可订阅,消息实时性会受到影响。

3)多Master多Slave模式(异步)

每个Master配置一个Slave,有多对Master-Slave,HA采用异步复制方式,主备有短暂消息延迟(毫秒级),这种模式的优缺点如下:

- 优点:即使磁盘损坏,消息丢失的非常少,且消息实时性不会受影响,同时Master宕机后,消费者仍然可以从Slave消费,而且此过程对应用透明,不需要人工干预,性能同多Master模式几乎一样;

- 缺点:Master宕机,磁盘损坏情况下会丢失少量消息。

4)多Master多Slave模式(同步)

每个Master配置一个Slave,有多对Master-Slave,HA采用同步双写方式,即只有主备都写成功,才向应用返回成功,这种模式的优缺点如下:

- 优点:数据与服务都无单点故障,Master宕机情况下,消息无延迟,服务可用性与数据可用性都非常高;

- 缺点:性能比异步复制模式略低(大约低10%左右),发送单个消息的RT会略高,且目前版本在主节点宕机后,备机不能自动切换为主机。

3.3 双主双从集群搭建

3.3.1 总体架构

消息高可用采用2m-2s(同步双写)方式

3.3.2 集群工作流程

- 启动NameServer,NameServer起来后监听端口,等待Broker、Producer、Consumer连上来,相当于一个路由控制中心。

- Broker启动,跟所有的NameServer保持长连接,定时发送心跳包。心跳包中包含当前Broker信息(IP+端口等)以及存储所有Topic信息。注册成功后,NameServer集群中就有Topic跟Broker的映射关系。

- 收发消息前,先创建Topic,创建Topic时需要指定该Topic要存储在哪些Broker上,也可以在发送消息时自动创建Topic。

- Producer发送消息,启动时先跟NameServer集群中的其中一台建立长连接,并从NameServer中获取当前发送的Topic存在哪些Broker上,轮询从队列列表中选择一个队列,然后与队列所在的Broker建立长连接从而向Broker发消息。

- Consumer跟Producer类似,跟其中一台NameServer建立长连接,获取当前订阅Topic存在哪些Broker上,然后直接跟Broker建立连接通道,开始消费消息。

3.3.3 搭建过程

这里简单描述一下,RocketMQ的集群搭建其实很简单,因为本人电脑配置原因,伪集群意义也不大,所以不进行过多的介绍。

- 修改配置文件,这里需要注意的是

主:

#所属集群名字

brokerClusterName=rocketmq-cluster

#broker名字,注意此处不同的配置文件填写的不一样

brokerName=broker-a

#0 表示 Master,>0 表示 Slave

brokerId=0

#nameServer地址,分号分割

#需要指定多个name-server,相当于注册到多个注册中心上去

namesrvAddr=rocketmq-nameserver1:9876;rocketmq-nameserver2:9876从:

#所属集群名字

brokerClusterName=rocketmq-cluster

#broker名字,注意此处不同的配置文件填写的不一样

brokerName=broker-b

#0 表示 Master,>0 表示 Slave

brokerId=1

#nameServer地址,分号分割

namesrvAddr=rocketmq-nameserver1:9876;rocketmq-nameserver2:9876其他配置文件也类似处理

- 在启动的时候修改docker-compose文件,注意修改配置文件所处的路径!

4. 消息发送样例

- 创建父级依赖管理

org.springframework.boot

spring-boot-starter-parent

2.1.8.RELEASE

4.0.0

study

1.0.0-SNAPSHOT

dependencies

pom

simple

RocketMQ

org.springframework.cloud

spring-cloud-dependencies

Greenwich.SR1

pom

import

com.alibaba.cloud

spring-cloud-alibaba-dependencies

2.1.0.RELEASE

pom

import

org.projectlombok

lombok

com.alibaba.cloud

spring-cloud-starter-stream-rocketmq

org.springframework.boot

spring-boot-starter-web

- 创建simple包开始测试

study

RocketMQ

1.0.0-SNAPSHOT

4.0.0

simple

org.springframework.boot

spring-boot-starter-web

provided

com.alibaba.cloud

spring-cloud-starter-stream-rocketmq

org.projectlombok

lombok

provided

- 消息发送者步骤分析r

1.创建消息生产者producer,并制定生产者组名

2.指定Nameserver地址

3.启动producer

4.创建消息对象,指定主题Topic、Tag和消息体

5.发送消息

6.关闭生产者producer- 消息消费者步骤分析

1.创建消费者Consumer,制定消费者组名

2.指定Nameserver地址

3.订阅主题Topic和Tag

4.设置回调函数,处理消息

5.启动消费者consumer4.1 基本样例

4.1.1 消息发送

1)发送同步消息

这种可靠性同步地发送方式使用的比较广泛,比如:重要的消息通知,短信通知。

/**

* @author Tiger

* @date 2019-12-23

* @see com.study.demo.sendMessage

**/

public class SyncProducer {

/**

* 发送同步消息:这种方式在发送消息之后需要等待broker返回发送的结果,因此会比较慢,但是可以保证可靠性

* @param args args

* @throws Exception e

*/

public static void main(String[] args) throws Exception {

// 实例化消息生产者Producer

DefaultMQProducer producer = new DefaultMQProducer("syncProducer");

// 设置NameServer的地址

producer.setNamesrvAddr("my.service.com:9876");

// 启动Producer实例

producer.start();

for (int i = 0; i < 100; i++) {

// 创建消息,并指定Topic,Tag和消息体

Message msg = new Message("SyncProducer" ,"TagA" ,("Hello RocketMQ " + i).getBytes(RemotingHelper.DEFAULT_CHARSET));

// 发送消息到一个Broker

SendResult sendResult = producer.send(msg);

// 通过sendResult返回消息是否成功送达

System.out.printf("%s%n", sendResult);

}

// 如果不再发送消息,关闭Producer实例。

producer.shutdown();

}

}2)发送异步消息

异步消息通常用在对响应时间敏感的业务场景,即发送端不能容忍长时间地等待Broker的响应。

/**

* @author Tiger

* @date 2019-12-23

* @see com.study.demo.sendMessage

**/

public class AsyncProducer {

public static void main(String[] args) throws Exception {

// 实例化消息生产者Producer

DefaultMQProducer producer = new DefaultMQProducer("syncProducer");

// 设置NameServer的地址

producer.setNamesrvAddr("my.service.com:9876");

// 启动Producer实例

producer.start();

// producer.setRetryTimesWhenSendAsyncFailed(0);

for (int i = 0; i < 10; i++) {

final int index = i;

// 创建消息,并指定Topic,Tag和消息体

Message msg = new Message("AsyncProducer", "TagA", "OrderID188", "Hello world".getBytes(RemotingHelper.DEFAULT_CHARSET));

// SendCallback接收异步返回结果的回调

producer.send(msg, new SendCallback() {

@Override

public void onSuccess(SendResult sendResult) {

System.out.printf("%-10d OK %s %n", index,

sendResult.getMsgId());

}

@Override

public void onException(Throwable e) {

System.out.printf("%-10d Exception %s %n", index, e);

e.printStackTrace();

}

});

}

// 这里需要注意,由于使用了异步,这么有可能会导致连接已经shutdown了才返回异步结果,这样会报错,因此只能手动关闭

// producer.shutdown();

}

}3)单向发送消息

这种方式主要用在不特别关心发送结果的场景,例如日志发送。

/**

* @author Tiger

* @date 2019-12-23

* @see com.study.demo.sendMessage

**/

public class OnewayProducer {

public static void main(String[] args) throws Exception {

// 实例化消息生产者Producer

DefaultMQProducer producer = new DefaultMQProducer("onewayProducer");

// 设置NameServer的地址

producer.setNamesrvAddr("my.service.com:9876");

// 启动Producer实例

producer.start();

for (int i = 0; i < 100; i++) {

// 创建消息,并指定Topic,Tag和消息体

Message msg = new Message("OnewayProducer",

"TagA",

("Hello RocketMQ " + i).getBytes(RemotingHelper.DEFAULT_CHARSET)

);

// 发送单向消息,没有任何返回结果

producer.sendOneway(msg);

}

// 如果不再发送消息,关闭Producer实例。

producer.shutdown();

}

}4.1.2 消费消息

1)负载均衡模式

消费者采用负载均衡方式消费消息,多个消费者共同消费队列消息,每个消费者处理的消息不同

/**

* @author Tiger

* @date 2019-12-23

* @see com.study.demo.getMessage

**/

public class Balance {

public static void main(String[] args) throws Exception {

// 实例化消息生产者,指定组名

DefaultMQPushConsumer consumer = new DefaultMQPushConsumer("syncProducer");

// 指定Namesrv地址信息.

consumer.setNamesrvAddr("my.service.com:9876");

// 订阅Topic

consumer.subscribe("AsyncProducer", "*");

//负载均衡模式消费

consumer.setMessageModel(MessageModel.CLUSTERING);

// 注册回调函数,处理消息

consumer.registerMessageListener(new MessageListenerConcurrently() {

@Override

public ConsumeConcurrentlyStatus consumeMessage(List msgs,

ConsumeConcurrentlyContext context) {

System.out.printf("%s Receive New Messages: %s %n",

Thread.currentThread().getName(), msgs);

return ConsumeConcurrentlyStatus.CONSUME_SUCCESS;

}

});

//启动消息者

consumer.start();

System.out.printf("Consumer Started.%n");

}

} 2)广播模式

消费者采用广播的方式消费消息,每个消费者消费的消息都是相同的

/**

* @author Tiger

* @date 2019-12-23

* @see com.study.demo.getMessage

**/

public class Broadcasting {

public static void main(String[] args) throws Exception {

// 实例化消息生产者,指定组名

DefaultMQPushConsumer consumer = new DefaultMQPushConsumer("syncProducer");

// 指定Namesrv地址信息.

consumer.setNamesrvAddr("my.service.com:9876");

// 订阅Topic

consumer.subscribe("AsyncProducer", "*");

//广播模式消费

consumer.setMessageModel(MessageModel.BROADCASTING);

// 注册回调函数,处理消息

consumer.registerMessageListener(new MessageListenerConcurrently() {

@Override

public ConsumeConcurrentlyStatus consumeMessage(List msgs,

ConsumeConcurrentlyContext context) {

System.out.printf("%s Receive New Messages: %s %n",

Thread.currentThread().getName(), msgs);

return ConsumeConcurrentlyStatus.CONSUME_SUCCESS;

}

});

//启动消息者

consumer.start();

System.out.printf("Consumer Started.%n");

}

} 4.2 顺序消息

消息有序指的是可以按照消息的发送顺序来消费(FIFO)。RocketMQ可以严格的保证消息有序,可以分为分区有序或者全局有序。

顺序消费的原理解析,在默认的情况下消息发送会采取Round Robin轮询方式把消息发送到不同的queue(分区队列);而消费消息的时候从多个queue上拉取消息,这种情况发送和消费是不能保证顺序。但是如果控制发送的顺序消息只依次发送到同一个queue中,消费的时候只从这个queue上依次拉取,则就保证了顺序。当发送和消费参与的queue只有一个,则是全局有序;如果多个queue参与,则为分区有序,即相对每个queue,消息都是有序的。

下面用订单进行分区有序的示例。一个订单的顺序流程是:创建、付款、推送、完成。订单号相同的消息会被先后发送到同一个队列中,消费时,同一个OrderId获取到的肯定是同一个队列。

4.2.1 顺序消息生产

/**

* Producer,发送顺序消息

*/

public class OrderProducer {

public static void main(String[] args) throws Exception {

DefaultMQProducer producer = new DefaultMQProducer("orderProducer");

producer.setNamesrvAddr("my.service.com:9876");

producer.start();

String[] tags = new String[]{"TagA", "TagC", "TagD"};

// 订单列表

List orderList = new OrderProducer().buildOrders();

Date date = new Date();

SimpleDateFormat sdf = new SimpleDateFormat("yyyy-MM-dd HH:mm:ss");

String dateStr = sdf.format(date);

for (int i = 0; i < 10; i++) {

// 加个时间前缀

String body = dateStr + " Hello RocketMQ " + orderList.get(i);

Message msg = new Message("TopicTest", tags[i % tags.length], "KEY" + i, body.getBytes());

SendResult sendResult = producer.send(msg, (mqs, msg1, arg) -> {

Long id = (Long) arg; //根据订单id选择发送queue

long index = id % mqs.size();

return mqs.get((int) index);

}, orderList.get(i).getOrderId());//订单id

// SendResult sendResult = producer.send(msg, new MessageQueueSelector() {

// @Override

// public MessageQueue select(List mqs, Message msg, Object arg) {

// Long id = (Long) arg; //根据订单id选择发送queue

// long index = id % mqs.size();

// return mqs.get((int) index);

// }

// }, orderList.get(i).getOrderId());//订单id

System.out.println(String.format("SendResult status:%s, queueId:%d, body:%s",

sendResult.getSendStatus(),

sendResult.getMessageQueue().getQueueId(),

body));

}

producer.shutdown();

}

/**

* 生成模拟订单数据

*/

private List buildOrders() {

List orderList = new ArrayList();

OrderStep orderDemo = new OrderStep();

orderDemo.setOrderId(15103111039L);

orderDemo.setDesc("创建");

orderList.add(orderDemo);

orderDemo = new OrderStep();

orderDemo.setOrderId(15103111065L);

orderDemo.setDesc("创建");

orderList.add(orderDemo);

orderDemo = new OrderStep();

orderDemo.setOrderId(15103111039L);

orderDemo.setDesc("付款");

orderList.add(orderDemo);

orderDemo = new OrderStep();

orderDemo.setOrderId(15103117235L);

orderDemo.setDesc("创建");

orderList.add(orderDemo);

orderDemo = new OrderStep();

orderDemo.setOrderId(15103111065L);

orderDemo.setDesc("付款");

orderList.add(orderDemo);

orderDemo = new OrderStep();

orderDemo.setOrderId(15103117235L);

orderDemo.setDesc("付款");

orderList.add(orderDemo);

orderDemo = new OrderStep();

orderDemo.setOrderId(15103111065L);

orderDemo.setDesc("完成");

orderList.add(orderDemo);

orderDemo = new OrderStep();

orderDemo.setOrderId(15103111039L);

orderDemo.setDesc("推送");

orderList.add(orderDemo);

orderDemo = new OrderStep();

orderDemo.setOrderId(15103117235L);

orderDemo.setDesc("完成");

orderList.add(orderDemo);

orderDemo = new OrderStep();

orderDemo.setOrderId(15103111039L);

orderDemo.setDesc("完成");

orderList.add(orderDemo);

return orderList;

}

}

@Data

public class OrderStep {

private long orderId;

private String desc;

@Override

public String toString() {

return "OrderStep{" +

"orderId=" + orderId +

", desc='" + desc + '\'' +

'}';

}

} 4.2.2 顺序消费消息

/**

* 顺序消息消费,带事务方式(应用可控制Offset什么时候提交)

*/

public class ConsumerInOrder {

public static void main(String[] args) throws Exception {

DefaultMQPushConsumer consumer = new

DefaultMQPushConsumer("please_rename_unique_group_name_3");

consumer.setNamesrvAddr("127.0.0.1:9876");

/**

* 设置Consumer第一次启动是从队列头部开始消费还是队列尾部开始消费

* 如果非第一次启动,那么按照上次消费的位置继续消费

*/

consumer.setConsumeFromWhere(ConsumeFromWhere.CONSUME_FROM_FIRST_OFFSET);

consumer.subscribe("TopicTest", "TagA || TagC || TagD");

consumer.registerMessageListener(new MessageListenerOrderly() {

Random random = new Random();

@Override

public ConsumeOrderlyStatus consumeMessage(List msgs, ConsumeOrderlyContext context) {

context.setAutoCommit(true);

for (MessageExt msg : msgs) {

// 可以看到每个queue有唯一的consume线程来消费, 订单对每个queue(分区)有序

System.out.println("consumeThread=" + Thread.currentThread().getName() + "queueId=" + msg.getQueueId() + ", content:" + new String(msg.getBody()));

}

try {

//模拟业务逻辑处理中...

TimeUnit.SECONDS.sleep(random.nextInt(10));

} catch (Exception e) {

e.printStackTrace();

}

return ConsumeOrderlyStatus.SUCCESS;

}

});

consumer.start();

System.out.println("Consumer Started.");

}

} 4.3 延时消息

比如电商里,提交了一个订单就可以发送一个延时消息,1h后去检查这个订单的状态,如果还是未付款就取消订单释放库存。

4.3.1 启动消息消费者

public class ScheduledMessageConsumer {

public static void main(String[] args) throws Exception {

// 实例化消费者

DefaultMQPushConsumer consumer = new DefaultMQPushConsumer("ExampleConsumer");

// 订阅Topics

consumer.subscribe("TestTopic", "*");

// 注册消息监听者

consumer.registerMessageListener(new MessageListenerConcurrently() {

@Override

public ConsumeConcurrentlyStatus consumeMessage(List messages, ConsumeConcurrentlyContext context) {

for (MessageExt message : messages) {

// Print approximate delay time period

System.out.println("Receive message[msgId=" + message.getMsgId() + "] " + (System.currentTimeMillis() - message.getStoreTimestamp()) + "ms later");

}

return ConsumeConcurrentlyStatus.CONSUME_SUCCESS;

}

});

// 启动消费者

consumer.start();

}

} 4.3.2 发送延时消息

/**

* @author Tiger

* @date 2019-12-24

* @see com.study.demo.sendMessage

**/

public class ScheduledMessageProducer {

/**

* 发送延时消息

* @param args a

* @throws Exception e

*/

public static void main(String[] args) throws Exception {

// 实例化一个生产者来产生延时消息

DefaultMQProducer producer = new DefaultMQProducer("ExampleProducerGroup");

producer.setNamesrvAddr("my.service.com:9876");

// 启动生产者

producer.start();

int totalMessagesToSend = 100;

for (int i = 0; i < totalMessagesToSend; i++) {

Message message = new Message("TestTopic", ("Hello scheduled message " + i).getBytes());

// 设置延时等级2,这个消息将在5s之后发送(现在只支持固定的几个时间,详看delayTimeLevel)

message.setDelayTimeLevel(2);

// 发送消息

producer.send(message);

}

// 关闭生产者

producer.shutdown();

}

}4.3.3 验证

您将会看到消息的消费比存储时间晚10秒

4.3.4 使用限制

// org/apache/rocketmq/store/config/MessageStoreConfig.java

private String messageDelayLevel = "1s 5s 10s 30s 1m 2m 3m 4m 5m 6m 7m 8m 9m 10m 20m 30m 1h 2h";现在RocketMq并不支持任意时间的延时,需要设置几个固定的延时等级,从1s到2h分别对应着等级1到18

4.4 批量消息

批量发送消息能显著提高传递小消息的性能。限制是这些批量消息应该有相同的topic,相同的waitStoreMsgOK,而且不能是延时消息。此外,这一批消息的总大小不应超过4MB。

4.4.1 发送批量消息

如果您每次只发送不超过4MB的消息,则很容易使用批处理,样例如下:

String topic = "BatchTest";

List messages = new ArrayList<>();

messages.add(new Message(topic, "TagA", "OrderID001", "Hello world 0".getBytes()));

messages.add(new Message(topic, "TagA", "OrderID002", "Hello world 1".getBytes()));

messages.add(new Message(topic, "TagA", "OrderID003", "Hello world 2".getBytes()));

try {

producer.send(messages);

} catch (Exception e) {

e.printStackTrace();

//处理error

} 如果消息的总长度可能大于4MB时,这时候最好把消息进行分割

public class ListSplitter implements Iterator> {

private final int SIZE_LIMIT = 1024 * 1024 * 4;

private final List messages;

private int currIndex;

public ListSplitter(List messages) {

this.messages = messages;

}

@Override

public boolean hasNext() {

return currIndex < messages.size();

}

@Override

public List next() {

int nextIndex = currIndex;

int totalSize = 0;

for (; nextIndex < messages.size(); nextIndex++) {

Message message = messages.get(nextIndex);

int tmpSize = message.getTopic().length() + message.getBody().length;

Map properties = message.getProperties();

for (Map.Entry entry : properties.entrySet()) {

tmpSize += entry.getKey().length() + entry.getValue().length();

}

tmpSize = tmpSize + 20; // 增加日志的开销20字节

if (tmpSize > SIZE_LIMIT) {

//单个消息超过了最大的限制

//忽略,否则会阻塞分裂的进程

if (nextIndex - currIndex == 0) {

//假如下一个子列表没有元素,则添加这个子列表然后退出循环,否则只是退出循环

nextIndex++;

}

break;

}

if (tmpSize + totalSize > SIZE_LIMIT) {

break;

} else {

totalSize += tmpSize;

}

}

List subList = messages.subList(currIndex, nextIndex);

currIndex = nextIndex;

return subList;

}

}

//把大的消息分裂成若干个小的消息

ListSplitter splitter = new ListSplitter(messages);

while (splitter.hasNext()) {

try {

List listItem = splitter.next();

producer.send(listItem);

} catch (Exception e) {

e.printStackTrace();

//处理error

}

} 4.5 过滤消息

在大多数情况下,TAG是一个简单而有用的设计,其可以来选择您想要的消息。例如:

DefaultMQPushConsumer consumer = new DefaultMQPushConsumer("CID_EXAMPLE");

consumer.subscribe("TOPIC", "TAGA || TAGB || TAGC");消费者将接收包含TAGA或TAGB或TAGC的消息。但是限制是一个消息只能有一个标签,这对于复杂的场景可能不起作用。在这种情况下,可以使用SQL表达式筛选消息。SQL特性可以通过发送消息时的属性来进行计算。在RocketMQ定义的语法下,可以实现一些简单的逻辑。下面是一个例子:

------------

| message |

|----------| a > 5 AND b = 'abc'

| a = 10 | --------------------> Gotten

| b = 'abc'|

| c = true |

------------

------------

| message |

|----------| a > 5 AND b = 'abc'

| a = 1 | --------------------> Missed

| b = 'abc'|

| c = true |

------------4.5.1 SQL基本语法

RocketMQ只定义了一些基本语法来支持这个特性。你也可以很容易地扩展它。

- 数值比较,比如:>,>=,<,<=,BETWEEN,=;

- 字符比较,比如:=,<>,IN;

- IS NULL 或者 IS NOT NULL;

- 逻辑符号 AND,OR,NOT;

常量支持类型为:

- 数值,比如:123,3.1415;

- 字符,比如:'abc',必须用单引号包裹起来;

- NULL,特殊的常量

- 布尔值,TRUE 或 FALSE

只有使用push模式的消费者才能用使用SQL92标准的sql语句,接口如下:

public void subscribe(finalString topic, final MessageSelector messageSelector)4.5.2 消息生产者

发送消息时,你能通过putUserProperty来设置消息的属性

DefaultMQProducer producer = new DefaultMQProducer("please_rename_unique_group_name");

producer.start();

Message msg = new Message("TopicTest",

tag,

("Hello RocketMQ " + i).getBytes(RemotingHelper.DEFAULT_CHARSET)

);

// 设置一些属性

msg.putUserProperty("a", String.valueOf(i));

SendResult sendResult = producer.send(msg);

producer.shutdown();4.5.3 消息消费者

用MessageSelector.bySql来使用sql筛选消息

DefaultMQPushConsumer consumer = new DefaultMQPushConsumer("please_rename_unique_group_name_4");

// 只有订阅的消息有这个属性a, a >=0 and a <= 3

consumer.subscribe("TopicTest", MessageSelector.bySql("a between 0 and 3");

consumer.registerMessageListener(new MessageListenerConcurrently() {

@Override

public ConsumeConcurrentlyStatus consumeMessage(List msgs, ConsumeConcurrentlyContext context) {

return ConsumeConcurrentlyStatus.CONSUME_SUCCESS;

}

});

consumer.start(); 5. spring-cloud-starter-stream-rocketmq的使用

5.1 基本样例

- 创建SpringCloud统一依赖管理

org.springframework.cloud

spring-cloud-dependencies

Greenwich.SR1

pom

import

com.alibaba.cloud

spring-cloud-alibaba-dependencies

2.1.0.RELEASE

pom

import

- 子模块中加入rocketmq依赖

com.alibaba.cloud

spring-cloud-starter-stream-rocketmq

- org.springframework.cloud.stream.config.BindingProperties查看可配置的属性

@JsonInclude(Include.NON_DEFAULT)

@Validated

public class BindingProperties {

public static final MimeType DEFAULT_CONTENT_TYPE;

private static final String COMMA = ",";

private String destination;

private String group;

private String contentType;

private String binder;

private ConsumerProperties consumer;

private ProducerProperties producer;

...

}5.2 配置生产者

- 编写生产者配置文件

server:

port: 9094

spring:

application:

name: rocketmq-provider

cloud:

stream:

bindings:

output1:

content-type: text/plain

destination: TransactionTopic

rocketmq:

binder:

name-server: my.service.com:9876

#自定义的名称 对应spring.cloud.stream.bindings.output1

bindings:

output1:

producer:

group: demo-group

transactional: true

datasource:

password: 123456

url: jdbc:mysql://my.service.com:3306/test?useUnicode=true&characterEncoding=UTF-8&useSSL=false&allowPublicKeyRetrieval=true&serverTimezone=GMT%2B8

username: root- 指定当前MQ使用的配置

public interface MySource {

@Output("output1")

MessageChannel output1();

}- 在

Application中进行绑定

@SpringBootApplication

@EnableBinding(MySource.class)

public class ServerApplication {

public static void main(String[] args) {

SpringApplication.run(ServerApplication.class, args);

}

}- 进入使用

@Resource

MySource source;

public void send(String message) {

//tags过滤方法

source.output1().send(MessageBuilder.withPayload(message).setHeader(RocketMQHeaders.TAGS,"test").build());

Random r = new Random();

//sql过滤方法

source.output1().send(MessageBuilder.withPayload(message).setHeader("index",r.nextInt(1000)+500).build());

//默认方法

source.output1().send(MessageBuilder.withPayload(message).build());

}- 如何使用事务方法

上面内容不需要进行变更,只需要加入以下监听类

@RocketMQTransactionListener(txProducerGroup = "demo-group")

public class ProducerListener implements RocketMQLocalTransactionListener {

@Autowired

JdbcTemplate jdbcTemplate;

@Override

@Transactional

public RocketMQLocalTransactionState executeLocalTransaction(Message message, Object arg) {

//消息发送成功回调此方法,此方法执行本地事务

try {

//解析消息内容

String jsonString = new String((byte[]) message.getPayload());

JSONObject jsonObject = JSONObject.parseObject(jsonString);

...

return RocketMQLocalTransactionState.COMMIT;

} catch (Exception e) {

e.printStackTrace();

return RocketMQLocalTransactionState.ROLLBACK;

}

}

//此方法检查事务执行状态

@Override

public RocketMQLocalTransactionState checkLocalTransaction(Message message) {

RocketMQLocalTransactionState state;

final JSONObject jsonObject = JSON.parseObject(new String((byte[]) message.getPayload()));

...

System.out.println("check");

System.out.println(jsonObject);

//自行定义规则,如要需要完整demo可以参考我github代码

if (...) {

//提交事务

state = RocketMQLocalTransactionState.COMMIT;

} else {

//稍后重试

state = RocketMQLocalTransactionState.UNKNOWN;

}

return state;

}

}5.3 配置消费者

- 编写消费者配置文件

server:

port: 9093

spring:

application:

name: rocketmq-consumer

cloud:

stream:

bindings:

input:

consumer:

# 消费者线程数设置

concurrency: 20

content-type: application/json

destination: TransactionTopic

group: demo-group

rocketmq:

binder:

name-server: my.service.com:9876

bindings:

input:

consumer:

broadcasting: false

sql: 'index >= 600'

tags: tag0||tag1

datasource:

password: 123456

url: jdbc:mysql://my.service.com:3306/test?useUnicode=true&characterEncoding=UTF-8&useSSL=false&allowPublicKeyRetrieval=true&serverTimezone=GMT%2B8

username: root- 这里没有使用自定义名称,只需要在

Application中绑定默认规则即可

@SpringBootApplication

@EnableBinding({Sink.class})

public class ConsumerApplication {

public static void main(String[] args) {

SpringApplication.run(ConsumerApplication.class, args);

}

}- 注册消息消费者监听器

@StreamListener(Sink.INPUT)

@StreamListener(Sink.INPUT)

//默认有ack机制,不抛出异常就是确认消费成功

public void receive(String receiveMsg) {

try {

JSONObject jsonObject = JSONObject.parseObject(receiveMsg);

...

} catch (Exception e) {

throw new RuntimeException();

}

}