在工作中,几乎每个岗位都会涉及到数据收集的任务。收集本地所有装修公司的名单,收集某个APP的所有评论,收集网上所有与**相关的文章,批量下载某网站的指定文件……

不会编程,不懂爬虫技术的我,曾经遇到这种工作,要么苦逼的CTRL+C,CTRL+V,要么赔着笑求技术人员帮忙爬取数据。直到我遇到web scraper这个神器,无需编程经验,简单几步设置后,几分钟就能快速收集上千条数据,效率高到飞起。

web scraper是一个谷歌爬虫插件,使用起来非常简单,30分钟即可完全掌握。web scraper插件会将数据爬取出来生成excel表格,供我们使用。

那么这款插件到底要怎么用呢?

爬取数据的基本流程

step1:下载和安装web scraper插件。

下载地址:链接: http://pan.baidu.com/s/1qXVbqUg 密码: t7bm

安装方法:参考百度经验文章http://jingyan.baidu.com/article/da1091fbdf12e9027949d673.html

step2:创建一个新的数据爬取站点。

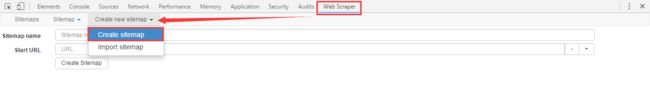

首先按F12(或者点击鼠标右键--检查)调出控制台,点击“Web Scraper”切换到爬虫插件功能,点击create new sitemap进入新的数据爬取站点创建页面。

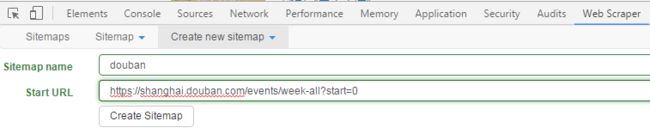

sitemap name可以自定义,但一定要是英文。start url是我们要爬取的网站网址,这里我们爬取豆瓣网上上海近一周的同城活动,将如下链接复制到start url输入框中,然后点击“create sitemap”确定创建。https://shanghai.douban.com/events/week-all?start=0

step3:选择需要提取的页面元素

上一步创建成功之后,页面会跳转到如下界面,这时我们点击“add new selector”创建一个新的选择器。

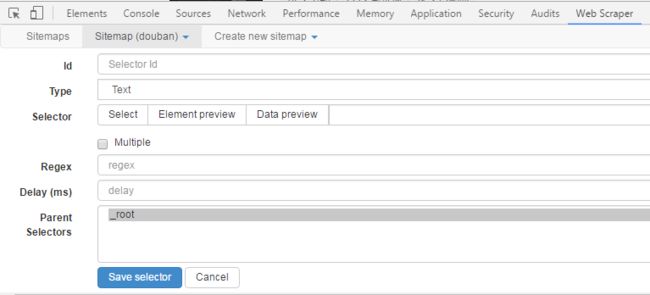

以提取该页面活动标题为例,设置ID为“title”(此处可以自定义,将会成为excel中的表头),type为“text”。

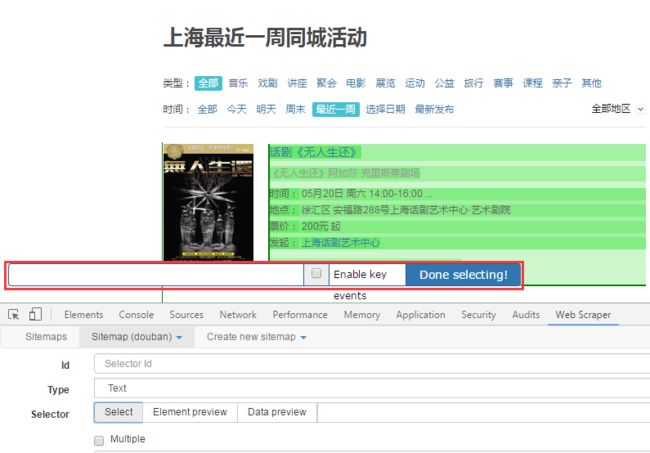

selector指的是页面中需要提取的数据区域。点击select,鼠标在网页上滑动,会出现绿色区域,表示这些区域的数据我们是可以选择的。

选中一个活动标题,这个区域会被红色边框包围,再继续选中下一个活动标题。当选中两个相同区域时,插件会自动选中该页面上其他的同类元素。点击“Done selecting!”确定选中。

我们可以点击“Element preview”查看页面上被选中的所有区域,点击“Data preview”预览爬虫将获取到的数据。

注意:由于我们要选择这个页面上的所有活动标题,因此需要将”Multiple“复选框选中。剩下的内容可以保持默认,点击”Save selector“保存这个选择器。

到这里,我们就选择好了需要提取的页面元素,如下图所示。

step4:开始爬取数据

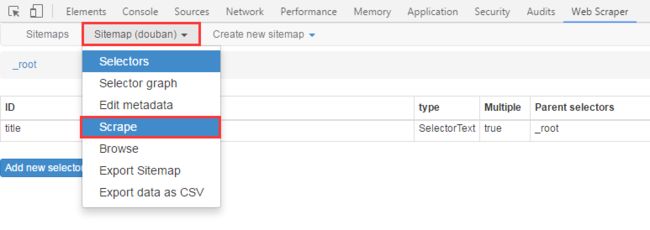

点击scrape,进入数据爬取启动页面。

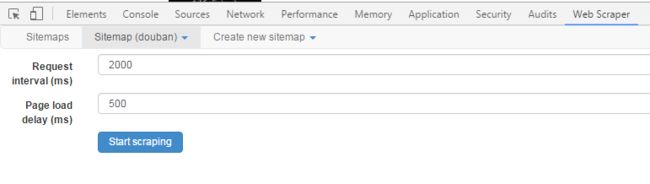

设置request interval 和page load delay时间,点击”Start scraping“开始爬取数据。这里的时间间隔主要是为了避免因操作太频繁导致爬虫被屏蔽,无法正常爬取。一般的网站默认时间间隔就可以,有些网站可能需要设置大一点的时间间隔。

开始后,会打开一个目标网址的窗口,爬虫根据提取设置好的规则一一爬取,当爬取完毕后,窗口会自动关闭。

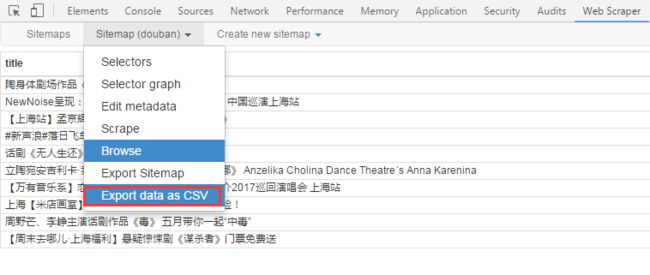

step5:下载数据

点击”Export data as CSV“跳转到excel数据下载页面,点击”download now"即可下载。

以上五步就是使用web scraper爬取数据的全部流程和操作。无论是多复杂的数据,都可以按照这样的流程和操作爬取到对应的数据。

进阶操作

1,如何一次性爬取一组数据?

刚刚我们仅仅爬取了活动主题,如果我们要同时爬取活动主题和活动时间,应该怎么处理呢?

从上图中可以看到数据的结构,活动主题和活动时间同时被包含在最外层的方框中,因此在设置选择器的时候,先创建一个大的选择器,让活动主题和活动内容同时被包含起来。

注意这里的Type要设置成“Element”.保存后点击刚才创建的内容(下图红框的位置)进入子页。

然后在这个页面分别创建标题选择器和时间选择器。其类型都是text。现在页面的可选区域被局限在了list这个区域,因此你只需要点击一次活动标题,确定选中即可。不用勾选“Multiple”。

只有创建一个element选择器将活动主题和活动时间包含起来,爬取到的数据才会一一对应的呈现出来。

2,如何一次性爬取多页内容?

这里根据分页形式的不同,有不同的解决办法。

1)固定分页情况下

可以注意到豆瓣同城活动的页面时做了分页的,每页显示10条数据。那么如果我们要爬取前10页的数据,应该怎么做呢?

仔细观察,会发现第一页的网址和第二页的网址是有区别的。

第一页:https://shanghai.douban.com/events/week-all?start=0

第二页:https://shanghai.douban.com/events/week-all?start=10

start=后面的数字是差为10的等差数列。

那么我们在设置数据爬取站点的时候,用[0-100:10]替代具体的数字,表示数据爬取的页面区间。即:https://shanghai.douban.com/events/week-all?start=[0-100:10]

如果网址的等差是1,例如知乎问题的网址:

第一页:https://www.zhihu.com/topic/19551325/top-answers?page=1

第二页:https://www.zhihu.com/topic/19551325/top-answers?page=2

则省略冒号和后面的等差,只写页码区间。如https://www.zhihu.com/topic/19551325/top-answers?page=[1-10]

表示知乎话题第一页到第十页。

处理这种数据的要点就是观察不同页面网址的变化,然后将页码区间写入网址中。

2)滚动鼠标自动加载

目前很多网站采取了滚动到底部后自动加载数据的方式,其网址并没有任何变化。如知乎live主页的数据加载方式。https://www.zhihu.com/lives/

这时我们需要在创建element选择器的时候,设置Type为“Element scroll down”。这样爬虫工作的时候会自动执行滚动操作,不停的爬取,直到没有可加载的数据为止。

3)点击页面底部“加载更多”按钮

在设置外层element元素的时候,设置Type类型为“Element click”,然后点击“Click selector”的“Select”按钮选中页面上的加载更多按钮或者图标。

为了让页面持续不断的加载,设置“Click type”为“Click more”,多次点击。

接下来设置停止点击的条件,当这个区域的文本内容或者HTML结构或者显示样式发生改变时,不再点击。

比如说当加载完毕之后,“加载更多”按钮文字改变为“已加载完毕”,那么这里选择Unique Text;如果加载到最后,这个按钮颜色变灰,就选择Unique CSS Selector。

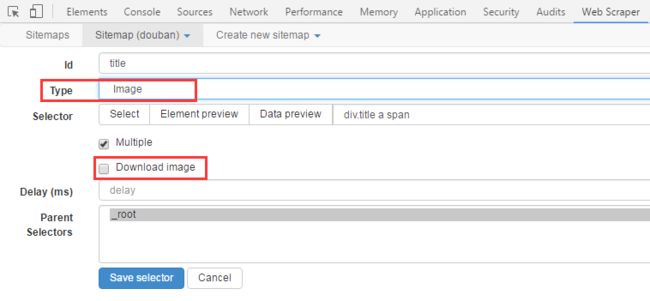

3,如何批量爬取并下载图片?

设置Type为image,插件将爬取到所有图片的链接。下载图片有两种方式,一种是直接勾选Download image,这样爬虫在爬取的时候就会自动下载。或者在爬取到所有图片链接后,使用批量下载工具直接下载。

4,如何爬取网页链接?

设置Type为Link,爬虫将爬取到该元素上的超链接。

如图所示:当Type为text时,爬取到的数据是立陶宛安吉利卡·乔丽娜舞团 舞剧《安娜·卡列尼娜》 Anzelika Cholina Dance Theatre´s Anna Karenina

当Type为Link时,爬取到的数据是:https://www.douban.com/event/28303813/,也就是点击下图红框中内容跳转的页面链接。

当你需要爬取的链接是一个下载文件的链接,比如说类似下图中“公告下载”按钮的链接。你可以设置Type为Popup Link,这样在爬取数据的过程中就会自动下载文件了。

5,如何爬取二级页面或三级页面的内容?

首先在根目录下创建一个选择器,这个选择器选择的内容是可以点进二级页面的区域,如果该区域有超链接,则设置Type为Link,否则设置为Element click;然后在这个选择器里面创建选择器,选择需要爬取的区域即可。这个可以一级一级的嵌套下去。

怎么判断一个区域是否有超链接?鼠标放在该区域,右键单击,如果有“在……中打开链接”的选项,则这个区域有超链接,设置Type为Link。

通过以上的设置,我们可以利用谷歌插件爬取80%的网站数据,获取到本地excel文件,进而对数据进行处理和分析。

以上的技能除了可以用于工作,还可以应用到生活中查询资讯的时候。

很多时候网站的设计存在一定问题,为我们获取资讯带来一定困难。

比如知乎live的网页,点进去一个live详情再退回来的时候,页面会回到顶部,需要你重新滚动加载;https://www.zhihu.com/lives/

比如互动吧的活动列表页,没有对活动状态的分类,正在进行中的活动一般是参与不了的,但是筛选不出去。http://www.hdb.com/shanghai/0-0-2-0-1/

这时候如果你用web scraper工具的话,就可以将数据爬取到本地,然后按照自己的需求进行快速筛选了。

熟练掌握这个插件后,真的能提高工作效率,减少麻烦吗?

提高工作效率是一定的,但减少麻烦就不见得了。毕竟我因为下班太早,被老板说了~呜呜呜