这篇笔记,主要记录花书第二章关于线性代数知识的回顾。希望把常用的概念和公式都记录下来,同时标记编号(为了方便,标记序号与书中一致),在后续公式推导过程中可以直接关联使用。

一些概念

标量(scalar):标量就是一个单独的数。

向量(vector):向量是一列数组。

矩阵(matrix):矩阵是一个二维的数组。

张量(tensor):张量是一个超过两维的数组。

向量和矩阵的一些性质

矩阵的转置(transpose):矩阵的转置就是将矩阵验证左上角至右下角的对角线为轴的一个镜像。表示成:

.矩阵的乘法(matrix product):两个矩阵相乘,表示成:C=AB.

.元素对应乘积(element-wise product):两个矩阵中对应元素乘积,表示成:

点积(dot product): 两个相同维度的x和y的点积可以看成矩阵的乘积,表示成

一些性质:在运算、简化函数的时候非常有用,在本章最后一节PCA算法中可以看到。

单位矩阵和逆矩阵

单位矩阵(identity matrix):主对角线都是1,其余都是0的矩阵。

逆矩阵( matrix inversion ):满足如下条件的矩阵称为逆矩阵。

线性相关和生成子空间

线性相关(linear dependence):在向量空间中,存在有限个其他向量的线性组合所表示,我们把这种冗余成为线性相关,反之为线性无关(linear independent)。线性组合(linear combination)可以表示为如下公式:

生成子空间(span):在向量空间中,其中一组最大的线性无关的组,成为生成子空间。

范数

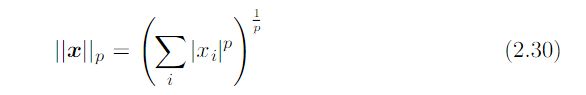

范数(norms):通常我们使用范数来定义某个向量的大小,通常如下公式表示。当p取值为1的时候称为一范,取值为2的时候称为二范。

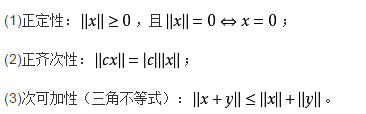

范数的基本性质:正定性、齐次性、三角不等式。

特殊的矩阵和向量

对角矩阵(Diagonal matrices):是一个主对角线之外的元素皆为0的矩阵。

对称矩阵(symmetric matrix):对称矩阵是指一个矩阵等于他自身转置的矩阵。

正交矩阵(orthogonal matrix):满足如下公式的n介矩阵,称为正交矩阵。

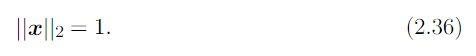

单位向量(unit vector):单位向量的大小是1,即满足如下条件的向量称为单位向量。

特征分解

特征向量(eigenvector):方阵A的特征向量是指与A相乘后相当于对该向量进行缩放的非零向量v。λ则被称为这个矩阵A的特征值(eigenvalue)

特征分解(eigendecomposition):是将矩阵分解为由其特征值和特征向量表示的矩阵之积的方法。需要注意只有可对角化矩阵才可以施以特征分解。A的特征分解表示成如下形式。

奇异值分解

奇异值分解(singular value decomposition):与特征分解类似,奇异值分解也是分解矩阵的一种方法,只是这次我们将向量A分解成三个矩阵的乘积的形式。如下公式表示:

其中,对角矩阵D(不一定是方阵)称为矩阵A的奇异值(singular values),矩阵U的列向量称为左奇异向量(left-singularvectors),矩阵V的列向量称为右奇异向量(right-singularvectors)

伪逆

伪逆(Moore-Penrose pseudoinverse):对于非方阵矩阵,没有逆矩阵的定义。伪逆的定义帮助我们取得了一定的进展。矩阵A的伪逆定义为如下公式:

但是在实际计算伪逆的时候,没有用到这个定义去计算,而是使用如下公式。其中V,D,U是对矩阵A进行奇异值分解后的矩阵。矩阵D的伪逆,是对其非零元素取到数之后转置得到的。

矩阵的迹操作

矩阵的迹(Trace):矩阵主对角线上所有元素的和称为矩阵的迹。表示为:

迹的一些性质:

行列式

行列式(determinant):一个方阵的行列式,是将方阵映射到实数的一个函数。记做det(A).行列式等于矩阵特征值的乘积.

PCA算法举例

问题:假设在n维空间中存在m个点x(1)~x(m),我们希望对这些点进行有损压缩。但是损失的精度尽可能的少。

分析:假设我们能找到一个l维度空间(l 推导过程如下,字写得丑,将就看吧……………… 根据最后一步,这个优化问题可以通过特征分解来求解,具体来讲,就是最优的d向量,就是 的最大特征值对应的特征向量。 如果有兴趣相投的朋友,欢迎来http://www.jokls.com/提问或者解答其他小伙伴的提问。![]()

Q&A: