人工智能新闻/资料/文章收录【2018年及之前】

目录

- 深度学习(科普)

- 专家观点

- 前沿技术

- AI硬件技术

- 课程资料

- 知乎

- 会议资料合集

- Benchmark & Dataset

- 研究Lab

- Tools, Docker, Framework

- 企业新闻

本文仅用于个人网络资料收录:)

深度学习(科普)

- 2014-11-17:解密最接近人脑的智能学习机器 ——深度学习及并行化实现(腾讯大数据)

- 2015.12.22:科研 | 人类为什么能从极少量的数据中做出判断?秘密可能是随机映射算法

- 2018-2-16:深度 | Pedro Domingos总结机器学习研究的12个宝贵经验

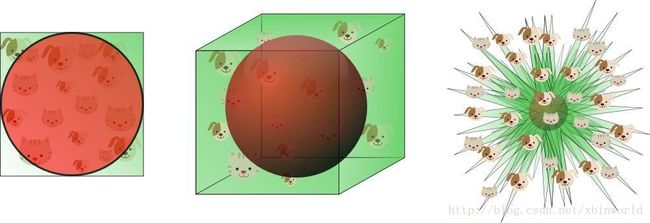

高维的一般问题是,来自三维世界的人类直觉通常不适用于高维空间。在高维度当中,多元高斯分布的大部分数据并不接近平均值,而是在其周围越来越远的「壳」中;此外,高维分布的大部分体积分布在表面,而不是体内。如果恒定数量的样本在高维超立方体中均匀分布,那么在超越某个维数的情况下,大多数样本将更接近于超立方体的一个面,而不是它们的最近邻。此外,如果我们通过嵌入超立方体的方式逼近一个超球面,那么在高维度下,超立方体几乎所有的体积都在超球面之外。这对于机器学习来说是个坏消息,因为一种类型的形状常常可以被另一种形状所逼近,但在高维空间中却失效了

- 2016-5-5:详细解读神经网络十大误解,再也不会弄错它的工作原理

神经网络不是人类大脑的模型, 神经网络并不是统计学的「弱形式」, 神经网络流行许多不同的架构, 规模很重要,但并不是越大越好, 神经网络的训练算法有很多种, 经网络并不总是需要大量数据, 神经网络不能基于任何数据训练, 神经网络需要被再训练, 神经网络不是黑箱, 神经网络不难实现

专家观点

-

2017-11-19:深度|Berkeley14位重量级学者:人工智能系统的四大趋势与九大挑战

-

2018-5-7:Ian Goodfellow:我最大的失败是用无监督解决计算机视觉的监督学习问题

-

2018-2-19:Science组织了一场尖锐的Reddit问答,Yann LeCun的回答还是那么耿直。

Yann LeCun,Facebook 人工智能研究中心首席科学家

Eric Horvitz,微软研究院负责人

Peter Norvig,谷歌研究总监

话题包括量子计算、隐私、前沿研究方向、伪人工智能等

Yann LeCun:我认为,让机器通过观察来学习预测模型是通用人工智能(AGI)的最大障碍。人类婴儿和很多动物似乎都可以通过观察世界并与其交互获得一种常识(虽然相比我们的强化学习系统,他们只需要很少量的交互)。我的直觉是,大脑中有很大一部分是预测机器。它训练自身以预测所有事物(从已见事物预测未见事物)。通过学习预测,大脑精心构建了层次化的表征。预测模型可以在和世界的最小量交互中用于规划和学习新的任务。目前的「无模型」强化学习系统,例如 AlphaGo Zero,需要与「世界」进行大量的交互来学习(虽然它们学习得很不错)。它们在围棋或象棋中表现得很好,但这样的「世界」很简单、很确定性,并且可以同时使用多个计算机快速运行。和这样的「世界」交互很容易,但无法推广到现实世界中。你不能在驾驶汽车时通过 5 万次撞击学习「不能撞击」的规则。人类甚至只需要一次经验就能学习到这样的规则。我们需要让机器学习这样模型。

Yann LeCun:下一个里程碑:深度无监督学习、可以进行推理的深度学习系统。无监督学习的挑战:学习世界的层次化表征,以理解变化的解释因素。我们需要让机器学习如何在不完全可预测的世界中进行预测。关键技能:对连续型数学(线性代数、多变量微积分、概率统计、优化学等)的掌握/良好直觉。熟练的编程技能。熟练的科学方法论。总之:创造力和直觉。 -

2018-11-13:Yan LeCun 109页最新报告:图嵌入, 内容理解,自监督学习

-

Yann LeCun演讲:如何让 AI 学习常识, AI 未来趋势又在何 | GMIC 2018

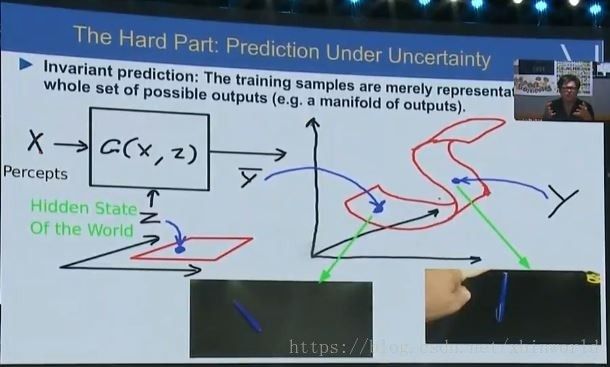

所以不管下次的变革在哪个点,我觉得它都不会是监督学习,当然也不会是纯强化学习的。它应该会有某种自我监督或者无监督学习。而且也会在这样的变革当中出现一些常识性的学习。我总结一下,这也就是我们近期在 Facebook 做的预测学习,学习如何预测、推理以及计划,也就是学习「常识」。它的核心思想是,自动的智能机器人应当有一个内部的世界模型,可以在它做出行动之前自己进行模拟,预知自己的动作的结果。这是一种最优控制中常见的方法,但在机器学习中就不那么常见了。这里我们遇到的问题也就是如何让人工智能学会对世界建模、从而用这个模型帮助自己规划现实世界中的行为。

预测的时候还需要处理不确定性,在桌子上立一支笔,然后松手,它就会倒下来。我们只确定它会倒下来,但是不确定具体会倒向哪个方向。这种时候我们也就需要对抗性训练,训练模型不只给出一个答案,而是多个可能的答案。这里需要两个模型,一个模型做预测,另一个模型来评判哪些结果还不错、哪些结果是现实世界不太可能发生的。做预测的模型也就要尝试让自己的预测越来越好,让做评判的模型分不清哪些是真的会发生的,哪些只是预测出的结果。

所以,对抗性训练也就是我们希望可以帮助建立预测机器的方法。预测应当是智慧的核心,我相信能训练出具有预测能力的模型也就能在未来几年中为我们带来大的进步。

- 2017-12-23:Hinton:今年AI没有重大突破,但三件事值得关注

(还有Andraw Ng,Andrew Moore,Rodney Brooks,等其他很多人的回答)

2017年确实有很多不错的进展,不过比起14年用神经网络做机器翻译,或者16年的AlphaGo,都谈不上重大突破。今年最大的进步,在我看来是以下几点:

1)神经架构搜索:用神经网络来自动设计神经网络,而且有效。

2)基于注意力机制的机器翻译,不再需要循环或者卷积了。

3)AlphaZero:快速学会以人类的风格下棋,把最强的棋类程序抛在身后。

- 「2018深度学习10大警示」多数芯片公司将破产;元学习成为新SGD

2018年,对于深度学习来说,将是剧变的一年。多数硬件公司将破产;元学习将成为新随机梯度下降法;直觉机器将弥合语义差异;深度学习研究将愈发泛滥等十大趋势值得注意。

- 2017-6-16:Bengio:深入了解深度学习中的“记忆”!

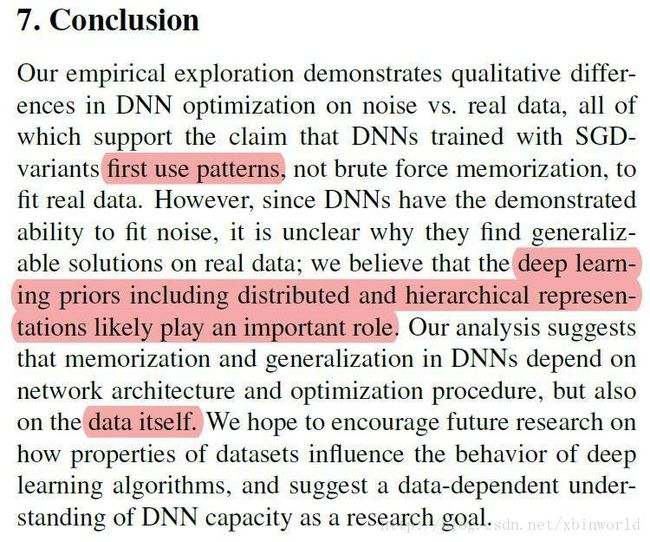

Bengio等人在arxiv上发表:《A Closer Look at Memorization in Deep Networks》:我们研究记忆在深度学习中的作用,吸取能力的连接,泛化和对抗的鲁棒性。虽然深层网络能够记忆噪声数据,但我们的结果表明,他们倾向于首先学习简单模式。在我们的实验中,我们揭示了深层神经网络(DNN)在噪声与实际数据的梯度优化中的定性差异。我们还表明,对于适当调整的明确正则化(例如,退出),我们可以降低噪声数据集上的DNN训练性能,而不会影响实际数据的泛化。

-

2017-10-21:南京大学周志华老师刚刚在微博发表对AlphaGo Zero的看法:非常值得大家学习。

周志华:花半小时看了下文章,说点个人浅见,未必正确仅供批评:

(1)别幻想什么无监督学习,监督信息来自精准规则,非常强的监督信息。

(2)不再把围棋当作从数据中学习的问题,回归到启发式搜索这个传统棋类解决思路。这里机器学习实质在解决搜索树启发式评分函数问题。

(3)如果说深度学习能在模式识别应用中取代人工设计特征,那么这里显示出强化学习能在启发式搜索中取代人工设计评分函数。这个意义重大。启发式搜索这个人工智能传统领域可能因此巨变,或许不亚于模式识别计算机视觉领域因深度学习而产生的巨变。机器学习进一步蚕食其他人工智能技术领域。

(4)类似想法以往有,但常见于小规模问题。没想到围棋这种状态空间巨大的问题其假设空间竟有强烈的结构,存在统一适用于任意多子局面的评价函数。巨大的状态空间诱使我们自然放弃此等假设,所以这个尝试相当大胆。

(5)工程实现能力超级强,别人即便跳出盲点,以启发式搜索界的工程能力也多半做不出来。

(6)目前并非普适,只适用于状态空间探索几乎零成本且探索过程不影响假设空间的任务。 -

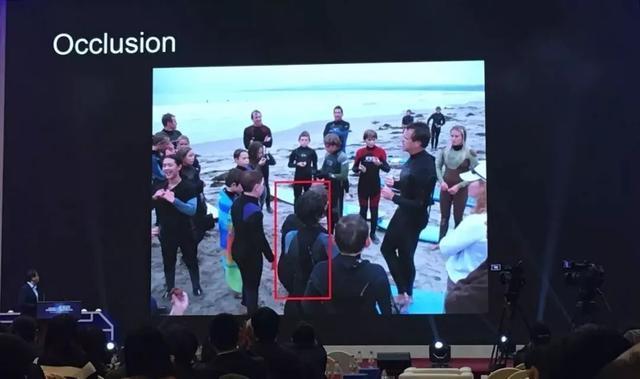

2018-2-8:旷视科技孙剑:物体检测中很难用函数逼近去解决的几大问题

今天虽然有深度神经网络,但是只能解决函数逼近问题,有很多问题很难用函数逼近去解决。虽然说视觉是感知问题,但是视觉背后有很多认知问题,所以视觉横跨感知和认知领域。

(1) 比如物体识别的“定义”问题。要定义“椅子”就非常困难,你很难定义清楚它。但如果一上来定义不清楚,怎么谈到做精确的物体识别?还有很多定义的概念是包容性的,千差万别。只有对这些概念有很好的建模,才能做场景理解。

(2) 还有一些很特殊的光照、特殊的姿态、遮挡等问题。大家看图里的红色框,其实有两个人,一个人被遮挡在后面,大多数人看这个东西还是很容易看出后面一个人,今天物体检测方法非常非常好了,依然做这个做的不太好。

(3) 还有一些需要上下文支持的问题。这图后面这两个红框是什么东西?大多数人看不清楚但是可以猜可能是人,我们今天的机器还没有这个能力去做这样的推理。 另外一个例子,看一张图很难想象是什么东西,但如果你有上下文理解的话会知道这是什么东西

(4) 还有一个很有趣的是我们做视频分析,人有很强的“跟踪”能力,但是如果把今天最好的跟踪系统拿出来,大家看这个图上这块人聚集的位置,重叠非常严重,今天的机器很难做到这个。我们检测方法并没有非常好的推理机制在里面。

还有一些挑战,像机器人要做好手眼配合,今天为什么家庭机器人卖不出去?因为它不能做家务,不能做饭。还有更多的挑战,不管是做无人车,还是做无人驾驶,确实在一定程度上要求的精度是非常高,甚至高过现在的标准,人工智能技术才能顺利地推广下去。

……

我在2010年写过一篇文章,怎么做深度学习、人脸识别,当时还没有进入人脸识别,通过建立一个大的数据库,用关联预测的机制来改善人脸识别的问题。当然预测也很重要,图象预测,左边有南瓜,抠掉以后,用图象学的方法来求解南瓜后边是什么东西,当时还需要引入人的交互划一条线,这是一种人的预测。预测的背后是很好的学习机制,我们通过每天观察世界,通过预测知道结果,形成海量的数据。左边是我们当时做的rich image,这张照片你需要识别出是什么人,什么地方,才能看图说话。

如果做这么一个系统,我们会构想什么样的系统才能把这个困难放在系统里解决,不是单点突破。大家看AlphaGo的成功,AlphaGo zero的成功,AlphaGo zero的成功是因为它能快速的模拟,**给我们的启示是我们如果要想做好人工智能,需要建立一个虚拟的世界,快速的去模拟这个世界,哪怕这个世界是简化的,让这个世界能够运行起来。**运行起来,**不管是有无监督,预测、推理、观察都可以在这个世界重运行,**当然这个不容易,但这是我们非常看好的研究方向。谢谢大家。

前沿技术

- 挑战量子权威!18岁华裔天才创新推荐算法,实现指数级加速,https://arxiv.org/abs/1807.04271

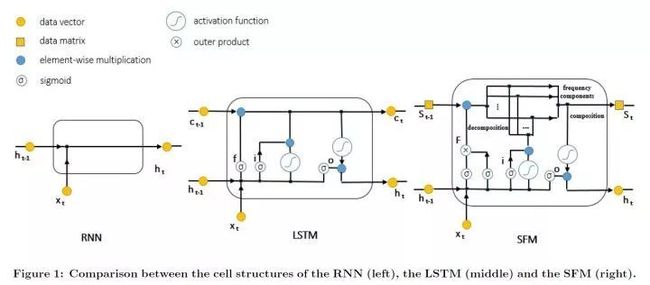

- 2018-2-18:深度学习引入信号处理技术,轻松分析股票等各种序列数据

股的例子告诉我们,对特定的应用,不同频率上的信号所起到的作用是不一样的。这类问题在很多工程应用中都有所体现。比如对特定物体进行跟踪。作为一个经典的预测问题,物体跟踪通过特定的观察量(比如雷达、激光雷达等)对某个物体实际的位置进行持续的预测。

这个时候,找到符合物体运动周期的特征,并用这些特定频率上的特征对运动进行分析就非常重要。同样地,在分析、预测社会活动时,这种特定周期或频率的特征模式往往也是非常常见的。比如,在分析交通流量时,上下班周期、在一个星期内不同天的周期等,对交通流量的分析预测都会起到非常关键的作用。找到并针对性地量化分析这些周期对预测未来趋势的影响,往往是分析序列数据的关键。这些都启发我们:在对信号进行预测时,需要对不同频率的信号区别对待,针对特定的任务加以合理应用。

经典的LSTM仅仅对时间信号的状态向量做为记忆元(Memory Cell)进行建模,而忽略了另一个重要维度频率。而我们将状态(state)-频率(frequency)联合起来,形成一个状态-频率矩阵(State-Frequency Matrix,SFM) 而非仅仅用一个向量来表示状态。

矩阵中的每个元素,用它的行来索引不同状态:每个状态在物理意义上可以理解成代表某个引发信号波动的因子。另一方面,用SFM的列来检索不同的频率,代表不同因子对不同频率的影响。

有了SFM做为记忆元,我们就可以像一般LSTM里那样定义输入门、输出门、遗忘门和控制信息的流向。特别地,如果我们对高频、短周期信号(比如短期高频的交易时)更关心,对应SFM矩阵的高频部分的信息流就会被输入门、输出门选定出来对信号序列进行建模。反之,如果我们对低频的、长周期信号(比如长期投资时)更有兴趣,那么我们就可以让模型聚焦在用SFM中的低频部分进行分析。

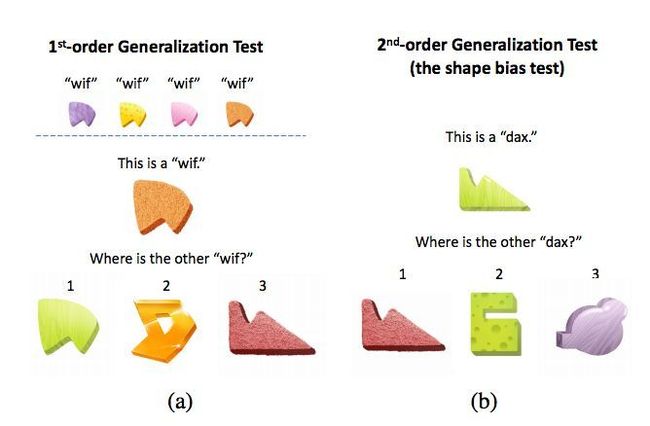

- 2018-2-17: 学界 | 纽约大学:参考儿童认知发展,通过简单神经网络学习归纳偏置

借助先验知识,也就是归纳偏置,人类得以有效学习关于世界的新知识。本文发现,简单神经网络在观察 4 个物体类别的 3 个实例之后,便可以发展出一种形状偏置,这预示着神经网络开始快速学习词汇,与儿童的认知发展过程相一致。本文启发了一种参考生物认知发展过程以初始化模型,然后逐渐泛化到更复杂数据集的模型开发范式

AI硬件技术

- 2018-09-18: 一统所有AI芯片:Facebook揭秘深度学习编译器Glow

- 2018-11-21:图灵奖得主华人高徒发布首款终端AI芯片!64位RISC-V、高度可编程,低功耗

课程资料

- ECE236B - Convex Optimization (Winter Quarter 2018-19):优化学习基础课程

- ECE236C - Optimization Methods for Large-Scale Systems (Spring 2019):优化学习进阶课程

- 2018年7月15日: 斯坦福大学Fall 2018课程-机器学习硬件加速器: ==> 课程Site

- 2018-12-12:免费体验机器学习课程PracticalAI,用Chrome浏览器在线学习Deep Learning以及基本的Python编程。需要梯子。

- 2017-10-21:【Bengio领衔】巴黎高工数据科学暑期学校课程要点合集

- 2017-03-12:牛津大学&DeepMind 2017 深度NLP课程

知乎

- 有哪些学术界都搞错了,忽然间有人发现问题所在的事情?

BP算法自八十年代发明以来,一直是神经网络优化的最基本的方法。神经网络普遍都是很难优化的,尤其是当中间隐含层神经元的个数较多或者隐含层层数较多的时候。长期以来,人们普遍认为,这是因为较大的神经网络中包含很多局部极小值(local minima),使得算法容易陷入到其中某些点。这种看法持续二三十年,至少数万篇论文中持有这种说法。

到2014年,一篇论文《Identifying and attacking the saddle point problem in

high-dimensional non-convex optimization》,指出高维优化问题中根本没有那么多局部极值。作者依据统计物理,随机矩阵理论和神经网络理论的分析,以及一些经验分析提出高维非凸优化问题之所以困难,是因为存在大量的鞍点(梯度为零并且Hessian矩阵特征值有正有负)而不是局部极值。

- 神经网络的训练可以采用二阶优化方法吗(如Newton, Quasi Newton)?

会议资料合集

-

1996-2015:计算机科学领域顶级会议最佳论文全收录

-

2016.01.10:2015深度学习年度十大论文

Gradient-based Hyperparameter Optimization through Reversible Learning,

Speed Learning on the Fly,

[Bengio] Clustering is Efficient for Approximate Maximum Inner Product Search -

2017-10-22:ICCV 2017 TUTORIAL ON THE MATHEMATICS OF DEEP LEARNING

-

真正统治世界的十大算法

-

2018-02-15: 人工智能、机器学习及数学基础经典著作24本PDF下载地址

-

2018-2-17: 【AI幽灵】超90%论文算法不可复现,你为何不愿公开代码?

针对主要会议上发表的400篇AI论文的调查显示,只有6%的论文包含算法的代码,约30%包含测试数据,54%包含伪代码。在AAAI会议上,加拿大麦吉尔大学的计算机科学家Peter Henderson表示,通过反复试验学习设计的AI的性能不仅对所使用的确切代码高度敏感,还对产生的随机数“超参数”也非常敏感——这些设置不是算法的核心,但会影响其学习速度。

Benchmark & Dataset

- 2018-12-10:AI界的State of the art 都在这里了:https://www.stateoftheart.ai/

- 2018-3-19:百度Apollo发布海量自动驾驶数据集,还有两项重磅挑战赛

- 2018-9-10:腾讯开源ML-Images,超越谷歌成业内最大多标签图像数据集

2018 年 9 月 10 日,腾讯 AI Lab 宣布将于 9 月底开源“Tencent ML-Images”项目,该项目由多标签图像数据集 ML-Images,以及业内目前同类深度学习模型中精度最高的深度残差网络 ResNet-101 构成。设计了:a) 带有权重交叉熵损失函数,b) 损失函数权重的自适应衰减,c) 负图像降采样,可以有效抑制类别不均衡对模型训练的不利影响。

研究Lab

- 2018-05-07:华盛顿大学成立SAML实验室:陈天奇参与,推进未来AI系统全栈研究

- SE(3) COMPUTER VISION GROUP AT CORNELL TECH

Our group’s research focuses on Computer Vision, Machine Learning, and Human-in-the-Loop Computing with applications ranging from image based geolocalization to assistive technology for the visually impaired. Much of our work involves humans and machines working together to solve challenging problems involving fine grained categorization and perceptual organization.

- :清华姚班的工作整理:

2018-05-27:一人署名!清华特奖、姚班本科生乔明达论文协作学习的鲁棒性方法

Tools, Docker, Framework

- 2017-12-21:教程 | 如何用Docker成为更高效的数据科学家?

- 2018-06-06:Spark团队开源新作:全流程机器学习平台MLflow

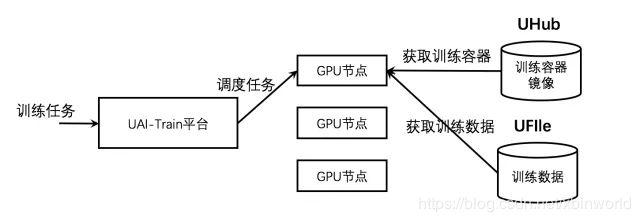

- 2018-05-27:基于UAI-Train平台的分布式训练

企业新闻

- 净利润大涨三倍、股价飙升,百度新上了一个秘密武器:强化学习

- 阿里巴巴开源深度学习框架 X-Deep Learning,引领高维稀疏数据场景的深度学习标准

XDL 框架具有五大系统核心能力:第一,为高维稀疏数据场景而生。XDL 针对高维稀疏数据场景,进行了性能优化,支持千亿级参数的超大规模深度学习模型训练;第二,工业级分布式训练。XDL 原生支持工业级的大规模分布式训练,具备完整的分布式容灾语义,可水平扩展至上干并发,支持批量学习与在线学习模式;第三,桥接多后端支持。XDL 创造性地采用了桥接的架构设计理念,复用了现有的开学深度学习框架的单节点稠密计算能力,支持 TensorFlow 与 MxNet 作为其单节点计算后端。这种桥接的架构,使得 XDL 跟业界的开源社区无缝对接。此外,对于已经在使用其它开源框架的企业或者个人用户,也可以在原有系统基础上轻松进行扩展。第四,高效的结构化压缩训练。XDL 针对互联网数据的特点,提出了结构化压缩训练模式,大幅缩减 IO 通信量和训练计算量,训练效率可达 10 倍以上的提升;第五,独创的高级模型服务器。XDL 提出了全新的 model shuffle 模式,原生支持多模态网络、异构计算网络等复杂算法。 - List item