scrapy_redis实现分布式爬虫

Redis数据库

——redis是一个开源的支持网络、可基于内存亦可持久化的日志型、非关系型、key-value数据库,其结构十分灵活。

——Redis是内存中的数据结构存储系统,处理速度快,提供队列集合等多种存储结构,方便队列维护。

——Redis提供了集合数据结构,调度服务器借助Redis结合实现URL去重。

——用户可在Redis集合中存储每个request的指纹(所谓指纹,就是标志request唯一性的多个特征),从而判断request是否已经加入了队列,如果已经加入,就不再重复添加。

Redis的安装

1.redis的下载

1.1Linux和Mac操作系统:在官网下载解压后编译安装

1.2windows系统:Redis官网没有提供下载安装版本,下载地址

https://github.com/MicrosoftArchive/redis/releases

链接:https://pan.baidu.com/s/1KYPW7UVKWu1I3wlBKcMZXw

提取码:t15q

2.Redis的安装

2.1将下载的压缩包解压

2.2命令进入解压目录,输入命令

redis-server redis.windows.conf

2.3这种方法虽然启动了Redis,但只要关闭cmd窗口,Redis就会停止运行,所以将Redis设置成windows下的服务

redis-server --service-install redis.windows-service.conf --loglevel verbose

redis-server --service-start

2.4停止Redis服务

redis-server --service-stop

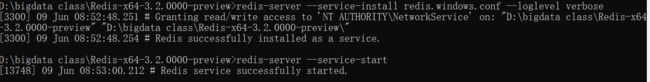

######报错问题#######:

>redis-server --service-start

[15852] 09 Jun 08:49:31.499 # HandleServiceCommands: system error caught. error code=2, message = StartService failed: no such file or directory

原因是系统服务中已经存在

先卸载之前存在的

redis-server --service-uninstall

redis-server --service-install redis.windows.conf --loglevel verbose

3.scrapy_redis实现分布式爬虫

scrapy_redis库:提供了所需的功能,scrapy_redis改写了scrapy的调度器、队列等组件,利用这个库可以方便地实现scrapy分布式架构。

3.1安装scrapy_redis库

>pip install scrapy_redis

3.2修改settings中的配置信息

替换scrapy调度器,使用scrapy_redis调度

SCHEDULER = "scrapy_redis.scheduler.Scheduler"

使用scrapy_redis去重

DUPEFILTER_CLASS = "scrapy_redis.dupefilter.RFPDupeFilter"

设置Redis的连接信息,这里的可以设置用户名和密码,如果没有则为空

REDIS_URL = "redis://localhost:6379"

设置Redis队列是否保存

如果设置为TRUE,则不会清空Redis里面的去重队列和请求队列,这样设置后,去重队列和请求队列会一直保存在Redis数据库中,用户可以暂停和启动爬虫而不影响继续去重

SCHEDULER_PERSIST = True

设置重启爬虫时是否清空爬虫队列

如果设置为True,每次重启爬虫,系统都会清空去重队列和请求队列,一般设置为False

SCHEDULER_FLUSH_ON_START = True

修改spider文件:

当使用scrapy_redis编写分布式爬虫时,需要将爬虫类修改为继承自scrapy_redis.spiders.RedisCrawSpider类。

from scrapy_redis.spiders import RedisCrawlSpider

from lianjia01.items import Lianjia01Item

class LianjiaSpider(RedisCrawlSpider):

name = 'lianjia'

allowed_domains = ['m.lianjia.com']

redis_key = 'LianjiaSpider:start_urls'

……

运行爬虫

修改完成后启动爬虫。因为代码中没有指定初始URL,爬虫会一直等待,没有爬取任何网页。用户可以手动向Redis的初始URL队列中添加URL,队列的名称为

LianjiaSpider:start_urls

默认情况下,在命令行定位到Redis目录,采用集合的命令进行添加

redis-cli lpush LianjiaSpider:start_urls https://m.lianjia.com/bj/jingjiren/ao22pg1