【论文笔记】Person Transfer GAN to Bridge Domain Gap for Person Re-Identification

摘要

本文提出了一种针对于ReID的生成对抗网络PTGAN,可以实现不同ReID数据集的行人图片迁移,在保证行人本体前景不变的情况下,将背景转换成期望的数据集style。另外本文还提出一个大型的ReID数据集MSMT17,这个数据集包括多个时间段多个场景,包括室内和室外场景,是一个非常有挑战的数据集。论文用PTGAN来缩小不同数据集间的domain gap,并在新提出的MSMT17这个大数据集和其他一些公开的小数据集上做了实验。

MSMT17数据集

MSMT17是一个大型的ReID数据集,现在的一些公开数据集的准确度已经被刷得很高,这个数据集的提出进一步延续了ReID的发展。不过数据集目前还有公开,等待论文接收后数据集可以公开。

MSMT17数据集有以下几个特性:

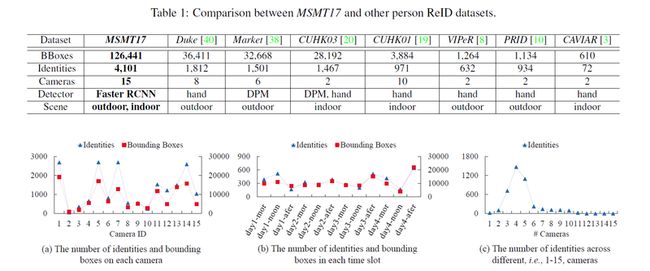

- 数据采集时长约为180小时

- 总共有15个相机,其中12个室外相机,3个室内相机

- 行人框由Faster RCNN机标完成

- 最后总共有4101个行人的126441个bounding boxes

上图是MSMT17数据集和已有的ReID数据集的对比。

PTGAN

Person Transfer GAN (PTGAN)是作者提出的一个针对于ReID问题的GAN。这个GAN最大的特点就是在尽可能保证行人前景不变的前提下实现背景domain的迁移。

首先PTGAN网路的损失函数包括两部分:

其中 LStyle 代表生成的风格损失,或者说domain损失,就是生成的图像是否像新的数据集风格。 LID 代表生成图像的ID损失,就是生成的图像是否和原始图像是同一个人。 λ1 是平衡两个损失的权重。下面的关键就是看这两个损失怎么定义。

首先PTGAN的基础是CycleGAN,所以loss也和正常的CycleGAN的loss差不错。首先第一部分是 LStyle ,这个就是标准的CycleGAN的判别loss

以上几部分都是正常的CycleGAN的损失,保证生成的图片和期望的数据集的domain是一样的。

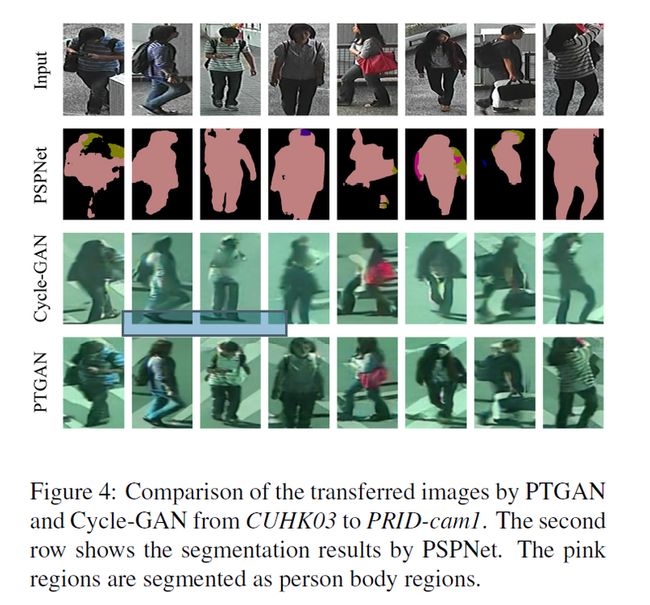

论文的另外一个改进的地方就是 LID 。为了保证图片迁移过程中前景不变,先用PSPNet对图片进行了一个前景分割,得到一个mask区域。传统的CycleGAN并不是用于ReID任务,因此也不需要保证前景物体的ID信息不变,这样的结果就是前景可能模糊之类的质量很差,更糟糕的现象是行人的外观可能改变,比如衣服颜色发生了改变,这是ReID任务非常不希望见到的。为了解决这个问题,论文提出 LID 损失,用PSPNet提取的前景,这个前景就是一个mask,最后ID损失为:

其中 M(a) 和 M(b) 是两个分割出来的前景mask,ID loss将会约束行人前景在迁移过程中尽可能的保持不变。最后转换的效果如下图所示:

可以看出,直观上和传统的CycleGAN相比能够更好的保证行人的ID信息。

结果

实验结果如上表,虽然论文没有用特别复杂的网络来训练,但是将另外一个数据集通过PTGAN迁移到MSMT上都能增加MSMT17数据集上的performance。并且从准确度上看MSMT17还是一个非常难的数据集。