最近一直在深入做手机传感器的调研,一是想系统化的了解手机传感器的原理与当下的应用情况;二是个人感觉未来的输入法交互肯定离不开花样繁多的传感器,传感器在输入的领域有广阔的应用场景。

现在在命令控制领域,尽管涌现出很多交互方式,但得到规模化应用的,现在基本已经分化成两个主要的发展趋势。一个是以Leap Motion、Kinect及三星智能家居应用的手势识别;另一个就是当下比较火热的语音控制。

当下手势识别的工作原理,简单描述就是通过设备投射了一块红外感应区域,通过人手势截断感应区域,实时建模去判断人的手势。或者通过摄像头捕捉手势,进行图形分析,判断手势。

通过体验Leap Motion与Kinect,感觉还是非常不错的,基本的操作手势准确率很高,但是由于操作时必须抬起手截断红外感应区域,所以如果是频繁交互,这种操作就会非常非常累。输入法这种频繁的输入交互,如果利用这种技术手段的手势交互,必然是行不通的。所以这类手势操作基本只能应用于指令操作的场景。

当下的语音输入,看似是最好的解决方式,但是还是有很多的限制性因素,比如噪杂环境的信号处理问题;语音使用的场景问题;语音使用的网络问题;以及识别率及语义理解的问题……这些都是限制当下语音交互在输入环节中广泛应用的问题。同时语音输入与手势输入是解决非标准化触摸屏人机交互的两个发展方向,并没有实质性的冲突。所以未尝不可向两个方向均进行尝试努力。

今年的愚人节,搜狗推出了Typany的输入手环视频,尽管这是愚人节善意的玩笑,但后续搜狗输入法产品经理的解释可以看出搜狗一直在朝这个方向努力。搜狗期望从底层彻底颠覆原本的输入体验,完成多终端的统一体验。从搜狗产品经理写的《有些玩笑,其实开得很认真!》一文中,大致可以窥见他们思考这个问题的思路。首先他们掌握了用户足够多的输入资料,可以利用这些数据构建近似完美的用户输入纠错模型及预测体系;接着他们期望通过准确的捕捉用户输入的三维坐标序列去定位每一个用户输入的字符。当然文中搜狗的产品经理也提到了如何在用户动态打字的过程中精确捕捉三维坐标序列并且进行处理输出是他们遇到的最大问题。

很明显搜狗期望通过在任何物体上构建出一个虚拟的键盘,然后让用户通过既有的拼音输入方式去输入。这样就需要不停地去计算用户虚拟按键的空间位置关系,考虑到中文的输入解码复杂度,可想而知这个实时的精准运算量之大。

这也就顺带出另外一个中文输入的问题——中文的编码复杂度。因为中文与拉丁语系语言通过字母组成词句不同,中文无法通过键盘的按键一一对应映射到每个文字上,所以必须给每个中文进行编码,再通过键盘输入编码,计算机进行译码,完成整个的中文汉字输入。所以,无论是拼音、双拼、五笔、笔划及仓颉,中文的几种主流输入方式,莫不是如此。因为不是通过键盘一一对应上屏,所以每个字的输出都要依靠键盘键入多个字母。这种传统的中文转码输入方式,并要通过传感器捕捉进行实时回馈,很明显对于传感器来说负担过重。

而继T9键盘创始人Cliff Kushler为触屏专门设计推出了Swype滑行输入法之后,谷歌、Bing、触宝等输入法均有跟进。个人在体验过程中感觉在屏幕上进行滑动的方式比较顺畅,加上对输入路劲的模糊计算,容错率的提升,感觉输入很畅快。很多时候,当一些字输入习惯之后,一些常用字输入已经不用去对着键盘的字母进行滑动,只需要凭借之前记忆该字的路劲直接滑出路劲图形即可。

如果这样的话,是否可以将滑行输入法直接抽象成路径图形的表义。比如“我”直接抽象成一条类似“——”的横线,其他的文字都通过实体键盘的转义成简单的图形化。因为转换成简单图形路径之后,对与传感器的负担就会大大减轻,传感器不需要再去实时检测相对的位置数据信息,只需记录下图形路径即可,配合容错与词组排序的优先级,似乎就可以输出文字。

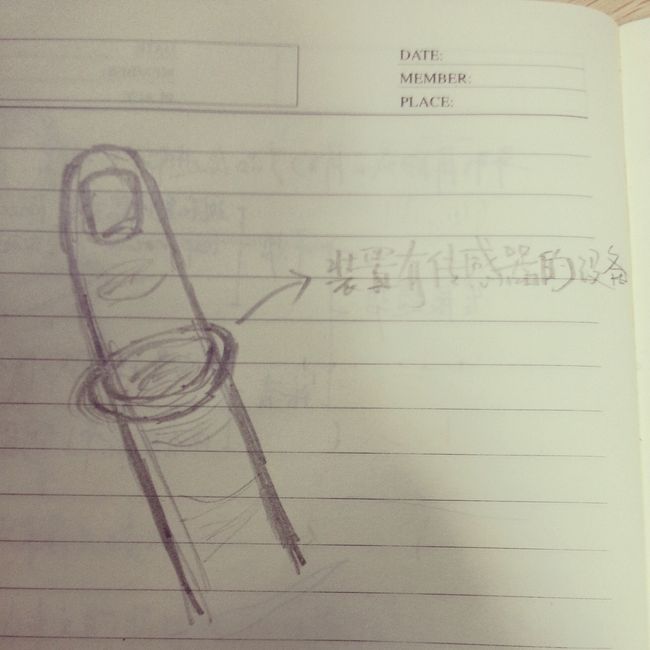

以上即是个人对于输入方式的一种思考,接下来是具体的一些产品概念设想:

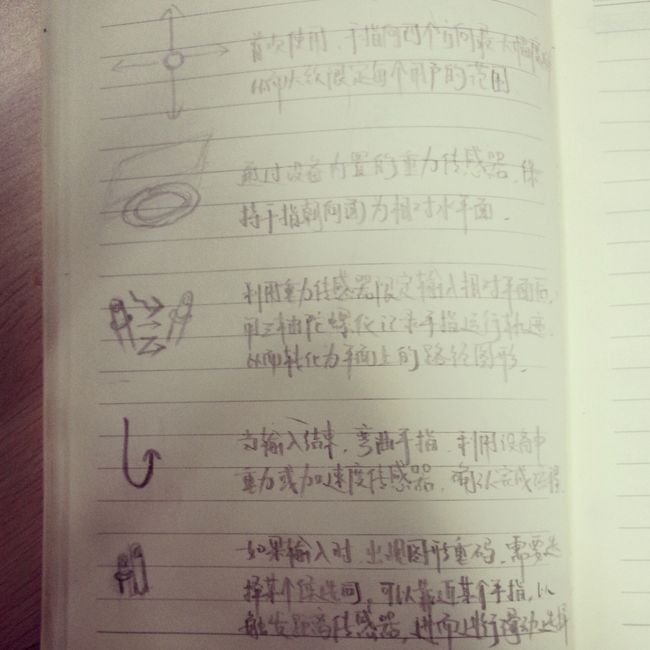

简而言之,这个想法可分为这三步:

- 滑行输入抽象成图形路径输入;

- 用三轴陀螺仪传感器将立体的手势操作传化成二维路径图形;

- 利用容错与图形组合去定位正确词组输出。

当然,这个思考过程中遇到了很多实际问题,比如三轴陀螺仪的精确度是否足以进行如此精细的操作(后来知道现在已经有提供九轴陀螺仪的公司啦,还是国内的团队!);滑行输入法的纠错是否足以满足抽象成图形路径输入需求……这些都是技术上再考虑的问题,但是现在有一个摆在面前的场景需求问题,就是如何统一不同终端屏幕尺寸乃至无标准屏幕的输入体验一致性的问题。希望可以发散出更好的idea,让输入变得更简单,让世界变得更美好!_