深度学习笔记(十 一)---分类与回归评价指标

目录

1、概念

1.1、前提

2、评价指标(性能度量)

2.1、分类评价指标

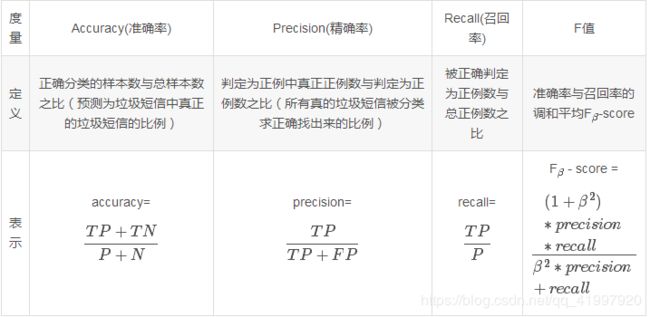

2.1.1 值指标-Accuracy、Precision、Recall、F值

2.1.2 相关曲线-P-R曲线、ROC曲线及AUC值

2.2、回归评价指标

2.2.1 可释方差得分

2.2.2 平均绝对误差 MAE (Mean absolute error)

2.2.3 均方差 MSE (Mean squared error)

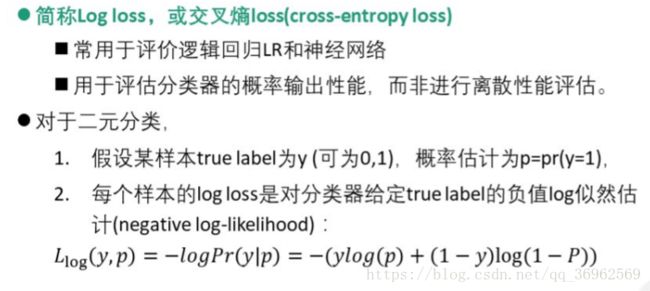

2.2.4 logistics回归损失

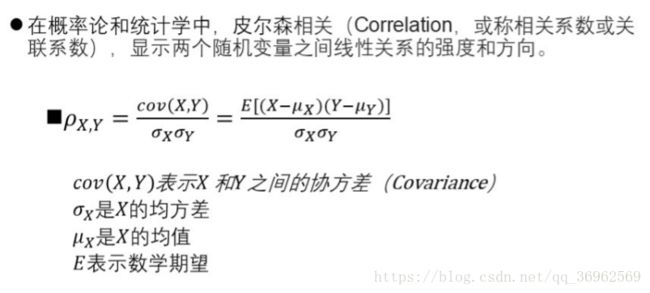

2.2.5 一致性评价 - pearson相关系数法

3.参考文献

1、概念

性能度量(评价)指标,主分为两大类:

(1)分类评价指标(classification),主要分析,离散的,整数的。其具体指标包括accuracy(准确率),precision(精确率),recall(召回率),F值,P-R曲线,ROC曲线和AUC。

(2)回归评价指标(regression),主要分析整数和实数之间的关系。其具体指标包括可释方差得分(explianed_variance_score),平均绝对误差MAE(mean_absolute_error),均方误差MSE(mean-squared_error),均方根差RMSE,交叉熵lloss(Log loss,cross-entropy loss),R方值(确定系数,r2_score)。

(3)聚类评价指标:兰德指数、互信息、轮廓系数。

1.1、前提

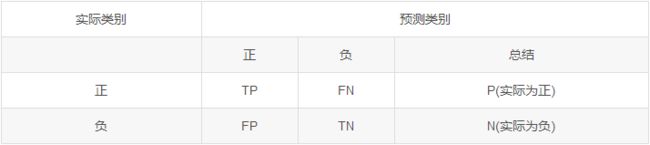

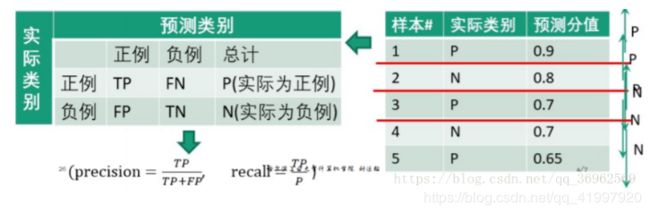

假设只有两类-正类(positive)和负类(negative),通常以关注的类为正类,其他类为负类(故多类问题亦可归纳为两类)

混淆矩阵(Confusion matrix)如下 :

表中AB模式:第一个表示预测结果的对错,第二个表示预测的类别。如TP表示,True Positive,即正确的预测为正类;FN表示,False Negative,即错误的预测为了负类。

2、评价指标(性能度量)

2.1、分类评价指标

2.1.1 值指标-Accuracy、Precision、Recall、F值

注:

1.precision也常称为查准率,recall称为查全率

2.F值比较常用的是F1,

3. β 越大,Recall的权重越大, 越小,Precision的权重越大。

由于F / β / Score 无法直观反映数据的情况,同时业务含义相对较弱,实际工作用到的不多。

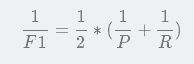

意义:精确率与召回率的调和平均值,它的值更接近于Precision与Recall中较小的值![]()

2.1.2 相关曲线-P-R曲线、ROC曲线及AUC值

(1) P-R曲线

步骤:

1、从高到低将”score”值排序并依次作为阈值threshold;

2、对于每个阈值,”score”值大于或等于这个threshold的测试样本被认为正例,其他为负例。从而形成一组预测数。

将0.9作为阈值,则第1个测试样本为正例,2、3、4、5为负例

得到

在阈值以下的部分,当作负例,则预测为负例的取值情况是正确预测值,即如果本身是正例,则取TP;如果本身是负例,则取TN,其都为预测分值。 负样本非常多,因此FPR=FP/N−FPR=FP/N−总是很小,考察TPR和FPR不是很有意义,这是候我们就只讨论正样本,考察TPR(recall)和PPV(pricision).,

(2)ROC曲线

横轴:假正例率 fp rate = FP / N

纵轴:真正例率 tp rate = TP / N

步骤:

1、从高到低将”score”值排序并依次作为阈值threshold;

2、对于每个阈值,”score”值大于或等于这个threshold的测试样本被认为正例,其他为负例。从而形成一组预测数。

同P-R曲线计算类似,不再赘述

鸢尾花数据集的ROC图像为

(3)PR curve

PR 曲线信息检索中定义的一种曲线,并不适用于一般的分类问题。假定k为每次检索返回的信息条目数量,很显然,根据我们的定义recall将随k的增大而增大,precision将随k的增大而减小。在不同的k下得到一组recall,pricision值,绘制在同一坐标系中就是PR曲线。

(4) AUC

AUC(Area under Curve):Roc曲线下的面积,介于0.1和1之间。Auc作为数值可以直观的评价分类器的好坏,值越大越好。

Auc = 1 ,完美分类,对应于roc可以完全做到(1,1)的点。

0.5 AUC的物理意义是任取一个正例和任取一个负例,正例排序在负例之前的概率。AUC反应的是分类器对样本的排序能力。另外值得注意的是,AUC对样本类别是否均衡并不敏感,这也是不均衡样本通常用AUC评价分类器性能的一个原因。 (5)比较PR曲线,F1值,ROC曲线,AUC值 PR线是以Precision为纵坐标、Recall为横坐标。ROC是以为TPR为纵坐标、FPR为横坐标。在ROC空间,ROC曲线越凸向左上方向效果越好,因为这说明精确率高且覆盖率大。与ROC曲线左上凸不同的是,PR曲线是右上凸效果越好。 ROC和PR曲线都被用于评估机器学习算法对一个给定数据集的分类性能,每个数据集都包含固定数目的正样本和负样本。而ROC曲线和PR曲线之间有着很深的关系。 定理1:对于一个给定的包含正负样本的数据集,ROC空间和PR空间存在一一对应的关系,也就是说,如果recall不等于0,二者包含完全一致的混淆矩阵。我们可以将ROC曲线转化为PR曲线,反之亦然。 定理2:对于一个给定数目的正负样本数据集,一条曲线在ROC空间中比另一条曲线有优势,当且仅当第一条曲线在PR空间中也比第二条曲线有优势。(这里的“一条曲线比其他曲线有优势”是指其他曲线的所有部分与这条曲线重合或在这条曲线之下。) 当正负样本差距不大的情况下,ROC和PR的趋势是差不多的,但是当负样本很多的时候,两者就截然不同了,ROC效果依然看似很好,但是PR上反映效果一般。解释起来也简单,假设就1个正例,100个负例,那么基本上TPR可能一直维持在100左右,然后突然降到0.如图,(a)(b)分别为正负样本1:1时的ROC曲线和PR曲线,二者比较接近。而(c)(d)的正负样本比例不为为1:1,这时ROC曲线效果依然很好,但是PR曲线则表现的比较差。这就说明PR曲线在正负样本比例悬殊较大时更能反映分类的性能。 两者都要看光不光滑,如果不光滑说明有很大问题是过拟合。 AUC(Area Under Curve)即指曲线下面积占总方格的比例。有时不同分类算法的ROC曲线存在交叉,因此很多时候用AUC值作为算法好坏的评判标准。面积越大,表示分类性能越好。 F1兼顾了分类模型的准确率和召回率,可以看作是模型准确率和召回率的调和平均数,最大值是1,最小值是0。 【1】文献一 【2】文献二 【3】文献三

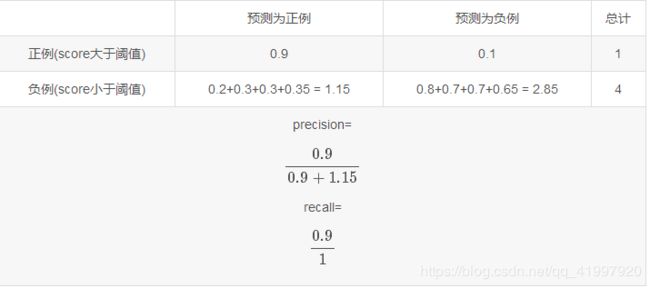

2.2、回归评价指标

2.2.1 可释方差得分

2.2.2 平均绝对误差 MAE (Mean absolute error)

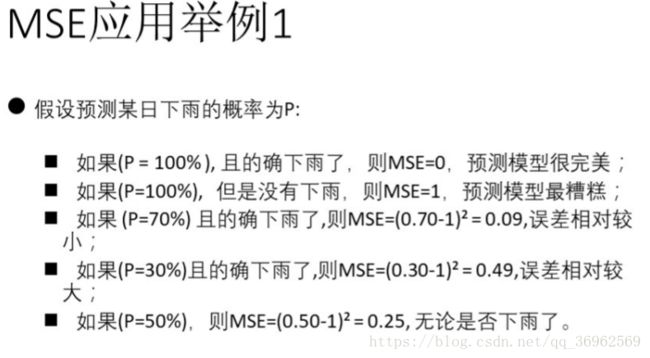

2.2.3 均方差 MSE (Mean squared error)

2.2.4 logistics回归损失 2.2.5 一致性评价 - pearson相关系数法

3.参考文献