干货收藏!基于深度学习目标姿态估计的论文一览(2017-2020)

点上方蓝字计算机视觉联盟获取更多干货

在右上方 ··· 设为星标 ★,与你不见不散

编辑:Sophia

计算机视觉联盟 报道 | 公众号 CVLianMeng

转载于 :黄浴,知乎,已获授权

AI博士笔记系列推荐:

博士笔记 | 周志华《机器学习》手推笔记“神经网络”

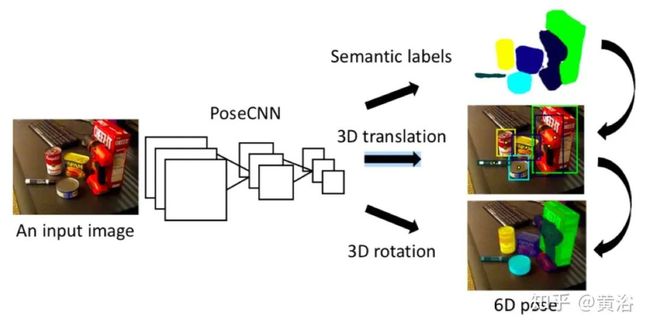

1. PoseCNN: A CNN for 6D Object Pose Estimation in Cluttered Scenes (RSS 2017)

估计已知目标的6D姿势对于机器人与现实世界进行交互非常重要。由于目标的种类繁多以及目标之间的干扰和遮挡导致场景的复杂性,因此该问题具有挑战性。这项工作介绍了用于6D姿势估计的PoseCNN模型,通过在图像中定位目标中心并预测其与相机的距离来估计目标的3D平移量。通过回归四元数表示来估算目标的3D旋转。它还引入了损失函数,该函数使PoseCNN可以处理对称目标。它为6D目标姿态估计构建了一个大型视频数据集,称为YCB-Video数据集。该数据集提供了来自YCB数据集的21个对象的准确6D姿势,这些姿势在92个视频中观察到,具有133,827帧。

代码和数据集位于https://rse-lab.cs.washington.edu/projects/posecnn/

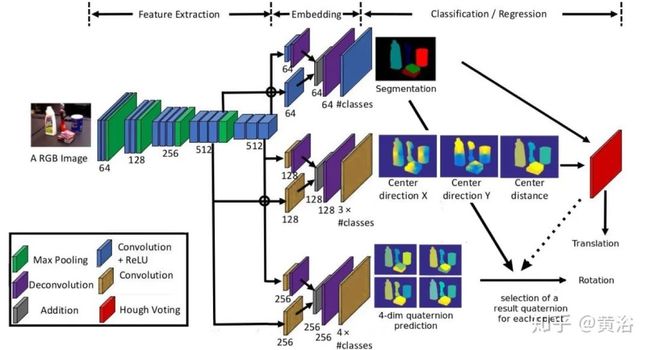

包括三部分:semantic labeling, 3D translation estimation, 3D rotation regression.

PoseCNN网络包含两个阶段。第一阶段包括13个卷积层和4个最大池化图层,它们从输入图像中提取具有不同分辨率的特征图。由于提取的特征在网络执行的所有任务之间共享,因此此阶段是网络的骨干。第二阶段包含一个嵌入步骤,该步骤将第一阶段生成的高维特征图嵌入到低维、任务特定的特征中。然后,网络执行3个不同的任务,从而实现6D姿势估计,即语义标记(FCN的变型),3D平移估计和3D旋转回归。

它通过在图像中定位2D目标中心并估计距相机的目标距离来估计3D平移。网络回归到图像中每个像素的中心方向,然后霍夫投票层找到目标的2D中心。

从霍夫投票层预测目标边框,利用两个RoI合并层,“裁剪并合并(crop and pool)”网络第一阶段为3D旋转回归生成的视觉特征。

如下是架构图:

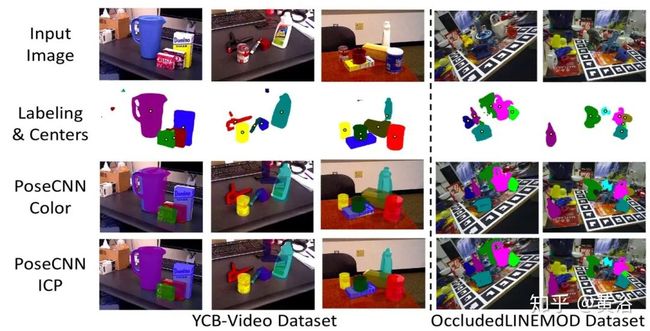

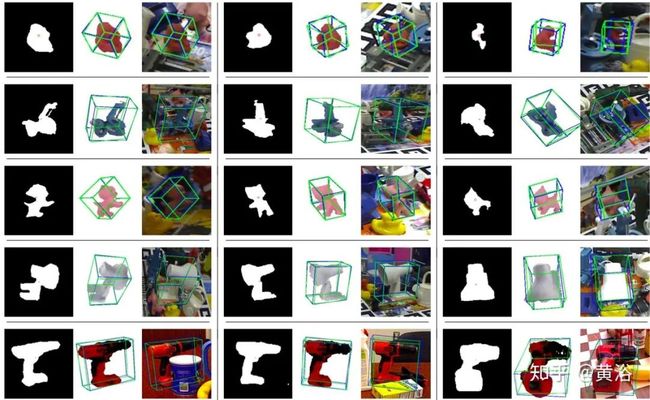

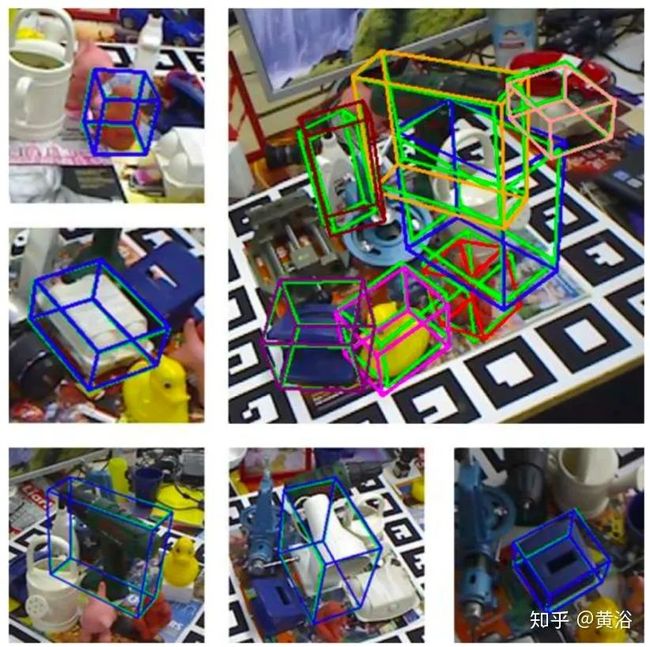

一些定性结果例子:

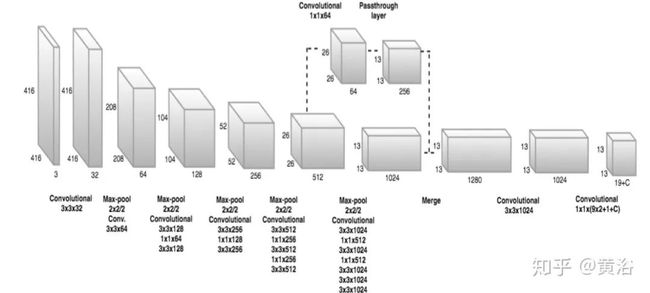

2.Real-Time Seamless Single Shot 6D Object Pose Prediction (2017)

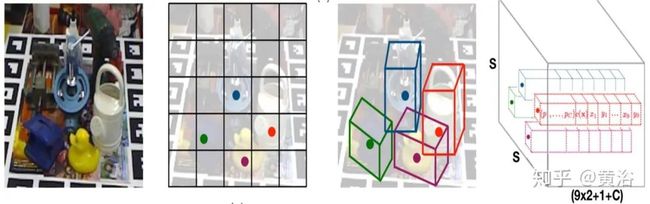

这是一种单步方法,可以同时检测RGB图像中的目标并预测其6D姿势,无需多步或不得不检查多个假设。与最近提出的单样本方法SSD-6D不同,其仅预测需要修正的近似6D姿态,而这种方法的精确度无需进行额外的后处理。速度更快,在Titan X(Pascal)GPU上为50 fps,更适合于实时处理。关键组件是CNN体系结构,可直接预测目标3D边框投影顶点的2D图像位置。然后,使用PnP算法估算目标的6D姿势。

如图是采用的CNN架构图:

如图从左到右依次是:具有四个目标的示例输入图像-》S×S网格显示负责检测四个目标的单元-》每个网格预测图像中投影的3D边框角点2D位置-》来自网络的3D输出张量代表每个网格的矢量,该矢量由2D角点位置、类别概率和与预测相关的置信度值组成。

下图是一些结果(最后一行是失败例子):

3.BB8: A Scalable, Accurate, Robust to Partial Occlusion Method for Predicting the 3D Poses of Challenging Objects without Using Depth (CVPR 2017)

本文介绍了一种仅从彩色图像进行3D目标检测和姿态估计的方法。它首先使用分割来检测在部分遮挡和背景混乱中感兴趣的2D目标。与基于补丁(patch-based)的方法相比,它依靠“整体(holistic)”方法:将经过训练的CNN应用于检测到的目标,以其3D边框角点的2D投影形式预测其3D姿势。但是,这不足以处理来自最近的T-LESS数据集中的目标:这些目标有旋转对称轴,并且在两个不同姿势下,该目标的两个图像相似性使训练CNN模型具有挑战性。

它通过限制用于训练的姿势范围,并引入分类器在估计运行之前识别姿势的范围来解决此问题。它还使用可选的附加步骤来细化预测的姿势。完整的方法也是可扩展的,因为可以同时针对多个目标训练单个网络。

下图是定位的示意图:

而下图展示的是有旋转对称轴目标的姿态估计:

下图介绍姿态修正过程:

接着讨论合成训练图像的方法,如下是两个例子:

最后是一些定性结果示例:

4.SSD-6D: Making RGB-Based 3D Detection and 6D Pose Estimation Great Again (ICCV 2017)

这是一种用于检测3D模型实例并根据RGB数据估计其6D姿势的方法。为此,扩展流行的SSD检测范例以覆盖整个6D姿势空间,并仅训练合成模型数据。该方法可以竞争或超越目前在多个具有挑战性的数据集上利用RGB-D数据的最新方法。它产生约10Hz的结果,比相关方法快许多倍。

如图是SSD样式的网络预测示意图。为网络提供299×299 RGB图像,并用InceptionV4的分支从输入图像中生成六个比例不同的特征图。然后,将每特征图与经过训练的、形状为(4 + C + V + R)的预测内核进行卷积,以确定目标类别,2D边框以及对可能的视点和平面内旋转的得分,这些得分将被解析以构建6D姿势假设。因此,C表示目标类别的数量,V表示视点的数量,并且R表示平面内旋转类别的数量。其他4个值用于细化离散边框的角点以紧紧适合检测到的目标。

如下是一些结果示例:

5. Implicit 3D Orientation Learning for 6D Object Detection from RGB Images (2018)

一个用于目标检测和6D姿态估计的基于RGB图像的实时流水线。该3D方向估计基于去噪 Autoencoder的一种变型,该变型使用域随机化(Domain Randomization)方法在3D模型的模拟视图上进行训练。

域随机化方法建立在以下假设的基础上:在各种半现实设置(增强的随机光照条件、背景和饱和度等)下用渲染视图训练模型,可推广到真实场景。

与现有方法相比,这种增强自动编码器(AAE,Augmented Autoencoder)具有以下优点:

由于训练独立于SO(3)中目标方向的具体表示(例如四元数),因此避免了从图像到方向的一对多映射,能够处理由对称视图导致的歧义姿势。

学习专门对3D方向进行编码的表示形式,同时实现针对遮挡、杂乱背景以及广泛应用于不同环境和测试传感器的鲁棒性。

AAE不需要任何实际的带姿势注释的训练数据;取而代之的是,它经过训练可以以自我监督的方式对3D模型视图进行编码,从而克服了对带有大型姿势注释数据集的需求。

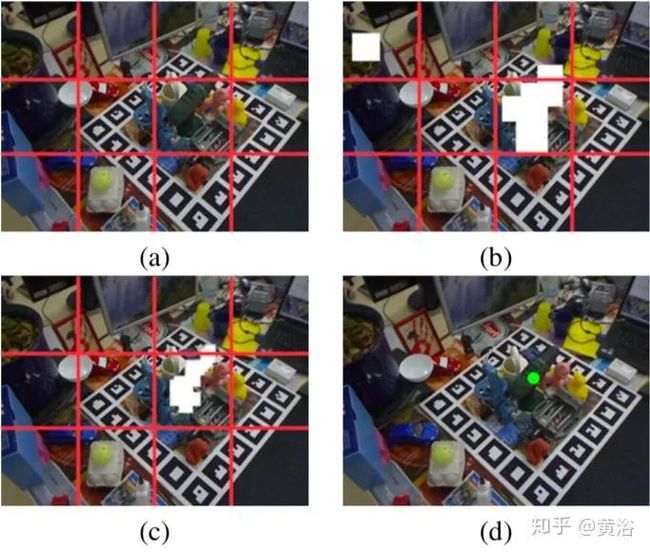

如图是目标检测流水线图:

关于对称目标的姿态歧义性示意图如下:

下图是AAE的训练过程:

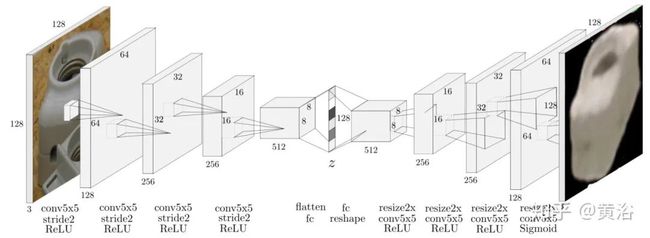

这是自动编码器的架构图:

训练后,AAE能够从许多不同相机传感器的真实场景中提取3D目标。解码器重建的清晰度和方向是编码质量的指标。为了从测试场景确定3D目标朝向,它创建了一个码本(codebook),如图所示:

好的结果不提,这里有些失败的检测和估计例子:

6.PVNet: Pixel-wise Voting Network for 6DoF Pose Estimation (2018.12)

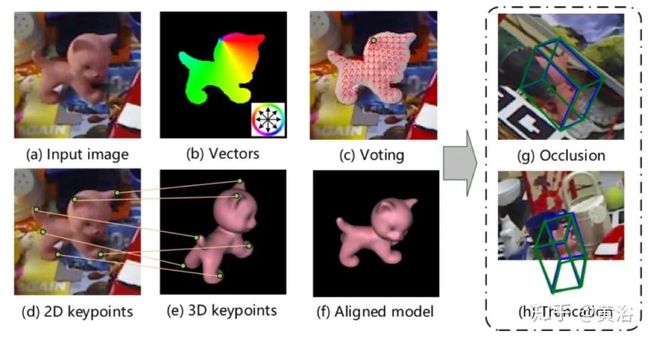

本文解决了在严重遮挡或截断情况下从单个RGB图像进行6DoF姿态估计的挑战。最近的许多工作表明,首先检测关键点然后解决PnP问题的姿势估计两阶段方法可实现出色的性能。但是,大多数这些方法仅通过对稀疏关键点进行定位来回归它们对遮挡和截断敏感的图像坐标或热图。

这里引入了逐像素投票网络(PVNet,Pixel-wise Voting Network),回归指向关键点的逐像素单位向量,并用这些向量通过RANSAC对关键点位置进行投票。这创建了一个灵活的表示形式,用于定位被遮挡或被截断的关键点。此表示的另一个重要特征是,它提供了关键点位置的不确定性,PnP求解可以进一步利用这些不确定性。实验表明,所提出的方法在很大程度上改进了LINEMOD、Occlusion LINEMOD和YCB-Video数据集上的现有技术,同时有效地进行实时姿态估计。该代码将在 zju-3dv.github.io/pvnet 上提供。

下图是定义姿态估计是PnP的示意图:注意小标题。

如图是关键点定位的概述图:(a)输入图像。(b)PVNet的架构。(c)指向目标关键点的逐像素单位矢量。(d)语义标签。(e)通过投票产生的关键点假设。(f)根据假设估算的关键点位置的概率分布。

下面是结果示例:

7.SilhoNet: An RGB Method for 6D Object Pose Estimation (2019.6)

自主机器人操纵涉及操纵目标的平移和方向,即6自由度(6D)姿势估计。使用RGB-D数据的方法在解决此问题方面已显示出巨大的成功。但是,在某些情况下,成本限制或工作环境可能会限制RGB-D传感器的使用。当仅限于单摄像机时,姿势估计的问题非常具有挑战性。

对于某些应用程序(例如AR),了解目标在图像中如何被遮挡是很重要的,在这些应用程序中,仅希望投影在目标的可见部分上。

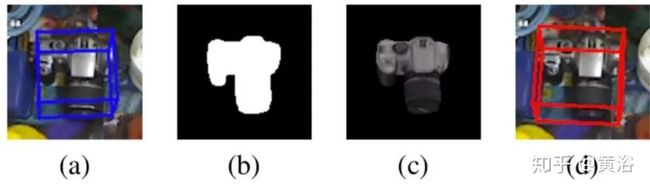

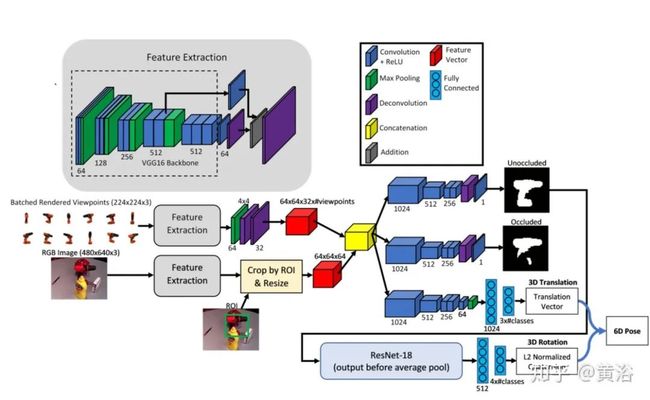

这项工作介绍了基于RGB的深度学习方法SilhoNet,该方法可以根据单目图像预测目标6D姿势。它用一个CNN流水线(如图所示),采用ROI提议来预测具有关联遮挡模版和3D平移向量的目标中间轮廓(silhouette)表示。然后,3D朝向从预测的轮廓中回归。

上图可以看出:该方法分两阶段,首先预测目标的中间轮廓表示和遮挡模版,以及描述3D平移的向量,然后从预测的轮廓回归3D朝向的四元数;网络的输入是RGB图像,其中包含针对检测到的目标ROI提议和相关的类别标签。第一个阶段用VGG16为主干,该主干的末尾具有去卷积层,从RGB输入图像生成特征图(与PoseCNN中使用的相同);从输入图像中提取的特征与来自一组渲染目标视点的特征连接在一起,然后通过3个网络分支,其中两个具有相同的结构以预测完整的未遮挡轮廓和遮挡模版;第三分支预测3D矢量,该3D矢量在像素坐标中对目标中心以及来自相机的目标中心的距离编码;网络的第二阶段将预测的轮廓通过两个FCL的ResNet-18架构,输出表示2D朝向的L2归一化四元数。

下图是一个示例的遮挡和非遮挡轮廓预测:

8. Pix2Pose: Pixel-Wise Coordinate Regression of Objects for 6D PoseEstimation (2019.8)

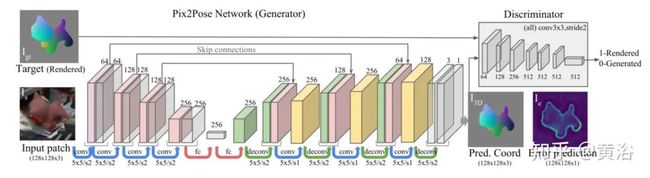

由于存在诸如遮挡和对称性等问题,仅使用RGB图像估计目标的6D姿势仍然具有挑战性。没有专家知识或专门的扫描设备,也很难构建具有精确纹理的3D模型。为了解决这些问题,它提出了一种姿态估计方法Pix2Pose,它可以在没有纹理模型的情况下预测每个目标像素的3D坐标。该文设计一个自动编码器(auto-encoder )体系结构,旨在估计每个像素的3D坐标和误差。然后,这些按像素进行的预测在多步中形成2D-3D对应关系,直接用RANSAC迭代的PnP算法计算姿态。该方法通过对抗性生成训练来精确地恢复被遮挡的部分,其对遮挡是鲁棒的。此外,提出了一种损失函数,即变换器损失(transformer loss),将预测引导至最接近的对称姿态来处理对称目标。

下图是模型架构图和训练流水线:

Pix2Pose用目标的裁剪区域预测单个像素的3D坐标。通过恢复被遮挡部分的3D坐标并运用目标区域的所有像素进行姿势预测,建立鲁棒估计。

训练一个单一网络用于每个目标类。3D模型的纹理对于训练和推理不是必需的。网络输入是检测目标类别的边框的裁剪图像。

网络输出是目标坐标中每个像素的标准化3D坐标以及来自Pix2Pose网络每个预测的估计误差。目标输出(target output)通过在真实姿态下绘制彩色坐标模型,可以轻松导出真实输出。

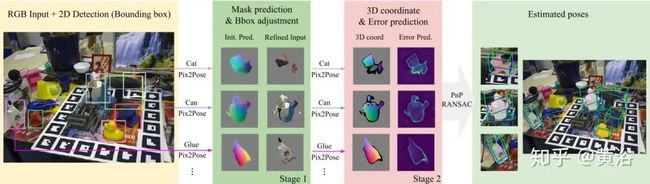

下图是一个姿势估计过程的示例。图像和二维检测结果作为输入。第一阶段,预测结果用于指定重要像素并调整边框,同时去除背景和不确定像素。第二阶段,有效坐标值和较小误差预测的像素,用附加RANSAC的PnP算法来估计姿态。结果中,绿线和蓝线表示真实姿势和估计姿势的目标3D边框。

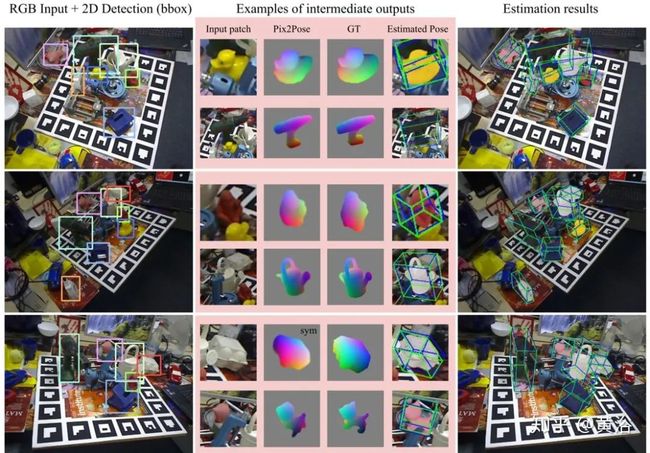

如图是一些结果示例:

9.Accurate 6D Object Pose Estimation by Pose Conditioned Mesh Reconstruction (2019.10)

当前的6D目标姿势估计方法由针对单个目标完全优化的深CNN模型组成,但其结构在具有不同形状的目标之间进行了标准化。这项工作明确地利用了每个目标的独特拓扑信息,即在任何后期处理优化之前,其姿态估计模型中的3D密集网格(dense meshes)。

为此,它提出了一个学习框架,其中图卷积神经网络(Graph Convolutional Neural Network )重构了目标的姿态条件3D网格(pose conditioned 3D mesh)。

在规范和重构密集3D网格之间可微分地计算Procrustes对齐(Procrustes’ alignment),可恢复同心圆朝向(allocentric orientation)的估计。使用附加模版和2D质心投影,自中心姿势(egocentric pose)估计可以提升到6D。通过测量重构网格的质量可验证其姿势估计。

如图是姿态估计的流水线图:

给定单眼RGB输入图像,目标是估计刚性物体的完整6D姿势。它旨在通过充分利用目标的先验信息,以自动化的方式设计每个目标不同的体系结构。重建阶段将已知目标的拓扑与图像提取的编码姿态信息结合在一起。估计的网格信息用于恢复目标的同心轴朝向。用预训练的基于FasterRCNN的2D目标检测器,采用训练数据进行微调,以检测2D空间中的目标。该检测器用于裁剪目标ROI,用于高分辨率,在流水线的下一阶段提取目标外观的精细细节。注意,该特设(ad hoc)检测器是独立训练的。

如图是一些定性结果例子:

10.DeepIM: Deep iterative matching for 6d pose estimation (2019.10)

尽管近来的几种技术已将深度相机用于目标姿态估计,但是这种相机在帧速率、视场、分辨率和深度范围方面具有局限性,这使得很难检测小、薄、透明或快速移动的物体。从图像估计目标6D姿势是各种应用(例如机器人操纵和虚拟现实)中的重要问题。虽然将图像直接回归到目标姿态的准确性有限,但是将目标的渲染图像与输入图像进行匹配可以产生准确的结果。

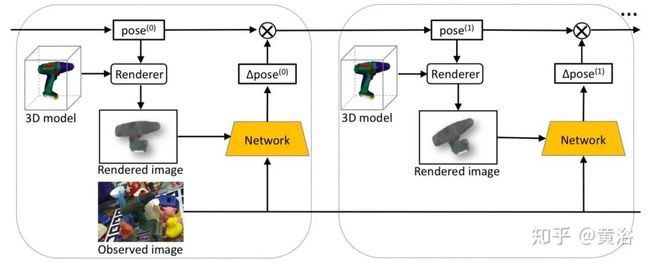

这项工作为6D姿势匹配提出了一个名为DeepIM的深度神经网络。在给出初始姿势估计的情况下,该网络能够通过将渲染的图像与观察到的图像进行匹配来迭代地改善姿势。用3D位置和3D方向的解缠表示法(disentangled representation)以及迭代训练过程对网络训练预测其相对姿态变换。DeepIM能够匹配以前没见过的目标。

如图所示是DeepIM的示意图。训练网络预测其相对SE(3)转换,该转换可以应用于初始姿势估计并进行迭代的姿势优化。给定目标的6D姿势估计(无论是来自PoseCNN还是来自先前迭代的姿势)以及目标的3D模型,它都会在粗略姿势估计下生成显示目标外观的渲染图像。利用渲染图像和观察图像的图像对,网络可以预测相对变换,该变换可用于完善输入姿势估计。

观察到的图像、渲染的图像和两个模版被连接到网络的8通道张量输入(对于观察/渲染的图像为3通道,每个模版为1通道)。它使用FlowNetSimple架构作为骨干网络,该网络经过训练可以预测两个图像之间的光流。姿势估计分支将FlowNetSimple的10个卷积层之后的特征图作为输入。它包含两个全连接层,每个层的尺寸均为256,然后是两个附加的全连接层,分别用于预测3D旋转的四元数和3D平移。在训练过程中,两个辅助分支可以规范化网络的特征表示,并提高训练的稳定性和性能。训练一个分支以预测渲染图像和观察图像之间的光流,另一分支被训练以预测在观察图像中模版的前景模版。其原理直观图如下图所示。

最后是一些试验结果示例:

11.CDPN: Coordinates-Based Disentangled Pose Network for Real-Time RGB-Based 6-DoF Object Pose Estimation (ICCV, 2019)

从单个RGB图像进行6自由度目标姿态估计是计算机视觉中一个基本且长期存在的问题。当前的领先方法是通过训练深度网络来解决该问题的,该网络可以直接从图像中回归旋转和平移;也可以构建2D-3D对应关系,并进一步通过PnP方法间接解决。

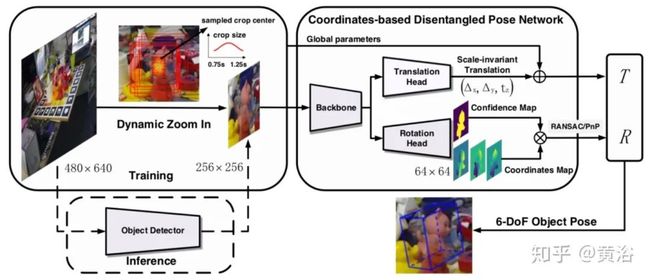

作者认为旋转和平移的显着差异应区别对待。这项工作提出了一种新颖的6自由度姿势估计方法:基于坐标的解缠姿势网络(CDPN,Coordinates-based Disentangled Pose Network),该方法可以解开姿势分别预测旋转和平移,实现高度准确和鲁棒的姿势估计。这种方法灵活和高效,可以处理没有纹理和被遮挡的目标。

其步骤如图所示,给定输入图像,先放大目标,然后解开旋转和平移以进行估计。具体而言,旋转是通过PnP从预测的3D坐标中解决的,而平移则直接从图像中估算出来。

首先,其使用快速轻便的检测器(例如微型YOLOv3)进行粗略检测;其次,实现固定大小的分割以提取目标像素。对于检测,姿态估计系统可以在很大程度上归因于动态放大(DZI,Dynamic Zoom-In),因此可以忍受检测误差,故快速但精度较低的检测器就足够了。

分割,将其合并到坐标回归,足够轻和快。这个两步流水线可以在各种情况下有效地提取准确的目标区域。在平移方面,为了获得更鲁棒和准确的估计,从图像而不是2D-3D对应关系进行预测,以避免在预测的3D坐标中受到比例误差的影响。缩放不变平移估计(SITE)方法不是从整个图像上回归平移,而是从检测到的目标区域估计平移。这样,将有关旋转和平移的解缠结过程统一到单个网络中,即基于坐标的解缠姿势网络(CDPN)。

下面是一些结果例子:

12.DPOD: 6D Pose Object Detector and Refiner (ICCV, 2019)

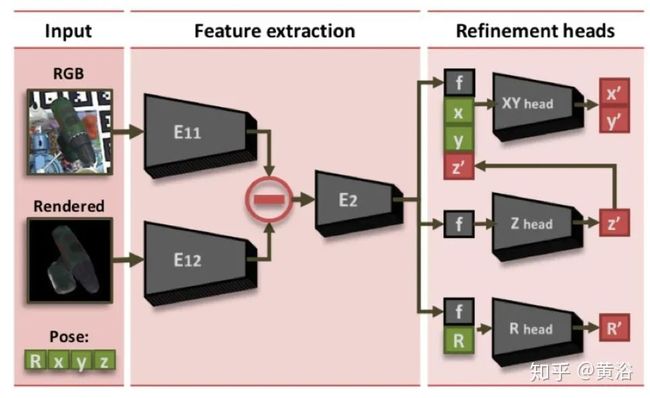

本文提出了一种仅从RGB图像进行3D目标检测和6D姿态估计的深度学习方法。此方法称为(DPOD,Dense Pose Object Detector)密集姿势目标检测器,用于估计输入图像和可用3D模型之间的密集多类2D-3D对应图。给定对应关系,可通过PnP和RANSAC计算6DoF姿态。基于深度学习的定制细化方案对初始姿态估计值进行细化。

与其他用真实数据而不在合成渲染数据进行训练的方法不同,它对合成和真实训练数据都进行评估,与最近的检测器相比,在细化之前/之后均显示出优异的结果。尽管很精确,但所提出的方法仍具有实时能力。

如图所示是DPOD的架构图。

给定输入的RGB图像,具有编码器-解码器神经网络的对应块回归目标ID掩码和对应图。后者提供了明确的2D-3D对应关系,而目标ID掩码则估算了每个检测目标应采用的对应关系。然后,姿势模块基于PnP + RANSAC有效地计算各个6D姿势。

DPOD的推理流水线分为两个模块:对应模块和姿势模块。对应块由具有三个解码器头的编码器-解码器CNN组成,它们从大小为320×240×3的RGB图像中回归目标ID掩码和密集的2D-3D对应图。编码器部分基于类似ResNet的12层架构,具有残差层,可加快收敛速度。解码器使用一堆双线性内插和卷积层将特征上采样到其原始大小。

姿势块负责姿势预测:给定估计的目标ID掩码,观察在图像中检测到哪些目标及其2D位置,而对应图将每个2D点映射到实际3D模型的坐标。然后,使用PnP(Perspective-n-Point)姿势估计方法去估计6D姿势。该方法在给定对应关系和照相机固有参数的情况下可估计照相机姿势。

最后还有一个细化架构,如下图所示:网络会根据初始姿态建议预测精炼姿态。真实图像和渲染的作物被馈送到两个平行的分支中。计算出的特征张量之差是为了估计精确的姿势。

最后一些结果例子:

13.ConvPoseCNN: Dense Convolutional 6D Object Pose Estimation (2019.12)

基于特征和基于模板的方法广泛用于6D目标姿态估计。基于特征的方法依赖于可区分的特征,并且对于纹理较差的目标表现不佳。如果目标被部分遮挡,则基于模板的方法将无法正常工作。随着深度学习方法成功地解决了一些图像相关的问题,启发或扩展这些模型已得到越来越多的使用。对称目标对方位估计提出了特殊的挑战,因为存在多个解决方案或解决方案的多种形式。

这项工作介绍了ConvPoseCNN,一种全卷积体系结构,避免裁剪出单个目标。它提出了目标姿态的平移和朝向分量的像素级密集预测,其中密集朝向以四元数形式表示。它提出了用于密集朝向预测的不同聚合方法,包括平均和聚类方案。密集朝向预测隐式地学习如何对付无遮挡且特征丰富的目标区域。下图是ConvPoseCNN的示意图:

如下图所示:从PoseCNN派生的ConvPoseCNN体系结构,从RGB图像预测每个目标的6D姿势。该网络从提取特征的VGG16的卷积主干开始。随后在三个分支中对它们进行处理:预测像素级语义分割的全卷积分割分支,预测中心朝向和深度像素级估计的全卷积顶点分支,以及四元数估计分支 。分割和顶点分支结果组合在一起,在Hough变换层中为目标中心投票。Hough变换层还预测检测目标的边框。然后,PoseCNN使用这些边框来裁剪和合并提取的特征,再将这些特征输入到全连接的神经网络体系结构中。该全连接部分预测每个边框的朝向四元数。

一些定性结果示例:

14.LatentFusion: End-to-End Differentiable Reconstruction and Rendering for Unseen Object Pose Estimation (2019.12)

当前的6D目标姿态估计方法通常需要为每个目标提供3D模型。这些方法还需要进行额外的训练才能合并新目标。结果,它们难以扩展到大量目标,并且不能直接应用于没见过的目标。

这项工作提出了一个没见过目标的6D姿态估计框架。它设计了端到端神经网络,该网络使用少量目标的参考视图来重建目标的潜在3D表示。用学习的3D表示,网络可以从任意视图渲染目标。使用该神经渲染器,可以根据输入图像直接优化姿势。通过使用大量3D形状训练网络进行重构和渲染,该网络可以很好地推广到没见过的目标。此外,它提出了一个用于没见过的物体姿态估计的数据集-MOPED(Model-free Object Pose Estimation Dataset)。

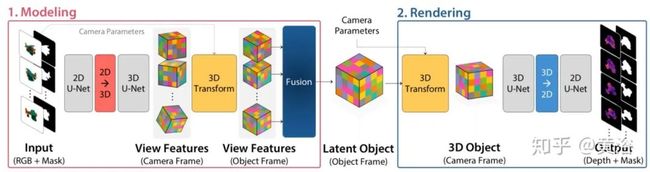

下图是其流水线结构图:

给定一组具有相关联的目标姿态和目标分割掩码的N个参考图像,它试图构建可以用任意相机参数渲染的目标表示。将目标表示为潜在的3D体素网格,可使用标准3D转换直接对其进行操作-自然地可以满足新视图渲染的要求。重建流水线有两个主要组件:1)通过预测每个视图的特征容量并将其融合为单个规范的潜在表示对目标建模;2)将潜在表示渲染为深度和彩色图像。

建模步骤的灵感来自于空间雕刻(space carving),因为该网络从多个视图中获取观察结果,并利用多视图一致性来构建规范表示。渲染模块获取融合的目标体积,并在给定任意相机参数的情况下对其进行渲染。首先进行深度渲染,然后使用基于图像的渲染方法来生成彩色图像,并通过神经网络保留高频细节。

下图是体系结构的高级概览:1)该建模网络获得图像和掩码,并预测每个输入视图的特征容量;然后,通过融合模块将预测的特征容量融合到单个规范的潜在目标中。2)给定潜在目标,渲染网络会为任何一个输出相机生成深度图和掩码。

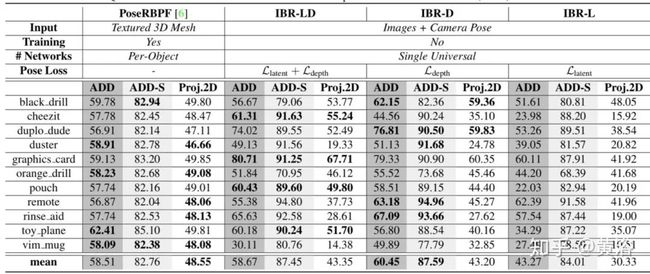

下面是一些模型性能的比较表格:

注:Ref[6] X Deng, A Mousavian, Y Xiang, F Xia, T Bretl, and D Fox. “PoseRBPF: A rao-blackwellized particle filter for 6D object pose tracking”. Robotics: Science and Systems (RSS), 2019.

15.HybridPose: 6D Object Pose Estimation under Hybrid Representations (2020.1)

HybridPose,一个6D目标姿态估计方法,利用混合中间表示在输入图像中表达不同的几何信息,包括关键点、边缘向量和对称对应关系。与单一表示相比,当一种类型的预测表示不准确时(例如,遮挡),混合表示允许姿势回归利用更多且多样化的特征。HybridPose利用强大的回归模块来滤除预测的中间表示中的异常值。可以通过相同的简单神经网络预测所有中间表示,而不会牺牲整体性能。与SOA姿势估计方法相比,HybridPose在运行时间上具有可比性,并且准确性更高。

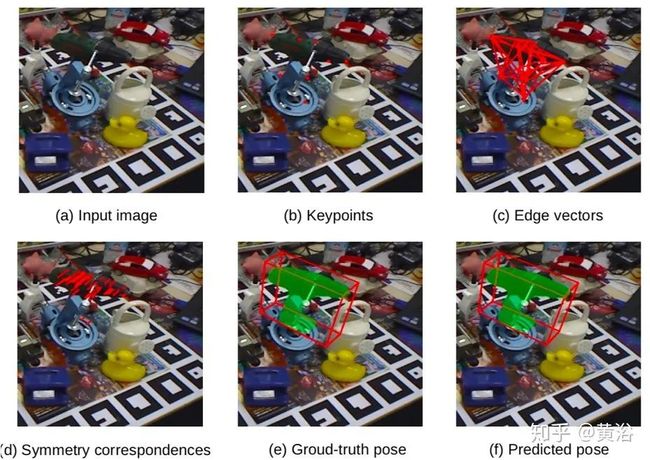

如图所示是HybridPose运行的直观图:(a)输入RGB图像;(b)红色标记表示预测的2D关键点;(c)边缘向量由所有关键点之间的完全连接图定义;(d)对称对应关系将目标上的每个2D像素连接到其对称的对应目标。

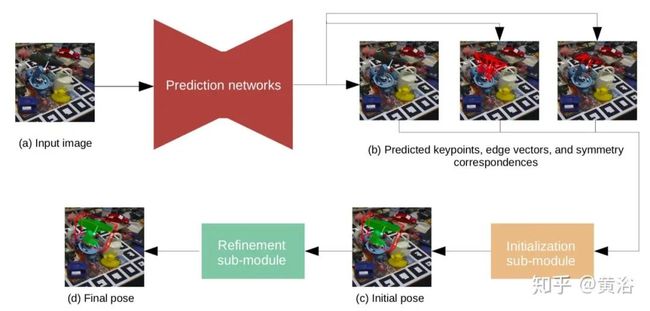

HybridPose的输入是包含已知类别目标的图像,假设该类目标具有规范的坐标系(即3D点云),在该坐标系下HybridPose输出图像目标的6D相机姿态。HybridPose由预测模块和姿势回归模块组成。HybridPose利用三个预测网络来估计一组关键点、一组关键点之间的边缘以及一组图像像素之间的对称对应关系。

关键点网络采用了现成的预测网络PVNet。边缘网络沿着预定义关键点图预测边缘向量,当关键点在输入的图像比较混乱时,这可以稳定姿势回归。对称网络(FlowNet 2.0的扩展)预测反映基本(部分)反射对称轴的对称对应。姿态回归模块优化目标的姿态适合三个预测网络的输出(如同遵循EPnP框架的P3P求解器)。如下图是其架构图:

下图结果展示遮挡的处理示例:

16.6DoF Object Pose Estimation via Differentiable Proxy Voting Loss (2020.2)

由于存在遮挡或缺少纹理,因此从单个图像估计6DOF目标姿势非常具有挑战性。基于矢量场的关键点投票已证明其在解决这些问题上的有效性和优越性。但是,矢量场的直接回归忽略了像素和关键点之间的距离也极大地影响了假设的偏差。换句话说,当像素远离关键点时,方向矢量的小误差可能会产生严重偏离的假设。

本文旨在通过将像素和关键点之间的距离纳入目标函数来减少此类误差。为此,它产生了可微分的代理投票损失(DPVL,differentiable proxy voting loss),该损失模拟了投票程序中的假设选择。利用投票损失,可以端到端的方式训练网络。

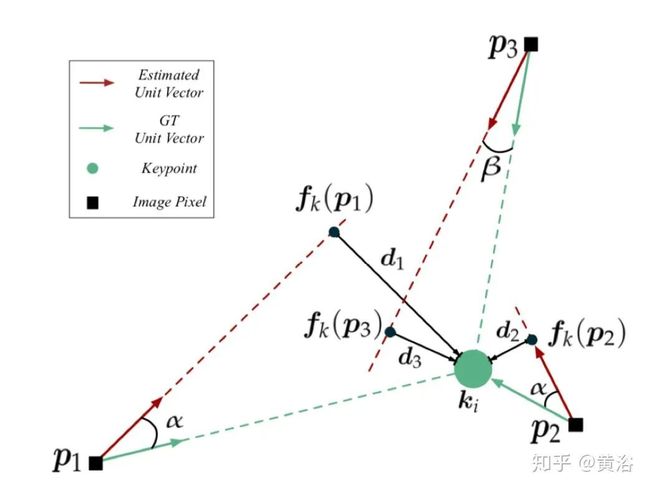

下图是DPVL示意图:假设方向矢量的估计误差相同(例如α),则像素与关键点之间的距离会影响假设与关键点之间的接近度。DPVL最小化代理假设fk(p⋆)与关键点ki之间的距离d⋆,以此实现关键点投票的准确假设。

下图所示是该系统的流水线图。这项工作着重于获得准确的初始姿态估计。特别是,此方法旨在精确定位和估计目标的朝向和平移而无需任何改进。目标姿态由从目标坐标系到摄像机坐标系的刚性转换表示。由于基于投票的方法已经证明了其对遮挡和视图更改的鲁棒性,因此这里采用基于投票的姿势估计流程。具体地,该方法首先从矢量场对目标关键点的2D位置进行投票,然后通过解决PnP问题来估计6DOF姿势。

以前工作采用L1-loss(损失函数类型)回归逐像素的矢量场。但是,矢量场中的小误差可能会导致假设的较大偏差误差,因为损失并未考虑像素与关键点之间的距离。因此,通过模拟投票过程中的假设选择,提供了可微分代理投票损失(DPVL)以减少此类错误。此外,得益于DPVL,网络可以更快地收敛。

最后展示的是一些结果例子:

END

声明:本文来源于网络

如有侵权,联系删除

联盟学术交流群

扫码添加联盟博士,可与相关学者研究人员共同交流学习:目前开设有人工智能、机器学习、计算机视觉、自动驾驶(含SLAM)、Python、求职面经、综合交流群扫描添加CV联盟微信拉你进群,备注:CV联盟

![]()

最新热文荐读

GitHub | 计算机视觉最全资料集锦

Github | 标星1W+清华大学计算机系课程攻略!

Github | 吴恩达新书《Machine Learning Yearning》

收藏 | 2020年AI、CV、NLP顶会最全时间表!

收藏 | 博士大佬总结的Pycharm 常用快捷键思维导图!

收藏 | 深度学习专项课程精炼图笔记!

笔记 | 手把手教你使用PyTorch从零实现YOLOv3

笔记 | 如何深入理解计算机视觉?(附思维导图)

笔记 | 深度学习综述思维导图(可下载)

笔记 | 深度神经网络综述思维导图(可下载)

总结 | 2019年人工智能+深度学习笔记思维导图汇总

![]()

点个在看支持一下吧![]()

![]()