手把手教你使用R语言做LASSO 回归

LASSO 回归也叫套索回归,是通过生成一个惩罚函数是回归模型中的变量系数进行压缩,达到防止过度拟合,解决严重共线性的问题,LASSO 回归最先由英国人Robert Tibshirani提出,目前在预测模型中应用非常广泛。在新格兰文献中,有大牛提出,对于变量过多而且变量数较少的模型拟合,首先要考虑使用LASSO 惩罚函数。今天我们来讲讲怎么使用R语言通过LASSO 回归构造预测模型。

首先我们要下载R的glmnet包,由 LASSO 回归的发明人,斯坦福统计学家 Trevor Hastie 领衔开发。

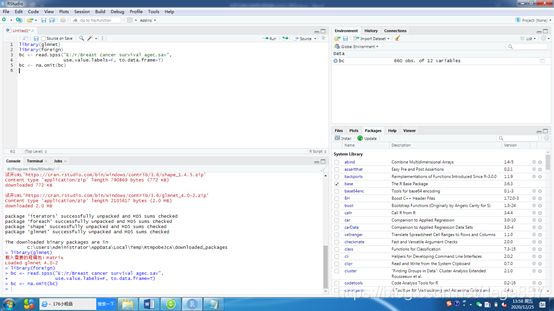

加载需要的包,导入数据(还是我们既往的SPSS乳腺癌数据),删除缺失值

library(glmnet)

library(foreign)

bc <- read.spss("E:/r/Breast cancer survival agec.sav",

use.value.labels=F, to.data.frame=T)

bc <- na.omit(bc)

目前,glmnet包只能接受矩阵形式的数据,数据框的数据会报错,所以我们先要把数据转换成矩阵形式,这一步很重要。

y<-as.matrix(bc[,8])

x<-as.matrix(bc[,c(2:7,9:11)])

通过转换后,我们得到了两个数据矩阵,Y是结果,X是数据的变量

开始构建模型

f1 = glmnet(x, y, family="binomial", nlambda=100, alpha=1) #这里alpha=1为LASSO回归,如果等于0就是岭回归

#参数 family 规定了回归模型的类型:

family="gaussian" 适用于一维连续因变量(univariate)

family="mgaussian" 适用于多维连续因变量(multivariate)

family="poisson" 适用于非负次数因变量(count)

family="binomial" 适用于二元离散因变量(binary)

family="multinomial" 适用于多元离散因变量(category)

我们这里结局指标是2分类变量,所以使用binomial

print(f1)#把f1结果输出

可以看到随着lambdas增加,自由度和残差减少,最小lambda为0.000233

输出图形

plot(f1, xvar="lambda", label=TRUE)

横坐标为随着lambdas的对数,纵坐标为变量系数,可以看到随着lambdas增加变量系数不断减少,部分变量系数变为0(等于没有这个变量了)

下面进行交叉验证

我们可以把数据集取一部分进行验证(这步不做也可以)

predict(f1, newx=x[2:5,], type = "response")

cvfit=cv.glmnet(x,y)

plot(cvfit)

我们这个图中有两条虚线,一个是均方误差最小时的λ值,一个是距离均方误差最小时一个标准误的λ值,有点拗口没关系,我们只要知道它是多少就可以了

cvfit$lambda.min#求出最小值

cvfit$lambda.1se#求出最小值一个标准误的λ值

l.coef2<-coef(cvfit$glmnet.fit,s=0.004174369,exact = F)

l.coef1<-coef(cvfit$glmnet.fit,s=0.04272596,exact = F)

l.coef1

l.coef2

我们看到第一个模型变量都没有了,第二个模型还有5个变量,因此就只能选第2个了。

我们把这几个系数拿出来组成广义线性方程,时间变量time懒得拿了(做示范而已,拿也是可以的)

mod<-glm(status~age+pathsize+lnpos+pr,family="binomial",data = bc)

summary(mod)