微信跳一跳好像火了很久了,我才开始接触,作为一个手残党, 玩了几次不到20分,打算直接放弃了。但作为一个技术宅,下一反应肯定是“上脚本”。最初想法是用arduino(不会可以学啊)+树梅派,树梅派用OpenCV处理摄像头,读取手机屏幕,判断跳跃距离,发命令给arduino控制机械手臂(触控笔),任务完成。但问题来了

- 不会arduino,也没有arduino和触控笔。

- 没有树梅派用的摄像头。

- 不会OpenCV

arduino控制触控笔,估计很麻烦,但同时肯定很有意思。就算入手arduino,学会控制机械手臂,难度好像是整个程序中最难的。然后退一步,用adb给屏幕发送模拟触屏命令,暂时解决第一部分。树梅派的摄像头也要买,暂时用笔记本摄像头代替(把手机举在摄像头前真的很二),再退一步,用adb截屏读取图像,处理图像比视频流要简单些。然后开始作,哎,我肯定不是第一个想到这些的,去搜搜,果然就找到了这里3。具体做法是:

- 用adb读取游戏截屏

- 根据颜色差判断棋子和下一跳棋盘的位置。计算两点之间的距离

- 找到合适的参数,得到屏幕按压时间,用adb把命令发过去。

这里最关键的地方是判断棋子和下一跳棋盘的位置,因为最初就是要用上OpenCV,他人处理颜色的代码看了两眼觉得太麻烦就直接放弃了。所以这篇日志的最主要的地方就是怎么用OpenCV找到这两个点。

从最开始写这个脚本到开始写个记录,不断搜索到新的方法来找这两个点。最近的发现2, 这里用了Tensorflow,对此代码我还理解不能。我打算放弃写这篇记录,认真看看TF。 转念一想,我的方法虽然没有其他人的高大上,也没什么效率,但总算是一种解决方式,所以还是记下来吧。

OpenCV的全称是Open Source Computer Vision Library,是一个跨平台的计算机视觉库,可用于开发实时的图像处理、计算机视觉以及模式识别程序1。听介绍就知道用在这里很合适。根据OpenCV的官方教程4, 初步确定寻找所需的两个点的方法:

- 将图像的色彩空间由RGB转换HSV

- 确定图形边缘及轮廓

- 假定其中一个轮廓的中心就是所需的点。

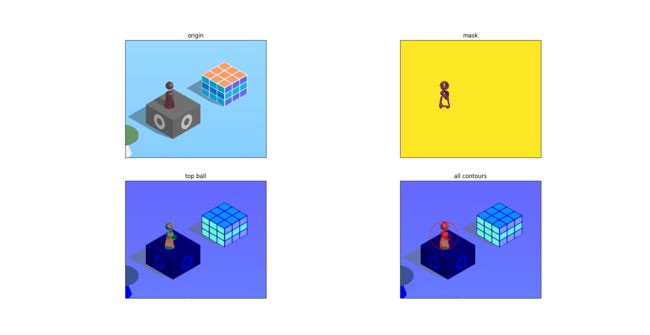

为什么要把色彩空间转化为HSV,而不是使用原始的RGB或者灰度? 据说HSV比RGB能更好的处理颜色,处理一个值H比三个RGB要简单,饱和度S和明度V能帮助处理光照和阴影。下图可以看出,只有转成HSV色彩空间的在后面的处理中可以正确的检测到方块的顶面边缘,同样的阈值条件下,RGB模式对顶面和右侧面的边缘检测能力较弱,灰度模式下顶面和两个侧面都分不清楚。而降噪处理在这张图没什么明显的变化,但对于有些图像--比如有木头纹理的桌子--还是有帮助的,所以需要保留,高斯模糊应该就足够了,Bilateral Filtering is highly effective in noise removal while keeping edges sharp. But the operation is slower compared to other filters, 所以没必要。

根据上面的图,即便有了边缘点,得到很多个轮廓的中心,仍然无法确定哪个中心点是棋子。根据经验,发现棋子总是某种黑紫色,而不论是下一跳的棋盘或者背景都不会跟这种颜色相近,所以根据颜色特征找到棋子更简单。所以接下来就是找到这个颜色值的上下限,面向Google编程,我找到了别人的一个方法,自己修改后放gist。

def get_start_point(image):

chess = image.copy()

blurred = cv2.GaussianBlur(chess, (3, 3), 1)

mask = cv2.inRange(blurred, lower_purple, upper_purple)

mask_1 = cv2.inRange(blurred, lower_purple_1, upper_purple_1)

masked = cv2.bitwise_and(blurred, blurred, mask=mask+mask_1)

chess_edges = cv2.Canny(masked, 100, 200)

thresh = cv2.adaptiveThreshold(

chess_edges,

255,

cv2.ADAPTIVE_THRESH_GAUSSIAN_C,

cv2.THRESH_BINARY,

7,

1)

_, cnts, _ = cv2.findContours(

thresh, cv2.RETR_CCOMP, cv2.CHAIN_APPROX_SIMPLE)

cs = list()

for cnt in cnts:

(x, y), r = cv2.minEnclosingCircle(cnt)

r = int(r)

# print(r)

if 25 < r < 40:

cs.append((int(x), int(y)))

mx = min(cs, key=operator.itemgetter(1))

return mx

边缘检测函数就是上面的Canny(),该方法的参数有三个,第一个是要处理的图像,后两个是阈值的上下限。Canny之前的是标准的选取颜色方法。有了边缘值再用adaptiveThreshold函数进行二值化处理,然后用findContours寻找棋子的轮廓, 轮廓(Contour)在这里其实就是一系列边缘点的列表,根据这些点就可以计算轮廓的很多特性,比如形状,面积等,OpenCV有很多函数帮助处理这些特性, 在这里可以用boundingRect(包括了所有轮廓点的长方形),minEnclosingCircle(包括了所有轮廓点的圆)或 moments(轮廓的几何重心),。因为棋盘顶了个球,并且minEnclosingCircle同时返回圆心坐标和半径,在这里最合适不过了。由于findContours是返回的所有轮廓,很是杂乱,如图右下里的红圈,所以要过滤下,根据半径过滤是最直接的想法,因为球的半径可以测出来,在1080p的屏幕上大概为30个像素。这样就能得到球心坐标了,如同左下的绿圈,注意:1. 即使过滤后也可能有多个坐标,这里取最上面的,就是mx = min(cs, key=operator.itemgetter(1))。2.这个坐标不是起始点的坐标,起始点应该为棋子底部圆心,y坐标应加上120px(图的左上为坐标原点)。

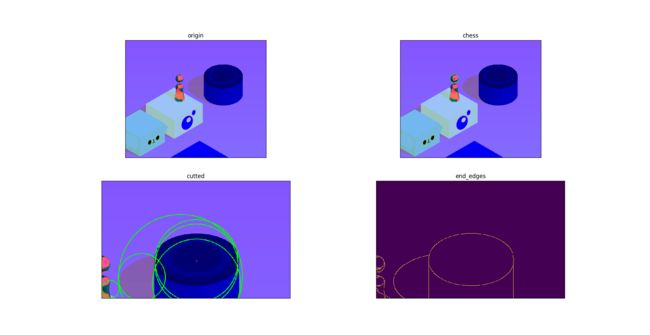

有了棋子的位置坐标,接下来就是找到下一跳的棋盘的顶部中心坐标了,方法大概是这样的:如果前一跳正好落在了当前棋盘的中心,下一跳棋盘的中心会有个白点(这样每一跳的分数也会递增,朋友圈排行上数k的分数都是外挂刷来的),只要找到这个白点就ok了。寻找这个白点跟找棋子一样也是通过颜色特征white_dot = np.array([0, 0, 245])。但没有这个白点之前还是要用检测边缘的办法,然后计算棋盘的顶面中心,如果没有噪音,这个方法和直接找到白点坐标应该是一样的,如果没有噪音。处理图像的步骤还是一样,有个细节可以减少计算量:棋子和下一跳的棋盘总是在屏幕中心的两侧,利用这点可以把棋盘从图上挖出来

def get_end_point(image, start_point):

global half_width

global cutted

cutted = image.copy()

if start_point[0] < half_width:

#棋子在屏幕左侧,取棋子坐标右侧的图

cutted = cutted[0:start_point[1] +

chess_height, start_point[0]+chess_width:]

else:

cutted = cutted[0:start_point[1] +

chess_height, :start_point[0]-chess_width]

w_dot = _get_end_dot(cutted)

if w_dot is None:

print("get by edges")

w_dot = _get_end_by_edges(cutted)

x, y = w_dot

### 最后得到坐标要还原回去

if start_point[0] < half_width:

x += start_point[0]+chess_width

return (x, y)

上面_get_end_dot()跟get_start_point类似,_get_end_by_edges是在没找到白点的情况下的笨方法,_get_ul方法来自这里。findContours方法也和前面不太一样,返回轮廓的同时还返回了轮廓的层次结构,因为只需要内侧的轮廓,用ch[2] < 0过滤出来。关于这个的 解释。 最后还要处理一部分噪音造成的太小的轮廓圆及整个棋盘+阴影造成的太大的圆。

def _get_ul(c, sigma=0.15):

l = int(max(0, (1.0 - sigma) * c))

u = int(min(255, (1.0 + sigma) * c))

return (l, u)

def _get_end_by_edges(image):

image = cv2.GaussianBlur(image, (1, 1), 0)

bg = image[:20, :]

mid = np.median(bg)

l, u = _get_ul(mid)

end_edges = cv2.Canny(image, l, u)

end_thresh = cv2.adaptiveThreshold(

end_edges,

255,

cv2.ADAPTIVE_THRESH_GAUSSIAN_C,

cv2.THRESH_BINARY,

5,

1)

_, cnts, hierarchy = cv2.findContours(

end_thresh, cv2.RETR_CCOMP, cv2.CHAIN_APPROX_SIMPLE)

hierarchy = hierarchy[0]

ms = list()

for cpnt in zip(cnts, hierarchy):

cnt = cpnt[0]

ch = cpnt[1]

if ch[2] < 0:

(x, y), r = cv2.minEnclosingCircle(cnt)

r = int(r)

# print(r)

if 25 < r < 230:

ms.append((int(x), int(y)))

mx = min(ms, key=operator.itemgetter(1))

return mx

利用检测边缘的方法寻找中心点的效果如下:单色且形状规则些的可以找到正中心或偏差不大。奇形怪状的连能不能跳到上面都不保证。

主要方法就是这些了,整个代码可以去我的 gist查看。整个代码还是会有些问题,有些能改进的地方,但是作为一个演示程序应该够了。我测试了几次,都没到1k,汗。但是不管跑多少分,都会遇到下图(当然我的历史最高分也是脚本跑了,只是当时还没有现在的外挂检测),反正除了测试改进代码,我是不会用这个跑分了。

如果有兴趣,我可能会增加点关于python的环境配置。