#论文笔记# ——《Multiway Attention Networks for Modeling Sentence Pairs》

《Multiway Attention Networks for Modeling Sentence Pairs》

Chuanqi Tany, FuruWei, Wenhui Wang, Weifeng Lv, Ming Zhou

IJCAI 2018

句子建模是自然语言处理中一个十分重要的任务,对句子建模后可以用以判断两个句子的关系,在文本蕴含识别、句子相似度计算、自动问答系统等任务中都经常用到。该文 [ ^[ [ 1 ^1 1 ] ^] ]是发表在IJCAI2018会议上的一篇论文,文章主要使用多种注意力机制来对句子建模,多个实验表明,该文所提出的方法在多个句子级别的任务上可以达到state-of-art的效果。

1. Introduction

1.1 任务描述

\quad 大多数句子级别上的任务都可以描述成为三元组的形式:

\quad 特定地,

\quad \quad 针对“复述识别”(Paraphrase Identification)任务, γ = { 0 , 1 } \gamma=\{0,1\} γ={ 0,1},其中 y = 1 y=1 y=1表示句子Q和P是可复述的, y = 0 y=0 y=0则表示不可复述;

\quad \quad 针对“蕴含识别”(Natural Language Inference)任务, γ = { e n t a i l m e n t , c o n t r a d i c t i o n , n e u t r a l } \gamma=\{entailment, contradiction, neutral\} γ={ entailment,contradiction,neutral},其中entailment表示句子Q蕴含句子P,即句子P可以由Q推出,contradiction表示在句子Q出现的条件下句子P是不可能出现的,即矛盾关系,neutral表示句子Q和P是不相关的;

\quad \quad 针对自动问答领域中“答案句子选择”(Answer sentence selection)任务, γ = { 0 , 1 } \gamma=\{0,1\} γ={ 0,1},1表示答案P是问题Q的答案,0则不是。

1.2 两个方向

- 句子编码

\quad \quad 这类方法的主要思想是把句子Q和P单独输入一个句子编码器,分别生成固定长度的一个句子向量,再使用这两个句子向量来完成某些操作以达到任务目的。

\quad \quad 基于句子编码的方法易于设计和实现,但是最大的缺点是两个句子在编码的过程中没有任何的交互,所以后续也有学者提出在句子编码层添加一层attention层,相当于重新对句子向量加权,突出相似部分和相异部分,以提高任务效果,但是这种方法无论如何都很难解决词语级别上的交互问题。 - 句子交互

\quad \quad 这类是在基于句子编码类方法之后提出的,目的正是为了解决上类方法中难以解决词语级别上交互的问题,这类方法的常用手段就是在词向量或者单词隐层向量中加入一个句子交互层(一般是各种attention)来加强在单词级别上的语义匹配,实现更小粒度上的语义识别。

\quad \quad 基于句子交互的方法是一个更新的思路,这类方法强调句子建模需要在不同粒度上进行,而不同的粒度上也会有不同的匹配机制。

1.3 论文动机

\quad 论文动机主要有两个:

\quad \quad 第一个是注意力机制(attention mechanism)在前人工作中展现出非常好的效果;

\quad \quad 第二个是虽然现在有很多模型在单词级别上的交互已经做得很好,但是作者任务单词级别上的交互对于句子建模十分重要;

\quad 所以,作者希望融合多种注意力机制,来增强在句子建模过程中单词级别上的交互。

2. Related works

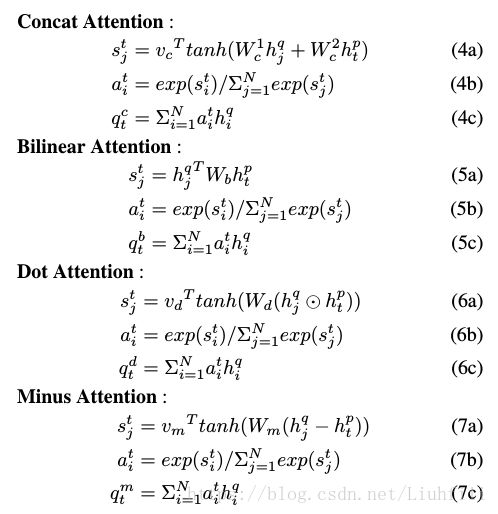

\quad \quad 在论文提出的方法中,主要使用了4中不同的注意力机制模型,在相关工作这一部分就简要介绍一下这4中注意力机制模型的出处,其他略过。

- 1 Concatenated attention [ ^[ [ 2 ^2 2 ] ^] ]

- 2 Bilinear attention [ ^[ [ 3 ^3 3 ] ^] ]

- 3 Dot attention [ ^[ [ 4 ^4 4 ] ^] ]

- 4 Minus attention [ ^[ [ 5 ^5 5 ] ^] ]

3. Proposed Approach

- 模型概览

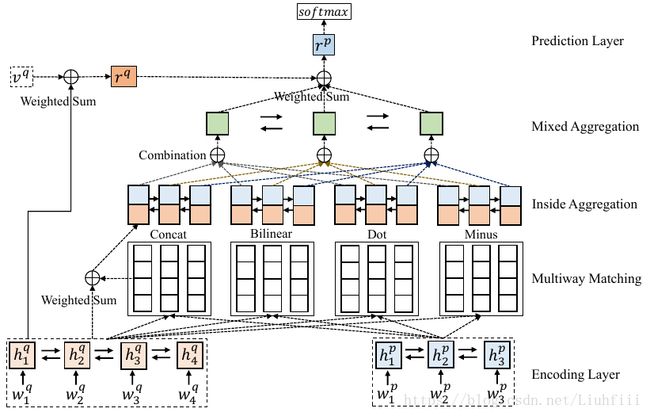

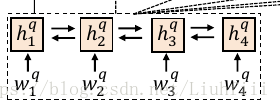

\quad \quad 该模型分为5层,分别是Encoding Layer, Multiway Matching Layer, Inside Aggregation Layer, Mixed Aggregation Layer和Prediction Layer。

\quad \quad 给定两个句子,模型首先用一个Bi-RNN对句子做上下文编码,然后使用4种不同的注意力机制对上下文向量进行加权编码,编码后的向量会输入到一个聚集层(这里分成了两层),聚集层的第一层是使用Bi-RNN对每个编码后的向量进行再一次的编码,第二层也是使用Bi-RNN将上层的向量编码层指定维度的向量。下面详细描述每一层的工作机制。 - Encoding Layer

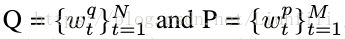

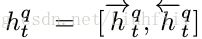

\quad \quad 这一次目的是将原始的单词转换成词向量,然后再将词向量输入到一个双向GRU内,完成对句子上下文的编码:

\quad \quad 值得注意的是,该文除了使用常用的Glove词向量外,还使用了一种ELMo词向量,该层具体公式如图所示:

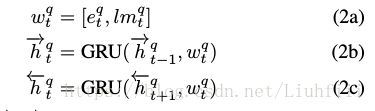

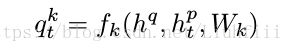

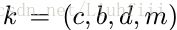

- Multiway Matching Layer

该层是整个模型的核心层,4个不同的注意力机制函数就是在里出现的,这一层的主要作用是完成两个句子的在单词级别上的交互,4中不同的注意力机制函数具体计算公式如下图所示:

- Inside Aggregation Layer

- Mixed Aggregation Layer

- Prediction Layer

4. Experiments

[1] Tan, C., Wei, F., Wang, W., Lv, W., & Zhou, M. (2018). Multiway Attention Networks for Modeling Sentence Pairs. In IJCAI (pp. 4411-4417).

Rocktäschel, T., Grefenstette, E., Hermann, K. M., Kočiský, T., & Blunsom, P. (2015). Reasoning about entailment with neural attention. arXiv preprint arXiv:1509.06664.

Chen, D., Bolton, J., & Manning, C. D. (2016). A thorough examination of the cnn/daily mail reading comprehension task. arXiv preprint arXiv:1606.02858.

Wang, S., & Jiang, J. (2016). A compare-aggregate model for matching text sequences. arXiv preprint arXiv:1611.01747.