环境信息

-购买操作系统选择centos7(7的任何一个版本都可以),如果选错了可以在阿里云管理面板的-更多--云盘和镜像--更换操作系统。

在阿里云购买ecs-购买后机器网卡环境:

公网IP-8.134.80.143、内网IP-172.30.40.95

设置阿里云端口映射:

开放1个端口

9092:kafka调用端口

配置入口-->安全组-->配置规则

点击手动添加,添加9092端口

开始安装

安装zookeeper

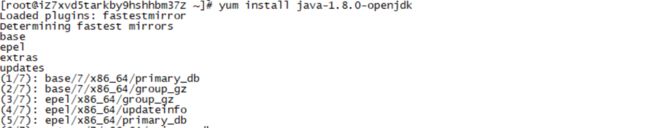

安装jdk

yum install java-1.8.0-openjdk

安装完成后可以进行zookeeper安装。

下载解压zookeeper

登陆服务器,下载zookeeper

wget https://mirrors.tuna.tsinghua.edu.cn/apache/zookeeper/zookeeper-3.6.2/apache-zookeeper-3.6.2-bin.tar.gz

tar -zxf apache-zookeeper-3.6.2-bin.tar.gz

cp -r apache-zookeeper-3.6.2-bin /usr/local/zookeeper

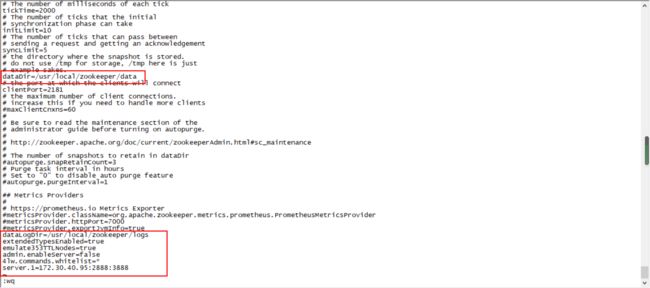

修改zookeeper配置文件

cp /usr/local/zookeeper/conf/zoo_sample.cfg /usr/local/zookeeper/conf/zoo.cfg

vim /usr/local/zookeeper/conf/zoo.cfg

修改1处(172.30.40.95为阿里云内网地址)

dataDir=/usr/local/zookeeper/data

末尾添加6行:

dataLogDir=/usr/local/zookeeper/logs

extendedTypesEnabled=true

emulate353TTLNodes=true

admin.enableServer=false

4lw.commands.whitelist=*

server.1=172.30.40.95:2888:3888

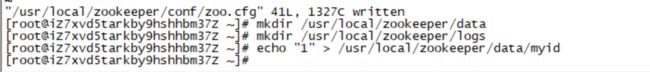

创建zookeeper目录

mkdir /usr/local/zookeeper/data

mkdir /usr/local/zookeeper/logs

创建id文件

echo "1" > /usr/local/zookeeper/data/myid

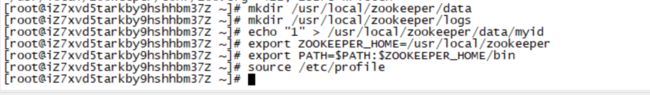

添加环境变量

export ZOOKEEPER_HOME=/usr/local/zookeeper

export PATH=$PATH:$ZOOKEEPER_HOME/bin

环境变量生效

source /etc/profile

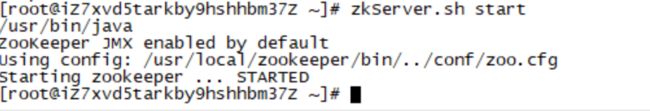

启动

zkServer.sh start

测试zookeeper

zkCli.sh -server localhost:2181

按ctrl+c 回到控制台,继续安装kafka

安装kafka

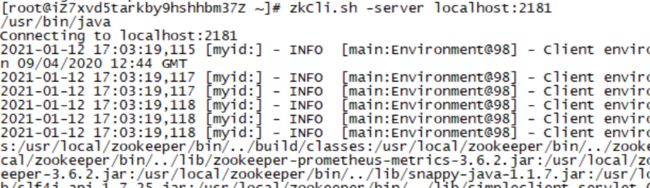

下载解压kafka

wget https://mirrors.tuna.tsinghua.edu.cn/apache/kafka/2.6.0/kafka_2.12-2.6.0.tgz

解压

tar -zxf kafka_2.12-2.6.0.tgz

cp -r kafka_2.12-2.6.0 /usr/local/kafka

修改kafka配置文件

vim /usr/local/kafka/config/server.properties

修改3处(8.134.80.143为阿里云的公网ip地址,如果只是服务器内网调用,这里配置内网地址就可以了 ):

listeners=PLAINTEXT://0.0.0.0:9092

advertised.listeners=PLAINTEXT://8.134.80.143:9092

log.dirs=/usr/local/kafka/logs

创建kafka目录

mkdir /usr/local/kafka/logs

添加环境变量

export KAFKA_HOME=/usr/local/kafka

export PATH=$PATH:$KAFKA_HOME/bin

source /etc/profile

启动kafka

(停止脚本是:/usr/local/kafka/bin/kafka-server-stop.sh)

/usr/local/kafka/bin/kafka-server-start.sh -daemon /usr/local/kafka/config/server.properties

image.png

image.png

创建Topic

kafka 的topic相当于对数据的一个分类,不同topic对数据会进行分开存储。

(replication-factor 1 是指一个节点,我们这里没有建多个机器,所有这里就是1 ,partitions 3 会存到3个文件,如果不需要分开可以直接填1,topic mykafka,这个 mykafka是名称,调用会用到,代表存储到哪个topic里面)

kafka-topics.sh --create --zookeeper localhost:2181 --replication-factor 1 --partitions 3 --topic mykafka

image.png

image.png

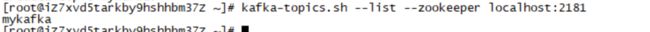

查看已经创建的topic列表

kafka-topics.sh --list --zookeeper localhost:2181

image.png

image.png

服务端的搭建就完成了,现在本机idea里面引入kafka来进行调用。

springboot 引入初始化

添加依赖

pom增加依赖(org.projectlombok.lombok这个引入是日志打印用的,实际引入org.springframework.kafka.spring-kafka就可以了)

org.springframework.kafka

spring-kafka

org.projectlombok

lombok

1.18.10

创建消息发送类-SendController

内容(mykafka时topic的名字,与服务器上创建的topic对应):

import lombok.extern.slf4j.Slf4j;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.kafka.core.KafkaTemplate;

import org.springframework.web.bind.annotation.RequestMapping;

import org.springframework.web.bind.annotation.RestController;

@Slf4j

@RestController

public class SendController {

@Autowired

private KafkaTemplate kafkaSend;

@RequestMapping("kafkaSend")

public String send(String info){

log.info(info);

kafkaSend.send("mykafka", info);

return "发送成功";

}

}

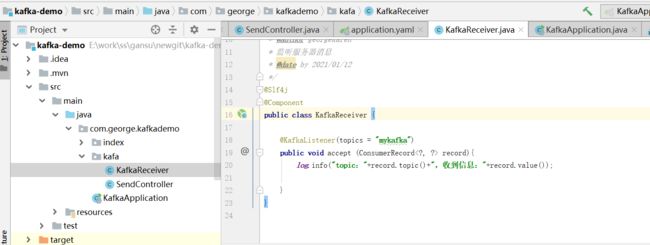

创建消息接收类-KafkaReceiver

内容(这个类代表客户端接收信息,mykafka是服务器上创建的topic名字,所有所有监听了mykafka这个topic的客户端都能收到消息):

import lombok.extern.slf4j.Slf4j;

import org.apache.kafka.clients.consumer.ConsumerRecord;

import org.springframework.kafka.annotation.KafkaListener;

import org.springframework.stereotype.Component;

/**

* @author georgekaren

* 监听服务器消息

* @date by 2021/01/12

*/

@Slf4j

@Component

public class KafkaReceiver {

@KafkaListener(topics = "mykafka")

public void accept (ConsumerRecord record){

log.info("topic:"+record.topic()+",收到信息:"+record.value());

}

}

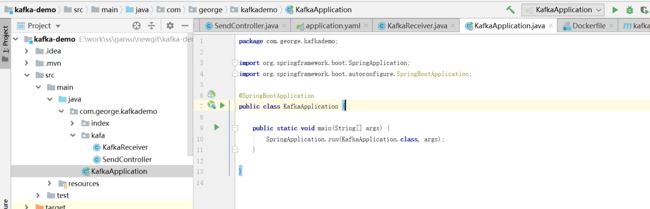

创建启动类-KafkaApplication

内容:

import org.springframework.boot.SpringApplication;

import org.springframework.boot.autoconfigure.SpringBootApplication;

@SpringBootApplication

public class KafkaApplication {

public static void main(String[] args) {

SpringApplication.run(KafkaApplication.class, args);

}

}

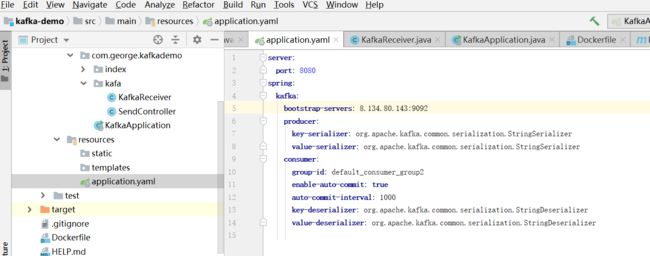

配置kafka配置信息-application.yaml

(地址:8.134.80.143是阿里云的公网地址-与kafka配置的server.properties文件配置的地址对应)

spring:

kafka:

bootstrap-servers: 8.134.80.143:9092

producer:

key-serializer: org.apache.kafka.common.serialization.StringSerializer

value-serializer: org.apache.kafka.common.serialization.StringSerializer

consumer:

group-id: default_consumer_group2

enable-auto-commit: true

auto-commit-interval: 1000

key-deserializer: org.apache.kafka.common.serialization.StringDeserializer

value-deserializer: org.apache.kafka.common.serialization.StringDeserializer

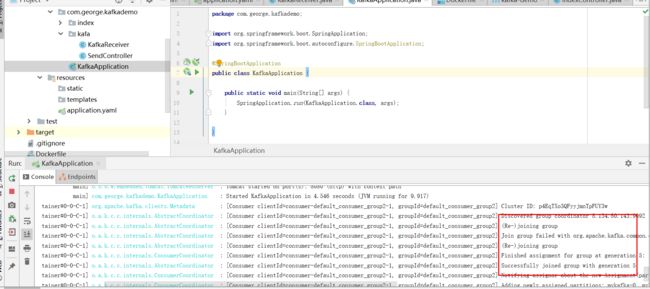

启动spring boot-连接kafka

图中显示连接成功(如果连接失败会显示异常信息)

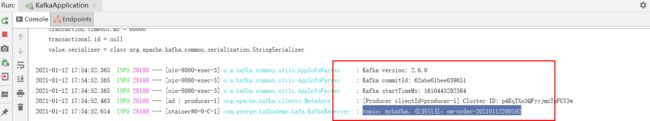

发送数据测试

浏览器打开:http://localhost:8080/kafkaSend?info=om-order-20210112200192

发送一个工单号测试一下。

(逻辑:通过浏览器调用kafkaSend接口时后端调用kafka服务端发送数据,服务端给客户端推送数据,本地KafkaReceiver接收数据并打印)

浏览器端:

客户端:

topic:mykafka,收到信息:om-order-20210112200192

完成。