【机器学习的数学基础】(四)解析几何(Analytic Geometry)(上)

文章目录

-

- 3 解析几何(Analytic Geometry)(上)

-

- 3.1 范数

- 3.2 内积

-

- 3.2.1 点积

- 3.2.2 一般内积

- 3.2.3 对称正定矩阵

- 3.3 长度和距离

- 3.4 角度和正交

- 3.5 标准正交基

- 3.6 正交补

- 3.7 函数的内积

3 解析几何(Analytic Geometry)(上)

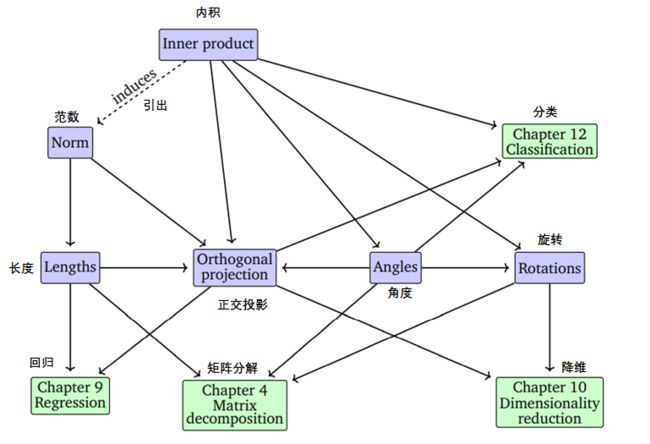

在第二章中,我们在一般但抽象的层次上研究了向量、向量空间和线性映射。在本章中,我们将为所有这些概念添加一些几何解释和直观感觉。特别地,我们会研究几何向量并计算它们的长度和距离或者两个向量之间的夹角。为了能够做到这一点,我们在向量空间中加入了内积这一概念,从而引出向量空间的几何形状。从内积及其相应的范数和度量可以得到相似性和距离的直观概念,我们在第十二章中的支持向量机将使用到这些概念。然后,我们将使用向量之间的长度和角度的概念来讨论正交投影,这将在第10章讨论主成分分析以及第9章通过最大似然估计回归时发挥核心作用。图3.1概述了本章的概念是如何关联的,以及它们是如何与本书的其他章节相联系的。

图3.1本章介绍的概念的思维导图,以及它们在书的其他部分的应用。

3.1 范数

对于几何向量,即从原点开始的有向线段,直观地说,它的长度是有向线段的“终点”到原点的距离。下面,我们将用范数来讨论向量长度这一概念。

定义 3.1 范数

向量空间 V V V的范数是一个指定每个向量 x \boldsymbol{x} x的长度的函数

∥ ⋅ ∥ : V → R x ↦ ∥ x ∥ \begin{aligned}\|\cdot\|: V & \rightarrow \mathbb{R} \\\boldsymbol{x} & \mapsto\|\boldsymbol{x}\|\end{aligned} ∥⋅∥:Vx→R↦∥x∥

并且对于任何 λ ∈ R \lambda \in \mathbb{R} λ∈R以及 x , y ∈ V \boldsymbol{x}, \boldsymbol{y} \in V x,y∈V,以下成立:

-

绝对一次齐次性(Absolutely homogeneous): ∥ λ x ∥ = ∣ λ ∣ ∥ x ∥ \|\lambda \boldsymbol{x}\|=|\lambda|\|\boldsymbol{x}\| ∥λx∥=∣λ∣∥x∥

-

三角不等式(Triangle inequality): ∥ x + y ∥ ⩽ ∥ x ∥ + ∥ y ∥ \|\boldsymbol{x}+\boldsymbol{y}\| \leqslant\|\boldsymbol{x}\|+\|\boldsymbol{y}\| ∥x+y∥⩽∥x∥+∥y∥

-

正定性(Positive definite): ∥ x ∥ ⩾ 0 and ∥ x ∥ = 0 ⟺ x = 0 \|\boldsymbol{x}\| \geqslant 0 \text { and }\|\boldsymbol{x}\|=0 \Longleftrightarrow \boldsymbol{x}=\mathbf{0} ∥x∥⩾0 and ∥x∥=0⟺x=0

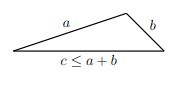

在几何中,三角形不等式指出,对于任何三角形,任意两条边的长度之和必须大于或等于另一条边的长度;如图3.2。

图 3.2三角不等式

定义3.1是关于一般的向量空间 V V V(2.4节),但在本书中我们只考虑有限维向量空间 R n \mathbb{R}^{n} Rn。对于向量 x ∈ R n \boldsymbol{x} \in \mathbb{R}^{n} x∈Rn,我们用下标表示向量的元素,也就是说, x i x_i xi是向量 x \boldsymbol{x} x的第 i i i个元素。

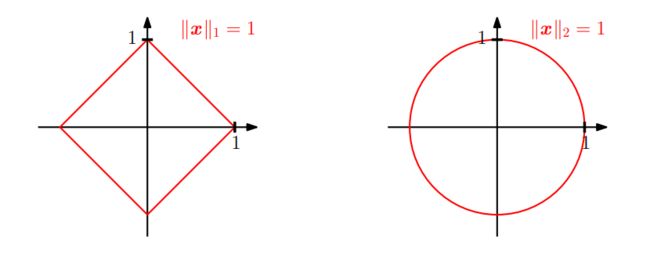

图3.3 红线表示两种不同范数为1的向量集合。左:曼哈顿范数;右:欧氏距离。

例 3.1 曼哈顿范数(Manhattan Norm)

x ∈ R n \boldsymbol{x} \in \mathbb{R}^{n} x∈Rn的曼哈顿范数定义为:

∥ x ∥ 1 : = ∑ i = 1 n ∣ x i ∣ \|\boldsymbol{x}\|_{1}:=\sum_{i=1}^{n}\left|x_{i}\right| ∥x∥1:=i=1∑n∣xi∣

∣ ⋅ ∣ |\cdot | ∣⋅∣表示绝对值。图3.3左边的图展示了所有 ∥ x ∥ 1 = 1 \|x\|_{1}=1 ∥x∥1=1的向量 x ∈ R 2 x \in \mathbb{R}^{2} x∈R2。曼哈顿范数也称为 ℓ 1 \ell_{1} ℓ1范数。

例 3.2 欧几里得范数(Euclidean Norm)

x ∈ R n \boldsymbol{x} \in \mathbb{R}^{n} x∈Rn的欧几里得范数定义为:

∥ x ∥ 2 : = ∑ i = 1 n x i 2 = x ⊤ x \|x\|_{2}:=\sqrt{\sum_{i=1}^{n} x_{i}^{2}}=\sqrt{x^{\top} x} ∥x∥2:=i=1∑nxi2=x⊤x

它计算 x \boldsymbol{x} x与原点的欧几里得距离(Euclidean distance)。

图3.3右边的图展示了所有 ∥ x ∥ 2 = 1 \|\boldsymbol{x}\|_{2}=1 ∥x∥2=1的向量 x ∈ R 2 \boldsymbol{x} \in \mathbb{R}^{2} x∈R2,欧几里得范数也称为 ℓ 2 \ell_{2} ℓ2范数.

备注:

下文中,如果没有另外说明,我们将使默认用欧几里德范数。

3.2 内积

内积可以引入一些直观的几何概念,例如向量的长度和两个向量之间的角度或距离。内积的一个主要目的是确定向量之间是否正交。

3.2.1 点积

我们可能已经熟悉了一种特殊类型的内积, R n \mathbb{R}^{n} Rn中的标量积/点积(scalar product/dot product):

x ⊤ y = ∑ i = 1 n x i y i ( 3.5 ) \boldsymbol{x}^{\top} \boldsymbol{y}=\sum_{i=1}^{n} x_{i} y_{i}\qquad(3.5) x⊤y=i=1∑nxiyi(3.5)

在这本书中,我们将把这种特殊的内积称为点积。但是,内积是具有特定性质的更一般的概念,我们现在将介绍这些概念。

3.2.2 一般内积

回想一下2.7节中的线性映射,我们可以重新排列与标量的相加和乘相相关的映射。而双线性映射(bilinear mapping) Ω \Omega Ω是有两个参数的的映射,且对于每个参数它都是线性的,即对于 x , y , z ∈ V , λ , ψ ∈ R \boldsymbol{x}, \boldsymbol{y}, \boldsymbol{z} \in V, \lambda, \psi \in \mathbb{R} x,y,z∈V,λ,ψ∈R,有:

Ω ( λ x + ψ y , z ) = λ Ω ( x , z ) + ψ Ω ( y , z ) \Omega(\lambda \boldsymbol{x}+\psi \boldsymbol{y}, \boldsymbol{z})=\lambda \Omega(\boldsymbol{x}, \boldsymbol{z})+\psi \Omega(\boldsymbol{y}, \boldsymbol{z}) Ω(λx+ψy,z)=λΩ(x,z)+ψΩ(y,z)

Ω ( x , λ y + ψ z ) = λ Ω ( x , y ) + ψ Ω ( x , z ) \Omega(\boldsymbol{x}, \lambda \boldsymbol{y}+\psi \boldsymbol{z})=\lambda \Omega(\boldsymbol{x}, \boldsymbol{y})+\psi \Omega(\boldsymbol{x}, \boldsymbol{z}) Ω(x,λy+ψz)=λΩ(x,y)+ψΩ(x,z)

这里,第一个式子表明 Ω Ω Ω关于第一个参数中是线性的,第二个式子表明 Ω Ω Ω关于第二个参数中是线性的。

定义 3.2

令 V V V为向量空间, Ω : V × V → R \Omega: V \times V \rightarrow \mathbb{R} Ω:V×V→R为双线性映射,它取 V V V中的两个向量并将它们映射到一个实数,那么:

- 对于所有 x , y ∈ V \boldsymbol{x}, \boldsymbol{y} \in V x,y∈V,如果 Ω ( x , y ) = Ω ( y , x ) \Omega(\boldsymbol{x}, \boldsymbol{y})=\Omega(\boldsymbol{y}, \boldsymbol{x}) Ω(x,y)=Ω(y,x),则称 Ω \Omega Ω为对称的( symmetric),即参数的顺序没有影响。

- 如果 ∀ x ∈ V \ { 0 } : Ω ( x , x ) > 0 , Ω ( 0 , 0 ) = 0 \forall \boldsymbol{x} \in V \backslash\{\boldsymbol{0}\}: \Omega(\boldsymbol{x}, \boldsymbol{x})>0, \quad \Omega(\mathbf{0}, \mathbf{0})=0 ∀x∈V\{ 0}:Ω(x,x)>0,Ω(0,0)=0,则 Ω \Omega Ω称为正定的(positive definite)

定义 3.3

使 V V V为向量空间, Ω : V × V → R \Omega: V \times V \rightarrow \mathbb{R} Ω:V×V→R为双线性映射,它取 V V V中的两个向量并将它们映射到一个实数,那么:

- 一个正定且对称的双线性映射 Ω : V × V → R \Omega: V \times V \rightarrow \mathbb{R} Ω:V×V→R称为 V V V上的内积(inner produc),我们通常写成 ⟨ x , y ⟩ \langle\boldsymbol{x}, \boldsymbol{y}\rangle ⟨x,y⟩而不是 Ω ( x , y ) \Omega(\boldsymbol{x}, \boldsymbol{y}) Ω(x,y)。

- ( V , ⟨ ⋅ , ⋅ ⟩ ) (V,\langle\cdot, \cdot\rangle) (V,⟨⋅,⋅⟩)称为内积空间或带内积的(实)向量空间。如果我们以点积为内积,则我们称 ( V , ⟨ ⋅ , ⋅ ⟩ ) (V,\langle\cdot, \cdot\rangle) (V,⟨⋅,⋅⟩)为欧氏向量空间(Euclidean vector space)。

在书中,我们将这些空间称为内积空间。

例 3.3 非点积的内积

考虑 V = R 2 V=\mathbb{R}^{2} V=R2,我们定义

⟨ x , y ⟩ : = x 1 y 1 − ( x 1 y 2 + x 2 y 1 ) + 2 x 2 y 2 \langle\boldsymbol{x}, \boldsymbol{y}\rangle:=x_{1} y_{1}-\left(x_{1} y_{2}+x_{2} y_{1}\right)+2 x_{2} y_{2} ⟨x,y⟩:=x1y1−(x1y2+x2y1)+2x2y2

其中 ⟨ ⋅ , ⋅ ⟩ \langle\cdot, \cdot\rangle ⟨⋅,⋅⟩为非点积的内积。

3.2.3 对称正定矩阵

对称正定矩阵在机器学习中起着重要的作用,它们是通过内积定义的。在4.3节矩阵分解中将涉及到对称正定矩阵。对称半正定矩阵的思想也是机器学习中核技巧的关键(12.4节)。

考虑一个 n n n维向量空间 V V V和内积: ⟨ ⋅ , ⋅ ⟩ : V × V → R \langle\cdot, \cdot\rangle:V \times V \rightarrow \mathbb{R} ⟨⋅,⋅⟩:V×V→R(见定义3.3)以及 V V V的有序基础 B = ( b 1 , … , b n ) B=\left(\boldsymbol{b}_{1}, \ldots, \boldsymbol{b}_{n}\right) B=(b1,…,bn)。对于合适的 ψ i , λ j ∈ R \psi_{i}, \lambda_{j} \in \mathbb{R} ψi,λj∈R,任何向量 x , y ∈ V \boldsymbol{x}, \boldsymbol{y} \in V x,y∈V都可以写成基向量的线性组合: x = ∑ i = 1 n ψ i b i ∈ V \boldsymbol{x}=\sum_{i=1}^{n} \psi_{i} \boldsymbol{b}_{i} \in V x=∑i=1nψibi∈V和 y = ∑ j = 1 n λ j b j ∈ V \boldsymbol{y}=\sum_{j=1}^{n} \lambda_{j} \boldsymbol{b}_{j} \in V y=∑j=1nλjbj∈V。由于内积的双线性,对于所有 x , y ∈ V \boldsymbol{x}, \boldsymbol{y} \in V x,y∈V,有:

⟨ x , y ⟩ = ⟨ ∑ i = 1 n ψ i b i , ∑ j = 1 n λ j b j ⟩ = ∑ i = 1 n ∑ j = 1 n ψ i ⟨ b i , b j ⟩ λ j = x ^ ⊤ A y ^ \langle\boldsymbol{x}, \boldsymbol{y}\rangle=\left\langle\sum_{i=1}^{n} \psi_{i} \boldsymbol{b}_{i}, \sum_{j=1}^{n} \lambda_{j} \boldsymbol{b}_{j}\right\rangle=\sum_{i=1}^{n} \sum_{j=1}^{n} \psi_{i}\left\langle\boldsymbol{b}_{i}, \boldsymbol{b}_{j}\right\rangle \lambda_{j}=\hat{\boldsymbol{x}}^{\top} \boldsymbol{A} \hat{\boldsymbol{y}} ⟨x,y⟩=⟨i=1∑nψibi,j=1∑nλjbj⟩=i=1∑nj=1∑nψi⟨bi,bj⟩λj=x^⊤Ay^

以 n = 2 n=2 n=2为例,

⟨ ∑ i = 1 2 ψ i b i , ∑ j = 1 2 λ j b j ⟩ = ⟨ ψ 1 b 1 + ψ 2 b 2 , λ 1 b 1 + λ 2 b 2 ⟩ = ψ 1 ⟨ b 1 , λ 1 b 1 + λ 2 b 1 ⟩ + ψ 2 ⟨ b 2 , λ 1 b 1 + λ 2 b 1 ⟩ \left\langle\sum_{i=1}^{2} \psi_{i} \boldsymbol{b}_{i}, \sum_{j=1}^{2} \lambda_{j} \boldsymbol{b}_{j}\right\rangle=\left\langle \psi_1\boldsymbol{b}_1+\psi_2\boldsymbol{b}_2 , \lambda_1\boldsymbol{b}_1+\lambda_2\boldsymbol{b}_2\right\rangle=\psi_1\left\langle \boldsymbol{b}_1, \lambda_1\boldsymbol{b}_1+\lambda_2\boldsymbol{b}_1\right\rangle + \psi_2\left\langle \boldsymbol{b}_2, \lambda_1\boldsymbol{b}_1+\lambda_2\boldsymbol{b}_1\right\rangle ⟨i=1∑2ψibi,j=1∑2λjbj⟩=⟨ψ1b1+ψ2b2,λ1b1+λ2b2⟩=ψ1⟨b1,λ1b1+λ2b1⟩+ψ2⟨b2,λ1b1+λ2b1⟩

= ψ 1 [ λ 1 ⟨ b 1 , b 1 ⟩ + λ 2 ⟨ b 1 , b 2 ⟩ ] + ψ 2 [ λ 1 ⟨ b 2 , b 1 ⟩ + λ 2 ⟨ b 2 , b 2 ⟩ ] =\psi_1[\lambda_1\left\langle \boldsymbol{b}_1,\boldsymbol{b}_1 \right\rangle+\lambda_2\left\langle \boldsymbol{b}_1,\boldsymbol{b}_2 \right\rangle]+\psi_2[\lambda_1\left\langle \boldsymbol{b}_2,\boldsymbol{b}_1 \right\rangle+\lambda_2\left\langle \boldsymbol{b}_2,\boldsymbol{b}_2 \right\rangle] =ψ1[λ1⟨b1,b1⟩+λ2⟨b1,b2⟩]+ψ2[λ1⟨b2,b1⟩+λ2⟨b2,b2⟩]

= [ ψ 1 , ψ 2 ] [ λ 1 ⟨ b 1 , b 1 ⟩ + λ 2 ⟨ b 1 , b 2 ⟩ λ 1 ⟨ b 2 , b 1 ⟩ + λ 2 ⟨ b 2 , b 2 ⟩ ] =[\psi_1,\psi_2]\left[\begin{array}{l}\lambda_1\left\langle \boldsymbol{b}_1,\boldsymbol{b}_1 \right\rangle+\lambda_2\left\langle \boldsymbol{b}_1,\boldsymbol{b}_2 \right\rangle \\\lambda_1\left\langle \boldsymbol{b}_2,\boldsymbol{b}_1 \right\rangle+\lambda_2\left\langle \boldsymbol{b}_2,\boldsymbol{b}_2 \right\rangle\end{array}\right] =[ψ1,ψ2][λ1⟨b1,b1⟩+λ2⟨b1,b2⟩λ1⟨b2,b1⟩+λ2⟨b2,b2⟩]

= [ ψ 1 , ψ 2 ] [ ⟨ b 1 , b 1 ⟩ + ⟨ b 1 , b 2 ⟩ ⟨ b 2 , b 1 ⟩ + ⟨ b 2 , b 2 ⟩ ] [ λ 1 λ 2 ] =[\psi_1,\psi_2]\left[\begin{array}{l}\left\langle \boldsymbol{b}_1,\boldsymbol{b}_1 \right\rangle+\left\langle \boldsymbol{b}_1,\boldsymbol{b}_2 \right\rangle \\\left\langle \boldsymbol{b}_2,\boldsymbol{b}_1 \right\rangle+\left\langle \boldsymbol{b}_2,\boldsymbol{b}_2 \right\rangle\end{array}\right]\left[\begin{array}{l}\lambda_1\\\lambda_2\end{array}\right] =[ψ1,ψ2][⟨b1,b1⟩+⟨b1,b2⟩⟨b2,b1⟩+⟨b2,b2⟩][λ1λ2]

其中 A i j : = ⟨ b i , b j ⟩ A_{i j}:=\left\langle\boldsymbol{b}_{i}, \boldsymbol{b}_{j}\right\rangle Aij:=⟨bi,bj⟩, x ^ , y ^ \hat{\boldsymbol{x}}, \hat{\boldsymbol{y}} x^,y^为 x \boldsymbol{x} x和 y \boldsymbol{y} y相对于基 B B B的坐标。这意味着 ⟨ ⋅ , ⋅ ⟩ \langle\cdot, \cdot\rangle ⟨⋅,⋅⟩是由 A \boldsymbol{A} A唯一确定的。由于内积是对称的,所以 A \boldsymbol{A} A也是对称的。此外,内积的正定性意味着

∀ x ∈ V \ { 0 } : x ⊤ A x > 0 \forall x \in V \backslash\{\mathbf{0}\}: \boldsymbol{x}^{\top} \boldsymbol{A} \boldsymbol{x}>0 ∀x∈V\{ 0}:x⊤Ax>0

定义 3.4 对称正定矩阵

满足 ∀ x ∈ V \ { 0 } : x ⊤ A x > 0 \forall x \in V \backslash\{\mathbf{0}\}: \boldsymbol{x}^{\top} \boldsymbol{A} \boldsymbol{x}>0 ∀x∈V\{ 0}:x⊤Ax>0的对称矩阵称为对称正定的(symmetric, positive definite)或只称它为正定的(positive definite)。如果 ∀ x ∈ V \ { 0 } : x ⊤ A x ≥ 0 \forall x \in V \backslash\{\mathbf{0}\}: \boldsymbol{x}^{\top} \boldsymbol{A} \boldsymbol{x}\ge0 ∀x∈V\{ 0}:x⊤Ax≥0,则称 A \boldsymbol{A} A为对称半正定的(symmetric, positive semidefinite.)。

例 3.4 对称,正定矩阵

考虑矩阵

A 1 = [ 9 6 6 5 ] , A 2 = [ 9 6 6 3 ] \boldsymbol{A}_{1}=\left[\begin{array}{ll}9 & 6 \\6 & 5\end{array}\right], \quad \boldsymbol{A}_{2}=\left[\begin{array}{ll}9 & 6 \\6 & 3\end{array}\right] A1=[9665],A2=[9663]

A 1 \boldsymbol{A}_{1} A1为正定的,因为对于 x ∈ V \ { 0 } \boldsymbol{x} \in V \backslash\{\mathbf{0}\} x∈V\{ 0},它是对称的且

x ⊤ A 1 x = [ x 1 x 2 ] [ 9 6 6 5 ] [ x 1 x 2 ] = 9 x 1 2 + 12 x 1 x 2 + 5 x 2 2 = ( 3 x 1 + 2 x 2 ) 2 + x 2 2 > 0 \begin{aligned}\boldsymbol{x}^{\top} \boldsymbol{A}_{1} \boldsymbol{x} &=\left[\begin{array}{ll}x_{1} & x_{2}\end{array}\right]\left[\begin{array}{l}9 & 6 \\6 & 5\end{array}\right]\left[\begin{array}{l}x_{1} \\x_{2}\end{array}\right] \\&=9 x_{1}^{2}+12 x_{1} x_{2}+5 x_{2}^{2}=\left(3 x_{1}+2 x_{2}\right)^{2}+x_{2}^{2}>0\end{aligned} x⊤A1x=[x1x2][9665][x1x2]=9x12+12x1x2+5x22=(3x1+2x2)2+x22>0

而 A 2 \boldsymbol{A}_{2} A2仅仅是对称的,它不是正定的,因为 x ⊤ A 2 x = 9 x 1 2 + 12 x 1 x 2 + 3 x 2 2 = ( 3 x 1 + 2 x 2 ) 2 − x 2 2 \boldsymbol{x}^{\top} \boldsymbol{A}_{2} \boldsymbol{x}=9 x_{1}^{2}+12 x_{1} x_{2}+3 x_{2}^{2}=\left(3 x_{1}+2 x_{2}\right)^{2}-x_{2}^{2} x⊤A2x=9x12+12x1x2+3x22=(3x1+2x2)2−x22可能小于0,例如当 x = [ 2 , − 3 ] ⊤ \boldsymbol{x}=[2,-3]^{\top} x=[2,−3]⊤时。

如果 A ∈ R n × n \boldsymbol{A} \in \mathbb{R}^{n \times n} A∈Rn×n是对称,正定的,那么:

⟨ x , y ⟩ = x ^ ⊤ A y ^ \langle\boldsymbol{x}, \boldsymbol{y}\rangle=\hat{\boldsymbol{x}}^{\top} \boldsymbol{A} \hat{\boldsymbol{y}} ⟨x,y⟩=x^⊤Ay^

定义了关于有序基 B B B的内积, x ^ , y ^ \hat{\boldsymbol{x}},\hat{\boldsymbol{y}} x^,y^为 x , y {\boldsymbol{x}},{\boldsymbol{y}} x,y相对于基 B B B的坐标。

定理 3.5 对于一个实值,有限维向量空间 V V V和 V V V的一个有序基 B B B, ⟨ ⋅ , ⋅ ⟩ : V × V → R \langle\cdot, \cdot\rangle: V \times V \rightarrow \mathbb{R} ⟨⋅,⋅⟩:V×V→R为一个内积当且仅当存在一个对称的,正定矩阵 A ∈ R n × n \boldsymbol{A} \in \mathbb{R}^{n \times n} A∈Rn×n使得

⟨ x , y ⟩ = x ^ ⊤ A y ^ \langle\boldsymbol{x}, \boldsymbol{y}\rangle=\hat{\boldsymbol{x}}^{\top} \boldsymbol{A} \hat{\boldsymbol{y}} ⟨x,y⟩=x^⊤Ay^

如果 A ∈ R n × n \boldsymbol{A} \in \mathbb{R}^{n \times n} A∈Rn×n是对称且正定的,那么它有以下属性:

- A \boldsymbol{A} A的零空间(核)只由 0 \boldsymbol{0} 0组成,因为对于所有 x ≠ 0 \boldsymbol{x}\not=\boldsymbol{0} x=0, x ⊤ A x > 0 \boldsymbol{x}^{\top} \boldsymbol{A} \boldsymbol{x}>0 x⊤Ax>0,这意味着如果 x ≠ 0 \boldsymbol{x}\not=\boldsymbol{0} x=0,那么 A x ≠ 0 \boldsymbol{A}\boldsymbol{x}\not=\boldsymbol{0} Ax=0

- A \boldsymbol{A} A的对角元素 a i i a_{ii} aii是正的,因为 a i i = e i ⊤ A e i > 0 a_{i i}=\boldsymbol{e}_{i}^{\top} \boldsymbol{A} \boldsymbol{e}_{i}>0 aii=ei⊤Aei>0,其中 e i e_i ei为 R n \mathbb{R}^{n} Rn标准基的第 i i i个向量。

3.3 长度和距离

在3.1节中,我们已经讨论了可以用来计算向量长度的范数。内积与范数密切相关,因为任何内积都自然地引出范数

∥ x ∥ : = ⟨ x , x ⟩ \|\boldsymbol{x}\|:=\sqrt{\langle\boldsymbol{x}, \boldsymbol{x}\rangle} ∥x∥:=⟨x,x⟩

这使得我们就可以用内积来计算向量的长度。然而,并不是每一个范数都是由内积引起的。曼哈顿范数是没有相应内积的的一种范数。在下面,我们将集中讨论由内积导出的范数,并介绍一些几何概念,如长度、距离和角度。

备注:柯西-施瓦兹不等式

对于一个内积向量空间 ( V , ⟨ ⋅ , ⋅ ⟩ ) (V,\langle\cdot, \cdot\rangle) (V,⟨⋅,⋅⟩),其引出的范数 ∥ ⋅ ∥ \|\cdot\| ∥⋅∥满足柯西-施瓦兹不等式(Cauchy-Schwarz Inequality):

∣ ⟨ x , y ⟩ ∣ ⩽ ∥ x ∥ ∥ y ∥ |\langle\boldsymbol{x}, \boldsymbol{y}\rangle| \leqslant\|\boldsymbol{x}\|\|\boldsymbol{y}\| ∣⟨x,y⟩∣⩽∥x∥∥y∥

例 3.5:内积求向量长度

在几何学中,我们经常对向量的长度感兴趣。我们现在可以使用内积 ∥ x ∥ : = ⟨ x , x ⟩ \|\boldsymbol{x}\|:=\sqrt{\langle\boldsymbol{x}, \boldsymbol{x}\rangle} ∥x∥:=⟨x,x⟩来计算它们。我们取 x = [ 1 , 1 ] ⊤ ∈ R 2 \boldsymbol{x}=[1, 1]^{\top} \in \mathbb{R}^{2} x=[1,1]⊤∈R2。如果我们使用点积作为内积,我们可以得到 x \boldsymbol{x} x的长度:

∥ x ∥ = x ⊤ x = 1 2 + 1 2 = 2 \|\boldsymbol{x}\|=\sqrt{\boldsymbol{x}^{\top} \boldsymbol{x}}=\sqrt{1^{2}+1^{2}}=\sqrt{2} ∥x∥=x⊤x=12+12=2

让我们选择一个不同的内积:

⟨ x , y ⟩ : = x ⊤ [ 1 − 1 2 − 1 2 1 ] y = x 1 y 1 − 1 2 ( x 1 y 2 + x 2 y 1 ) + x 2 y 2 \langle\boldsymbol{x}, \boldsymbol{y}\rangle:=\boldsymbol{x}^{\top}\left[\begin{array}{cc}1 & -\frac{1}{2} \\-\frac{1}{2} & 1\end{array}\right] \boldsymbol{y}=x_{1} y_{1}-\frac{1}{2}\left(x_{1} y_{2}+x_{2} y_{1}\right)+x_{2} y_{2} ⟨x,y⟩:=x⊤[1−21−211]y=x1y1−21(x1y2+x2y1)+x2y2

当我们计算向量的范数时,如果向量的元素 x 1 x_1 x1和 x 2 x_2 x2有相同的符号( x 1 x 2 > 0 x_1x_2\gt0 x1x2>0),那么这个内积返回的值比点积小;否则,它返回的值比点积大。通过这个内积,我们代入[1,1]得到:

⟨ x , x ⟩ = x 1 2 − x 1 x 2 + x 2 2 = 1 − 1 + 1 = 1 ⟹ ∥ x ∥ = 1 = 1 \langle\boldsymbol{x}, \boldsymbol{x}\rangle=x_{1}^{2}-x_{1} x_{2}+x_{2}^{2}=1-1+1=1 \Longrightarrow\|\boldsymbol{x}\|=\sqrt{1}=1 ⟨x,x⟩=x12−x1x2+x22=1−1+1=1⟹∥x∥=1=1

这样计算得到的 x \boldsymbol{x} x的长度比点积的“短”。

定义 3.6 距离和度量

考虑一个内积空间 ( V , ⟨ ⋅ , ⋅ ⟩ ) (V,\langle\cdot, \cdot\rangle) (V,⟨⋅,⋅⟩),对于任意 x , y ∈ V \boldsymbol{x}, \boldsymbol{y} \in V x,y∈V:

d ( x , y ) : = ∥ x − y ∥ = ⟨ x − y , x − y ⟩ d(\boldsymbol{x}, \boldsymbol{y}):=\|\boldsymbol{x}-\boldsymbol{y}\|=\sqrt{\langle\boldsymbol{x}-\boldsymbol{y}, \boldsymbol{x}-\boldsymbol{y}\rangle} d(x,y):=∥x−y∥=⟨x−y,x−y⟩

称为 x \boldsymbol{x} x和 y \boldsymbol{y} y的距离(distance )。如果我们用点积作为内积,则该距离称为欧几里得距离(Euclidean distance)。映射

d : V × V → R ( x , y ) ↦ d ( x , y ) \begin{aligned}d: V \times V & \rightarrow \mathbb{R} \\(\boldsymbol{x}, \boldsymbol{y}) & \mapsto d(\boldsymbol{x}, \boldsymbol{y})\end{aligned} d:V×V(x,y)→R↦d(x,y)

称为度量(metric)

备注:

与向量的长度类似,向量之间的距离不需要使用到其他内积:一般的范数就足够了。如果我们有一个由内积引出的范数,距离可能会因内积的不同而不同。

度量 d d d满足:

- 1、 d d d是正定的,即对于任意 x , y ∈ V \boldsymbol{x}, \boldsymbol{y} \in V x,y∈V, d ( x , y ) ⩾ 0 d(\boldsymbol{x}, \boldsymbol{y}) \geqslant 0 d(x,y)⩾0,且 d ( x , y ) = 0 ⟺ x = y d(\boldsymbol{x}, \boldsymbol{y})=0 \Longleftrightarrow \boldsymbol{x}=\boldsymbol{y} d(x,y)=0⟺x=y

- 2、 d d d是对称的,即对于任意 x , y ∈ V \boldsymbol{x}, \boldsymbol{y} \in V x,y∈V, d ( x , y ) = d ( y , x ) d(\boldsymbol{x}, \boldsymbol{y})=d(\boldsymbol{y}, \boldsymbol{x}) d(x,y)=d(y,x)

- 3、 三角不等式:对于 x , y , z ∈ V \boldsymbol{x}, \boldsymbol{y}, \boldsymbol{z} \in V x,y,z∈V, d ( x , z ) ⩽ d ( x , y ) + d ( y , z ) d(\boldsymbol{x}, \boldsymbol{z}) \leqslant d(\boldsymbol{x}, \boldsymbol{y})+d(\boldsymbol{y}, \boldsymbol{z}) d(x,z)⩽d(x,y)+d(y,z)

备注:

乍一看,内积和度量的一系列属性看起来非常相似。然而,通过比较定义3.3和定义3.6,我们发现 ⟨ x , y ⟩ \langle\boldsymbol{x}, \boldsymbol{y}\rangle ⟨x,y⟩和 d ( x , y ) d(\boldsymbol{x}, \boldsymbol{y}) d(x,y)的表现是相反的:非常相似的 x \boldsymbol{x} x和 y \boldsymbol{y} y,其内积值较大而度量值很小(因为度量涉及两个向量相减)。

3.4 角度和正交

除了能够定义向量的长度以及两个向量之间的距离之外,内积还能通过计算两个向量之间的角度 ω ω ω来得到向量空间的几何结构。我们利用Cauchy-Schwarz不等式来定义两个向量 x \boldsymbol{x} x和 y \boldsymbol{y} y之间在内积空间中的夹角 ω ω ω,这个概念与我们在 R 2 \mathbb{R}^{2} R2和 R 3 \mathbb{R}^{3} R3中的直观感觉相吻合。假设 x ≠ 0 , y ≠ 0 \boldsymbol{x} \neq \mathbf{0}, \boldsymbol{y} \neq \mathbf{0} x=0,y=0。那么

− 1 ⩽ ⟨ x , y ⟩ ∥ x ∥ ∥ y ∥ ⩽ 1 -1 \leqslant \frac{\langle\boldsymbol{x}, \boldsymbol{y}\rangle}{\|\boldsymbol{x}\|\|\boldsymbol{y}\|} \leqslant 1 −1⩽∥x∥∥y∥⟨x,y⟩⩽1

因此,存在唯一的 ω ∈ [ 0 , π ] \omega \in[0, \pi] ω∈[0,π],使得:

cos ω = ⟨ x , y ⟩ ∥ x ∥ ∥ y ∥ ( 3.25 ) \cos \omega=\frac{\langle\boldsymbol{x}, \boldsymbol{y}\rangle}{\|\boldsymbol{x}\|\|\boldsymbol{y}\|}\qquad (3.25) cosω=∥x∥∥y∥⟨x,y⟩(3.25)

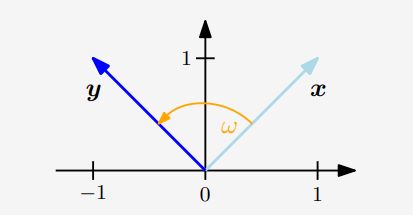

如图3.4所示。

图3.4对于 w ∈ [ 0 , π ] w\in[0,\pi] w∈[0,π], f ( x ) = cos ( w ) f(x)=\cos(w) f(x)=cos(w)返回 [ − 1 , 1 ] [-1,1] [−1,1]区间内唯一对应的值。

ω ω ω的值是向量 x \boldsymbol{x} x和 y \boldsymbol{y} y之间的角度(angle)。直观地说,两个向量之间的夹角告诉我们它们的方向有多相似。例如,使用点积情况下, x \boldsymbol{x} x和 y = 4 x \boldsymbol{y}=4\boldsymbol{x} y=4x之间的角度为0:它们的方向相同,即 y \boldsymbol{y} y是 x \boldsymbol{x} x的缩放版本。

图3.5用内积计算两个向量 x \boldsymbol{x} x, y \boldsymbol{y} y之间的角度 ω ω ω。

例 3.6 向量间的角度

让我们以点积作为内积计算 x = [ 1 , 1 ] ⊤ ∈ R 2 \boldsymbol{x}=[1,1]^{\top} \in \mathbb{R}^{2} x=[1,1]⊤∈R2, y = [ 1 , 2 ] ⊤ ∈ R 2 \boldsymbol{y}=[1,2]^{\top} \in \mathbb{R}^{2} y=[1,2]⊤∈R2的夹角,见图3.5。

cos ω = ⟨ x , y ⟩ ⟨ x , x ⟩ ⟨ y , y ⟩ = x ⊤ y x ⊤ x y ⊤ y = 3 10 \cos \omega=\frac{\langle\boldsymbol{x}, \boldsymbol{y}\rangle}{\sqrt{\langle\boldsymbol{x}, \boldsymbol{x}\rangle\langle\boldsymbol{y}, \boldsymbol{y}\rangle}}=\frac{\boldsymbol{x}^{\top} \boldsymbol{y}}{\sqrt{\boldsymbol{x}^{\top} \boldsymbol{x} \boldsymbol{y}^{\top} \boldsymbol{y}}}=\frac{3}{\sqrt{10}} cosω=⟨x,x⟩⟨y,y⟩⟨x,y⟩=x⊤xy⊤yx⊤y=103

则两个向量之间的角度为 ( 3 10 ) ≈ 0.32 r a d \left(\frac{3}{\sqrt{10}}\right) \approx 0.32 \mathrm{rad} (103)≈0.32rad,大约 18 ° 18° 18°

内积的一个关键特征是它还允许我们将向量描述为正交的(orthogonal)。

定义 3.7正交性

两个向量 x \boldsymbol{x} x和 y \boldsymbol{y} y是正交( orthogonal)当且仅当 ⟨ x , y ⟩ = 0 \langle\boldsymbol{x}, \boldsymbol{y}\rangle=0 ⟨x,y⟩=0,写成 x ⊥ y \boldsymbol{x}\perp\boldsymbol{y} x⊥y。若 ∥ x ∥ = 1 = ∥ y ∥ \|\boldsymbol{x}\|=1=\|\boldsymbol{y}\| ∥x∥=1=∥y∥即向量为单位向量,则 x \boldsymbol{x} x和 y \boldsymbol{y} y为标准正交的( orthonormal)

这个定义表明 0 \boldsymbol{0} 0向量与向量空间中的每个向量正交。

图 3.6两个向量 x x x, y y y之间的角度 ω ω ω取决于内积的选择。

例 3.7 正交向量

考虑图3.6两个向量 x = [ 1 , 1 ] ⊤ , y = [ − 1 , 1 ] ⊤ ∈ R 2 \boldsymbol{x}=[1,1]^{\top}, \boldsymbol{y}=[-1,1]^{\top} \in \mathbb{R}^{2} x=[1,1]⊤,y=[−1,1]⊤∈R2。我们来用两个不同的内积来确定它们之间的角 ω ω ω。使用点积作为内积, x \boldsymbol{x} x和 y \boldsymbol{y} y之间的角 ω ω ω为90°,因此 x ⊥ y \boldsymbol{x}\perp\boldsymbol{y} x⊥y。但是,如果我们选择内积

⟨ x , y ⟩ = x ⊤ [ 2 0 0 1 ] y \langle\boldsymbol{x}, \boldsymbol{y}\rangle=\boldsymbol{x}^{\top}\left[\begin{array}{ll}2 & 0 \\0 & 1\end{array}\right] \boldsymbol{y} ⟨x,y⟩=x⊤[2001]y

我们得到 x \boldsymbol{x} x和 y \boldsymbol{y} y之间的角度 ω ω ω由以下式子给出:

cos ω = ⟨ x , y ⟩ ∥ x ∥ ∥ y ∥ = − 1 3 ⟹ ω ≈ 1.91 r a d ≈ 109. 5 ∘ \cos \omega=\frac{\langle\boldsymbol{x}, \boldsymbol{y}\rangle}{\|\boldsymbol{x}\|\|\boldsymbol{y}\|}=-\frac{1}{3} \Longrightarrow \omega \approx 1.91 \mathrm{rad} \approx 109.5^{\circ} cosω=∥x∥∥y∥⟨x,y⟩=−31⟹ω≈1.91rad≈109.5∘

可以得到 x \boldsymbol{x} x和 y \boldsymbol{y} y不是正交的。因此,关于一种内积正交的向量不一定关于其他内积正交。

定义 3.8正交矩阵

方阵 A ∈ R n × n \boldsymbol{A} \in \mathbb{R}^{n \times n} A∈Rn×n为正交矩阵当且仅当它的列是标准正交的,即

A A ⊤ = I = A ⊤ A \boldsymbol{A} \boldsymbol{A}^{\top}=\boldsymbol{I}=\boldsymbol{A}^{\top} \boldsymbol{A} AA⊤=I=A⊤A

这意味着通过简单的转置就可以得到正交矩阵的逆矩阵。

A − 1 = A ⊤ \boldsymbol{A}^{-1}=\boldsymbol{A}^{\top} A−1=A⊤

正交矩阵变换是特殊的,因为向量 x \boldsymbol{x} x在用正交矩阵 A \boldsymbol{A} A对其变换时,向量的长度是不变的。以点积为内积,我们可以得到:

∥ A x ∥ 2 = ( A x ) ⊤ ( A x ) = x ⊤ A ⊤ A x = x ⊤ I x = x ⊤ x = ∥ x ∥ 2 \|\boldsymbol{A} \boldsymbol{x}\|^{2}=(\boldsymbol{A} \boldsymbol{x})^{\top}(\boldsymbol{A} \boldsymbol{x})=\boldsymbol{x}^{\top} \boldsymbol{A}^{\top} \boldsymbol{A} \boldsymbol{x}=\boldsymbol{x}^{\top} \boldsymbol{I} \boldsymbol{x}=\boldsymbol{x}^{\top} \boldsymbol{x}=\|\boldsymbol{x}\|^{2} ∥Ax∥2=(Ax)⊤(Ax)=x⊤A⊤Ax=x⊤Ix=x⊤x=∥x∥2

此外,使用正交矩阵 A \boldsymbol{A} A对任意两个向量 x , y \boldsymbol{x},\boldsymbol{y} x,y进行变换,使用内积测量变换前后向量间的角度是不变的。假设内积为点积,则像 A x \boldsymbol{Ax} Ax和像 A y \boldsymbol{Ay} Ay之间的角度如下所示:

cos ω = ( A x ) ⊤ ( A y ) ∥ A x ∥ ∥ A y ∥ = x ⊤ A ⊤ A y x ⊤ A ⊤ A x y ⊤ A ⊤ A y = x ⊤ y ∥ x ∥ ∥ y ∥ \cos \omega=\frac{(\boldsymbol{A} \boldsymbol{x})^{\top}(\boldsymbol{A} \boldsymbol{y})}{\|\boldsymbol{A} \boldsymbol{x}\|\|\boldsymbol{A} \boldsymbol{y}\|}=\frac{\boldsymbol{x}^{\top} \boldsymbol{A}^{\top} \boldsymbol{A} \boldsymbol{y}}{\sqrt{\boldsymbol{x}^{\top} \boldsymbol{A}^{\top} \boldsymbol{A} \boldsymbol{x} \boldsymbol{y}^{\top} \boldsymbol{A}^{\top} \boldsymbol{A} \boldsymbol{y}}}=\frac{\boldsymbol{x}^{\top} \boldsymbol{y}}{\|\boldsymbol{x}\|\|\boldsymbol{y}\|} cosω=∥Ax∥∥Ay∥(Ax)⊤(Ay)=x⊤A⊤Axy⊤A⊤Ayx⊤A⊤Ay=∥x∥∥y∥x⊤y

这意味着 A ⊤ = A − 1 \boldsymbol{A}^{\top}=\boldsymbol{A}^{-1} A⊤=A−1的正交矩阵 x \boldsymbol{x} x对两个向量变换后同时保持了它们之间的角度和距离。这表明正交矩阵定义的变换是旋转(也可能是翻转)。在3.9节我们将讨论有关旋转的更多细节。

3.5 标准正交基

在第2.6.1节中,我们刻画了基向量的性质,发现在一个 n n n维向量空间中,我们需要 n n n个基向量,即 n n n个线性无关的向量。在第3.3节和第3.4节中,我们使用内积来计算向量的长度和向量之间的夹角。下面,我们将讨论基向量相互正交且每个基向量的长度都为1的特殊情况。我们称这个基为标准正交基。

定义 3.9 标准正交基( Orthonormal Basis)

考虑一个 n n n维向量空间 V V V和 V V V的一个基 { b 1 , … , b n } \left\{\boldsymbol{b}_{1}, \ldots, \boldsymbol{b}_{n}\right\} { b1,…,bn},如果对于任意 i , j = 1 , … , n i, j=1, \ldots, n i,j=1,…,n,有:

⟨ b i , b j ⟩ = 0 for i ≠ j \left\langle\boldsymbol{b}_{i}, \boldsymbol{b}_{j}\right\rangle=0 \quad \text { for } i \neq j ⟨bi,bj⟩=0 for i=j

⟨ b i , b i ⟩ = 1 ( 3.34 ) \left\langle\boldsymbol{b}_{i}, \boldsymbol{b}_{i}\right\rangle=1\qquad (3.34) ⟨bi,bi⟩=1(3.34)

则这个基称为标准正交基(orthonormal basis, ONB)。

如果单单满足第一个式子,则这个基被称为正交基(orthogonal basis)。注意(3.34)表明所有基向量的长度/范数为1.

回想2.61节中,我们可以使用高斯消元法为一组向量所张成的向量空间找到一个基。这里假设我们给定一个非正交和非标准基向量的集合 { b ~ 1 , … , b ~ n } \left\{\tilde{\boldsymbol{b}}_{1}, \ldots, \tilde{\boldsymbol{b}}_{n}\right\} { b~1,…,b~n}。我们把它们连接成一个矩阵 B ~ = [ b ~ 1 , … , b ~ n ] \tilde{\boldsymbol{B}}=\left[\tilde{\boldsymbol{b}}_{1}, \ldots, \tilde{\boldsymbol{b}}_{n}\right] B~=[b~1,…,b~n]。并将高斯消元法应用于增广矩阵 [ B ~ B ~ ⊤ ∣ B ~ ] \left[\tilde{\boldsymbol{B}} \tilde{\boldsymbol{B}}^{\top} \mid \tilde{\boldsymbol{B}}\right] [B~B~⊤∣B~]即可获得正交基。这种迭代地建立一个正交基 { b 1 , … , b n } \left\{\boldsymbol{b}_{1}, \ldots, \boldsymbol{b}_{n}\right\} { b1,…,bn}的构造性方法被称为Gram-Schmidt过程(Gram-Schmidt process)。

例 3.8 标准正交基

欧氏向量空间 R n \mathbb{R}^{n} Rn的规范基/标准基是标准正交基,其中内积是向量的点积。

R 2 \mathbb{R}^{2} R2中,向量

b 1 = 1 2 [ 1 1 ] , b 2 = 1 2 [ 1 − 1 ] \boldsymbol{b}_{1}=\frac{1}{\sqrt{2}}\left[\begin{array}{l}1 \\1\end{array}\right], \quad \boldsymbol{b}_{2}=\frac{1}{\sqrt{2}}\left[\begin{array}{c}1 \\-1\end{array}\right] b1=21[11],b2=21[1−1]

形成标准正交基,因为 b 1 ⊤ b 2 = 0 \boldsymbol{b}_{1}^{\top} \boldsymbol{b}_{2}=0 b1⊤b2=0, ∥ b 1 ∥ = 1 = ∥ b 2 ∥ \left\|\boldsymbol{b}_{1}\right\|=1=\left\|\boldsymbol{b}_{2}\right\| ∥b1∥=1=∥b2∥

我们将在第12章和第10章讨论支持向量机和主成分分析时利用标准正交基的概念。

3.6 正交补

定义了正交性之后,我们现在来看看彼此正交的向量空间。这将在第十章从几何角度讨论线性降维时发挥重要作用。

图 3.7三维向量空间中的平面 U U U可以由它的法向量来描述,法向量张成其正交补 U ⊥ U^⊥ U⊥空间

考虑一个 D D D维向量空间 V V V和 M M M维子空间 U ⊆ V U \subseteq V U⊆V,那么它的正交补 U ⊥ U^{\perp} U⊥是 V V V的一个 ( D − M ) (D-M) (D−M)维的子空间,这个子空间包含 V V V中与 U U U中每一个向量正交的向量。并且, U ∩ U ⊥ = { 0 } U \cap U^{\perp}=\{\mathbf{0}\} U∩U⊥={ 0},所以任何向量 x ∈ V \boldsymbol{x} \in V x∈V能被唯一分解为:

x = ∑ m = 1 M λ m b m + ∑ j = 1 D − M ψ j b j ⊥ , λ m , ψ j ∈ R \boldsymbol{x}=\sum_{m=1}^{M} \lambda_{m} \boldsymbol{b}_{m}+\sum_{j=1}^{D-M} \psi_{j} \boldsymbol{b}_{j}^{\perp}, \quad \lambda_{m}, \psi_{j} \in \mathbb{R} x=m=1∑Mλmbm+j=1∑D−Mψjbj⊥,λm,ψj∈R

其中 ( b 1 , … , b M ) \left(\boldsymbol{b}_{1}, \ldots, \boldsymbol{b}_{M}\right) (b1,…,bM)为 U U U的基, ( b 1 ⊥ , … , b D − M ⊥ ) \left(\boldsymbol{b}_{1}^{\perp}, \ldots, \boldsymbol{b}_{D-M}^{\perp}\right) (b1⊥,…,bD−M⊥)为 U ⊥ U^{\perp} U⊥的基。

因此,正交补也可以用来描述三维向量空间中的平面 U U U(二维子空间)。更具体地说, ∥ w ∥ = 1 \|\boldsymbol{w}\|=1 ∥w∥=1的向量 w w w若与平面 U U U正交,则它是 U ⊥ U^{\perp} U⊥的基向量。如图3.7。所有与 w \boldsymbol{w} w正交的向量都必须(通过构造)位于平面 U U U中。向量 w \boldsymbol{w} w称为 U U U的法向量(normal vector)

在 n n n维向量空间和仿射空间中,通常可以用正交补来描述超平面。

3.7 函数的内积

到目前为止,我们研究了内积的性质来计算长度、角度和距离。我们主要研究有限维向量的内积。下面,我们将看到一个特殊的向量内积:函数的内积。

我们讨论的内积是对具有有限个元素的向量定义的。我们还可以把向量 x ∈ R n x \in \mathbb{R}^{n} x∈Rn看作一个有 n n n个函数值的函数。同时内积的概念可以推广到具有无穷多个元素的向量(无限可数)和连续值函数(无限不可数)。然后把各个分量的和(以式3.5为例)就可以变成一个积分。

两个函数 u : R → R \boldsymbol{u}: \mathbb{R} \rightarrow \mathbb{R} u:R→R和 v : R → R \boldsymbol{v}: \mathbb{R} \rightarrow \mathbb{R} v:R→R的内积可以被定为上下限分别为 a , b < ∞ a, b<\infty a,b<∞的定积分:

⟨ u , v ⟩ : = ∫ a b u ( x ) v ( x ) d x \langle u, v\rangle:=\int_{a}^{b} u(x) v(x) d x ⟨u,v⟩:=∫abu(x)v(x)dx

与一般的内积一样,我们可以通过函数内积来定义范数和正交性。如果内积的值为0,则函数 u \boldsymbol{u} u和 v \boldsymbol{v} v是正交的。为了使前面的内积在数学上定义精确,我们需要考虑度量和积分的定义,从而得到Hilbert空间的定义。此外,与有限维向量上的内积不同,函数的内积可能会发散(具有无穷大的值)。所有这些都需要深入到实变函数和泛函分析中的一些更复杂的细节中,这在本书中我们没有涉及。

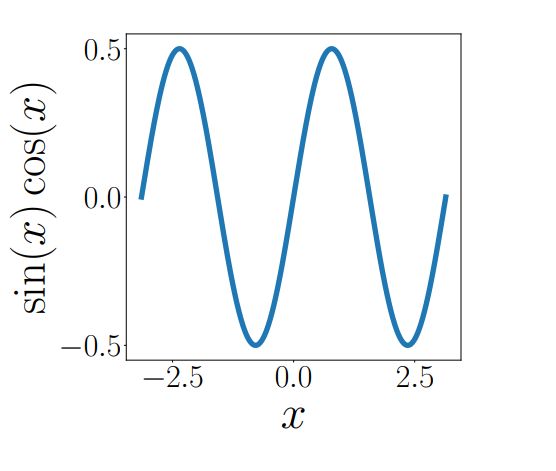

图 3.8 f ( x ) = s i n ( x ) c o s ( x ) f(x)=sin(x)cos(x) f(x)=sin(x)cos(x)

例 3.9 函数的内积

如果我们选择 u = s i n ( x ) u=sin(x) u=sin(x)和 v = c o s ( x ) v=cos(x) v=cos(x),则 f ( x ) = u ( x ) v ( x ) f(x)=u(x)v(x) f(x)=u(x)v(x)的积分如图3.8所示。可以看到该函数是奇函数,即 f ( − x ) = − f ( x ) f(-x)=-f(x) f(−x)=−f(x)。因此,上下限为 a = − π , b = π a=-\pi,b=\pi a=−π,b=π的积分得到内积值为0。所以 s i n sin sin和 c o s cos cos为正交函数。

备注:

如果积分区间为 − π -\pi −π到 π \pi π,则函数集合:

{ 1 , cos ( x ) , cos ( 2 x ) , cos ( 3 x ) , … } \{1, \cos (x), \cos (2 x), \cos (3 x), \ldots\} { 1,cos(x),cos(2x),cos(3x),…}

为正交的,即任何一对函数都是相互正交的。该函数集张成了一个函数的巨大的子空间,这个子空间上的函数,在 [ − π , π ) [-\pi,\pi) [−π,π)上是偶函数且具有周期性,而将函数投影到这个子空间是傅里叶级数背后的基本思想。

在概率和分布6.4.6中,我们将看到第二种非常规内积:随机变量的内积。

翻译自:

《MATHEMATICS FOR MACHINE LEARNING》作者是 Marc Peter Deisenroth,A Aldo Faisal 和 Cheng Soon Ong

公众号后台回复【m4ml】即可获取这本书。

另外,机器学习的数学基础.pdf