多元回归分析(线性回归)

多元线性回归分析

- 一、回归的基本理解

-

- (1)回归的基本任务

- (2)回归里的关键词

- (3)回归里的数据类型

- (4)回归方程中的系数解释

- (5)扰动项要满足的条件

-

- (1)异方差的检验(同方差要求)

- (2)异方差如何解决

- (3)多重共线性的检验(无自相关要求)

- (4)多重共线性的解决方法

- (6)核心解释变量和控制变量

- (7)特殊的自变量:虚拟变量X

- (8)介绍两种筛选变量的回归

- 二、例题:电商平台的奶粉销售问题

- 三、例题:举例一个错误使用回归的例子

- 四、例题:P2P网络贷款中是否存在地域歧视▲

-

- (1)地域歧视的异质性

- (2)地域歧视对学历的异质性

- (3)地域歧视对年龄的异质性

- (4)判断地域歧视是否合理

- (5)稳健性检验:更改地域歧视的研究对象

- (6)稳健性检验:更改计量方法

- (7)稳健性检验:加入其他控制变量

- (8)对工作进行总结

一、回归的基本理解

(1)回归的基本任务

回归分析是数据分析中最基础也是最重要的分析工具,它通过研究自变量X和因变量Y的相关关系,尝试去解释Y的形成机制,进而达到通过X去预测Y的目的。

(2)回归里的关键词

这里涉及到三个重要的关键词:相关性、自变量X、因变量Y

同时需要注意的是相关性与因果性的区别:

我们使用回归分析的结果只是一个相关性的答案,并不是因果关系。在绝大多数情况下,我们没有能力去探究两件事之间发生的严格因果关系、不能很绝对的说这件事的发生是因为这件事导致的,所以我们只能退而求其次,改成通过回归分析,去研究两者的相关关系,也就是说这件事的发生和另外一件事有关联。

因变量Y

因变量Y就是我们研究的核心变量,因变量Y一般可以分为以下几种数据类型

- 连续数值型变量:经济学家研究经济增长的决定因素,那么这个因变量Y可以选择GDP增长率

- 0-1型变量:P2P公司要研究借款人是否能按时还款,那么因变量Y可以涉及成一个二值变量,Y=0表示可以还款,Y=1表示不能还款

- 定序变量:在网店的评价等级,一星表示非常差劲,二星表示一般,三星表示合格,四星表示还可以,五行表示很满意

- 计数变量:在管理学FRM模型中,F代表一定时间内,客户到访的次数,次数其实就是一个非负的整数

- 生存变量:研究某个产品的使用寿命、企业寿命、人的寿命,这类型数据往往不能精确的观测到,例如需要研究吸烟对于寿命的影响,那么样本中的老王60岁,那么他的寿命就可以记为60+

自变量X

X是解释Y的相关变量,Y为被解释变量,即X为解释变量、Y为被解释变量。

通过以上的分析,回归的分析的任务就是完成3个任务:

- 选择(识别)重要的变量:哪些变量是真的同Y相关,哪些不是

- 判断相关性的方向:就是X变量通Y变量的相关性为正相关还是负相关

- 估计权重:赋予不同的自变量X不同的权重,通过回归后的系数,得出不同变量之间的相对重要性

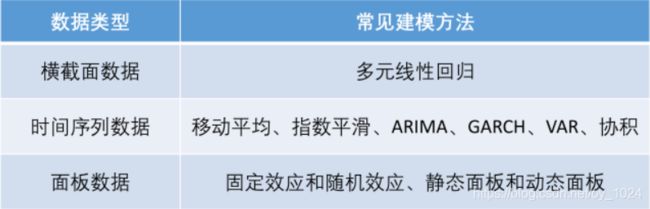

(3)回归里的数据类型

- 横截面数据:在某一时间点收集的不同对象的数据;例如:发放的调查问卷、全国个省份2018年的GDP数据

- 时间序列数据:对同一对象在不同时间连续观察所取得的数据;例如:从出生到现在你的身高数据,中国历年来的GDP数据

- 面板数据:横截面数据与时间序列数据综合起来的一种数据资源;例如2008-2018年我国个省份的GDP数据

针对与不同的数据会使用不同的解决和处理方法

在这我们仅讨论横截面数据的处理,即多元线性回归。

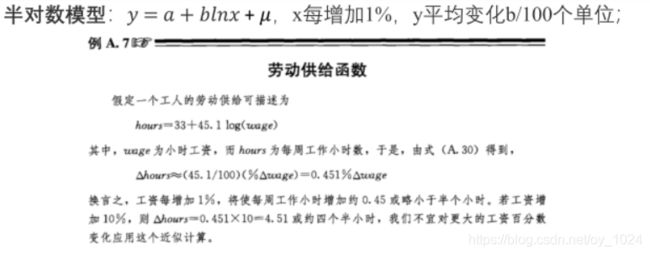

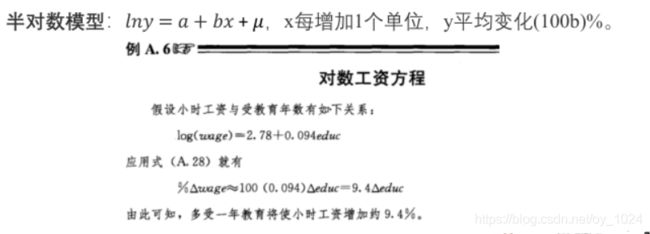

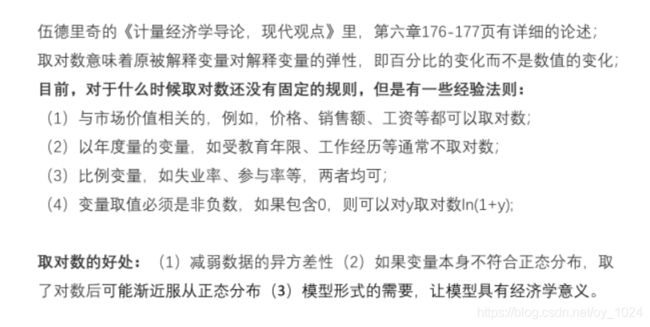

(4)回归方程中的系数解释

主要分为四类模型的回归系数解释:

(5)扰动项要满足的条件

一般我们设计的线性回归方程长这样:

在回归中需要扰动项是球形扰动,球形扰动就是要求满足”同方差“和”无自相关“两个条件。

条件一:同方差:

即对于任意的i j,当i=j时,他们的协方差相等。

条件二:无自相关

扰动项和回归里的解释变量没有相关性。

PS:

- 横截面数据容易出现异方差问题

- 时间序列数据容易出现自相关问题

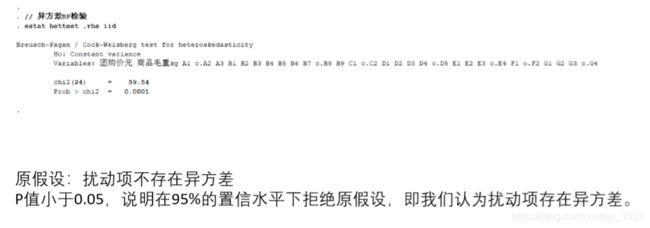

(1)异方差的检验(同方差要求)

在回归后使用Stata命令

estat hettest ,rhs iid

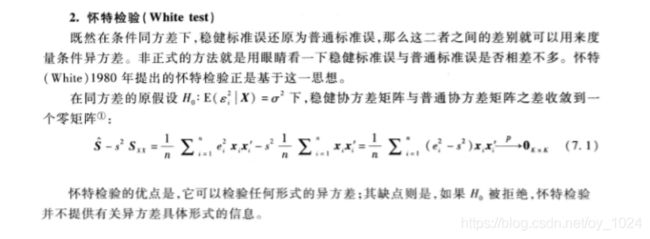

怀特检验(使用最多)

在实际应用中更多使用的时怀特检验,BP检验只是怀特检验的一个特例。

在回归后使用Stata命令

estat imtest ,white

原假设:扰动项不存在异方差,P值小于0.05,说明在95%的置信水平下拒绝原假设,即认为扰动项存在异方差。

(2)异方差如何解决

使用OLS+稳健的标准误 更加常用

使用命令

regress y x1 x2 x3 ... xk,robust

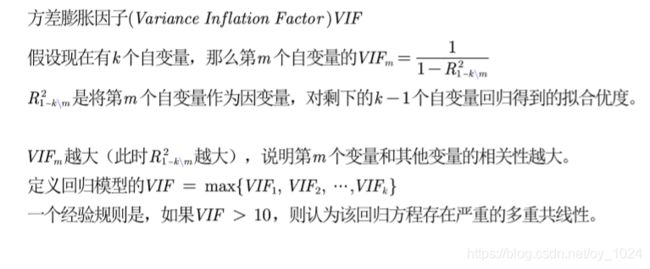

(3)多重共线性的检验(无自相关要求)

多重共线性存在会出现的两种现象

- **现象一:**虽然整个回归方程的拟合优度很大,F检验也很显著,但是对于单个系数的T检验却并不显著,或者是系数的估计值不合理,甚至符号与理论的预期相反。

- **现象二:**添加或者是减少解释变量会使得系数估计值发生较大的变化(比如:后面加入的解释变量与以有的解释变量相关,构成多重共线性)

在Stata回归后使用命令 计算个自变量的VIF

estat vif

(4)多重共线性的解决方法

(6)核心解释变量和控制变量

有了对回归系数的理解,并且已知在进行回归之前会选择真正对因变量有关的自变量,然后再进行回归分析,可知因变量的选择非常的重要。

对于同一个题目,第二个回归方程相较于第一个回归方程多添加了一个变量,产品的价格,而从得到的结果来看,在向回归方程中添加新的自变量产品价格后,对回归系数的影响非常大,因此可以知道的是,变量的遗漏会对回归结果产生很大的影响。

因为在所建立的回归方程中会设置一个扰动项u,而回归对扰动项的要求是扰动项u和回归方程里的所有自变量X均不相关,不然会对回归系数的估计不准确,即不满足无偏和一致性。

在所建立的模型里,会要求扰动项u是一个无法观测并且满足一定条件。这里所说的一定条件指的就是:误差项U和回归方程里的自变量X均不相关,即模型需具有外生性(若相关,则存在内生性,内生性会导致回归系数的估计不准确)

已知在添加X2产品的价格后,回归方程系数的变动很大,可知最开始建立的一元回归模型的扰动项和自变量X1产品的评分存在内生性。所以说变量的遗漏会导致内生性。

上述例子中可以说明扰动项中会包含与y相关,但是未添加到回归模型中的变量,如果这些变量和我们已经添加的自变量相关,则该模型存在内生性。

我们的回归模型要求无内生性,即要求所有的解释变量均与扰动项不相关,但是这个条件一般很难实现,因为在回归里解释变量一般很多,很难保证他们全部外生。所以我们对该条件进行一个弱化,那这个弱化的措施就是将解释变量区分为核心解释变量和控制变量两类。

- 核心解释变量:我们最感兴趣的变量,因此我们特别希望得到对其系数的一致估计(当样本容量无限增大时,收敛于带估计参数的真值)

- 控制变量:对于回归方程中的一些变量,我们对其并没有太多的兴趣,而之所以把它们也添加到回归方程中,主要是为了“控制住”那些对解释变量有影响的遗漏因素。

然而在实际应用中我们只需要保证核心解释变量与扰动项不相关即可。

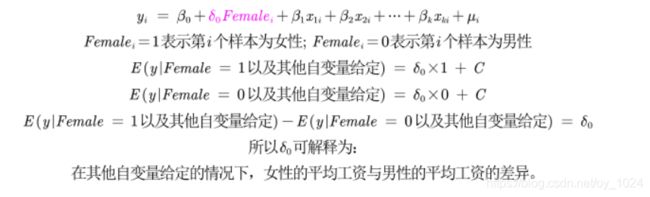

(7)特殊的自变量:虚拟变量X

在一些情况下,自变量中会存在定性变量,例如性别、地域等,那么可以将其设为一个虚拟变量。

单分类虚拟变量

虚拟变量的解释:

多分类虚拟变量

为了避免完全多重共线性的影响,会设置对照组变量,于是引入虚拟变量个数一般是分类数-1。在求解出模型后,对其他变量的分析,所分析的影响和变化是相对于对照组参数来说的。

例如:假设现求解的是样本中广东省的借款成功率,那么这个求解的结果是相对于内蒙(对照组)来说的结果。

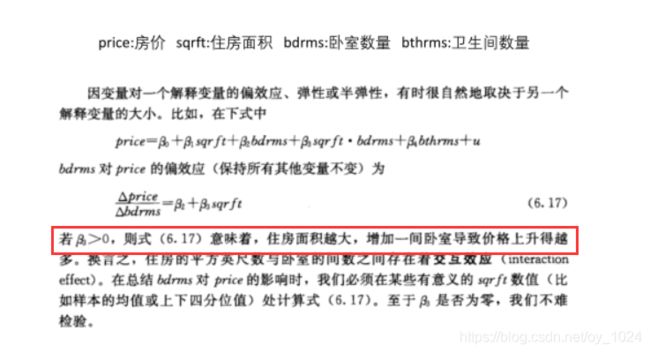

含有交互项的自变量

注意理解交互变量的分析:同时对两个解释变量进行分析。

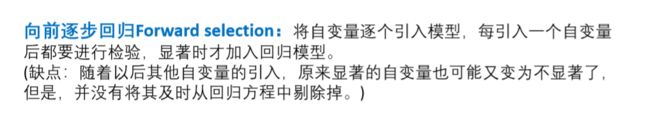

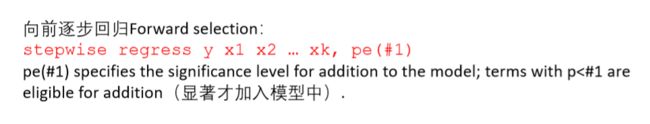

(8)介绍两种筛选变量的回归

解释变量要求和扰动项不存在相关,并且扰动项需要满足球形扰动的要求,那么如何选择和确定解释变量?

方法二:向后逐步回归 #2指的是置信水平的选择

PS注意点

向前逐步回归和向后逐步回归的结果可能不同,不要轻易的使用逐步回归,因为剔除了自变量后很有可能会产生其他的问题,比如内生性问题

二、例题:电商平台的奶粉销售问题

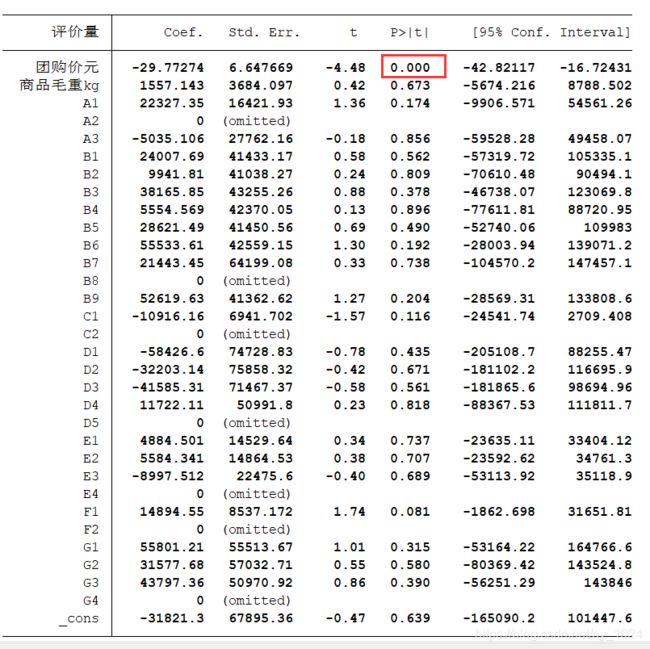

问题一:

是将评价量作为因变量,分析剩余变量和评价量的关系,可以是用回归计算评价量与个变量之间的回归系数,使用回归系数衡量关系。

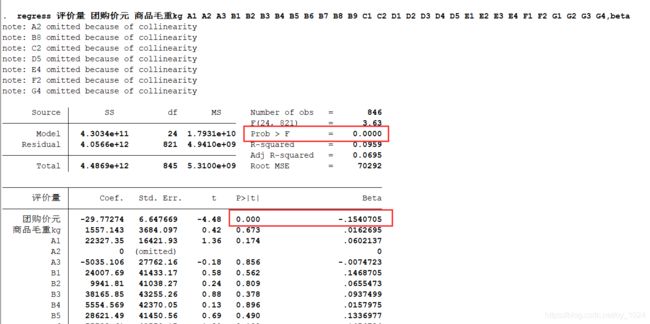

现在我们对处理后的数据进行回归,通过Stata的结果我们可以知道:P值小于0.05,在置信区间为95%的条件下,我们拒绝原假设,即回归系数显著异于0,则可以得到的结果是:

Stata会自动的检测数据的完全多重共线性问题,并且随机的将存在多重共线性的变量作为对照组(剔除)。

第二题

以评价量为因变量,研究影响评价量的重要因素。

为了更为精确的研究影响评价量的重要因素(取除量纲的影响)会使用标准化回归系数进行评价

标准化回归系数

为了更为精确的研究影响评价量的重要因素(取除量纲的影响)会使用标准化回归系数。

首先会对数据进行标准化,就是将原始数据减去它的均数后,再除以该变量的标准差,计算得到的新的变量值,新变量构成的回归方程称为标准化回归方程,回归后得到相应的标准化回归系数。

标准化系数的绝对值越大,说明该解释变量对因变量的影响越大,当然前提是通过联合显著性检验,我们只关注通过联合显著性回归的系数。

对第二问进行求解:

通过Stata的分析结果我们可以知道团购价格是影响评价量的最重要因素,并且当团购价格上升1个单位时,评价量约平均下降0.15个单位。

这道题的必须注意的点:

PS1:为什么经过标准化回归的结果和之前回归的结果完全相同,除了多了最后一列标准化回归系数?对数据进行标准化处理并不胡影响回归系数的标准误,也不会影响显著性。

PS2:

可以看到的是在运行结果中,拟合优度R^2并不是非常的高。

PS2的解释:

- 回归分为解释型回归和预测性回归,在预测型回归中会更加看重拟合优度,也就是说在预测性回归里会要求拟合优度的值较高;而在解释型的回归中更多关注模型整体的显著性以及自变量的统计显著性和经济意义的显著性即可。

- 拟合优度低可以对模型进行调整,例如对数据取对数或者是平方后在进行回归。而拟合优度较低的原因是数据中可能存在异常值或者是数据分布非常的不均匀。

三、例题:举例一个错误使用回归的例子

在该例子中错误的方式对数据处理,并且错误的使用回归。

错误的点:

-

使用归一化,改变了数据的范围:

对论文中的数据进行回归后得到下面的结果:

对“高考总分”进行一个分析,它的系数是-1.26左右,应该有的解释是:当高考总分增加一个单位时,会使得期末成绩减少1.26分。

而论文中对数据进行了一个归一化,使得数据的范围发生了改变,期末成绩的范围是在0-1之间,此时这里的解释就会变得很困难。 -

对解释变量的形式进行了修改,添加高次项:向回归方程中添加新的变量需要合理的理由,因为添加心得变量会使得拟合优度增加,使得方程的解释更加困难。

-

优点:回归的置信区间大部分包含原点,这是结果不太满意的原因

coef的结果是一个点估计,而后面的置信区间是一个区间估计,我们希望得到的区间尽量不要包含原点。这可以是一个判断结果是否良好的原因。

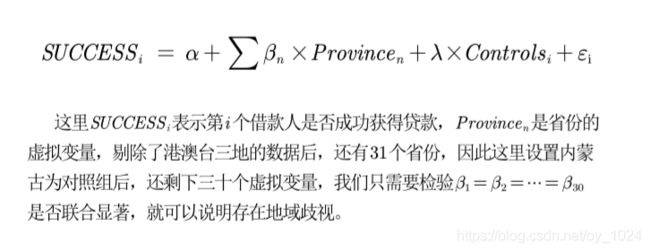

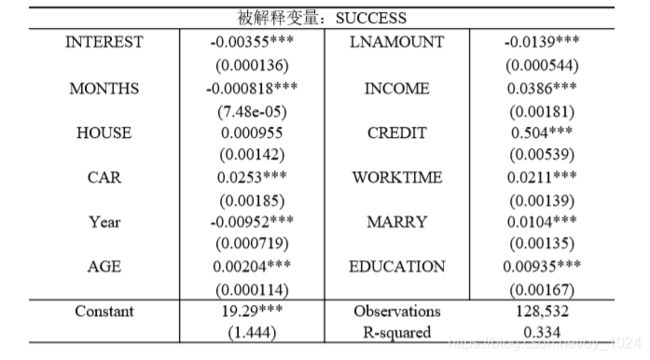

四、例题:P2P网络贷款中是否存在地域歧视▲

(1)地域歧视的异质性

对30个省份的系数进行联合显著性检验,得到F统计量:F(30,128489)=9.09,对应的P值为0.00,所以在99%置信水平下我们拒接原假设,即30个省份的系数显著,所以可得到结论P2P借贷市场中存在地域歧视。

(2)地域歧视对学历的异质性

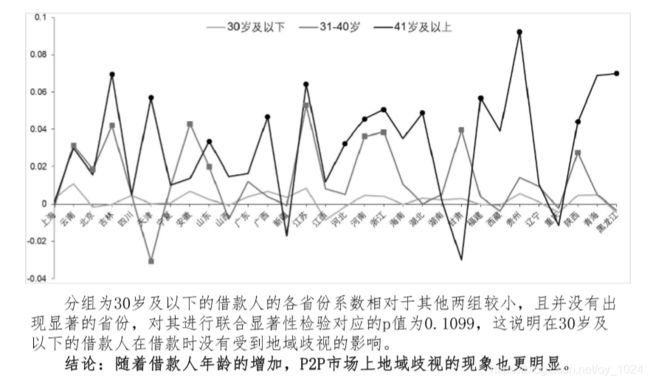

(3)地域歧视对年龄的异质性

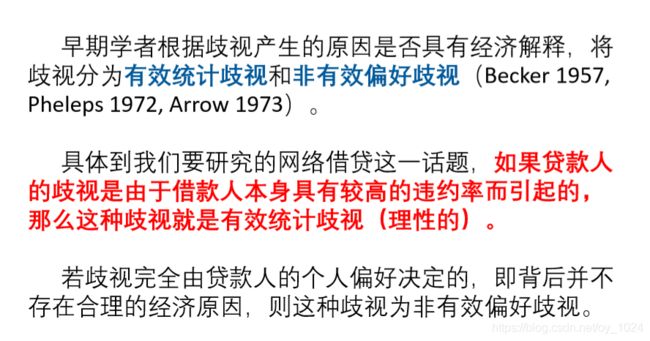

(4)判断地域歧视是否合理

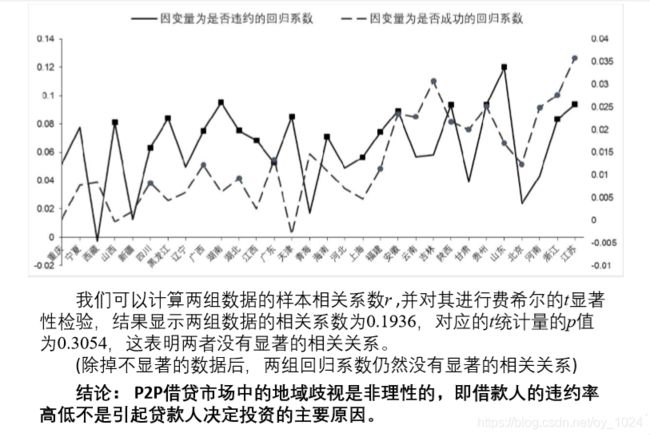

在上面的步骤已经对各个省份进行了回归,其因变量为借款是否成功,它的回归系数所表示的含义是各个省份借款成功率相对于对照组(内蒙)借款成功率的相对差额。

在前面的步骤中我们讨论的是借款成功率,结合上面歧视产生原因的经济解释,我们还需对借款的违约率进行一个讨论。

于是设计违约率回归方程:

在这里因变量为是否违约,样本为所有成功获得借款的借款人,使用OLS估计出每个省份的回归系数,他们所体现的是**各个省份违约率和对照组违约率的相对差额**

在得出违约率中各个省份的回归系数后,与上步骤借款成功率得到的系数,两者的系数进行一个相关性判断,若两者的系数是一个显著的负相关关系,则表明地域歧视是理性的;反之,地理歧视是非理性的。

原因:理性的地域歧视应该是贷款人违约率高,则借款成功率会低,那么两者所呈现的是一种负相关的关系。

(5)稳健性检验:更改地域歧视的研究对象

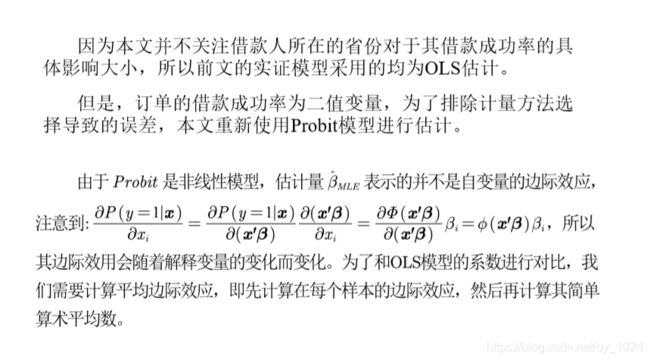

(6)稳健性检验:更改计量方法

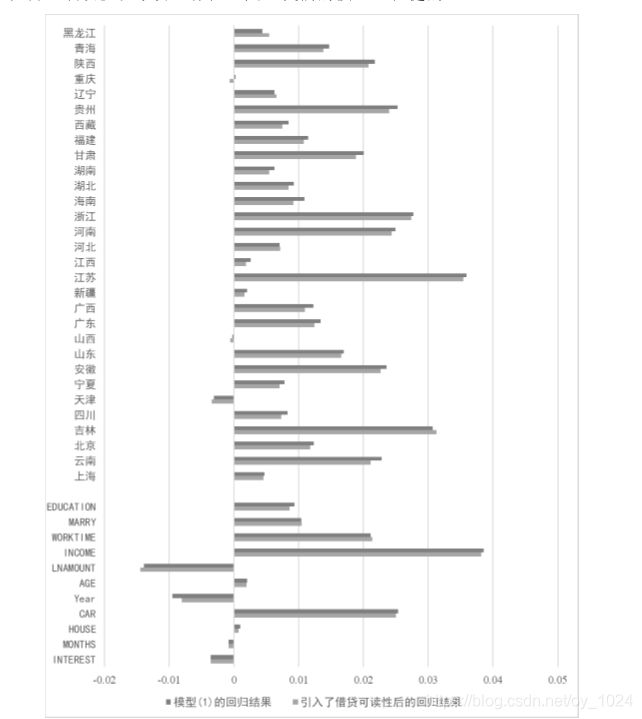

(7)稳健性检验:加入其他控制变量

增加借贷可读性与不增加这一控制变量的模型对比,各自变量回归系数的大小和显著性均无明显变化,另外对各省份系数进 行联合显著性检验,得到F统计量:F(30,128485) = 9.01,其对应的p值 为0,这说明地域歧视现象仍然存在,因此我们的模型是稳健的。