活体检测论文研读三:Learning Deep Models for Face Anti-Spoofing: Binary or Auxiliary Supervision

论文简介

一、指出先前的深度学习方法将人脸反欺骗问题视为一个简单的二分类问题,将Spoof Face和Live Face分别采用简单的0,1标签进行监督学习。这样的神经网络很难抓住足够的欺骗线索并且对线索的归纳性很差

二、论证辅助监督在引导神经网络学习区别和归纳线索方面的重要性

三、提出了一种新的CNN-RNN模型。利用基于像素级的监督方式来估计人脸的深度信息以及基于序列监督的方式来估计人脸的rPPG信号。将估计的深度信息以及rPPG信号进行融合来区分Spoof Face和Live Face

四、介绍了一个新的人脸反欺骗数据库OULU Database,此数据库涵盖了大范围的光照、受试者和姿势变化

论文研读

二分类监督的不足

二分类监督的反欺骗模型,主要存在两个问题:

首先,存在不同程度的图像退化,即欺骗模式,将恶搞脸与活人脸进行比较,这包括皮肤细节丢失、颜色失真、莫尔图案、形状变形和欺骗伪影(例如,反射)。利用Softmax Loss的CNN可能会发现能够区分这两个类别的任意线索,例如屏幕边框,但不会发现忠实的恶搞模式。当这些线索在测试过程中消失时,这些模型将无法区分Spoof Face和Live Face,从而导致较差的泛化能力

其次,在测试过程中,在二元监督下学习的模型只会生成一个二元决策,而没有对决策做出解释及其基本原理的阐述【无法了解具体使用了什么线索】

论文创新点

PA: attackers present face spoofs (i.e., presentation attacks, PA), PA include printing a face on paper (print attack), replaying a face video on a digital device (replay attack), wearing a mask (mask attack), etc. 利用假脸来解锁人脸安全系统的行为,包括打印攻击,回放攻击以及面具攻击等

PIE:variations in poses, illuminations, expressions (PIE). 在姿态、照明、表情上的变化

为了解决上述问题,本文作者提出了一种深度学习模型,该模型利用时间和空间上的辅助信息监督而不是0、1监督,以从人脸视频中稳健地检测PA

空间信息监督Spatial Auxiliary:活体脸部具有与脸部相似的深度,活体人脸具有深度信息,而电子设备以及纸质设备上的人脸在一个平面上(或者对于直至媒体来说可以是一张扭曲后的平面),活体人脸具有更严格和多样性的深度信息

时间信息监督Temporal Auxiliary:正常的rPPG信号(即心脏脉搏信号)可以从活体人脸视频中检测到,但不能从欺骗视频中检测到,所以通过提供不同的rPPG信号作为辅助监管,分别引导网络学习Live Videos和Spoof Videos

为了实现这两种辅助信息监督,作者设计了一个网络架构,该架构具有一个桥接(short-cut connection)用于捕捉不同尺度,以及一个用于处理运动和姿态变化的新型非刚性配准层(non-rigid registration layer)来获取rPPG估计信号

贡献SiW数据库Spoof in the Wild Database:

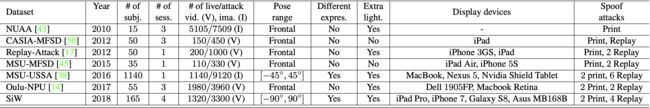

作者认为相机和屏幕质量是影响Spoof Face成像质量的关键因素。以往的数据集都是几年前收集的了,如见电子设备已经更替几倍,这些数据集早已过时。而最近的数据集在PIE上的变化很少,缺少必要变化的数据集难以训练出有效的模型。因此作者收集了SiW数据集。SiW数据库由165个受试者、6个欺骗媒介和4个会话组成,涵盖了PIE、摄像机的距离等变量。SiW涵盖了比以往数据库更大的变化

前期工作

作者回顾了前人的三项工作:1、基于纹理(texture-base);2、基于时间(temporal-based);3、远程光电体积描记术(remote photoplethysmography)

基于纹理方法:对RGB图像使用手工制作的特征例如LBP、HoG、SIFT、SURF并采用传统的分类器SVM和LDA。也有将RGB转换为HSV和YCbCr颜色空间,或使用傅里叶谱作为输入信息来克服照明的影响。随着深度学习的兴起,许多工作尝试使用基于CNN特征或CNN网络来处理人脸反欺骗问题,然而这项工作的大多数人通过应用softmax损失函数将人脸反欺骗问题视为一个简单的二分类问题,例如一些对ImageNet上的CaffeNet或VGG-face预训练模型进行微调、使用多尺度人脸和手工特征来直接区分真假脸。《Face anti-spoofing using patch and depth-based CNNs》这篇论文提出的基于纹理和深度的two-steam CNN-based anti-spoofing方法与我们工作相似,并且相对于这篇论文我们在许多方面取得了进展,这其中包括rPPG、更精细的网络结构、新型非刚性配准层以及综合实验对我们的支撑

基于时间的方法:基于时间线索是面部反欺骗的最早解决方案之一,例如眨眼检测,通过跟踪嘴和嘴唇的运动来检测面部表情。这些方法对典型的纸面攻击有效,但对回放攻击或剪裁出眼睛/嘴巴部分的纸张攻击时,效果并不好

还有一些工作依赖于更一般的时间特征,而不是特定的面部动作。最常见的方法是帧连接。许多手工制作的基于特征的方法通过简单的连接连续帧的特征来训练分类器以此提高内数据集测试的性能。此外,也有一些工作提出了特定时间的特征,例如Haralick特征、运动放大和光流。在深度学习时代,Fenget等人将光流图和剪切波图像特征喂入CNN。Xue等人提出了一种利用时间信息进行二值分类的LSTM-CNN结构。总体而言,现有的人脸反欺骗方法仍然将人脸反欺骗视为二分类问题,因此很难在跨库测试中得到很好的推广。在这项工作中,通过学习人脸视频的rPPG信号来提取可区分的时间信息

远程光电体积描记术:远程光电容积描记术(rPPG)是一种跟踪生命信号(例如心率)而无需与人体皮肤接触的技术。研究始于没有运动或照明变化的面部视频到具有多种变化的视频。Haan等人通过照明和运动变化来估计RGB面部视频中的rPPG信号,它利用色差消除镜面反射并估计两个正交色度信号。 应用带通滤波器(BPM)后,色度信号的比率将用于计算rPPG信号

rPPG曾被用来解决面部反欺骗,例如在3D面具攻击中,活体人脸显示出心跳脉冲。通过提取rPPG信号并计算相关特征进行分类。同样,Magdalena等人从三个面部区域和两个非面部区域提取rPPG信号用于检测打印和回放攻击。尽管在回放攻击中,rPPG提取器可能仍会捕获正常脉冲,但多个区域的组合可以辨别真假。尽管rPPG提取的解析解决方案易于实现,但我们观察到它对PIE变化很敏感。因此,我们采用一种新颖的CNN-RNN架构来学习从人脸视频到rPPG信号的映射,这不仅对PIE变化具有鲁棒性,而且对于活体的区分具有判别能力【提取RPPG的方法来源于论文《Robust pulse rate from chrominance-based rPPG》】

Face Anti-Spoofing with Deep Network

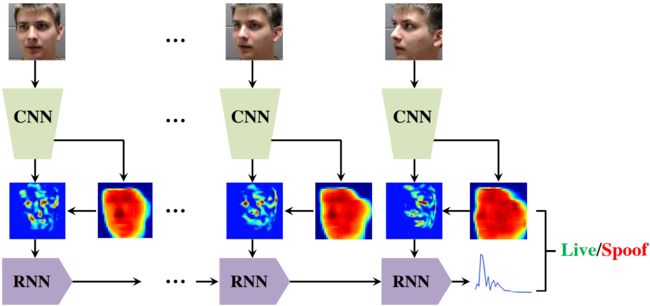

所提出的方法的主要思想是引导深层网络关注横贯空间和时间的已知欺骗模式,而不是提取任何能够区分两个类别却难以归纳的线索。如下图所示,所提出的网络以连贯的方式结合了CNN和RNN架构。CNN部分利用深度图监督来发现微妙的纹理属性,从而对真假脸的识别带来不同的深度。然后,它将估计的深度和特征映射喂入到新的非刚性配准层以创建对齐的特征图。RNN部分使用对齐的特征图和检查视频帧间变化的rPPG作为监督进行训练

Depth Map Supervision

使用人脸的深度图作为标签的方法比简单的0-1标签信息更丰富,因为它表明了活体人脸、打印和回放人脸之间的一个基本区别。将深度图用于深度损失函数来监督CNN部分,基于像素的深度损失函数将引导CNN学习从感受野内的面部区域到标记深度值得映射。对于活体面部,深度值在0-1。对于欺骗面部,深度值为0

rPPG Supervision

rPPG信号提供了有关活体面部的时域信息,因为rPPG信号与面部的皮肤有关,随着时间的变化,面部的不同变化会带来不同的rPPG信号。这些强度变化与血液流动高度相关。提取rPPG信号的传统方法《Robust pulse rate from chrominance-based rPPG》具有三个缺点。首先,它对姿势和表情变化很敏感,因为跟踪特定的面部区域来测量强度变化变得更加困难。其次,它对照明的变化也很敏感,因为额外的照明会影响皮肤反射的光量。第三,出于反欺骗的目的,从欺骗视频中提取的rPPG信号可能无法与真实人脸视频信号充分区分开

作者所提出的方法是采用RNN网络来估计rPPG信号。这简化了具有PIE变化的面部视频的信号估计,并且由于为活体视频和欺骗性视频提供了不同的rPPG监控,因此它还会产生更具有区分性的rPPG信号

论文中假设在不同的PIE条件下同一受试者的视频具有相同的ground truth rPPG。因为对于短时间内(<5分钟)捕获的同一受试者的视频,心跳相似。从受约束的视频中提取的rPPG信号(即,没有PIE变化)用作rPPG损失函数中针对同一受试者的所有活体视频的“ground truth”监督。这种一致的监督有助于CNN和RNN部分对PIE变化具有鲁棒性

Network Architecture

论文提出的网络由两个深层网络组成。首先,CNN部分分别评估每个帧,并估计每个帧的深度图和特征图。其次,递归神经网络(RNN)部分评估整个序列特征图上的时域变化

CNN Network

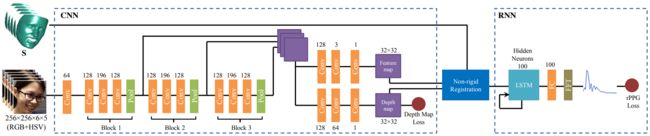

CNN部分采用FCN(Fully Convolutional Network,全卷积网络)结构。如上图所示,CNN部分含有多个blocks,每一个blocks包含三个卷积层,一个池化层,一个resizing(调整网络大小)层,每一个卷积层后面都跟有一个ELU层(exponential linear units,指数线性单元)层和BN(batch normalization,批归一化)层。然后,在每一个block后,resizing层将response maps(将响应图)调整到一个预定义的64x64大小并将response maps连接起来。与ResNet结构相似,旁路连接帮助网络利用不同深度blocks提取到的特征,CNN部分含有两个分支,一个用于估计深度图,一个用于估计特征图

CNN深度图估计分支采用256x256大小尺寸的输入图像,即 I ∈ R 256 × 256 I \in {R^{256 \times 256}} I∈R256×256,使用深度图作为监督,采用的公式如下:

Θ D = arg min ∑ i = 1 N d ∥ CN N D ( I i ; Θ D ) − D i ∥ 1 2 {\Theta _D} = \arg \min \sum\limits_{i = 1}^{{N_d}} {\left\| {{\text{CN}}{{\text{N}}_D}({{\rm I}_i};{\Theta _D}) - {{\text{D}}_i}} \right\|_1^2} ΘD=argmini=1∑Nd∥CNND(Ii;ΘD)−Di∥12

D i D_i Di表示第 i i i张图的“ground truth”, I i I_i Ii表示输入的第 i i i张图, Θ D {\Theta _D} ΘD表示CNN的参数, N d N_d Nd表示图片的数量。CNN特征图的输出则将被送入非刚性配准层

RNN Network

RNN部分的目的是估计具有 N f N_f Nf帧输入序列 { I j } j = 1 N f \left\{ {{{\text{I}}_j}} \right\}_{j = 1}^{{N_f}} {Ij}j=1Nf的rPPG信号 f \text{f} f,仍然如上图网络结构所示。作者使用带有100个隐藏神经元的LSTM层、全连接层和FFT层。FFT层将全连接层的响应转换为傅里叶域。给定输入序列 { I j } j = 1 N f \left\{ {{{\text{I}}_j}} \right\}_{j = 1}^{{N_f}} {Ij}j=1Nf以及“ground truth” rPPG信号 f \text{f} f,通过训练RNN最小化估计的rPPG信号与“ground truth” f \text{f} f之间的 l 1 l_1 l1距离

Θ R = arg min ∑ i = 1 N s ∥ RN N R ( [ { F j } j = 1 N f ] i ; Θ R ) − f i ∥ 1 2 {\Theta _R} = \arg \min \sum\limits_{i = 1}^{{N_s}} {\left\| {{\text{RN}}{{\text{N}}_R}({{[\{ {{\text{F}}_j}\} _{j = 1}^{{N_f}}]}_i};{\Theta _R}) - {{\text{f}}_i}} \right\|_1^2} ΘR=argmini=1∑Ns∥∥∥RNNR([{Fj}j=1Nf]i;ΘR)−fi∥∥∥12

Θ R {\Theta _R} ΘR表示RNN参数, F j ∈ R 32 × 32 {{\text{F}}_j} \in {{\text{R}}^{32 \times 32}} Fj∈R32×32是正面化的特征图, N s N_s Ns是序列的数量, f i \text{f}_i fi表示第 i i i帧的“ground truth”

Implementation Details

Ground Truth Data:给定一组活体与造假视频,提供深度图监督 D \text{D} D和rPPG信号监督 f \text{f} f的“ground truth”,如下图对于活体视频深度图的“ground truth”采用前面所描述的计算方式进行计算,对于造假视频的深度图则给定为一个平面,即全零矩阵。对于rPPG信号,活体视频的“ground truth”从前额的一个patch计算得到,并且每一个受试者采用一个没有PIE变化的活体视频。同样需要对rPPG信号 f \text{f} f采用归一化,即 ∥ f ∥ 2 = 1 {\left\| {\text{f}} \right\|_2} = 1 ∥f∥2=1,对于造假视频rPPG信号设为0

Training Strategy:论文所提出的网络结合CNN和RNN进行端到端训练。CNN部分所需的训练数据应该来自不同的受试者,这样可以使训练过程更加稳定,增加学习模型的可泛化性。同时,为了充分利用帧间的时间信息,RNN部分的训练数据应该是长序列。这两个偏好恰好是相互矛盾的,特别是考虑到有限的GPU内存。因此,为了满足这两种偏好,我们设计了一个双流训练策略。第一个流满足CNN部分的偏好,其中输入包括人脸图像 I I I和深度图“ground truth” D D D。

第二个流满足RNN部分,输入包括人脸序列 { I j } j = 1 N f \left\{ {{{\text{I}}_j}} \right\}_{j = 1}^{{N_f}} {Ij}j=1Nf以及该序列对应的深度图 { D j } j = 1 N f \left\{ {{{\text{D}}_j}} \right\}_{j = 1}^{{N_f}} {Dj}j=1Nf,估计的3D形状 { S j } j = 1 N f \left\{ {{{\text{S}}_j}} \right\}_{j = 1}^{{N_f}} {Sj}j=1Nf以及相应的rPPG “ground truth” f \text{f} f。在训练期间,我们的方法在这两个流之间交替,以收敛到一个模型,使深度图和rPPG损失都最小化。请注意,即使第一个流只更新CNN部分的权值,第二个流的反向传播也会以端到端的方式更新CNN和RNN部分的权值

Testing:作者提供了一个分类的分数,他们将测试序列喂入网络来计算最后一帧的深度图 D ^ \widehat {\text{D}} D 以及rPPG信号 f ^ \widehat {\text{f}} f ,而不是使用 D ^ \widehat {\text{D}} D 和 f ^ \widehat {\text{f}} f 设计一个分类器,score的计算公式如下:

s c o r e = ∥ f ^ ∥ 2 2 + λ ∥ D ^ ∥ 2 2 score = \left\| {\widehat {\text{f}}} \right\|_2^2 + \lambda \left\| {\widehat {\text{D}}} \right\|_2^2 score=∥∥∥f ∥∥∥22+λ∥∥∥D ∥∥∥22

其中, λ \lambda λ是一个恒权值,用于组合网络的两个输出

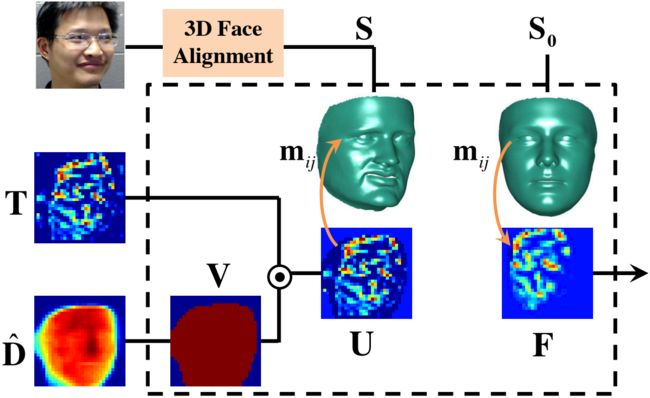

Non-rigid Registration Layer

论文设计了一个新的非刚性配准层来为RNN部分准备数据。这一层利用估计的密集3D形状来对齐来自CNN部分的激活或特征图。这一层对于确保RNN跟踪和学习同一面部区域跨时间以及跨所有受试者的激活变化非常重要

如上图所示,这一层包含三个输入:特征图 T ∈ R 32 × 32 {\text{T}} \in {{\text{R}}^{32 \times 32}} T∈R32×32,深度图 D ^ \widehat {\text{D}} D 以及3D形状 S S S。在这一层,我们首先对深度图设置阈值来产生一个二值化的mask V ∈ R 32 × 32 {\text{V}} \in {{\text{R}}^{32 \times 32}} V∈R32×32

V = D ^ ≥ t h r e s h o l d \text{V}=\widehat {\text{D}}≥threshold V=D ≥threshold

然后,计算二值化mask与特征图的内积 U = T ⊙ V {\text{U}}={\text{T}}\odot{\text{V}} U=T⊙V,本质上是利用深度图作为特征图中每个像素的可见性指标。如果一个像素的深度值小于阈值,我们认为该像素是不可见的。最后,我们利用估计的三维形状 S {\text{S}} S对 U {\text{U}} U进行正面化

F ( i , j ) = U( S ( m i j , 1 ) , S ( m i j , 2 ) ) \text{F}(i, j)=\text{U}\text(S(\text{m}_{ij}, 1), \text{S}(\text{m}_{i j}, 2)) F(i,j)=U(S(mij,1),S(mij,2))

其中 m ∈ R K m\in \text{R}^{K} m∈RK是 S 0 \text{S}_0 S0中面部区预定义的 K K K个索引的列表, m i j m_{ij} mij是像素 i , j i,j i,j对应的索引。利用 m \text{m} m将掩膜后的激活图 U \text{U} U投影到正脸图像 F \text{F} F上,提出的非刚性配准层对我们的网络有三点贡献:

一、应用非刚性配准可以对齐输入数据,并且使得RNN可以比较特征图而无需考虑面部姿势或表情。换句话说,它可以学习同一面部区域的特征映射激活的时间变化

二、非刚性配准会移除特征图中的背景区域。因此背景区域不会参与RNN学习,尽管背景信息已经在CNN部分的层中使用

三、对于欺骗脸,深度图可能更接近于零。因此,具有深度图的内积实质上削弱了特征图中的激活,这使得RNN更容易输出零rPPG信号。同样地,rPPG损失的反向传播还鼓励CNN部分为所有输入帧或输入序列中大多数帧中的一个像素位置生成零深度图

Collection of Face Anti-Spoofing Database

随着传感器技术的进步,现有的反欺骗系统很容易受到新兴的高质量欺骗介质的攻击。让系统能够抵御这些攻击的一种方法是收集新的高质量数据库。为了满足这一需求,我们收集了一个新的人脸反欺骗数据库,名为“Spoof in the Wild (SiW)”数据库,它比下表中以前的数据集有多种优势。首先,它包含了更多具有不同种族的活体受试者,例如,Oulu-NPU受试者的3倍。请注意,MSU-USSA是使用现有的名人图像构建的,没有捕捉活体人脸。第二,活体视频是用两个高质量摄像头(Canon EOS T6, Logitech C920 webcam)对不同PIE变化拍摄的

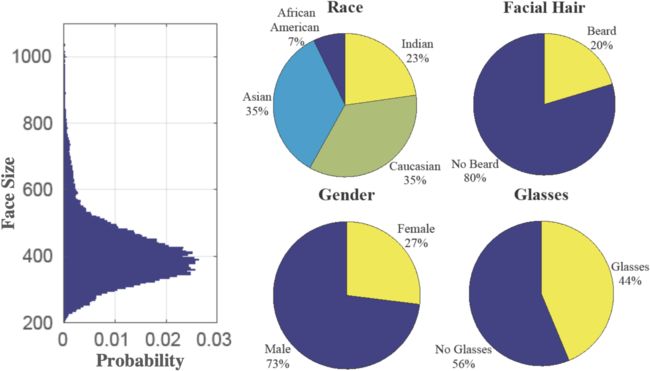

SiW提供了165个受试者的30-fps的活体和造假视频。每个受试者有8个活体和20个造假视频,总共4620个视频。受试者的一些统计数据如下图所示

活体视频分四个环节收集。在第一环节中,受试者移动头部与摄像机保持不同的距离。在第二环节中,受试者在[-90°,90°]范围内改变头部的偏航角(yaw angle),并做出不同的面部表情。在3、4环节中,受试者重复环节1、2,同时收集者在面部周围的不同角度移动点光源

两台摄像机拍摄的实时视频分辨率为1920x1080,我们为每个受试者提供了两次打印和四次回放视频攻击,如下图所示:

为了产生不同质量的打印攻击,我们为每个受试者捕获高分辨率图像(5,184x3,456),并使用它来进行高质量的打印攻击。此外,我们还从活体视频中提取了一个正面视图帧,用于低质量打印攻击。我们使用HP color LaserJet M652打印图像。打印纸的视频攻击是通过保持打印纸静止或在摄像机前扭曲它们来捕捉的。为了生成高质量的回放攻击视频,我们选择了四种造假媒介:Samsung Galaxy S8, iPhone 7, iPad Pro, and PC(Asus MB168B)屏幕。对于每个受试者,我们从四个高质量的活体视频中随机选择两个在造假媒体中显示

Experimental Results

Experimental Setup

Databases:我们在多个数据库上评估了我们的方法以证明它的泛化性。我们利用SiW和Oulu数据集作为新的高分辨率数据集,并在它们之间执行内部测试和交叉测试。此外,我们使用CASIA-MFSD和Replay-Attack数据集进行交叉测试,并与现有的SOTA进行比较

Parameter setting:采用TensorFlow框架,学习率为恒定的 3 × 1 0 − 3 3 \times {10^{ - 3}} 3×10−3,训练10个EPOCH。CNN流的batch size为10,将 N f N_f Nf设定为5,因此CNN-RNN流的batch size为2。使用0均值,0.02标准差的正态分布来随机初始化网络参数,设置 λ \lambda λ为0.015, t h r e s h o l d threshold threshold为0.1

Evaluation metrics:为了与以前的工作进行比较,使用以下指标来报告结果: A P C E R APCER APCER, B P C E R BPCER BPCER, A C E R = A P C E R + B P C E R 2 ACER =\frac{APCER+BPCER}{2} ACER=2APCER+BPCER,以及 H T E R HTER HTER。 H T E R HTER HTER是 F R R FRR FRR和 F A R 之 FAR之 FAR之和的一半

Experimental Comparison

Ablation Study

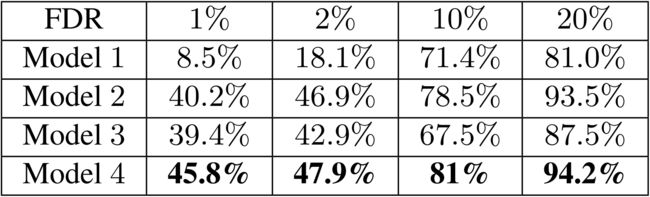

Advantage of proposed architecture:论文比较了四种结构来展示所提出的loss层和非刚性配准层的优势,如下图所示

M o d e l 1 Model\ 1 Model 1的结构类似于所提出方法中的CNN部分,但它扩展了额外的池层、全连接的层和二分类的softmax loss。

M o d e l 2 Model\ 2 Model 2是我们的方法中的CNN部分,具有深度图损失函数。但简单的使用 ∥ D ^ ∥ 2 {\left\| {\widehat {\text{D}}} \right\|_2} ∥∥∥D ∥∥∥2来分类

M o d e l 3 Model\ 3 Model 3包含没有非刚性配准层的CNN和RNN部分。深度图和rPPG损失函数都在该模型中使用。然而,RNN部分将处理CNN未配准的特征图

M o d e l 4 Model\ 4 Model 4是所提出的网络结构

我们用来自SIW的20名受试者的活体视频与造假视频训练了上述四种模型。计算了所有模型在Oulu数据集协议1上的交叉测试性能。下表中报告了不同FDR下的TDR。 M o d e l 1 Model\ 1 Model 1由于采用二元监督所以性能较差。相比之下,仅使用深度图作为监督, M o d e l 2 Model\ 2 Model 2的性能要好得多。然而,在添加了带有rPPG监督的RNN部分之后,我们所提出的 M o d e l 4 Model\ 4 Model 4可以进一步提高性能。通过比较 M o d e l 4 Model\ 4 Model 4和 M o d e l 3 Model\ 3 Model 3,我们可以看到非刚性配准层的优势。显然,RNN部分不能直接使用特征图来跟踪激活图中的变化以及估计rPPG信号

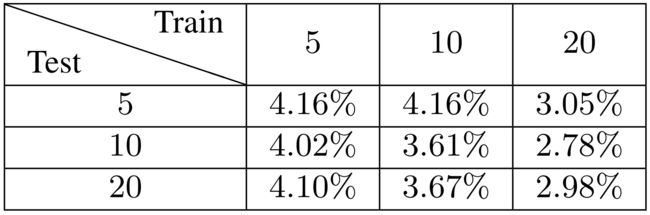

Advantage of longer sequences:为了显示利用更长序列来估计rPPG的优势,我们在序列长度为 N f N_f Nf为5、10以及20时训练和测试我们的模型,采用Oulu协议2的内部测试方式。从下图中,我们可以看到,随着序列长度的增加,rPPG估计更加可靠,ACER降低

尽管更长的序列有好处,但在实践中,由于受到GPU内存的限制,被迫将上表中所有实验的图像大小减小到128x128。因此,在随后的实验中,由于较高分辨率的重要性(例如下表中的ACER比4.16%低2.5%,下表中为1.6%),我们将 N f N_f Nf设定为5,图像尺寸设定为256x256

Intra Testing

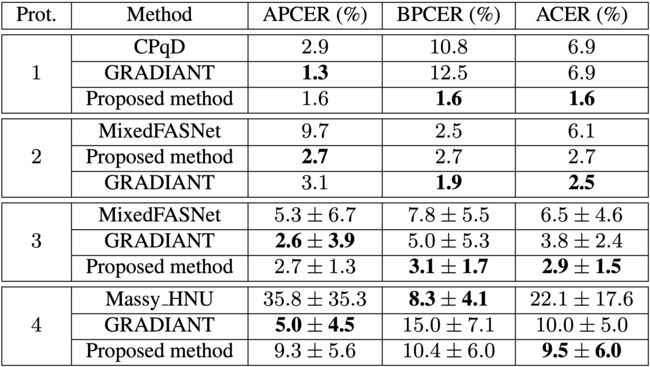

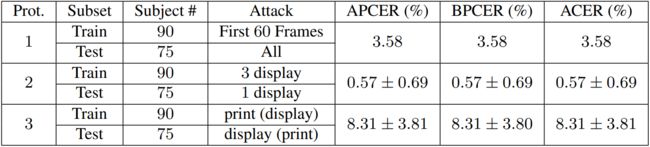

我们对Oulu和SiW数据集进行内部测试。对于Oulu数据集,我们遵循《A competition on generalized software-based face presentation attack detection in mobile scenarios.》中的四个协议,并报告它们的 A P C E R APCER APCER、 B P C E R BPCER BPCER和 A C E R ACER ACER。下表分别展示比较了我们所提出的方法和每个协议中最佳的两种方法在面部反欺骗比赛中的结果

我们的方法在4个协议中的3个实现了最低的 A C E R ACER ACER。我们的ACER在协议2上稍差。为了给未来的SiW研究设定一个baseline,我们为SiW定义了三个方案,协议1处理面部姿态和表情的变化。我们使用训练视频的前60帧进行训练,主要是正面视图,并在所有测试视频上进行测试,协议2评估回放攻击的在交叉造假媒介上的性能,协议3评估在交叉PA上的性能,即从打印攻击到回放攻击,反之亦然。下表显示了协议的定义和我们在每个协议上的性能

Cross Testing

为了证明我们方法的通用性,我们进行了多次交叉测试实验。我们的模型在SiW接受了80名受试者的活体和造假视频的训练,并测试了Oulu的所有协议。协议1-4上的 A C E R ACER ACER分别为: 10.0 % 10.0\% 10.0%、 14.1 % 14.1\% 14.1%、 13.8 ± 5.7 % 13.8±5.7\% 13.8±5.7%和 10.0 ± 8.8 % 10.0±8.8\% 10.0±8.8%。将这些交叉测试结果与《A competition on generalized software-based face presentation attack detection in mobile scenarios.》中的内部测试结果进行比较,我们在四个协议的平均ACER在15名参赛者的面部反欺骗竞赛中排名第六。特别是在所有协议中最难的协议4上,我们的方法实现了 10.0 % 10.0\% 10.0%的ACER,并列第一。这是一个值得注意的结果,因为众所周知,交叉测试比内部测试要困难得多,但我们的交叉测试结果与内部测试的最高性能相当。这证明了我们所学模型的泛化能力

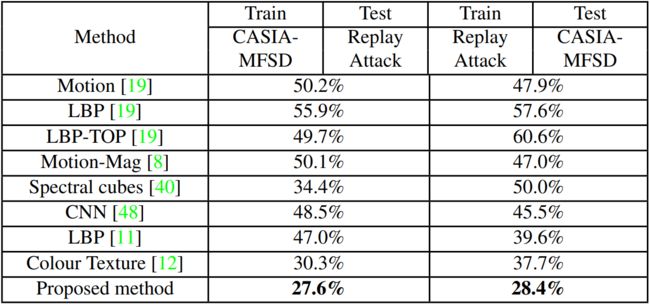

此外,我们利用CASIA-MFSD和Replay-Attack数据集在它们之间执行交叉测试,这两个数据集被广泛用作交叉测试基准。下表比较不同方法的交叉测试的HTER。与以前的SOTA相比,我们提出的方法在Replay-Attack和CASIA-MFSD数据集上的交叉测试错误率分别减少了8.9%和24.6%

Visualization and Analysis

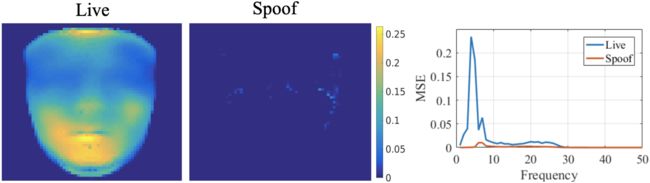

在提出的结构中,正面化的特征图被用作RNN部分的输入,并由rPPG损失函数进行监督训练。这些特征图的值可以显示不同面部区域对rPPG估计的重要性。下图显示了正面特征图的平均值和标准偏差,这些特征图都是从Oulu数据集的1080个活体视频与造假视频中计算而来的。我们可以看到前额和脸颊的侧部区域对rPPG的估计有较高的影响

尽管我们系统的目标是检测PAs,但我们的模型是训练用来估计辅助信息。因此,除了反欺骗之外,我们还喜欢评估模型对辅助信息估计的准确性。为此,我们计算了模型估计的深度图和rPPG信号的准确性,以测试Oulu协议2中的数据。如下图所示,在造假数据中两种估计的准确性都很高,而活体数据的准确性相对较低。注意到,嘴部区域的深度估计有更多的误差,这与上图中相同区域的较少激活是一致的

最后,我们对失败案例进行统计分析,因为我们的系统可以利用辅助信息确定潜在的原因。通过Oulu协议2,我们发现了31个失败案例( 2.7 % A C E R 2.7\%\ ACER 2.7% ACER),对于每个案例,无论我们单独使用深度图还是单独使用rPPG信号,仍然会失败。总计下来,有 29 31 \frac{29}{31} 3129失败案例来源于深度图估计, 13 31 \frac{13}{31} 3113失败案例来源于rPPG信号估计, 11 31 \frac{11}{31} 3111失败案例来源于两者的共同估计。这也表明了未来的研究方向

Conclusions

本文指出了辅助监督对基于神经网络的人脸反欺骗模型的重要性。该网络结合了CNN和RNN结构,联合估计人脸的深度图和人脸视频的rPPG信号。本文提出的SiW数据集比以往的数据集包含更多的受试者和各种变化。最后,通过实验证明了本文方法的优越性

Acknowledgment:This research is based upon work sup-ported by the Office of the Director of National Intelli-gence (ODNI), Intelligence Advanced Research ProjectsActivity (IARPA), via IARPA R&D Contract No.2017-17020200004. The views and conclusions contained hereinare those of the authors and should not be interpreted as nec-essarily representing the official policies or endorsements,either expressed or implied, of the ODNI, IARPA, or theU.S. Government. The U.S. Government is authorized to re-produce and distribute reprints for Governmental purposesnotwithstanding any copyright annotation thereon.