姿态估计之2D人体姿态估计 - HigherHRNet: Scale-Aware Representation Learning for Bottom-Up Human Pose Estimation

参见:

HigherHRNet 论文阅读笔记_酉意铭的博客-CSDN博客_higherhrnet

论文笔记_人体姿态估计:HigherHRNet - 知乎

HigherHRNet论文详解 - 知乎

https://arxiv.org/pdf/1908.10357.pdf

https://github.com/HRNet/HigherHRNet-Human-Pose-Estimation

HigherHRNet是在HRNet和Simple baseline工作的基础上形成的。HRNet因其可以一直保持一个高分辨率网络来提取feature,提取的feature效果很好,从而可以用在pose estimation,object detection,semantic segmentation(语义分割)等工作上。 HigherHRNet则更进一步,因为之前simple baseline的工作证明了,通过反卷积得到更高分辨率的featuremap有助于pose estimation效果的提高,因此,HigherHRNet就是在HRNet原来输出的featuremap基础上,额外加入了一个反卷积,使得模型的输出size进一步提高,pose estimation效果更好。

HRNet论文解读

Simple baseline论文解读

From R-CNN to Mask R-CNN

(源代码) HigherHRNet的整体框架与流程_大黑山修道的博客

HigherHRnet详解之实验复现_error:404..的博客-CSDN博客

Abstract

- Bottom-up的人体姿势估计方法由于尺度变化的挑战,在预测小人物的正确姿势方面有困难。

- 本文提出了一种新的Bottom-up的人体姿态估计方法HigherHRNet,该方法利用高分辨率特征金字塔学习尺度感知表示。

- 该方法在训练方面具有多分辨率监督,在推理方面具有多分辨率聚合功能,能够较好地解决自底向上多人姿态估计中的尺度变化挑战,并能更精确地定位关键点,特别是对小人物。

- HigherHRNet中的特征金字塔由HRNet的特征映射输出和通过转置卷积的上采样高分辨率输出组成。

表现情况:

- 在COCO test-dev中,对于中等大小的人,HigherHRNet比以往最好的自底向上方法有2.5%的AP的提升,显示了它在处理尺度变化方面的有效性。

- HigherHRNet在COCO test-dev(70.5%AP)上达到了SOTA,无需使用固件或其他后处理技术,超越了所有现有的自底向上方法

-

HigherHRNet在CrowdPose test(67.6%AP)测试中甚至超过了所有自顶向下的方法,具有很好的鲁棒性。

1.Introduction

- 由于自上而下的方法可以通过裁剪和调整检测到的人员边界框的大小,将所有人员规范化为大致相同的比例,因此它们通常对人员的比例变化不太敏感。因此,各种多人姿态估计基准的SOTA大多是通过自顶向下的方法来实现的。然而,由于这种方法依赖于单独的人检测器,并且需要单独估计每个人的姿势,因此它们通常是计算密集型的,并且不是真正的端到端系统。

- Bottom-up的策略有效地提高了自底向上方法的速度,提高了姿态估计的实时性。但是,由于自下而上的方法需要处理尺度变化,Bottom-up和top-down的方法在性能上仍然存在很大的差距,特别是对于small scale的人来说

预测小尺寸的人的关键点主要有两个挑战

- 一是处理尺度变化,即在不损害大尺寸的人表现的情况下提高小尺寸的人的表现。

- 另一个是生成高质量的高分辨率热图,用于精确定位小尺寸人的的关键点。

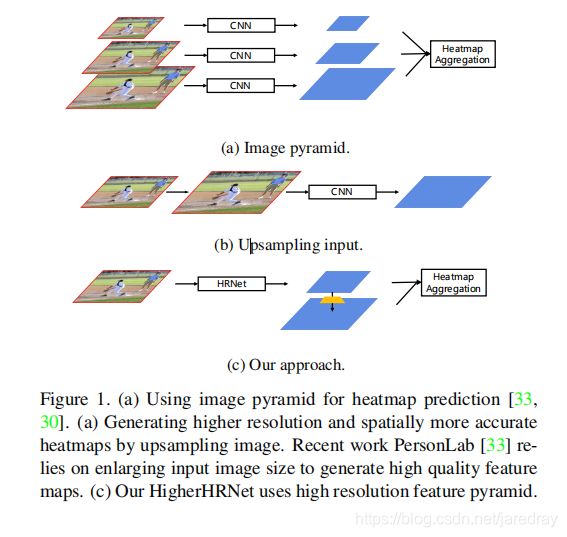

以往的自下而上方法主要集中在对关键点进行分组,简单地使用一个分辨率的特征图,即输入图像分辨率的四分之一来预测热图关键点。 这些方法忽视了尺度变化的挑战,在推理过程中依赖于图像金字塔。如图1 (a)所示。

PersonLab 通过增加输入分辨率生成高分辨率热图,如图1(b)所示。虽然随着输入分辨率的增加,small person的表现一直在增加,但当输入分辨率太大时,large person的表现开始下降。

为了解决这些挑战,必须以自然和简单的方式生成空间上更精确和更具scale-aware的热图,用于自下而上的关键点预测,而无需耗费大量的计算成本。

本文提出了一种==尺度感知高分辨率网络(HigherHRNet)==来解决这些问题

- HigheHRnet通过一个新的高分辨率特征金字塔模块生成高分辨率热图。

- 不同于传统的特征金字塔,它从1/32分辨率开始,使用带横向连接的双线性上采样将特征图分辨率逐渐提高到1/4,高分辨率特征金字塔直接从backbone的1/4分辨率开始,通过反卷积生成更高分辨率的特征图。如图1(c)所示。在HRNet[38,40]的1/4分辨率路径上构建高分辨率特征金字塔,使其更加高效。

- 为了使HigherHRNet能够处理尺度变化,我们进一步提出了一种多分辨率监督策略,将不同分辨率的训练目标分配到相应的特征金字塔层

- 最后,我们在推理过程中引入了一种简单的多分辨率热图聚合策略来生成尺度感知(scale-aware)的高分辨率热图。

2.Related works

Top-down methonds:

自顶向下的方法检测一个人包围框内的单个人的关键点。person bounding boxes 通常由目标检测Mask R-CNN直接生成, 在更快的R-CNN上添加一个关键点检测分支,并在ROIPooling之后重用特征。 进一步将自上而下的方法分为两个步骤,并使用单独的模型进行人的检测和姿态估计。

Bottom-up methods:自下而上的方法[35,19,20,3,30]在图像中为所有人检测无身份的身体关节,然后将其分组。 OpenPose [3]使用两分支多阶段网络,其中一个分支用于热图预测,一个分支用于分组。 OpenPose使用一种称为 part affinity field的分组方法,该方法学习链接两个关键点的2D矢量场。通过计算两个关键点之间的线积分并将其与最大积分对进行分组来完成分组。 Newell等。 [30]使用堆叠沙漏网络[31]进行热图预测和分组。分组是通过一种称为关联嵌入的方法完成的,该方法为每个关键点分配一个“tag”(向量表示),并根据标签向量之间的L2距离对这些关键点进行分组。 PersonLab [33]使用dialated ResNet [17]并通过直接学习每对关键点的2D偏移字段来对关键点进行分组。 PifPaf [22]使用Part Intensity Field(PIF)来定位身体部位,并使用Part Association Field(PAF)将身体部位彼此关联以形成完整的人体姿势。

Feature pyramid:

金字塔形表示已在最近的目标检测和分割框架中被广泛采用以处理尺度变化。 SSD [29]和MSCNN [2]可以预测网络多层中的目标,而无需合并功能。 特征金字塔网络(FPN)[26]使用自上而下的路径扩展了主干模型,该路径使用双线性上采样和横向连接逐渐将特征分辨率从1/32恢复到1/4。 共同的动机是让来自不同金字塔等级的特征预测不同尺度的实例。 但是,这种金字塔形表示法在自下而上的多人姿势估计中很少得到探索。 在这项工作中,我们设计了一个高分辨率的特征金字塔,该金字塔将金字塔扩展到另一个不同方向,从1/4分辨率的特征开始,并生成具有更高分辨率的特征金字塔

High resolution feature maps:

生成高分辨率特征图的方法主要有4种。

- Encoderdecoder [31、16、9、37、1、25、41、10]捕获编码器路径中的上下文信息,并恢复解码器路径中的高分辨率特征。解码器通常包含一系列双线性上采样操作,并具有相同分辨率的编码器功能的跳过连接。

- 扩展卷积[44、5、6、7、8、4、28、43、11、12](也称为“atrous”卷积)用于删除多个跨步卷积/最大池,以保留特征图分辨率。扩散卷积可防止丢失空间信息,但会带来更多的计算成本。

- 在网络末端依次使用反卷积(转置卷积)[42],以有效地提高特征图的分辨率。 SimpleBaseline [42]演示了反卷积可以生成用于热图预测的高质量特征图。

- 最近,提出了一种高分辨率网络(HRNet)[38,40],作为在整个网络上保持高分辨率传输的有效方法。 HRNet [38,40]由具有不同分辨率的多个分支组成。较低分辨率的分支捕获上下文信息,而较高分辨率的分支保留空间信息。通过分支之间的多尺度融合,HRNet [38,40]可以生成具有丰富语义的高分辨率特征图。

我们采用HRNet [38,40]作为我们的基础网络来生成高质量的特征图。 并且我们添加了一个反卷积模块,以生成更高分辨率的特征图以预测热图。 生成的模型称为“尺度感知“的高分辨率网络”Scale-Aware High-Resolution NetWork(HigherHRNet)。 由于HRNet [38、40、40]和反卷积都是有效的,HigherHRNet是一种高效模型,可用于生成用于热图预测的高分辨率特征图。

transposed convolution(反卷积),顾名思义是卷积操作的逆向操作。卷积,输入图片,输出图片的特征,理论依据是统计不变性中的平移不变性(translation invariance),起到降维的作用。反卷积,输入图片的特征,输出图片,起到还原的作用。在HigherHRNet中反卷积的主要目的是生成更更高分辨率的特征来提高准度。

3.Higher-Resolution Network

3.1 HigherHRNet

3.1.1 HRNet

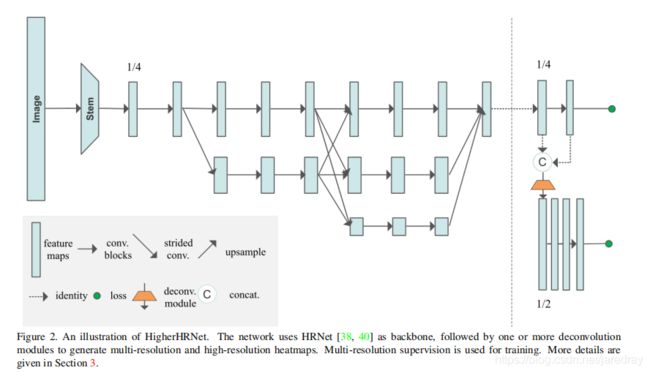

HigherHRNet使用HRNet [38,40](如图2所示)作为backbone。 HRNet [38,40]在第一阶段从高分辨率分支开始。 在随后的每个阶段中,都会将一个新分支与当前分支中分辨率最低的1/2并行添加到当前分支中。 随着网络具有更多阶段,它将具有更多具有不同分辨率的并行分支,并且先前阶段的分辨率都保留在以后阶段。 图2显示了一个包含3个并行分支的示例网络结构。

我们使用与HRNet [38,40]类似的方式实例化backbone。 网络从一个stem开始,该stem由两个跨步的3×3卷积组成,将分辨率降低到1/ 4。 第一级包含4个残差单元,其中每个单元由一个bottleneck(宽度(通道数)为64)形成,然后是一个3×3卷积,将特征图的宽度减小到C。第二,第三,第四级包含1, 4个和3个多分辨率块。 四个分辨率的卷积宽度分别为C,2C,4C和8C。 多分辨率群卷积中的每个分支都有4个残差单位,每个单位的每个分辨率中都有2个3×3卷积。 通过将C分别设置为32和48,我们可以测试两个容量不同的网络。

HRNet [38,40]最初是为自上而下的姿势估计而设计的。 在这项工作中,我们通过添加1×1卷积来预测热图和标tagmap,从而将HRNet [38,40]应用于自下而上的方法,类似于[30]。 我们仅使用最高分辨率(输入图像的1/4)的特征图进行预测。 [30]之后,我们为每个关键点使用标量tag。

3.1.2 HigeherHRNet

热图的分辨率对于预测小型人群的关键点很重要。 现有的大多数人体姿势估计方法都是通过准备ground truth 热图来预测高斯平滑的热图,其中将未标准化的高斯核应用于每个关键点位置。 添加此高斯核有助于训练网络,因为CNN倾向于输出空间平滑的响应,这是卷积运算的本质。 但是,应用高斯核也会给关键点的精确定位带来混乱,特别是对于属于小人物的关键点。 减少这种混乱的简单方法是减少高斯核的标准偏差。 但是,从经验上我们发现,这会使优化变得更加困难,并导致更糟糕的结果。

我们没有降低标准偏差,而是通过以更高的分辨率预测热图来解决此问题,而在不同分辨率下标准偏差不变。 自下而上的方法通常以输入图像的分辨率1/4预测热图。 但是我们发现该分辨率还不足以预测准确的热图。 受[42]的启发,这表明可以使用反卷积有效地生成高质量和高分辨率的特征图,我们通过在图2中所示的HRNet中最高分辨率的特征图的基础上,通过添加一个反卷积模块来构建HigherHRNet,如图2所示。 第3.3节。

反卷积模块将来自HRNet的特征和预测热图作为输入,并生成分辨率比输入特征图大2倍的新特征图。 因此,反卷积模块会与HRNet的特征图一起生成具有两种分辨率的特征金字塔。 反卷积模块还通过添加额外的1×1卷积来预测热图。 我们遵循第3.4节,以不同的分辨率训练热图预测变量,并使用第3.5节中所述的热图聚合策略进行推理。

如果需要更大的分辨率,可以添加更多的反卷积模块。 我们发现反卷积模块的数量取决于数据集人体尺度的分布。 一般而言,包含较小人体的数据集需要较大分辨率的特征图才能进行预测,反之亦然。 在实验中,我们发现添加单个反卷积模块可在COCO数据集上实现最佳性能。

3.2 Grouping

最近的工作[30,23]表明,可以通过使用关联嵌入的简单方法[30]高精度地解决分组问题。 有证据表明,[30]中的实验结果表明,在带有COCO关键点检测数据集的500个训练图像上,使用具有预测tags的ground truth检测将AP从59.2提高到94.0 [27] 。 我们遵循[30]将关联嵌入用于关键点分组。 分组过程通过将tags具有小的L2距离的关键点分组,将无身份的关键点聚类为多个个体。

3.3 Deconvolution Module

我们提出了一个简单的反卷积模块,用于生成高质量的特征图,其分辨率是输入特征图的两倍。 [42]之后,我们使用4×4反卷积(也称为转置卷积),然后使用BatchNorm和ReLU来学习对输入特征图进行上采样。 可选地,我们可以在反卷积之后进一步添加几个基本残差块[17],以细化上采样的特征图。 我们在HigherHRNet中添加4个残差块。

与[42]不同,反卷积模块的输入是来自HRNet或以前的反卷积模块的特征图和预测的热图的串联。 每个反卷积模块的输出特征图也可用于以多尺度方式预测热图。

3.4 Multi-Resolution Supervision

与其他仅对最大分辨率热图应用监视的自下而上的方法[30、33、3]不同,我们在训练过程中引入了多分辨率监督以处理尺度变化。 我们将ground truth关键点位置转换为所有分辨率的热图上的位置,以生成具有不同分辨率的ground truth热图。 然后,我们将具有相同标准偏差(默认情况下使用标准偏差= 2)的高斯核应用于所有这些ground truth热图。 我们发现重要的是不要缩放高斯核的标准偏差。 这是因为特征金字塔的不同分辨率适合于预测不同尺度的关键点。 在更高分辨率的特征图上,需要相对较小的标准偏差(与特征图的分辨率相比)以更精确地定位小人物的关键点。

在HigherHRNet中的每个预测尺度上,我们计算该尺度的预测热图与其关联的ground truth热图之间的均方误差。 热图的最终损失是所有分辨率的均方误差之和。

值得强调的是,由于以下原因,我们没有将不同尺度的人体分配给特征金字塔中的不同级别。 首先,用于分配训练目标的启发式方法取决于数据集和网络体系结构。 由于数据集(人对所有目标的尺度分布)和体系结构(HigherHRNet仅具有2个金字塔等级,而FPN有4个)变化,很难将FPN [26]的启发式方法转换为HigherHRNet。 其次,由于我们应用了高斯核,因此发round truth关键点目标彼此相互作用。 因此,仅通过设置忽略区域来分离关键点非常困难。 我们认为模型能够自动关注特征金字塔不同级别中的特定尺度。

tagmap的训练与HigherHRNet中的热图不同。 我们仅以最低分辨率预测标签图,而不使用所有分辨率。 这是因为学习标记图需要全局推理,它更适合于以较低的分辨率预测标记图。 根据经验,我们还发现更高的分辨率无法很好地预测标签图,甚至无法收敛。 因此,我们遵循[30]来以14分辨率的输入图像在特征图上训练标签图。

3.5 Heatmap Aggregation for Inference热图聚合

我们提出了推理过程中的热图聚合策略。 我们使用双线性插值法将具有不同分辨率的所有预测热图上采样到输入图像的分辨率,并平均所有尺度的热图以进行最终预测。 此策略与以前的方法[3,30,33]完全不同,以前的方法仅使用单个尺度或单个阶段的热图进行预测。

我们使用热图聚合的原因是为了启用尺度感知姿势估计。 例如,COCO关键点数据集[27]包含从322个像素到超过1282个像素的大规模尺度变化的人。 自上而下的方法[34、9、42]通过将人的区域近似标准化为单个尺度来解决此问题。 但是,自下而上的方法需要注意尺度,以从所有尺度中检测关键点。 我们在HigherHRNet中发现了不同尺度的热图,更好地捕获了不同尺度的关键点。 例如,可以在较高分辨率的热图中恢复在较低分辨率的热图中丢失的小人们的关键点。 因此,对来自不同分辨率的预测热图进行平均,使HigherHRNet成为可识别尺度的姿势估计器。

实验

coco关键点检测

数据集:COCO数据集[27]包含超过200000张图像和250000个人体实例,并标有17个关键点。 COCO被分为分别具有57k,5k和20k图像的train / val / test-dev集。 本文所有实验仅在训练集上进行训练。 我们报告了用于消融研究的val设置的结果,并与test-dev设置上的其他最新方法进行了比较。

评测指标:标准评估指标基于目标关键点相似性(OKS):OKS =![]() x。 这里

x。 这里![]() 是检测到的关键点与其对应的ground truth之间的欧几里得距离,

是检测到的关键点与其对应的ground truth之间的欧几里得距离,![]() 是ground truth的可见性标记,s 是目标尺度,

是ground truth的可见性标记,s 是目标尺度,![]() 是控制衰减的每个关键点常数。 我们报告标准平均精确度和召回力评分:AP50(OKS处的AP = 0.50),AP75,AP(OKS处的AP评分的平均值= 0.50、0.55,...,0.90; 0.95),中型对象的APM,APL的 大对象和AR(在OKS处的召回平均值= 0.50、0.55,...,0.90、0.95)。

是控制衰减的每个关键点常数。 我们报告标准平均精确度和召回力评分:AP50(OKS处的AP = 0.50),AP75,AP(OKS处的AP评分的平均值= 0.50、0.55,...,0.90; 0.95),中型对象的APM,APL的 大对象和AR(在OKS处的召回平均值= 0.50、0.55,...,0.90、0.95)。

训练:根据[30],我们使用随机旋转([−30◦,30◦]),随机缩放([0.75,1.5]),随机平移([−40,40])的数据增强来裁剪 输入大小为512×512的图像块以及随机翻转。 如第3.4节所述,我们生成了两个分辨率为128×128和256×256的ground truth热图。

我们使用Adam优化器[21]。 基本学习率设置为1e-3,在第200个和第260个epochs分别降至1e-4和1e-5。 我们对模型进行了总共300个epochs的训练。 为了平衡热图损失和分组损失,我们将两个损失的权重分别设置为1和1e-3。

测试: 我们首先将输入图像的短边尺寸调整为512,并保持宽高比。 热图聚合是通过将所有预测的热图的大小调整为输入图像的大小并取平均值来完成的。 follow[30],翻转测试用于所有实验。 所有报告的数字都是使用单个模型获得的,没有集ensembling。

COCO2017 test-dev上的结果:表1总结了COCO2017 test-dev数据集上的结果。 从结果可以看出,使用HRNet [38,40]本身已成为自下而上方法(64.1 AP)的简单而强大的基准。 我们的仅使用单一尺度测试的HRNet baseline方法优于使用多尺度测试的Hourglass [30],而HRNet在FLOP方面的参数和计算量要少得多。 配备轻量级反卷积模块,我们提出的HigherHRNet(66.4 AP)在参数(+0.4%)和FLOPs(+23.1%)略有增加的情况下,以+2.3 AP胜过HRNet。 HigherHRNet可与PersonLab [33]媲美,但参数仅为50%,FLOP为11%。 如果我们进一步使用多尺度测试,我们的HigherHRNet将达到70.5的AP,大大优于所有现有的自下而上的方法。 在[3,30]中,我们不使用任何自上而下的方法来进行后期处理,例如进行优化。

![]()

表1.与COCO2017 test-dev集上的自下而上方法的比较。 所有GFLOP均以单尺度计算。 对于PersonLab [33],我们仅计算其主干的#Params和GFLOP。 顶部:w/o尺度测试。 底部:w /多尺度测试。 值得注意的是,我们的结果是在没有refinement的情况下实现的。

表2列出了COCO2017 test-dev数据集的自下而上和自上而下的方法。 HigherHRNet进一步缩小了自下而上和自上而下方法之间的性能差距。

![]()

表2.在COCO2017 test-dev数据集上与自顶向下和自底向上方法的比较。 * 表示使用refinement。 +表示使用多尺度测试。

消融实验

我们执行了许多消融实验,以分析COCO2017 [27] val数据集上尺度感知的高分辨率网络(HigherHRNet)。

HRNet vs. HigherHRNet

我们比较HRNet和HigherHRNet进行消融研究。 对于HigherHRNet,使用没有额外残差块的反卷积模块,并且使用热图聚合进行inference。 结果显示在表3中。通过使用特征步长为4的HRNet的简单的自下而上的基线可以达到AP = 64.4。 通过添加一个反卷积模块,我们的HighHRHRNet的特征跨度为2,大大超过了HRNet +2.5 AP(实现了66.9 AP)。 此外,主要改进来自中型人体,其中APM从HRNet的57.1提高到HigherHRNet的61.0。

![]()

表3.在COCO2017 val数据集上HRNet与HigherHRNet的消融研究。 对HigherHRNet使用一个反卷积模块在COCO数据集上表现最佳。

这些结果表明,HigherHRNet由于具有高分辨率的热图,因此在小尺度下的性能要好得多。 我们还发现大人体姿势的AP不会下降。 这主要是因为我们还使用较小分辨率的热图进行预测。 它表明1)以更高的分辨率进行预测对自下而上的姿势估计很有帮助,并且2)尺度感知预测很重要。

如果我们在HRNet之后添加两个反卷积模块的序列以生成与输入图像具有相同分辨率的特征图,则会观察到性能从66.9 AP降低到66.5 AP,仅添加一个反卷积模块。 中型人体的改善很小(+0.1 AP),但大人体的表现却有很大的下降(-0.8 AP)。 我们假设这是因为特征图尺度和目标尺度之间的不匹配。 较大的分辨率特征图(特征步幅= 1)适合于检测甚至更小的人的关键点,但不考虑COCO中的小人进行姿势估计。 因此,默认情况下,我们仅对COCO数据集使用一个反卷积模块。 但我们想指出的是,级联反卷积模块的数量应取决于数据集,我们将在以后的工作中在更多数据集上对此进行验证。

HigherHRNet 增益故障:为了更好地理解所提出组件的增益,我们对每个单独的组件进行了详细的消融研究。 图3展示了我们实验的所有架构。 结果示于表4。

![]()

表4.在COCO2017 val数据集上HigherHRNet组件的消融研究。 MSR:多分辨率监督。 feature concat .:特征串联。 res. bolck:残差块。

反卷积模块的效果: 我们对添加反卷积模块以生成更高分辨率的热图的效果进行消融研究。 为了公平地比较,我们仅使用最高分辨率的特征图来生成用于预测的热图(图3(b))。 HRNet(图3(a))达到了64.4 AP的baseline。 通过添加一个反卷积模块,该模型可实现66.0 AP,这比baseline好1.6 AP。 这种改进完全归因于对具有更高质量的较大特征图的预测。 该结果验证了我们的主张,即对于自下而上的姿势估计,预测更高分辨率的特征图非常重要。

特征串联的效果: 我们将特征图与来自HRNet的预测热图连接起来,作为反卷积模块的输入(图3(c)),性能进一步提高到66.3 AP。 我们还观察到,中型人体的收益很大,而大型人体的表现却有所下降。 比较方法(a)和(c),以较高的分辨率预测热图的收益主要来自中等人体(+3.7APM)。 此外,大人体的AP下降(-1.6 AP)证明了我们的主张,即特征图的不同分辨率对不同尺度的人敏感。

热图聚合的效果: 我们根据热图聚合策略进一步使用热图的所有分辨率进行inference(图3(d))。 与仅使用最高分辨率的热图进行inference的图3(c)(66.3 AP)相比,应用热图聚合策略可实现66.9 AP。 比较方法(d)和(e),热图聚合的收益来自大人体(+1.7 AP)。 大人体的表现甚至比较低分辨率下的预测要好一些(方法(a))。 这意味着使用热图聚合策略预测热图是真正尺度感知的。

![]()

图3.(a)使用HRNet [38,40]作为backbone的baseline方法。 (b)具有多分辨率监督(MRS)的HigherHRNet。 (c)具有MRS和特征串联的HigherHRNet。 (d)具有MRS和特征串联的HigherHRNet。 (e)具有MRS,特征串联和额外残差块的HigherHRNet。 对于(d)和(e),使用热图聚合。

额外残差块的影响: 我们在反卷积模块中添加了4个残差块,我们的最佳模型实现了67.1 AP。 添加残差块可以进一步细化特征图,并且同样增加中型和大型人员的AP。

用更大图片尺寸训练:一个自然的问题是,使用更大的输入size进行训练是否可以进一步提高性能? 为了回答这个问题,我们用640×640和768×768训练HigherHRNet,结果如表5所示,所有三种模型都使用训练图像尺寸进行了测试。 我们发现,通过将训练图像大小增加到640,可以显着提高AP的1.4增益。 大部分收益来自中型人体,而大型人体的表现则略有下降。 当我们进一步将训练图像大小更改为768时,整个AP不再变化。 我们观察到中等人体的略微改善以及大人体的大幅度衰减。

![]()

表5.在COCO2017 val数据集上具有不同训练图像大小的HigherHRNet的消融研究。

更大的backbone:在先前的实验中,我们使用HRNet-W32(1/4分辨率特征图具有32个通道)作为backbone。 我们使用较大backbone 的HRNet W40和HRNet-W48进行实验。 结果显示在表6中。我们发现使用较大的backbone可以持续提高中型和大型人体的性能。

![]()

表6.在COCO2017 val数据集上具有不同backbone的HigherHRNet的消融研究。

CrowPose

CrowdPose [24]数据集由20,000张图像组成,包含约80,000个人。 训练,验证和测试子集按5:1:4的比例分配。 与COCO关键点数据集相比,CrowdPose的场景更为拥挤,给姿势估计方法带来了更多挑战。 评估指标与COCO [27]相同。

另一方面,自下而上的方法自然在拥挤的场景中具有优势。 为了验证HigherHRNet在拥挤场景中的稳健性,以及为自下而上的方法设置一个强大的基准。 我们在CrowdPose训练和val集合上训练了最好的HigherHRNet-W48模型,并在测试集中报告了性能。 所有训练参数均严格遵循COCO,我们使用640×640的crop size进行训练和测试。

结果显示在表7中。我们的HigherHRNet优于单纯的自上而下的方法,大大提高了6.6 AP。 HIGHERHRNET还以1.6 AP优于以前的最佳方法[24](对自上而下的方法[15]进行了global refinement),大部分收益来自APM(+1.8 AP)和APH(+1.5 AP) ,其中包含人群最多的图像。 即使没有多尺度测试,HigherHRNet在APH中也比SPPE [24]高出0.5

![]()

表7.与CrowdPose测试数据集上的自上而下和自下而上方法的比较。 AP的上标E,M,H表示容易,中等和困难。 +表示使用多尺度测试。

5 Conclusion

我们提出了Scale-Aware High-Resolution Network(HigherHRNet)来解决自下而上的多人姿态估计问题中的尺度变化问题, 特别是对于精确定位small persons的关键点。 我们发现多尺度图像金字塔和较大的输入大小部分解决了这个问题, 但是这些方法的计算成本很高。为了解决这个问题, 我们提出了一种基于HRNet的高效高分辨率特征金字塔, 并对其进行多分辨率监督训练。 在推理过程中,具有多分辨率热图聚集的HigherHRNet能够有效地生成多分辨率和高分辨率的热图,以获得更精确的人体姿态估计。 在COCO数据集上,HigherHRNet在很大程度上优于所有现有的自下而上方法,特别是对于small persons。

References

[1] Vijay Badrinarayanan, Alex Kendall, and Roberto Cipolla.Segnet: A deep convolutional encoder-decoder architecturefor image segmentation. IEEE TPAMI, 2017. 3

[2] Zhaowei Cai, Quanfu Fan, Rogerio S Feris, and Nuno Vasconcelos. A unified multi-scale deep convolutional neural network for fast object detection. In ECCV, 2016. 3

[3] Zhe Cao, Tomas Simon, Shih-En Wei, and Yaser Sheikh. ealtime multi-person 2d pose estimation using part affinity fields. In CVPR, 2017. 1, 2, 5, 6, 8

[4] Liang-Chieh Chen, Maxwell D. Collins, Yukun Zhu, George Papandreou, Barret Zoph, Florian Schroff, Hartwig Adam,and Jonathon Shlens. Searching for efficient multi-scale architectures for dense image prediction. In NeurIPS, 2018.3

[5] Liang-Chieh Chen, George Papandreou, Iasonas Kokkinos, Kevin Murphy, and Alan L Yuille. Semantic image segmentation with deep convolutional nets and fully connected crfs.2015. 3

[6] Liang-Chieh Chen, George Papandreou, Iasonas Kokkinos, Kevin Murphy, and Alan L Yuille. Deeplab: Semantic image segmentation with deep convolutional nets, atrous convolution, and fully connected crfs. IEEE TPAMI, 2018. 3

[7] Liang-Chieh Chen, George Papandreou, Florian Schroff, and Hartwig Adam. Rethinking atrous convolution for semantic image segmentation. arXiv preprint arXiv:1706.05587,2017. 3

[8] Liang-Chieh Chen, Yukun Zhu, George Papandreou, FlorianSchroff, and Hartwig Adam. Encoder-decoder with atrous separable convolution for semantic image segmentation. In ECCV, 2018. 3

[9] Yilun Chen, Zhicheng Wang, Yuxiang Peng, Zhiqiang Zhang, Gang Yu, and Jian Sun. Cascaded pyramid network for multi-person pose estimation. In CVPR, 2018. 1, 2, 3, 5, 6

[10] Bowen Cheng, Liang-Chieh Chen, Yunchao Wei, Yukun Zhu, Zilong Huang, Jinjun Xiong, Thomas S Huang, WenMei Hwu, and Honghui Shi. Spgnet: Semantic prediction

guidance for scene parsing. In ICCV, 2019. 3

[11] Bowen Cheng, Maxwell D Collins, Yukun Zhu, Ting Liu,Thomas S Huang, Hartwig Adam, and Liang-Chieh Chen. Panoptic-deeplab. arXiv preprint arXiv:1910.04751, 2019.3

[12] Bowen Cheng, Maxwell D Collins, Yukun Zhu, Ting Liu, Thomas S Huang, Hartwig Adam, and Liang-Chieh Chen. Panoptic-deeplab: A simple, strong, and fast baseline for bottom-up panoptic segmentation. In CVPR, 2020. 3

[13] Bowen Cheng, Yunchao Wei, Honghui Shi, Rogerio Feris, Jinjun Xiong, and Thomas Huang. Decoupled classification refinement: Hard false positive suppression for object detection. arXiv preprint arXiv:1810.04002, 2018. 2

[14] Bowen Cheng, Yunchao Wei, Honghui Shi, Rogerio Feris, Jinjun Xiong, and Thomas Huang. Revisiting rcnn: On awakening the classification power of faster rcnn. In ECCV,2018. 2

[15] Hao-Shu Fang, Shuqin Xie, Yu-Wing Tai, and Cewu Lu. Rmpe: Regional multi-person pose estimation. In ICCV, 2017. 2, 6, 8

[16] Kaiming He, Georgia Gkioxari, Piotr Dollar, and Ross Girshick. Mask r-cnn. In ICCV, 2017. 1, 2, 3, 6, 8

[17] Kaiming He, Xiangyu Zhang, Shaoqing Ren, and Jian Sun. Deep residual learning for image recognition. In CVPR, 2016. 3, 4

[18] Shaoli Huang, Mingming Gong, and Dacheng Tao. A coarsefine network for keypoint localization. In ICCV, 2017. 2, 6

[19] Eldar Insafutdinov, Leonid Pishchulin, Bjoern Andres, Mykhaylo Andriluka, and Bernt Schiele. Deepercut: A deeper, stronger, and faster multi-person pose estimation model. In ECCV, 2016. 2

[20] Umar Iqbal and Juergen Gall. Multi-person pose estimation with local joint-to-person associations. In ECCV, 2016. 2

[21] Diederik P Kingma and Jimmy Ba. Adam: A method for stochastic optimization. arXiv preprint arXiv:1412.6980,2014. 5

[22] Sven Kreiss, Lorenzo Bertoni, and Alexandre Alahi. Pifpaf: Composite fields for human pose estimation. In CVPR, 2019.1, 2, 3, 6

[23] Hei Law and Jia Deng. Cornernet: Detecting objects as paired keypoints. In ECCV, 2018. 4

[24] Jiefeng Li, Can Wang, Hao Zhu, Yihuan Mao, Hao-Shu Fang, and Cewu Lu. Crowdpose: Efficient crowded scenes pose estimation and a new benchmark. In CVPR, 2019. 2, 8

[25] Guosheng Lin, Anton Milan, Chunhua Shen, and Ian Reid. Refinenet: Multi-path refinement networks for highresolution semantic segmentation. In CVPR, 2017. 3

[26] Tsung-Yi Lin, Piotr Dollar, Ross Girshick, Kaiming He, ´

Bharath Hariharan, and Serge Belongie. Feature pyramid networks for object detection. In CVPR, 2017. 2, 3, 5

[27] Tsung-Yi Lin, Michael Maire, Serge Belongie, James Hays, Pietro Perona, Deva Ramanan, Piotr Dollar, and C Lawrence ´ Zitnick. Microsoft coco: Common objects in context. In ECCV, 2014. 2, 4, 5, 6, 8

[28] Chenxi Liu, Liang-Chieh Chen, Florian Schroff, Hartwig Adam, Wei Hua, Alan Yuille, and Li Fei-Fei. Auto-deeplab: Hierarchical neural architecture search for semantic image segmentation. In CVPR, 2019. 3

[29] Wei Liu, Dragomir Anguelov, Dumitru Erhan, Christian Szegedy, Scott Reed, Cheng-Yang Fu, and Alexander C Berg. Ssd: Single shot multibox detector. In ECCV, 2016. 3

[30] Alejandro Newell, Zhiao Huang, and Jia Deng. Associative embedding: End-to-end learning for joint detection and

grouping. In NeurIPS. 2017. 1, 2, 3, 4, 5, 6

[31] Alejandro Newell, Kaiyu Yang, and Jia Deng. Stacked hourglass networks for human pose estimation. In ECCV, 2016.2, 3

[32] Xuecheng Nie, Jiashi Feng, Jianfeng Zhang, and ShuichengYan. Single-stage multi-person pose machines. In ICCV,2019. 6

[33] George Papandreou, Tyler Zhu, Liang chieh Chen, SpyrosGidaris, Jonathan Tompson, and Kevin Murphy. Personlab: Person pose estimation and instance segmentation with a part-based geometric embedding model. In ECCV, 2018.1, 2, 5, 69

[34] George Papandreou, Tyler Zhu, Nori Kanazawa, Alexander

Toshev, Jonathan Tompson, Chris Bregler, and Kevin Murphy. Towards accurate multi-person pose estimation in thewild. In CVPR, 2017. 1, 2, 5, 6

[35] Leonid Pishchulin, Eldar Insafutdinov, Siyu Tang, Bjoern Andres, Mykhaylo Andriluka, Peter V Gehler, and Bernt Schiele. Deepcut: Joint subset partition and labeling for multi person pose estimation. In CVPR, 2016. 2

[36] Shaoqing Ren, Kaiming He, Ross Girshick, and Jian Sun. Faster r-cnn: Towards real-time object detection with region proposal networks. In NeurIPS, 2015. 2

[37] Olaf Ronneberger, Philipp Fischer, and Thomas Brox. U-net: Convolutional networks for biomedical image segmentation. In MICCAI, 2015. 3

[38] Ke Sun, Bin Xiao, Dong Liu, and Jingdong Wang. Deep high-resolution representation learning for human pose estimation. In CVPR, 2019. 1, 2, 3, 4, 6, 7

[39] Xiao Sun, Bin Xiao, Fangyin Wei, Shuang Liang, and Yichen Wei. Integral human pose regression. In ECCV, 2018. 1, 6

[40] Jingdong Wang, Ke Sun, Tianheng Cheng, Borui Jiang,Chaorui Deng, Yang Zhao, Dong Liu, Yadong Mu, Mingkui Tan, Xinggang Wang, Wenyu Liu, and Bin Xiao. Deep high-resolution representation learning for visual recognition. CoRR, abs/1908.07919, 2019. 1, 2, 3, 4, 6, 7

[41] Zbigniew Wojna, Vittorio Ferrari, Sergio Guadarrama, Nathan Silberman, Liang-Chieh Chen, Alireza Fathi, and Jasper Uijlings. The devil is in the decoder. In BMVC, 2017. 3

[42] Bin Xiao, Haiping Wu, and Yichen Wei. Simple baselinesfor human pose estimation and tracking. In ECCV, 2018. 1,2, 3, 4, 5, 6

[43] Tien-Ju Yang, Maxwell D Collins, Yukun Zhu, Jyh-JingHwang, Ting Liu, Xiao Zhang, Vivienne Sze, George Papandreou, and Liang-Chieh Chen. Deeperlab: Single-shot image parser. arXiv preprint arXiv:1902.05093, 2019. 3

[44] Fisher Yu and Vladlen Koltun. Multi-scale context aggregation by dilated convolutions. arXiv preprint arXiv:1511.07122, 2015. 3