CVPR2020 Few-Shot Object Detection with Attention-RPN and Multi-Relation Detector论文翻译

CVPR2020 Few-Shot Object Detection with Attention-RPN and Multi-Relation Detector论文翻译

-

-

- 摘要

- 1.介绍

- 2.相关工作

- 3. FSOD:一个高度多样化的few-shot对象检测数据集

- 4.本文方法

-

- 4.1 问题定义

- 4.2 深度关注的few-shot检测

-

- 4.2.1 基于注意力的RPN

- 4.2.2 多关系检测器

- 4.3 双向对比训练策略

- 5.实验

-

- 5.1 训练细节

- 5.2 与SOTA方法的比较

-

- 5.2.1 ImageNet检测数据集

- 5.2.2 MS COCO数据集

- 5.3 现实中的应用

- 5.4 更多的类别 vs 更多的样本?

- 6. 结论

- 附录A:多关系检测器的实现细节

- 附录B: 更多的实现细节

-

- B.1. 训练和微调细节

- B.2. 评估细节

- 参考文献

-

论文地址:Few-Shot Object Detection with Attention-RPN and Multi-Relation Detector

摘要

传统的目标检测方法通常需要大量的训练数据,而准备这样高质量的训练数据是具有很大劳动成本的。在本文中,我们提出了一种新的Few-Shot目标检测网络,旨在检测不可见类别的,只有少量标签的目标。该方法的核心是我们的Attention-RPN、Multi-Relation Detector和Contrastive Training strategy(对比训练策略),利用Few-Shot支持集和查询集之间的相似性来检测新的目标,同时抑制背景中的假检测。为了训练我们的网络,我们贡献了一个新的数据集,其中包含1000个带有高质量注解的不同类别的对象。据我们所知,这是第一个专门为Few-Shot目标检测设计的数据集。一旦我们的Few-Shot网络被训练,它可以检测不可见类别的目标不需要进一步的训练或微调。该方法具有广泛的应用前景。我们生产一个新的最先进的性能在不同的数据集在Few-Shot设置。数据集链接是https://github.com/fanq15/Few-Shot-ObjectDetection-Dataset

1.介绍

现有的目标检测方法通常严重依赖于大量的注释数据,并且需要很长的训练时间。这激发了最近发展的Few-Shot目标检测。Few-Shot学习是一个挑战,现实生活的目标照明,形状,纹理等有着很大的变化。[1,2,3,4,5,6,7,8]虽然已经取得了重要的研究和进展,但这些方法都专注于图像分类,很少涉及到few-shot目标检t测问题,这可能是因为从few-shot分类到few-shot目标检测的转换是一项艰巨的任务。

目标检测的核心问题是如何在杂乱的背景下定位一个看不见的物体,事后看来,这是一个很普遍的目标定位问题,它来自于一些新类别的注释例子。潜在的边框很容易错过看不见的物体,或者在背景中产生许多错误的检测。我们认为这是由于区域建议网络(RPN)输出的良好边框分数偏低,使得新对象难以被检测到。这使得few-shot目标检测与few-shot分类有着本质的不同。另一方面,最近关于few-shot目标检测的研究[9,10,11,12]都需要进行微调,因此不能直接应用于新的类别。

在本文中,我们针对的是few-shot目标检测问题:给定一些新的目标对象的支持图像,我们的目标是检测出测试集中所有属于目标对象类别的前景目标,如图1所示。为此目的,我们提出两项主要贡献:

- 首先,我们提出了一个通用的few-shot目标检测模型,该模型可以用于检测新的目标,而无需再训练和微调。该方法通过精心设计的对比训练策略、RPN上的注意力模块和检测器,利用权值共享网络中多个网络阶段目标对之间的匹配关系。

这使得我们的模型可以在线检测新类别的对象,而不需要进行良好的训练或进一步的网络自适应。实验表明,我们的模型可以受益于早期阶段的注意力模块,在此阶段提案质量显著提高,最后一个阶段中的多关系检测器模块在混乱的背景中抑制和过滤假检测。在few-shot设定下,我们的模型在ImageNet检测数据集和MS COCO数据集上取得了SOTA的表现。 - 第二个贡献由一个带有1000个类别的大型注释数据集组成,每个类别只有几个例子。总的来说,我们的方法使用该数据集取得了比现有的大规模数据集,如COCO[13] 更显著的性能。据我们所知,这是首批拥有空前数量的目标类别(1000个)的 few-shot目标检测数据集之一。使用该数据集,我们的模型在不同数据集上取得了更好的性能,甚至不需要任何微调。

2.相关工作

通用目标检测: 目标检测是计算机视觉中的一个经典问题。在早期,目标检测通常被表述为一个使用手工制作特征的滑动窗口分类问题[14,15,16]。随着[17]深度学习的兴起,基于cnn的方法成为主要的目标检测解决方案。大多数方法可以进一步分为两种一般的方法:无提案检测器和基于提案检测器。第一种方法遵循一个阶段的培训策略,并不明确生成候选框[18,19,20,21,22],另一方面,由RCNN[23]首创的第二中方法,首先从给定图像中提取潜在对象的类不可知区域建议。然后这些边框被进一步细化,并通过特定的模块划分为不同的类别[24,25,26,27]。这种策略的一个优点是它可以通过RPN模块过滤掉许多负样本,从而方便下一步的检测任务。为此,基于rpn的方法通常比无提案的方法性能更好,有着检测任务的SOTA[27]。然而,上述方法具有很强的监督作用,仅凭几个例子很难扩展到新的范畴。

Few-shot learning: 在经典的场景中Few-shot learning[28]是对传统机器学习算法的挑战,从仅仅几个训练例子学习。早期的工作试图学习一个通用的先验[29、30、31、32、33),如可以跨类别共享的hand-designed strokes或parts。一些研究[1,34,35,36]集中在手工设计不同类别之间的距离公式时的度量学习。最近的趋势是设计一个总代理/策略,在每个任务中指导监督式学习;通过知识的积累,网络可以捕捉到不同任务之间的结构变化。这个研究方向一般称为元学习[2,5,37,38,39]。在这一领域,[37]提出了一个由双网络共享权值组成的连体网络,其中每个网络分别被一个支持图像和一个查询作为输入。查询与其支持之间的距离自然是通过逻辑回归得到的。这种匹配策略捕获了支持和查询之间固有的变化,而不管它们的类别是什么。在匹配框架领域,后续工作[3、4、6、8、10、40]有一个方向是构建内存模块捕获全局上下文的支持来重点加强特征向量。许多著作[41,42]利用局部描述符从有限的数据中获取额外的知识。在[43,44]中,作者引入了图神经网络(GNN)来建模不同类别之间的关系。在[45]中,通过遍历给定的整个支持集来识别与任务相关的特征,从而使高维空间的度量学习更加有效。其他工作,如[2,46],致力于学习总代理来指导参数优化。到目前为止,few-shot learning还没有取得突破性的进展,主要集中在分类任务上,很少有其他重要的计算机视觉任务,如语义分割[47,48,49]、人体运动预测[50]、目标检测[9]等。在[51]中使用未标记数据,在无框图像上交替优化多个模块。但是,这种方法可能会被错误的检测和弱监督所误导,需要重新对新的类别进行训练。在LSTD[9]中,作者提出了一种新的few-shot的目标检测框架,通过最小化源域和目标域之间的分类后验概率差距,将知识从一个大数据集转移到另一个小数据集。然而,这种方法强烈地依赖于源域,并且很难扩展到非常不同的场景。最近,其他几个关于few-shot检测的工作[9,10,11,12]也被提出,但它们学习特定类别的特征向量,并需要针对新的类别进行微调。

我们的工作是由匹配网络[37]开创的研究路线推动的。我们提出了一个通用的few-shot目标检测网络,该网络基于Faster R-CNN框架,采用我们的新注意力RPN和使用我们的对比训练策略训练的多关系检测器来学习图像对之间的匹配度量。

3. FSOD:一个高度多样化的few-shot对象检测数据集

few-shot learning的关键在于相关模型在呈现新类别时的泛化能力。因此,一个具有大量目标类别的高多样性数据集对于训练一个能够检测不可见目标的通用模型以及执行令人信服的评估是必要的。然而,现有的数据集[13,52,53,54,55]包含的类别非常有限,并没有在few-shot评估设置中进行设计。因此,我们建立了一个新的few-shot目标检测数据集。

数据集建设. 我们从现有的用于监督学习的大规模目标检测数据集构建我们的数据集,即[54,56]。然而,这些数据集不能直接使用,原因在于:

- 不同数据集的标签系统是不一致的,一些有着相同语义的目标由不同的词注释。

- 由于不准确和缺少标签、重复的框、对象太大,现有注释的很大一部分是有噪声的。

- 它们的train/test分割包含相同的类别,而对于few-shot的设置,我们希望train/test集合包含不同的类别,以便评估其在不可见类别上的通用性。

为了开始构建数据集,我们首先从[54,56]中总结一个标签系统。通过将具有相同语义(如北极熊和冰熊)的子标签分组到一个类别中,并去除不属于任何子类别的语义,我们将原始标签系统中的子标签合并到一起。然后去除标签质量差的图像和边框尺寸不合适的图像。具体来说,被移除的图像的方框小于图像尺寸的0.05%,通常视觉质量很差,不适合作为支持的示例。接下来,我们按照few-shot学习设置,将我们的数据分为训练集和测试集,没有重叠的类别。我们在MS COCO数据集[13]中构建了带有类别的训练集,以满足案例研究者更喜欢预训练阶段。然后我们通过选择距离最大的类别与现有训练类别进行分割,分离了包含200个类别的测试集,其中距离是在is-a分类法[57]中连接两个语义的最短路径。剩下的分类合并到训练集中,训练集中总共有800个分类。总之,我们构建了一个包含1000个分类的数据集,对分类进行明确的分离,用于训练和测试,其中531个分类来自ImageNet数据集[56],469个分类来自开放图像数据集[54]。

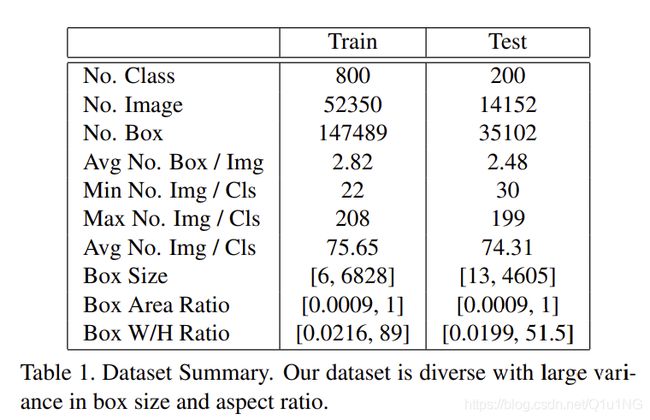

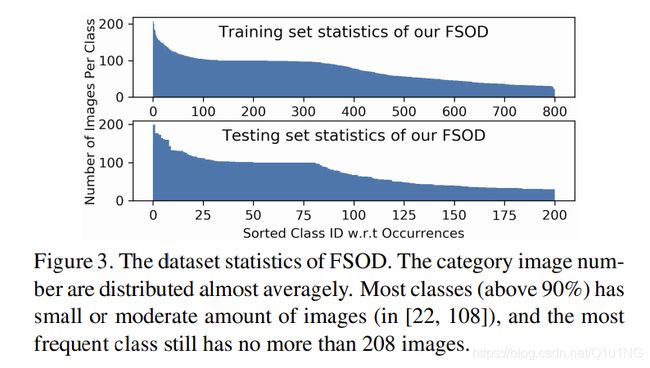

数据集分析. 我们的数据集是专门为few-shot学习和评估模型在新类别上的通用性而设计的,其中包含1000个类别,训练集和测试集分别使用800/200分割,约66,000幅图像和182,000个边框。具体统计如表1、图3所示。我们的数据集有以下属性:

类别的高度多样性: 我们的数据集包含83个父语义,如哺乳动物、服装、武器等,进一步分解为1000个子类。我们的标签树如图2所示。由于我们严格的数据集分割,我们的训练/测试集包含非常不同语义类别的图像,因此对要评估的模型提出了挑战。

具有挑战性的设置: 我们的数据集目标框大小和纵横比有着很大的方差, 26.5%不少于三个目标的图像组成测试集。我们的测试集包含大量不在我们的标签系统的边框类别,因此对于few-shot模型提出巨大挑战。

虽然我们的数据集类别较多,但训练图像和边框的数量远远少于MS COCO dataset等其他大型基准数据集,后者包含123,287幅图像和大约886,000个边框。我们的数据集被设计成紧凑而有效的few-shot学习。

4.本文方法

在本节中,我们首先定义我们的任务是few-shot检测,然后详细描述我们的新颖的few-shot目标检测网络。

4.1 问题定义

给定一个带有目标对象特写的支持图像sc和一个可能包含支持类别c对象的查询图像qc,任务是在查询中找到属于该支持类别的所有目标对象,并使用紧密边界框标记它们。如果支持集合包含N个类别,每个类别有K个例子,这个问题被称为N-way K-shot检测。

4.2 深度关注的few-shot检测

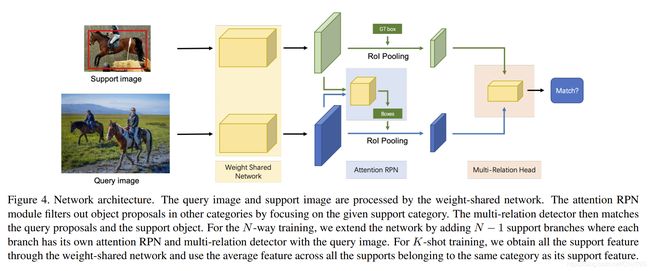

我们提出了一种新的注意力网络,学习支持集和RPN模块和检测器上的查询之间的综合匹配关系。图4显示了我们网络的总体架构。具体来说,我们构建一个由多个分支组成的权重共享框架,其中一个分支用于查询集,其他分支用于支持集 (为了简单起见,我们在图中只显示了一个支持分支)。权值共享框架的查询分支是一个Faster R-CNN网络,它包含了RPN和检测器。我们利用该框架训练支持特征与查询特征之间的匹配关系,使网络能够学习同一类别之间的共性知识。在该框架的基础上,我们引入了一种具有多关系模块的注意RPN和检测器,以实现查询中支持框和潜在框之间的精确解析。

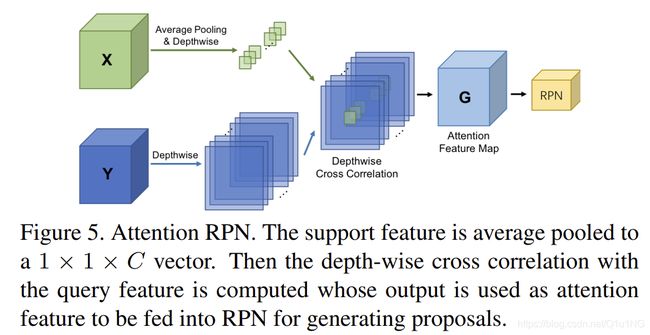

4.2.1 基于注意力的RPN

在few-shot目标检测中,RPN在生成潜在相关的方框以促进后续检测任务方面非常有用。具体来说,RPN不仅要区分对象和非对象,还要过滤掉不属于支持类别的负面对象。然而,在没有任何支持图像信息的情况下,RPN即使不属于支持类别,也会在每一个objectness score较高的潜在目标中漫无目的地活动,从而给后续检测器的分类任务带来大量不相关对象的负担。为了解决这个问题,我们提出了attention RPN(图5),它使用支持信息来过滤掉大多数背景框和那些不匹配类别的框。因此,生成的候选建议集更小、更精确,具有包含目标对象的高潜力。

我们通过注意力机制引入支持信息来引导RPN来生成相关的区域候选并且抑制其他类别的区域候选。具体地说,我们以depth-wise的方式计算支持特征图与查询度特征图之间的相似度,然后利用相似度来构建提案生成。特别地,我们将支持特征表示为X ∈ tS×S×C,将查询的特征映射表示为Y ∈ tH×W×C,相似度定义为:

G是合成的注意力特征图。这里使用支持特征X作为内核,以 depth-wise cross correlation方式[60]在查询特征图上滑动[58,59]。在我们的工作中,我们在RPN模型中采用了顶层的特征,即ResNet50中的res4_6。我们发现,在我们的例子中,S = 1的内核大小执行得很好。这一事实与[25]一致,即全局特征可以为对象分类提供一个良好的优先对象。在我们的例子中,内核是通过对支持特性图求平均值来计算的。注意图先经过3x3卷积处理,然后是objectness分类层和边框回归层。与[25]一样,注意RPN和损失Lrpn与网络联合训练。

4.2.2 多关系检测器

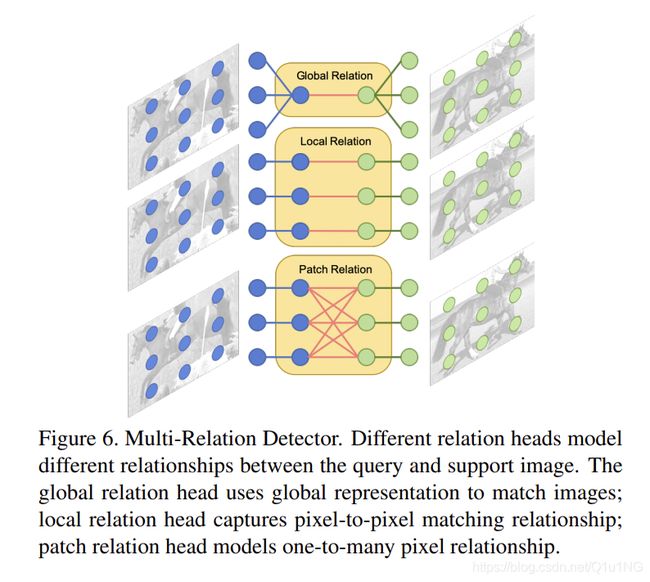

在R-CNN框架中,RPN模块后面跟着一个检测器,它的重要作用是重新评分提案和分类回归。因此,我们希望一个检测器具有较强的辨别能力,能够区分不同的类别。为此,我们提出了一种新的多关系检测器,可以有效地测量查询中建议框与支持目标之间的相似度,如图6所示。检测器模块包括三个注意力模块,分别是 global-relation head 来学习全局匹配的深度嵌入,local-correlation head学习支持和查询建议的pixel-wise和depth-wise cross correlation,patch-relation head学习深度非线性度量来进行块匹配。实验表明,这三个匹配模块可以相互补充,产生更高的性能。3个head的实施细节详见补充资料。

我们需要哪个relation heads? 我们遵循RepMet[61]中提出的N-way K-shot评估协议来评估我们的relation head和其他组件。表2显示了我们提出的多关系检测器在简单的1-way 1-shot训练策略和对FSOD数据集的5-way 5-shot评估下的消融研究。我们在FSOD数据集为所有消融研究使用相同的评估设置。对于单个头,local-relation head在AP50和AP75评估中表现最好。令人惊讶的是, patch-relation head的性能比其他relation head差,尽管它模拟了图像之间更复杂的关系。我们认为复杂的relation head使模型难以学习。当将任意两种类型的relation head结合时,我们得到了比单独的relation head更好的性能。通过组合所有的relation head,我们得到了完整的多关系检测器,并取得了最好的性能,表明三种提出的关系头是互补的,以更好地区分目标和非匹配对象。因此,以后的实验都采用整个多关系检测器。

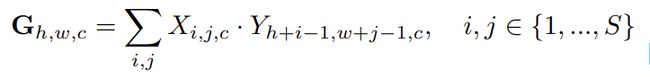

4.3 双向对比训练策略

一种简单的训练策略是通过构造一个训练对(qc, sc)来匹配相同的类别对象,其中查询图像qc和支持图像sc都在同一个第c类对象中。一个好的模型不仅要匹配相同的类别对象,还要区分不同的类别。为此,我们提出了一种新颖的双向对比训练策略。

根据图7中不同的匹配结果,我们提出了双向对比训练,在区分不同类别的同时进行同一类别的匹配。我们随机选择一个查询图像qc,,和包含相同c-th类的支持图像sc,和另一个与sc对象包含不同的n-th类对象的支持图像sn,构建训练triplet(qc、sc、sn),c ≠ n。在训练triplet,只有c-th类别查询图像中的对象标记为前景,而所有其他对象被当作背景。

在训练过程中,模型学习将查询图像中注意力RPN产生的每个建议与支持图像中的对象进行匹配。因此,该模型不仅可以在(qc, sc)之间匹配相同类别的对象,还可以在(qc, sn)之间区分不同类别的对象。然而,有大量的背景提议通常主导训练,特别是与negative支持图像。由于这个原因,我们在查询提议和支持之间平衡这些匹配对的比例。对于前景建议和positive支持对(pf, sp),背景建议和positive支持对(pb, sp),以及建议(前景或背景)和negative支持对(p, sn),我们保持比例为1:2:1。根据匹配分数,我们分别选取所有N(pf, sp)对,选取top 2N (pb, sp)对和top N (p, sn)对,并计算所选择对的匹配损失。在训练过程中,我们对每个抽样建议使用多任务损失L = Lmatching + Lbox,其中边界框损失Lbox在[24]中定义,匹配损失为二进制交叉熵。

哪种训练策略更好? 见表3。我们用2-way 1-shot对比训练策略来训练我们的模型,与单纯的1-way 1-shot训练策略相比,AP50提高了7.9%,说明在训练过程中学习如何区分不同类别的重要性。通过5-shot训练,我们得到了进一步的改善,这正如[1]中验证的few-shot 训练有益于few-shot测试。将我们的双向训练策略扩展到多向训练训策略是很简单的。但是,从表3可以看出, 5-way训练策略并没有比2-way训练策略产生更好的绩效。我们认为,训练不同类别区分模型时,只有一个negative支持类别就足够了。因此,我们所有的模型采用了2-way 5-shot对比训练策略。

哪一个RPN更好? 我们用不同的评估指标来评估我们的注意力RPN。为了评估提案质量,我们首先评估常规RPN和我们提议的注意力RPN中超过0.5 IoU阈值的前100个提案的召回。我们的注意RPN比常规RPN表现出更好的召回性能(0.9130 vs. 0.8804)。然后我们评估这两种rpn在ground truth box上的平均最佳重叠比(ABO[62])。注意RPN的ABO为0.7282,而常规RPN的相同指标为0.7127。这些结果表明,注意RPN可以产生更多高质量的提案。

表3进一步比较了不同训练策略下,有注意RPN的模型和有常规RPN的模型。在AP50和AP75评估中,带有注意力RPN的模型始终比常规RPN表现更好。在AP50/AP75评估中,注意力RPN在1-way 1-shot训练策略中产生0.9%/2.0%的增益,在2-way 5-shot训练策略中产生2.0%/2.1%的增益。这些结果证实了我们的注意力RPN产生了更好的建议,有利于最终的检测预测。因此,我们所有的模型都采用了attention RPN。

5.实验

在实验中,我们比较我们的方法与先进(SOTA)方法在不同的数据集。我们通常在FSOD训练集上训练我们的整个模型,然后直接对这些数据集进行评估。为了与其他方法公平的比较,我们可以放弃FSOD上的训练,采用与这些方法相同的训练/测试设置。在这些情况下,我们使用multi-way few-shot训练在微调阶段并描述更多的细节。

5.1 训练细节

我们的模型使用SGD在4个Tesla P40 gpu上采用batch-size=4(用于查询图像)进行端到端训练。前56000次迭代的学习率为0.002,后4000次迭代的学习率为0.0002。我们观察到在ImageNet[56]和MS COCO[13]上进行预训练可以提供稳定的低级特征,并且可以得到更好的收敛点。鉴于此,除非另有说明,我们默认从[13,56]上预先训练好的ResNet50训练我们的模型。在训练过程中,我们发现过多的训练迭代会损害性能,过多的训练迭代会使模型过度拟合到训练集上。我们固定Res1-3 blocks的权值,只训练高层利用低层基本特征,避免过拟合。将查询图像的较短边调整为600像素;长边的上限是1000。支持图像以16像素的图像上下文围绕目标对象裁剪,零填充,然后调整大小为320x320的正方形图像。对于few-shot的训练和测试,我们通过对同一类别的目标特征求平均来融合特征,然后将它们输入到注意力RPN和多关系检测器中。我们采用典型的度量标准[21],即AP、AP50和AP75进行评估。

5.2 与SOTA方法的比较

5.2.1 ImageNet检测数据集

在表4中,我们将我们的结果与LSTD[9]和RepMet[61]在具有挑战性的基于ImageNet的50路5-shot检测场景中的结果进行了比较。为了公平比较,我们使用他们的评估协议和测试数据集,我们使用相同的MS COCO训练集来训练我们的模型。在评估期间,我们还使用了RepMet评估中采用的soft- nms[63]。在AP50上的评估相比,我们的方法获得了1.7%的性能提升。

为了显示我们方法的泛化能力,我们直接将我们在FSOD数据集上训练的模型应用到测试集上,我们在AP50评估上得到了41.7%,这比我们的微调模型好得多(表4)。值得注意的是我们的模型在FSOD数据集上训练之后,可以直接在测试集上测试,不需要微调,就可以实现SOTA的表现。此外,虽然我们在FSOD数据集上训练的模型比我们在MS-COCO数据集上的微调模型具有稍微好的AP50性能,但是在AP75评估中,我们的模型比微调模型高出6.4%,这表明我们提出的FSOD数据集显著地有利于few-shot目标检测。通过在测试集上对FSOD训练模型进行进一步微调,我们的模型获得了最佳性能,同时注意到,与SOTA相比,我们的不进行微调的方法已经工作得最好。

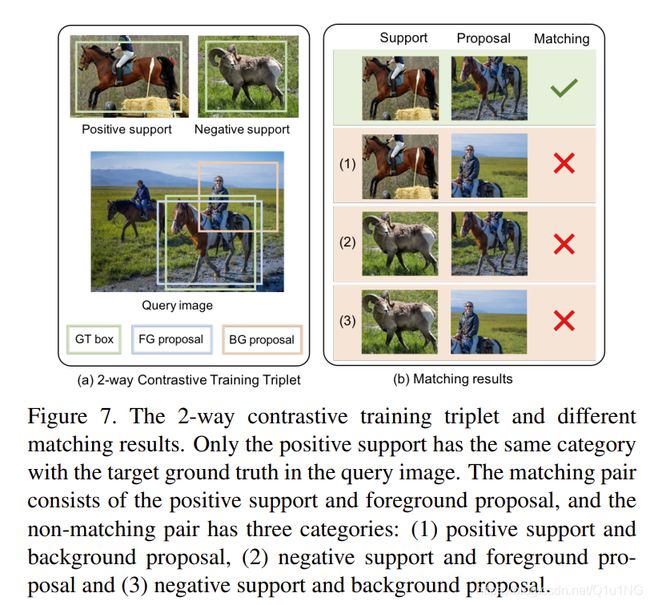

5.2.2 MS COCO数据集

在表5中,我们在MS COCO minival集比较我们的方法与特征权重[10]和Meta R-CNN[12]。我们遵循他们的数据分割和使用相同的评估协议:我们设置了20个类别包含在PASCAL VOC作为新的类别来评估,并使用其他60类别MS COCO的其他60类别来训练。我们使用相同MS COCO训练数据集的微调模型在AP/AP50/AP75指标上的表现比Meta - cnn高出2.4%/1.3%/4.0%。这说明了我们的模型具有很强的学习和泛化能力,而且,在few-shot场景中,学习通用的匹配关系比尝试学习分类特定的嵌入更有前景[10,12]。我们采用FSOD训练的模型在AP/AP50/AP75指标上取得了7.9%/12.2%/9.5%的显著改善。值得注意的是,我们在FSOD数据集上训练的模型直接应用于新的类别,而没有任何进一步的微调

,而所有其他方法都使用10个支持来微调适应新的类别。同样,在不进行微调的情况下,我们在FSOD上训练的模型已经在sota中工作得最好了。

5.3 现实中的应用

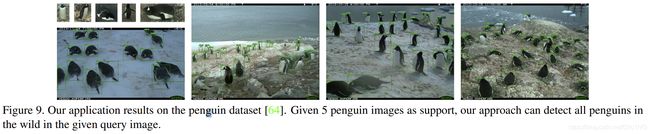

我们在不同的实际应用场景中应用我们的方法来展示它的泛化能力。图8给出了我们测试集中对新类别的定性1-shot目标检测结果。我们进一步将我们的方法应用于野生企鹅的检测[64],并在图9中显示了样本定性的5-shot目标检测结果。

新类别的检测. 考虑这种常见现实生活中的应用场景:给定一个大量的图片相册或电视连续剧没有任何标签,标注的任务是在给定的大规模收集不知道哪些图像包含目标对象,可存在在不同的大小和位置的情况下,注释新颖的目标对象(例如,火箭)。为了减少人工劳动,一种解决方案是手动查找少量包含目标对象的图像,对它们进行注释,然后应用我们的方法自动对图像集合中的其余图像进行注释。根据这个设置,我们执行评估如下:我们将所有测试FSOD的图像数据集合在一起,并为每个对象类别,我们在整个测试集中选5张包含目标对象的图像来执行该新类别的目标检测。注意,不同于标准的目标检测评估,在这个评估里,该模型分别评估每个类别,没有完整的可知类别。

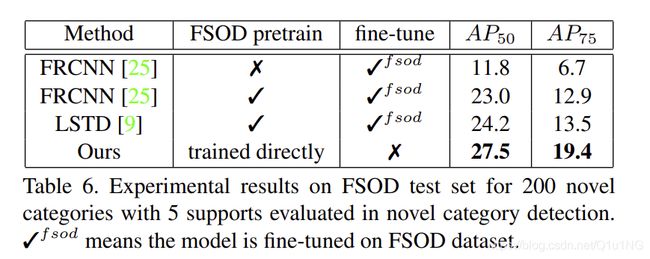

我们与LSTD[9]进行了比较,它需要通过将知识从源域转移到目标域来训练新的类别。然而,我们的方法可以应用于检测新的类别中的对象,而不需要任何进一步的再训练或微调,这与LSTD有根本的不同。为了更有经验的比较,我们将LSTD调整为基于Faster R-CNN,并在公平配置下分别对每个测试类别的5个固定支撑进行再训练。结果如表6所示。在AP50/AP75的所有200个测试类别中,我们的方法比LSTD的性能高出3.3%/5.9%,比它的骨干Faster R-CNN性能高4.5%/6.5%。更具体地说,在没有对我们的数据集进行预先训练的情况下,Faster R-CNN的性能会显著下降。注意,因为模型只知道支持类别,基于finetuning的模型需要分别训练每个类别,这很费时间。

Wild Car检测. 我们将我们的方法应用于KITTI[52]和Cityscapes[65]数据集上的Wild Car检测,这些数据集是用于驾驶应用的城市场景数据集,图像由车载摄像机捕捉。我们评估在KITTI训练集上7480张图片和Cityscapes验证集上500张图片的car类别。DA Faster R-CNN[66]使用来自源域(KITTI/Cityscapes)的大量注释数据和来自目标域(Cityscapes/KITTI)的未标记数据来训练域自适应Faster R-CNN,并评估目标域上的性能。没有使用进一步的重新训练和微调,我们采用10-shot支持的模型获得了可比甚至更好的AP50表现(Cityscapes上37.0% vs 38.5%,KITTI上 67.4% vs. 64.1%)。请注意,DA - Faster R-CNN是专门为野外汽车检测任务设计的,它们在类似领域使用更多的训练数据。

5.4 更多的类别 vs 更多的样本?

我们提出的数据集有大量的目标类别,但每个类别的图像样本很少,这有利于few-shot目标检测。为了证实这一益处,我们在MS COCO数据集上训练我们的模型,该数据集有超过11.5万张图像,只有80个类别。然后在分类数不同的FSOD数据集上对模型进行训练,同时保持相似的训练图像数目。表7总结了实验结果,我们发现MS COCO虽然拥有最多的训练图像,但其模型性能最差,然而在FSOD数据集上训练的模型有着更好的性能,有着更多的类别但保持相似的训练图像数目。这表明,数量有限、图像数量过多的类别实际上会阻碍few-shot目标的检测,而数量众多的类别则会持续地对任务有益。因此,我们认为类别多样性对于few-shot目标检测至关重要。

6. 结论

我们提出了一种基于注意力RPN、多关系检测器和对比训练策略的few-shot目标检测网络。我们贡献了一个新的FSOD,其中包含1000个带有高质量注释的各种对象类别。在FSOD上训练的模型可以不需要预先训练或进一步的网络自适应就能检测出新的类别目标。我们的模型已被广泛的定量和定性结果在不同的数据集上验证。本文对few-shot目标检测做出了贡献,我们相信通过我们的大规模FSOD数据集和检测网络可以衍生出值得研究的相关工作。

附录A:多关系检测器的实现细节

考虑到支持特征fs和大小为7x7xC的查询建议特性fq,我们的多关系检测器实现如下。我们使用三个正面的匹配分数之和作为最终的匹配分数。

Global-Relation Head. 我们将fs和fq连接到大小为7x7x2C的连接特征fc。然后我们将fc平均池化为1x1x2C向量。然后,我们使用具有两个完全连接(fc)层(ReLU)的MLP和一个最终的fc层来处理fc并生成匹配的分数。

Local-Relation Head. 首先使用权重共享的1x1xC卷积分别处理fs和fq。然后利用主论文4.2.1节中的公式,S = H = W = 7计算 depth-wise相似度。然后使用fc层生成匹配的分数。

Patch-Relation Head. 我们首先将fs和fq连接到大小为7x7x2C的连接特征fc。然后将fc送入patch-relation模块,其结构如表8所示。本模块中所有卷积层、ReLU层和池化层都有零填充,将feature map的大小从7x7减小到1x1。然后我们使用fc层来生成匹配分数,使用单独的fc层来生成边界框预测。

附录B: 更多的实现细节

B.1. 训练和微调细节

在这里,我们将在主论文的5.2节中展示更多的实验细节。

在5.2节中,我们采用其他方法在MS COCO数据集[13]上训练我们的模型,并对目标数据集进行微调。当我们在MS COCO上训练我们的模型时,我们删除了小于32x32边框的图像。这些方框通常在视觉质量很差的情况下,当它们作为支持例子时,会损害训练。当我们在目标数据集上微调我们的模型时,我们遵循其他方法的相同设置[9,10,11,12]来进行公平比较。具体来说,LSTD[9]和RepMet[11]每个类别使用5个支持图像,其中每个图像包含一个或多个对象实例,而Feature reweights[10]和Meta R-CNN[12]使用严格的规则,每个类别采用10个对象实例进行微调。

B.2. 评估细节

在论文中有两种评价设置。

- 消融实验采用RepMet[11]中定义的基于分段的评估方案,其设置借鉴于few-shot分类任务[2,4]。总共有600个随机评估集,这保证了测试集中的每一幅图像都能得到高概率的评估。在每一段中,对于N-way K-shot评估,有N个类别,每个类别有K个实例,每个类别有10个查询图像,其中每个查询图像至少包含一个属于该类别的实例。所以在每一段中有KxN个支持和10 xN个查询图像。请注意,所有这些类别和图像都是在每段中随机选择的。

- 其他基于基线的比较实验采用标准的目标检测评估标准,这是一种full-way, N-shot评估。在评估过程中,一旦获得了支持特征,就可以丢弃模型中的支持分支,然后将支持特征作为正向过程的模型权重。

参考文献

[1] Jake Snell, Kevin Swersky, and Richard Zemel. Prototypical

networks for few-shot learning. In NeurIPS, 2017.

[2] Sachin Ravi and Hugo Larochelle. Optimization as a model

for few-shot learning. In ICLR, 2017.

[3] Adam Santoro, Sergey Bartunov, Matthew Botvinick, Daan

Wierstra, and Timothy Lillicrap. Meta-learning with

memory-augmented neural networks. In ICML, 2016.

[4] Oriol Vinyals, Charles Blundell, Tim Lillicrap, Daan Wierstra, et al. Matching networks for one shot learning. In

NeurIPS, 2016.

[5] Chelsea Finn, Pieter Abbeel, and Sergey Levine. Modelagnostic meta-learning for fast adaptation of deep networks.

In ICML, 2017.

[6] Qi Cai, Yingwei Pan, Ting Yao, Chenggang Yan, and Tao

Mei. Memory matching networks for one-shot image recognition. In CVPR, 2018.

[7] Spyros Gidaris and Nikos Komodakis. Dynamic few-shot

visual learning without forgetting. In CVPR, 2018.

[8] Flood Sung Yongxin Yang, Li Zhang, Tao Xiang, Philip HS

Torr, and Timothy M Hospedales. Learning to compare: Relation network for few-shot learning. In CVPR, 2018.

[9] Hao Chen, Yali Wang, Guoyou Wang, and Yu Qiao. Lstd:

A low-shot transfer detector for object detection. In AAAI,

2018.

[10] Bingyi Kang, Zhuang Liu, Xin Wang, Fisher Yu, Jiashi Feng,

and Trevor Darrell. Few-shot object detection via feature

reweighting. In ICCV, 2019.

[11] Leonid Karlinsky, Joseph Shtok, Sivan Harary, Eli Schwartz,

Amit Aides, Rogerio Feris, Raja Giryes, and Alex M Bronstein. Repmet: Representative-based metric learning for

classification and few-shot object detection. In CVPR, 2019.

[12] Xiaopeng Yan, Ziliang Chen, Anni Xu, Xiaoxi Wang, Xiaodan Liang, and Liang Lin. Meta r-cnn : Towards general

solver for instance-level low-shot learning. In ICCV, 2019.

[13] Tsung-Yi Lin, Michael Maire, Serge Belongie, James Hays,

Pietro Perona, Deva Ramanan, Piotr Dollar, and C Lawrence ´

Zitnick. Microsoft coco: Common objects in context. In

ECCV, 2014.

[14] Navneet Dalal and Bill Triggs. Histograms of oriented gradients for human detection. In CVPR, 2005.

[15] Pedro F Felzenszwalb, Ross B Girshick, David McAllester,

and Deva Ramanan. Object detection with discriminatively

trained part-based models. IEEE transactions on pattern

analysis and machine intelligence, 32(9):1627–1645, 2010.

[16] P VIODA. Rapid object detection using a boosted cascade

of simple features. In CVPR, 2001.

[17] Alex Krizhevsky, Ilya Sutskever, and Geoffrey E Hinton.

Imagenet classification with deep convolutional neural networks. In NeurIPS. 2012.

[18] Joseph Redmon, Santosh Divvala, Ross Girshick, and Ali

Farhadi. You only look once: Unified, real-time object detection. In CVPR, 2016.

[19] Joseph Redmon and Ali Farhadi. Yolo9000: better, faster,

stronger. In CVPR, 2017.

[20] Wei Liu, Dragomir Anguelov, Dumitru Erhan, Christian

Szegedy, Scott Reed, Cheng-Yang Fu, and Alexander C

Berg. Ssd: Single shot multibox detector. In ECCV, 2016.

[21] Tsung-Yi Lin, Priya Goyal, Ross Girshick, Kaiming He, and

Piotr Dollar. Focal loss for dense object detection. In ´ ICCV,

2017.

[22] Songtao Liu, Di Huang, et al. Receptive field block net for

accurate and fast object detection. In ECCV, 2018.

[23] Ross Girshick, Jeff Donahue, Trevor Darrell, and Jitendra

Malik. Rich feature hierarchies for accurate object detection

and semantic segmentation. In CVPR, 2014.

[24] Ross Girshick. Fast r-cnn. In ICCV, 2015.

[25] Shaoqing Ren, Kaiming He, Ross Girshick, and Jian Sun.

Faster r-cnn: Towards real-time object detection with region

proposal networks. In NeurIPS, 2015.

[26] Kaiming He, Georgia Gkioxari, Piotr Dollar, and Ross Gir- ´

shick. Mask r-cnn. In ICCV, 2017.

[27] Bharat Singh, Mahyar Najibi, and Larry S Davis. Sniper:

Efficient multi-scale training. In NeurIPS, 2018.

[28] Sebastian Thrun. Is learning the n-th thing any easier than

learning the first? In NeurIPS, 1996.

[29] Li Fei-Fei, Rob Fergus, and Pietro Perona. One-shot learning

of object categories. IEEE transactions on pattern analysis

and machine intelligence, 28(4):594–611, 2006.

[30] Brenden Lake, Ruslan Salakhutdinov, Jason Gross, and

Joshua Tenenbaum. One shot learning of simple visual concepts. In Proceedings of the Annual Meeting of the Cognitive

Science Society, volume 33, 2011.

[31] Brenden M Lake, Ruslan R Salakhutdinov, and Josh Tenenbaum. One-shot learning by inverting a compositional causal

process. In NeurIPS, 2013.

[32] Brenden M Lake, Ruslan Salakhutdinov, and Joshua B

Tenenbaum. Human-level concept learning through probabilistic program induction. Science, 350(6266):1332–1338,

2015.

[33] Alex Wong and Alan L Yuille. One shot learning via compositions of meaningful patches. In ICCV, 2015.

[34] Boris Oreshkin, Pau Rodr´ıguez Lopez, and Alexandre La- ´

coste. Tadam: Task dependent adaptive metric for improved

few-shot learning. In NeurIPS, 2018.

[35] Eleni Triantafillou, Richard Zemel, and Raquel Urtasun.

Few-shot learning through an information retrieval lens. In

NeurIPS, 2017.

[36] Bharath Hariharan and Ross Girshick. Low-shot visual

recognition by shrinking and hallucinating features. In

ICCV, 2017.

[37] Gregory Koch, Richard Zemel, and Ruslan Salakhutdinov.

Siamese neural networks for one-shot image recognition. In

ICML Workshop, 2015.

[38] Tsendsuren Munkhdalai and Hong Yu. Meta networks. In

ICML, 2017.

[39] Tsendsuren Munkhdalai, Xingdi Yuan, Soroush Mehri, and

Adam Trischler. Rapid adaptation with conditionally shifted

neurons. In ICML, 2018.

[40] Yu-Xiong Wang, Ross Girshick, Martial Hebert, and Bharath

Hariharan. Low-shot learning from imaginary data. In

CVPR, 2018.

[41] Wenbin Li, Lei Wang, Jinglin Xu, Jing Huo, Gao Yang, and

Jiebo Luo. Revisiting local descriptor based image-to-class

measure for few-shot learning. In CVPR, 2019.

[42] Yann Lifchitz, Yannis Avrithis, Sylvaine Picard, and Andrei

Bursuc. Dense classification and implanting for few-shot

learning. In CVPR, 2019.

[43] Sungwoong Kim Chang D. Yoo Jongmin Kim, Taesup Kim.

Edge-labeling graph neural network for few-shot learning. In

CVPR, 2019.

[44] Spyros Gidaris and Nikos Komodakis. Generating classification weights with gnn denoising autoencoders for few-shot

learning. In CVPR, 2019.

[45] Hongyang Li, David Eigen, Samuel Dodge, Matthew Zeiler,

and Xiaogang Wang. Finding task-relevant features for fewshot learning by category traversal. In CVPR, 2019.

[46] Chelsea Finn, Pieter Abbeel, and Sergey Levine. Modelagnostic meta-learning for fast adaptation of deep networks.

In ICML, 2017.

[47] Nanqing Dong and Eric P Xing. Few-shot semantic segmentation with prototype learning. In BMVC, 2018.

[48] Claudio Michaelis, Matthias Bethge, and Alexander S.

Ecker. One-shot segmentation in clutter. In ICML, 2018.

[49] Tao Hu, Pengwan, Chiliang Zhang, Gang Yu, Yadong Mu,

and Cees G. M. Snoek. Attention-based multi-context guiding for few-shot semantic segmentation. In AAAI, 2019.

[50] Liang-Yan Gui, Yu-Xiong Wang, Deva Ramanan, and Jose´

M. F. Moura. Few-shot human motion prediction via metalearning. In ECCV, 2018.

[51] Xuanyi Dong, Liang Zheng, Fan Ma, Yi Yang, and Deyu

Meng. Few-example object detection with model communication. IEEE transactions on pattern analysis and machine

intelligence, 41(7):1641–1654, 2018.

[52] Andreas Geiger, Philip Lenz, and Raquel Urtasun. Are we

ready for autonomous driving? the kitti vision benchmark

suite. In CVPR, 2012.

[53] Mark Everingham, Luc Van Gool, Christopher KI Williams,

John Winn, and Andrew Zisserman. The pascal visual object

classes (voc) challenge. International journal of computer

vision, 88(2):303–338, 2010.

[54] Alina Kuznetsova, Hassan Rom, Neil Alldrin, Jasper Uijlings, Ivan Krasin, Jordi Pont-Tuset, Shahab Kamali, Stefan

Popov, Matteo Malloci, Tom Duerig, and Vittorio Ferrari.

The open images dataset v4: Unified image classification,

object detection, and visual relationship detection at scale.

arXiv:1811.00982, 2018.

[55] Ranjay Krishna, Yuke Zhu, Oliver Groth, Justin Johnson,

Kenji Hata, Joshua Kravitz, Stephanie Chen, Yannis Kalantidis, Li-Jia Li, David A Shamma, et al. Visual genome:

Connecting language and vision using crowdsourced dense

image annotations. International Journal of Computer Vision, 123(1):32–73, 2017.

[56] Jia Deng, Wei Dong, Richard Socher, Li-Jia Li, Kai Li,

and Li Fei-Fei. Imagenet: A large-scale hierarchical image

database. In CVPR, 2009.

[57] George A Miller. Wordnet: a lexical database for english.

Communications of the ACM, 38(11):39–41, 1995.

[58] Luca Bertinetto, Jack Valmadre, Joao F Henriques, Andrea

Vedaldi, and Philip HS Torr. Fully-convolutional siamese

networks for object tracking. In ECCV, 2016.

[59] Erika Lu, Weidi Xie, and Andrew Zisserman. Class-agnostic

counting. In ACCV, 2018.

[60] Bo Li, Wei Wu, Qiang Wang, Fangyi Zhang, Junliang Xing,

and Junjie Yan. Siamrpn++: Evolution of siamese visual

tracking with very deep networks. In CVPR, 2019.

[61] Eli Schwartz, Leonid Karlinsky, Joseph Shtok, Sivan Harary,

Mattias Marder, Sharathchandra Pankanti, Rogerio Feris,

Abhishek Kumar, Raja Giries, and Alex M Bronstein. Repmet: Representative-based metric learning for classification

and one-shot object detection. In CVPR, 2019.

[62] Jasper RR Uijlings, Koen EA Van De Sande, Theo Gevers, and Arnold WM Smeulders. Selective search for object recognition. International journal of computer vision,

104(2):154–171, 2013.

[63] Navaneeth Bodla, Bharat Singh, Rama Chellappa, and

Larry S. Davis. Soft-nms improving object detection with

one line of code. In ICCV, 2017.

[64] C. Arteta, V. Lempitsky, and A. Zisserman. Counting in the

wild. In ECCV, 2016.

[65] Marius Cordts, Mohamed Omran, Sebastian Ramos, Timo

Rehfeld, Markus Enzweiler, Rodrigo Benenson, Uwe

Franke, Stefan Roth, and Bernt Schiele. The cityscapes

dataset for semantic urban scene understanding. In CVPR,

2016.

[66] Yuhua Chen, Wen Li, Christos Sakaridis, Dengxin Dai, and

Luc Van Gool. Domain adaptive faster r-cnn for object detection in the wild. In CVPR, 2018.