论文那些事—AdvDrop: Adversarial Attack to DNNs by Dropping Information

AdvDrop: 通过丢弃信息生成对抗样本去攻击DNN(ICCV2021)

1、摘要\背景

人有很强的抽象能力和联想力,例如一个由几块积木拼成的乐高玩具,小朋友也能轻易认出其中描述的场景。甚至几个像素,玩家也可以轻易认出这是哪个人物,但AI确没有那么容易识别。这不就满足了对抗样本的两个特性:1、人眼无法察觉对图片的改动 2、使机器能够识别错误

为此,我们提出了一种新的对抗性攻击,名为AdvDrop,它通过删除图像的现有信息来制作对抗性样本。以前,大多数对抗攻击都会在干净的图像上添加额外的干扰信息。与以前的工作相反,我们提出的工作从一个新的角度探讨了DNN模型的对抗性健壮性,通过丢弃不易察觉的细节来制作对抗性样本。

主要贡献有三方面:

- 为DNN生成对抗性攻击,打开了新的大门

- 证明了AdvDrop在目标和非目标攻击环境下的有效性,并且当前防御方法对此防御效果较差

- 使用可视化解释AdvDrop生成对抗样本

2、方法论

这里先讲一点背景知识,毕竟跨度有点大:

低频分量(低频信号)代表着图像中亮度或者灰度值变化缓慢的区域,也就是图像中大片平坦的区域,描述了图像的主要部分。主要对整幅图像强度的综合度量。

高频分量(高频信号)对应着图像变化剧烈的部分,也就是图像的边缘(轮廓)或者噪声以及细节部分,主要是对图像边缘和轮廓的度量。

DCT变换对图像进行压缩的原理是减少图像中的高频分量,高频主要是对应图像中的细节信息,而我们人眼对细节信息并不是很敏感,因此可以去除高频的信息量。另外,去掉50%的高频信息存储部分,图像信息量的损失不到5%。(DCT变换本身是无损的,但是在图像编码等领域给接下来的量化、哈弗曼编码等创造了很好的条件。)

对原始图像进行离散余弦变换,变换后DCT系数能量主要集中在部分位置,其余大部分系数接近于零。这样一来,描述不重要的分量 只需要很少的比特数;将变换后的DCT系数进行门限操作,将小于一定值得系数归零,这就是图像压缩中的量化过程,然后进行逆DCT运算,可以得到压缩后的图像。

离散余弦变换的公式为:

量化表(Y ,Cb ,Cr,DCT变换里的东西)和量化是两个概念

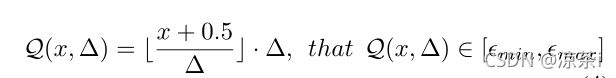

量化通过两个操作完成:舍入和截断。前者将原始值映射到最近的量化点,而后者限制量化值的范围公式如下:

反离散余弦变换的公式:

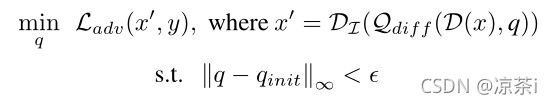

提出的AdvDrop首先将干净的图像从空间域转换到频域,然后应用量化降低转换图像的某些特定频率,然后将图像的频率信号反转回空间域。在优化过程中,AdvDrop仅调整以 ϵ 为界的量化表 q 的值。总之,我们的最终目标是:

![]() :损失函数,用于优化量化表q

:损失函数,用于优化量化表q

![]() 和

和![]() :表示对抗样本和真实样本

:表示对抗样本和真实样本

![]() 和

和![]() :表示DCT(从空间域转为频域)和IDCT(从频域转回空间域)

:表示DCT(从空间域转为频域)和IDCT(从频域转回空间域)

![]() 和:表示一个完整量化—去量化的过程,其中

和:表示一个完整量化—去量化的过程,其中![]() 表示量化,表示差分量化

表示量化,表示差分量化

q:量化表,每个点包含三个元素(Y ,Cb ,Cr)

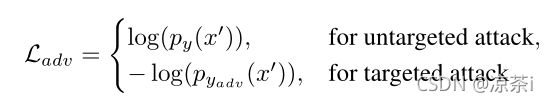

对于对抗损失,使用以下交叉熵损失:

量化:

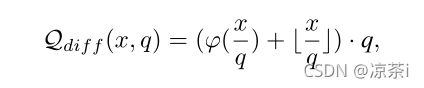

为了准确地调整量化表q,进一步提高攻击的成功率,我们通过反向传播利用目标模型f的梯度,将整个过程描述为一个优化问题。然而⌊·⌋ 是一个阶梯函数,因此是非微分函数,不能通过反向传播直接集成到优化中。于是提出另一个方法:

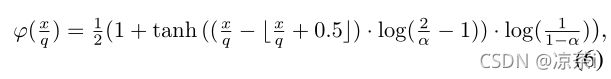

其中φ(·)近似于两个相邻量化值之间的变化。φ(·)处处连续可微,定义如下:

其中α是一个可调参数,用于控制两个相邻量化值之间斜率的陡度。在优化过程中,我们线性降低α值,以逐步逼近阶梯函数。α值在优化开始时确定,并在优化过程中逐渐减小,因此的行为与优化结束时所需的阶梯量化函数几乎相同。由于在优化过程中量化表q应该是整数,我们使用通过反向传播返回的梯度符号更新量化表q。表示为:

ϵ限制量化表q的范数,以进一步限制要丢弃的信息量。

3、实验结果

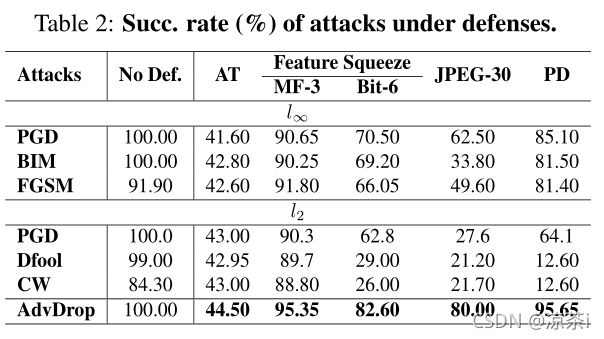

我认为本文最重要的实验体现在防御上,作者用了原来经典的攻击方法(PGD BIM FGSM DEEPFOOL CW)生成对抗样本,然后使用经典的防御防御方法来防御,发现AdvDrop除了对抗训练有效果,其他防御方法都难以抵御这种攻击,最大的原因就是生成方式不一样,而且基于去噪的防御也不行,因为使用AdvDrop本身已经去掉了很多东西,再进行去噪容易失真。

最后展示一波热力图:

重要特征基本都被除掉了。

4、总结

在本文中,我们从新的角度研究了对抗性鲁棒性,并提出了一种称为对抗性丢弃(AdvDrop)的新方法,该方法利用差分量化和对抗性攻击技术,通过丢弃图像的现有细节来制作对抗性样本。AdvDrop为DNNs的健壮性评估开辟了一条新途径。目前提出的AdvDrop仍然使用一种相对简单的方法,通过聚焦于频域来丢弃信息。我们计划在未来的工作中探索其他技术,从图像中删除信息。此外,我们还将探讨如何将AdvDrop应用于其他任务,例如DNN的可解释性。此外,针对AdvDrop的有效防御战略将是另一个关键和有希望的方向。

5、思路

1、使用图像修复技术以此来防御对抗样本,将标签映射回原来的区域

2、增强AdvDrop的攻击性能,将去除的特征以补丁的形式贴回到图片中

6、代码

有对抗样本代码方面的问题可以私信我,其实这篇论文代码是有一些问题的,也问过原作者,但作者也没有明确解释,有点差强人意=.=