AlexNet —— Part 1:论文导读

这是我读的有关深度学习的第一篇论文,希望是一个好的开始!

题目

AlexNet:《ImageNet Classification with Deep Convolutional Neural Networks》,基于深度卷积神经网络的图像分类。

注意:这里的深度是在2012年该模型是属于比较深的,但是在现在来看,是属于比较浅的。

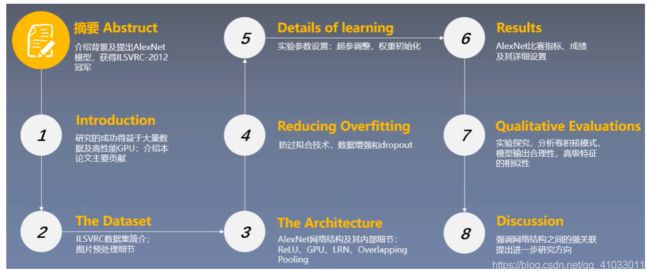

论文总览

首先,读一篇论文,我们第一遍通常需要泛读,即读这篇论文的题目,摘要,各个部分的标题和小标题,以及图片和表格。

下面是泛读之后整理出该篇论文大致分成8个部分。

Part 1:论文导读

研究背景

首先对于论文导读,我会从论文研究背景和研究成果及意义出发。

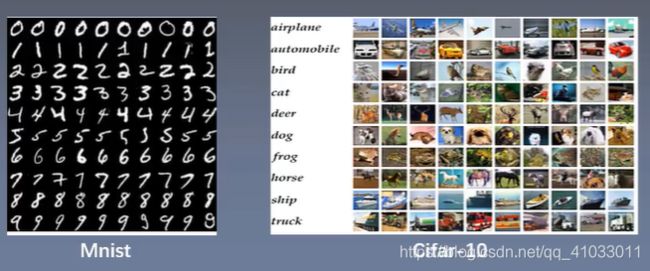

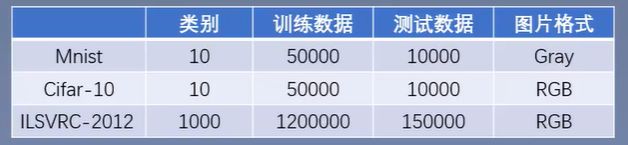

首先来看研究背景,我们从数据集出发,它的数据集是 ILSVRC-2012,ILSVRC 的全称是 “ImageNet Large Scale Visual Recognition Challenge”,即著名的 ImageNet 大规模图像识别挑战赛,这个挑战赛的数据量非常大。那么数据量是多大呢?我们通过以下对比就可以发现。在 CV 领域,我们常见的两个数据集就是 MNIST 和 Cifar-10。

MNIST 数据集(手写数字数据集),可以称之为 CV 领域中的 “hello world”,我们入门 CV 时第一个接触的数据集几乎都是 MNIST,MNIST数据集一共有10个类别,训练数据50000个,测试数据10000个,图片的格式为 Gray(灰度图),每张图片的分辨率为 28x28。相对来说,MNIST 数据集是一个比较小的数据集,所以常常被用来入门学习。第二个常见数据集是 Cifar-10,它也有10个分类,训练数据集和测试数据集也是50000个和10000个,但是它的图片格式为 RGB,每张图片的分辨率为 32x32。而这篇论文中的 ILSVRC-2012 数据集有1000个分类,训练数据集有120万,测试数据有15万,每张图片的格式为 RGB,分辨率为上百像素。所以,对比之下,ILSVRC 数据量真的很大了。

下 面我们再认识一下 ILSVRC:大规模的图像识别挑战赛,ImageNet Large Scale Visual Recognition Challenge 是李飞飞等人于2010年创办的图像识别挑战赛,自2010年起连续举办8年,极大地推动计算机视觉发展。其中比赛涵盖了:图像分类(Classification)、目标定位(Object Iocalization)、目标检测(Object detection)、视频目标检测(Object deteciton from video)、场景分类(Scene classification)、场景解析(Scene parsing)。在竞赛中脱颖而出了大量的经典模型:AlexNet、VGG、GoogleNet、ResNet、DensenNet 等等。

那么 ILSVRC 与这里反复提到的 ImageNet 数据集有什么关系呢?ImageNet 数据集包含 21841 个类别,共 14,197,122 张图片,其通过 WordNet 对类别进行分组,使数据集的语义信息更合理,非常适合图像识别。而 ILSVRC-2012 是从 ImageNet 中挑选 1000 类的 1,200,000 作为训练集。关于 ImageNet,可以跳转到官网进行查看更多详细信息。我们需要关注的就是 Task,其中重点关注 Top 5 error。

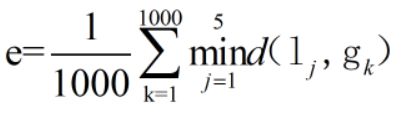

在上面一段话中,大致就是说:对于每一张图片,算法需要给出 5 个类别,如果 5 个类别中有一个分类正确,那么就不会去惩罚该模型,下面是 Top 5 error 的公式:

![]()

算法最后会给出 5 个预测的类别 l j l_j lj, j = 1 , . . . , 5 j = 1,...,5 j=1,...,5。而这张图片真实的标签是 g k , k = 1 , , . . . , n g_k, k = 1,,...,n gk,k=1,,...,n,因为该数据集一共有 1000 个类,所以 n n n = 1000。

举个栗子,假如我们现在预测的这张图片的真实 label 为 3( g k g_k gk = 3),而模型预测的 5 个分类分别是 1,2,3,4,5。现在用预测的分类 1 与 真实的 label 3 进行比较,不相等,所以 d ( l 1 , g 3 ) d(l_1, g_3) d(l1,g3) = 1,再用预测的分类 2 与 真实的 label 3 进行比较,不相等,所以 d ( l 2 , g 3 ) d(l_2, g_3) d(l2,g3) = 1,再用预测的分类 3 与 真实的 label 3 进行比较,相等,所以 d ( l 3 , g 3 ) d(l_3, g_3) d(l3,g3) = 0,以此类推,最后得到 5 个值。然后我们在这得出的 5 个值中取最小值。

以上就是关于 ImageNet 的一个简单的介绍。除了数据集造就了 AlexNet 的成功,还有一个非常重要的原因就是强大的计算资源 —— GPU,高性能计算资源使得大型神经网络可以快速训练。当时 AlexNet 是使用了2个内存为3G的580GPU共训练了6天。

研究成果

AlexNet 在 ILSVRC-2012 以超出第二名10.9个百分点夺冠。

- SIFT+FVS 是 ILSVRC-2012 分类任务的第二名,我们可以看到第二名的 Top-5 Error 为 26.2%。

- 1CNN:训练一个 AlexNet

- 5CNNs:训练 5 个 AlexNet 取平均值

- 1CNN*:在最后一个池化层之后,额外添加第六个卷积层,并使用 ImageNet 2011(秋)数据集上预训练

- 7 CNNs*:两个预训练微调,与 5CNNs 取平均值

那么,AlexNet 的历史意义是什么呢?

- 拉开卷积神经网络统治计算机视觉的序幕。

- 加速计算机视觉应用落地