数学建模(NO.15聚类模型)

聚类模型

- 一.应用

- 二.K-means聚类算法

-

- 1.算法流程

- 2.图解K-means算法

- 3.算法流程图

- 4.一些讨论

- 5.算法的评价

- 三.K-means++算法

-

- 1.算法基础

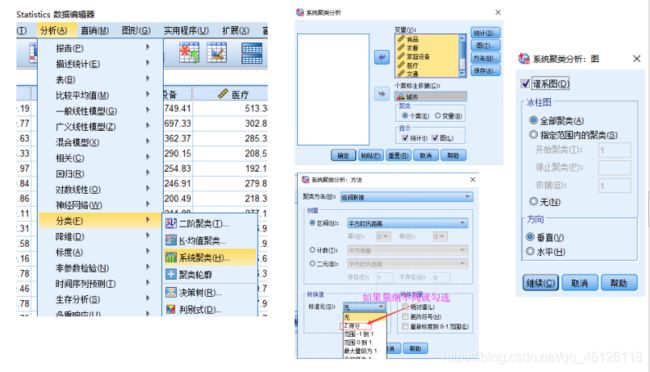

- 2. SPSS操作

- 四.系统(层次)聚类

-

- 1.概念

- 2. 算法流程

- 3.Spss软件操作

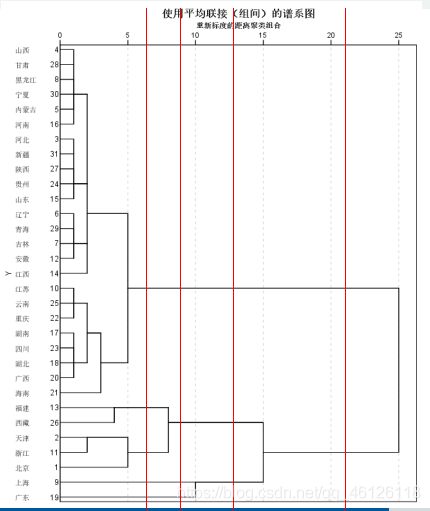

- 3.用图形估计聚类的数量

- 五.DBSCAN算法

-

- 1.基本说明

- 2.数据点分类

- 3.DBSCDN可视化

- 4.伪代码(维基百科)

- 5.Matlab代码

- 6.优缺点

一.应用

所谓的聚类,就是将样本划分为由类似的对象组成的多个类的过程。聚类后,我们可以更加

准确的在每个类中单独使用统计模型进行估计、分析或预测;也可以探究不同类之间的相关性和主要差异。

聚类和上一讲分类的区别:分类是已知类别的,聚类未知

二.K-means聚类算法

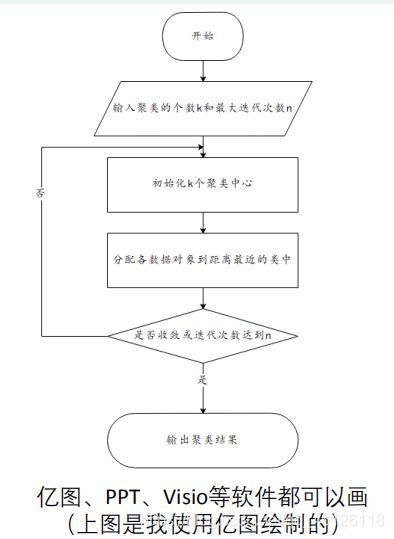

1.算法流程

一、指定需要划分的簇[cù]的个数K值(类的个数);

二、随机地选择K个数据对象作为初始的聚类中心(不一定要是我们的样本点);

三、计算其余的各个数据对象到这K个初始聚类中心的距离,把数据对象划归到距离它最近的那个中心所处在的簇类中;

四、调整新类并且重新计算出新类的中心;

五、循环步骤三和四,看中心是否收敛(不变),如果收敛或达到迭代次数则停止循环;

六、结束

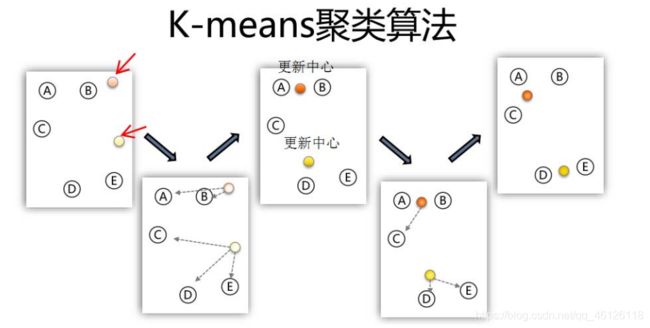

2.图解K-means算法

3.算法流程图

4.一些讨论

(1)聚类的个数K值怎么定?

答:分几类主要取决于个人的经验与感觉,通常的做法是多尝试几个K值,看分成几类的结果更好解释,更符合分析目的等。

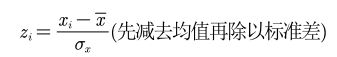

(2)数据的量纲不一致怎么办?

答:如果数据的量纲不一样,那么算距离时就没有意义。例如:如果X1单位是米,X2单位是吨,用距离公式计算就会出现“米的平方”加上“吨的平方”开平方,最后算出的东西没有数学意义,这就有问题了。

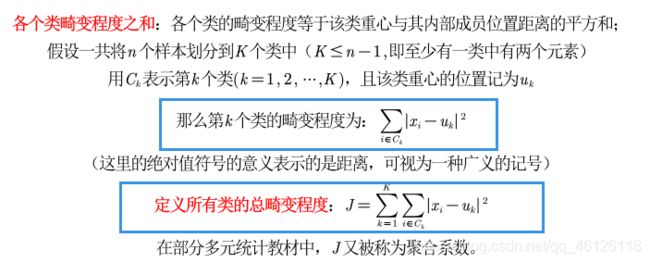

5.算法的评价

优点:

(1)算法简单、快速。

(2)对处理大数据集,该算法是相对高效率的。

缺点:

(1)要求用户必须事先给出要生成的簇的数目K。 (2)对初值敏感。

(3)对于孤立点数据敏感。

K‐means++算法可解决2和3这两个缺点。

三.K-means++算法

1.算法基础

k-means++算法选择初始聚类中心的基本原则是:初始的聚类中心之间的相互距离要尽可能的远。

算法描述如下:(只对K-means算法“初始化K个聚类中心” 这一步进行了优化)

步骤一:随机选取一个样本作为第一个聚类中心;

步骤二:计算每个样本与当前已有聚类中心的最短距离(即与最近一个聚类中心的距离),这个值越大,表示被选取作为聚类中心的概率较大;最后,用轮盘法(依据概率大小来进行抽选)选出下一个聚类中心;

步骤三:重复步骤二,直到选出K个聚类中心。选出初始点后,就继续使用标准的K-means算法了。

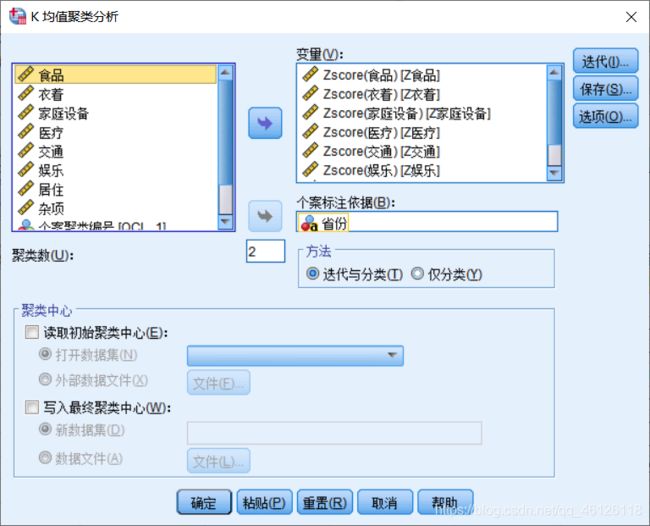

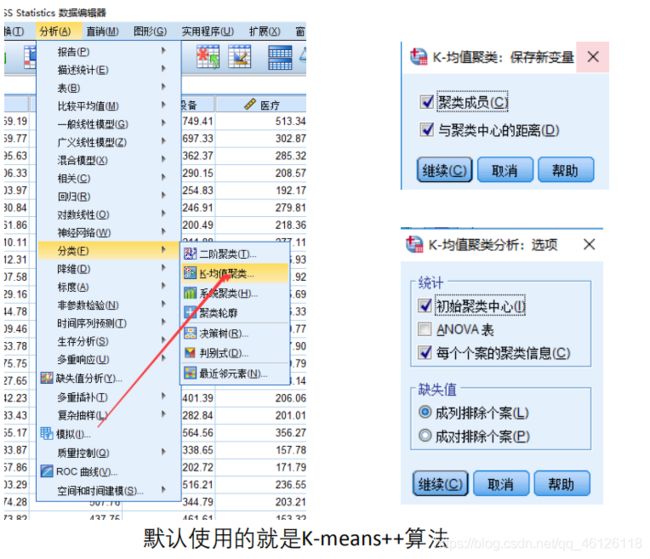

2. SPSS操作

四.系统(层次)聚类

1.概念

系统聚类的合并算法通过计算两类数据点间的距离,对最为接近的两类数据点进行组合,并反复迭代这一过程,直到将所有数据点合成一类,并生成聚类谱系图。

2. 算法流程

系统(层次)聚类的算法流程:

一、将每个对象看作一类,计算两两之间的最小距离;

二、将距离最小的两个类合并成一个新类;

三、重新计算新类与所有类之间的距离;

四、重复二三两步,直到所有类最后合并成一类;

五、结束

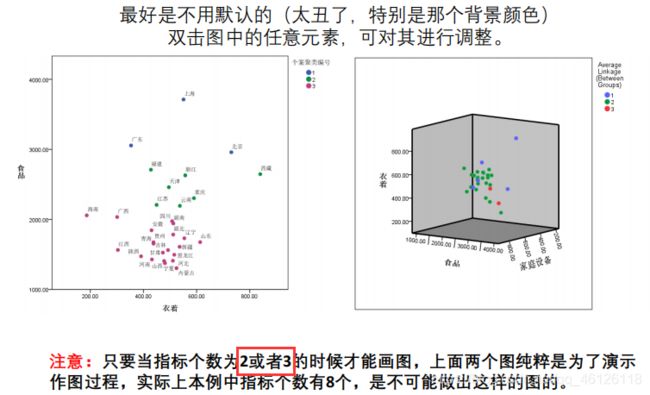

3.Spss软件操作

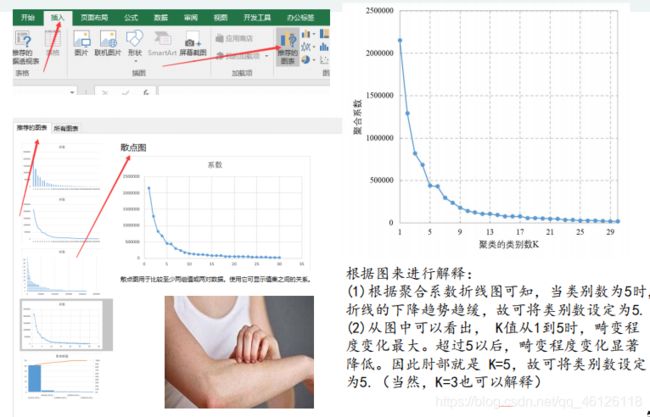

3.用图形估计聚类的数量

肘部法则(Elbow Method):通过图形大致的估计出最优的聚类数量。

聚合系数折线图

画图前先对数据进行处理

聚合系数折线图的画法

确定K后保存聚类结果并画图

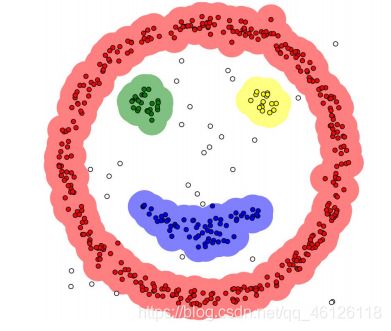

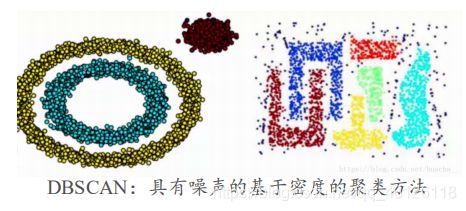

五.DBSCAN算法

1.基本说明

DBSCAN(Density-based spatial clustering of applications

with noise)是一种基于密度的聚类方法

聚类前不需要预先指定聚类的个数,生成的簇的个数不定(和数据有关)。

该算法利用基于密度的聚类的概念,即要求聚类空间中的一定区域内所包含对象(点或其他空间对象)的数目不小于某一给定阈值。

该方法能在具有噪声的空间数据库中发现任意形状的簇,可将密度足够大的相邻区域连接,能有效处理异常数据

2.数据点分类

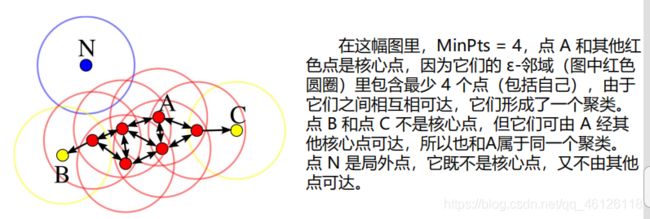

DBSCAN算法将数据点分为三类:

• 核心点:在半径Eps内含有不少于MinPts数目的点

• 边界点:在半径Eps内点的数量小于MinPts,但是落在核心

点的邻域内

• 噪音点:既不是核心点也不是边界点的点

3.DBSCDN可视化

4.伪代码(维基百科)

DBSCAN(D, eps, MinPts) {

C = 0

for each point P in dataset D {

if P is visited

continue next point

mark P as visited

NeighborPts = regionQuery(P, eps)

if sizeof(NeighborPts) < MinPts

mark P as NOISE

else {

C = next cluster

expandCluster(P, NeighborPts, C, eps, MinPts)

} } }

expandCluster(P, NeighborPts, C, eps, MinPts) {

add P to cluster C

for each point P' in NeighborPts {

if P' is not visited {

mark P' as visited

NeighborPts' = regionQuery(P', eps)

if sizeof(NeighborPts') >= MinPts

NeighborPts = NeighborPts joined with NeighborPts'

}

if P' is not yet member of any cluster

add P' to cluster C

} }

regionQuery(P, eps)

return all points within P's eps-neighborhood (including P)

5.Matlab代码

main.m

clc;

clear;

close all;

%% Load Data

load mydata;

%% Run DBSCAN Clustering Algorithm

epsilon=0.5;

MinPts=10;

IDX=DBSCAN(X,epsilon,MinPts);

%% Plot Results

% 如果只要两个指标的话就可以画图啦

% PlotClusterinResult(X, IDX);

% title(['DBSCAN Clustering (\epsilon = ' num2str(epsilon) ', MinPts = ' num2str(MinPts) ')']);

DBSCAN.m

function [IDX, isnoise]=DBSCAN(X,epsilon,MinPts)

C=0;

n=size(X,1);

IDX=zeros(n,1); % 初始化全部为0,即全部为噪音点

D=pdist2(X,X);

visited=false(n,1);

isnoise=false(n,1);

for i=1:n

if ~visited(i)

visited(i)=true;

Neighbors=RegionQuery(i);

if numel(Neighbors)<MinPts

% X(i,:) is NOISE

isnoise(i)=true;

else

C=C+1;

ExpandCluster(i,Neighbors,C);

end

end

end

function ExpandCluster(i,Neighbors,C)

IDX(i)=C;

k = 1;

while true

j = Neighbors(k);

if ~visited(j)

visited(j)=true;

Neighbors2=RegionQuery(j);

if numel(Neighbors2)>=MinPts

Neighbors=[Neighbors Neighbors2]; %#ok

end

end

if IDX(j)==0

IDX(j)=C;

end

k = k + 1;

if k > numel(Neighbors)

break;

end

end

end

function Neighbors=RegionQuery(i)

Neighbors=find(D(i,:)<=epsilon);

end

end

PlotClusterinResult.m

function PlotClusterinResult(X, IDX)

k=max(IDX);

Colors=hsv(k);

Legends = {};

for i=0:k

Xi=X(IDX==i,:);

if i~=0

Style = 'x';

MarkerSize = 8;

Color = Colors(i,:);

Legends{end+1} = ['Cluster #' num2str(i)];

else

Style = 'o';

MarkerSize = 6;

Color = [0 0 0];

if ~isempty(Xi)

Legends{end+1} = 'Noise';

end

end

if ~isempty(Xi)

plot(Xi(:,1),Xi(:,2),Style,'MarkerSize',MarkerSize,'Color',Color);

end

hold on;

end

hold off;

axis equal;

grid on;

legend(Legends);

legend('Location', 'NorthEastOutside');

end

6.优缺点

优点:

- 基于密度定义,能处理任意形状和大小的簇;

- 可在聚类的同时发现异常点;

- 与K-means比较起来,不需要输入要划分的聚类个数。

缺点: - 对输入参数ε和Minpts敏感,确定参数困难;

- 由于DBSCAN算法中,变量ε和Minpts是全局唯一的,当聚类的密度不均匀时,聚

类距离相差很大时,聚类质量差; - 当数据量大时,计算密度单元的计算复杂度大。

我的建议:

只有两个指标,且你做出散点图后发现数据表现得很“DBSCAN”,这时

候你再用DBSCAN进行聚类。

其他情况下,全部使用系统聚类吧。

K‐means也可以用,不过用了的话你论文上可写的东西比较少。