基于 NeRF 的 App 上架苹果商店,照片转 3D 只需一部手机,网友们玩疯了

目录

前言

Luma AI

NeRF 手机 App 是什么?

支持 iPhone 11 或以上机型

参考链接

前言

最近在做利用手机数据采集驱NeRF进行三维重建,调研到Luma AI这家公司,是一个很有代表性NeRF商业化公司。

以前有部分手机的相册自带3D建模功能,其原理就是使用后置相机把要建模的对象“扫描”一遍,而且还需要360°全方位扫描,最后手机就会生成一个3D模型文件以及预览。出于好奇,小雷以前就用手机体验过,但效果实在是太拉胯,模型面很粗糙,精度也是几乎没有。不过当时手机性能不强,摄像头素质也远不如今天的产品,所以建模效果就很差。

在快速建模里,NeRF也算是代表了,在专业影视、游戏等领域用的比较多,但早期的NeRF想要实现精准的3D建模,需要用专业相机拍摄几百张照片,拍照时还要严格按照参数坐标,结果才算足够精准。这些工作都要一个专业团队去搞定,更别说普通用户了。不过NeRF的代码数据都是开源的,意味着其它软件开发商也可以在NeRF的基础上加以改进或简化,Luma AI便是其中之一,而且生成都是在云服务器中完成的,估计创建过程也有AI的加入,不然效果也不会那么惊艳。Luma AI生成出来的模型还可以导入到Blender等游戏引擎中,这就意味着这款软件也能在专业的建模领域中应用,简化视觉团队的工作流程,估计建模师都要下岗了。但不得不说,Luma AI的出现还是很厉害的,大大降低了专业人士的生产难度,同时普通用户也能体验一把快速建模的乐趣。

Luma AI

只用一部手机,现实中的 2D 照片就能渲染出 3D 模型?

没错,无需再手动上传电脑或安装激光雷达,苹果手机自带 App 就能生成 3D 模型。

这个名叫 Luma AI 的“NeRF APP”,正式上架 App Store 后爆火:

小如 3D 装饰模型,兼具灯光和形状细节:

大到整个墓园的 3D 场景渲染版,都能被很好捕捉:

这样无论是风景、3D 物体还是人物,都可以被很好地保存进手机,并快速生成对应的 3D 模型。

所以这个 App 究竟包含什么功能,它又具体要如何使用?

NeRF 手机 App 是什么?

Luma AI 是一个基于 NeRF 打造的 APP,目前能在苹果商店中搜到:

NeRF 是少量 2D 照片生成 3D 场景的经典 AI 模型,最初版本由 UC 伯克利和谷歌开发,只需要输入少量静态图片,就能做到多视角的逼真 3D 效果。

最初 NeRF 需要专业相机拍几百张照片,并在拍照时严格遵守参数坐标,但由于它的代码数据开源,目前已经有不少简化版模型被开发出来。

不仅照片数量有所下降,从几百张到几十张甚至几张,对拍照位置和照相机的要求也有所降低。

但能直接通过 App 导引、随时随地可用的 NeRF,几乎还没出现过。

现在,Luma AI 团队基于云服务器,实现了这个可以实时渲染 3D 物体、产品或风景和场景的 APP。

它包含自动调整焦距、视角和画面比例调整等不同功能,捕捉到的 3D 场景则包含复杂形状、反射和照明等细节。

同时,制作得到的 3D 模型既可以直接分享到网上,比 2D 照片更全方位地展示细节:

也可以放进 Blender 等游戏引擎中,让它“动起来”:

现在,你也可以试一试了。

支持 iPhone 11 或以上机型

目前 Luma AI 支持 iPhone 11 或以上的机型,操作方法也很简单。

在苹果商店下载 App 后,只需要跟着导引,围绕 3D 物体一步步完成拍摄,NeRF 就能在后台将这些照片合成出一个 3D 模型,并实时导出:

支持的玩法也很多样,从调整焦距、效果预览都包括:

实际拍出来的效果,可以直接放进电影中,有运镜内味了:

所以,没有苹果手机怎么办?

在网页端上传照片也可以,视频和照片集二选一:

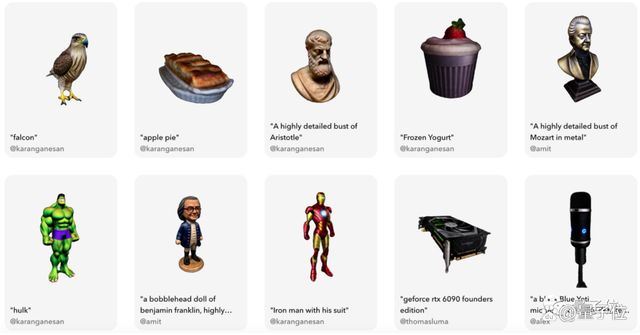

在 Luma AI 公开的 3D 模型分享库中,已经有不少网友上传了自己随手拍的 3D 模型:

目前支持导出的 3D 模型格式,主要包括 obj 和 gltf 两种。

你想好用它来拍出大片效果、做游戏模型,还是把家里的 3D 手办“电子化”了吗?

Luma AI 的强大之处

- 以逼真的 3D 方式捕获:照片写实感、反射和细节。

- 逼真的游戏资产:使用手机捕获无与伦比的优质资产,导出到任何游戏引擎。

Luma AI 的优势

无论是创建过程还是最终结果,Luma AI的 3D 建模精度是颠覆性的。用户只需要上传少量的图片, App 就能够把它快速渲染出来,不管是小物件,或是人物、大风景等复杂场景, Luma AI 都能够精准还原,甚至还能还原光照环境

参考链接

-

https://twitter.com/LumaLabsAI/status/1611466398546690048

-

https://captures.lumalabs.ai/imagine

-

https://apps.apple.com/us/app/luma-ai/id1615849914