- 厦门自由行之第一天:

大苏子在广漂

厦门三人行之杂记出发前一天:12️28日下午15:00从广州粗发,来深圳集合!但是中间发生一个小插曲,验票时候发现车票不见了,或许也是一场恶作剧,对于不排队的人,忍不住说了一下,接下来就发现车票不见了,已经是拿在手上!不过还好,可以凭借购票订单查看到信息,所以有惊无险,顺利进站!晚上三个人一起去吃了柠檬鱼,说实话,那会,感觉美吃饱,啊哈哈!晚上回来,两个人又开始彻夜长谈,发现身边优秀的人,一大把,

- 【安装环境】配置MMTracking环境

xuanyu22

安装环境机器学习神经网络深度学习python

版本v0.14.0安装torchnumpy的版本不能太高,否则后面安装时会发生冲突。先安装numpy,因为pytorch的安装会自动配置高版本numpy。condainstallnumpy=1.21.5mmtracking支持的torch版本有限,需要找到合适的condainstallpytorch==1.11.0torchvision==0.12.0cudatoolkit=10.2-cpytor

- 家庭杂记 2022.03.14

怡然自得的花花

1今天是孩子们居家学习的第一天,姐姐的第一次网课的第一堂课是班队课。老师在给孩子们讲了一些关于YQ当中在家学习时,如果遇到一些心理上的问题要如何去化解和处理的方法。晚上我和老马在讨论的时候就觉得现在的老师们或者说现在的教学在这一点上还是真是和我们那时候比起来进步了不少,开始更多地在关心孩子们的心理健康。我们所在片区虽然是FF区,但老马为了不给同事们造成一些心理压力,也主动提出了居家办公,可能接下来

- 安装torch报错 raise ReadTimeoutError(self._pool, None, “Read timed out.“) pip._vendor.urllib3.exceptions

待磨的钝刨

pippytorch人工智能

文章目录1.配置cuda的torch环境时报错1.配置命令2.报错bug2.解决方法1.增加下载超时时间:2.尝试使用镜像源:3.检查网络连接:4.分次安装:5.重试安装:6.手动下载.whl文件安装1.配置cuda的torch环境时报错1.配置命令pipinstalltorch==2.0.1torchvision==0.15.2torchaudio==2.0.2--index-urlhttps:

- SAM2跑通(Ubuntu20.04)内含安装多个cuda

好好607

pytorchlinux

参考链接:github链接安装cuda,之前借鉴的方法安装多个cuda补充cuda安装:Asymlinkalreadyexistsat/usr/local/cuda.Updatetothisinstallation?选择no,否则会创建一个软连接覆盖之前那个/usr/local/cudasudogedit~/.bashrc如果按第二个链接安装的cuda,手动改一下版本即可SAM环境安装步骤除了本地

- 英伟达(NVIDIA)B200架构解读

weixin_41205263

芯际争霸GPGPU架构gpu算力人工智能硬件架构

H100芯片是一款高性能AI芯片,其中的TransformerEngine是专门用于加速Transformer模型计算的核心部件。Transformer模型是一种自然语言处理(NLP)模型,广泛应用于机器翻译、文本生成等任务。TransformerEngine的电路设计原理主要包括以下几个方面:

- 使用vllIm部署大语言模型

添砖JAVA的小墨

机器学习

使用vllm部署大语言模型一般需要以下步骤:一、准备工作1.系统要求-操作系统:常见的Linux发行版(如Ubuntu、CentOS)或Windows(通过WSL)。-GPU支持:NVIDIAGPU并安装了适当的驱动程序。-足够的内存和存储空间。2.安装依赖-Python3.8及以上版本。-CUDA工具包(根据GPU型号选择合适的版本)。二、安装vllm1.创建虚拟环境(推荐)-使用Conda:c

- vllm在线推理踩坑记

懂点投资的码农

大语言模型ai语言模型python

最近在《AI大模型全栈工程师》课程里看老师推荐使用vllm部署大模型,优点就不详细介绍了,这里摘抄一段来自于Qwen2上手指南对于它的简单介绍:它易于使用,且具有最先进的服务吞吐量、高效的注意力键值内存管理(通过PagedAttention实现)、连续批处理输入请求、优化的CUDA内核等功能。至于原理就先不看了,直接上手部署,以后再来补理论知识。一、vLLM在线推理在Qwen2的上市指南里介绍了v

- 多版本cuda安装及灵活切换详细教程

Fzc_PCL

CUDALinux记录cudalinux

一、首先介绍下我所使用的环境ubuntu18.04+1080ti二、下载安装包1.cudatoolkit下载①环境选择,想要多版本共存的,尽量选择runfile文件进行安装②有些cudatoolkit下载页面,和我上边的一样,没有对应的安装包下载按钮,BaseInstaller中只给了两行命令,如果运行第一行命令的话,下载会比较慢,我是直接复制wget后边的链接在新网页窗口中打开,会自动弹出下载窗

- Cuda 程序编译报错: fatal error: cusparse.h: No such file or directory

原野寻踪

实践经验cuda

编译cuda程序时发现下列报错:/mnt/xxx/miniconda3/envs/xxx/lib/python3.8/site-packages/torch/include/ATen/cuda/CUDAContext.h:6:10:fatalerror:cusparse.h:Nosuchfileordirectory#include^~~~~~~~~~~~检查发现是选择了错误的Cuda版本。ls/

- 大四合院杂记(四十三,六相公的梦想就是吃饱饭)

高领001

四十三,六相公的梦想就是吃饱饭六相公是村里的五保户,一直单门独户,我们这些小屁孩的,小一点的喜欢听他讲故事,稍微大一点了,就会跟着更大一点的孩子瞎起哄:“相公相公,穿个花衣衫,娶个麻子婆,生个孩子没屁眼!”听他讲故事那时候,他很高兴,他喜欢讲他小时候受苦的故事,解放前,给财主放牛,吃不饱,穿不暖,还会挨打。他那时的梦想就是能吃饱饭。因为他是孤儿,住的地方是茅草棚子,夏天外面下大雨,里面下小雨;冬天

- 天下苦英伟达久矣!PyTorch官方免CUDA加速推理,Triton时代要来?

诗者才子酒中仙

物联网/互联网/人工智能/其他pytorch人工智能python

在做大语言模型(LLM)的训练、微调和推理时,使用英伟达的GPU和CUDA是常见的做法。在更大的机器学习编程与计算范畴,同样严重依赖CUDA,使用它加速的机器学习模型可以实现更大的性能提升。虽然CUDA在加速计算领域占据主导地位,并成为英伟达重要的护城河之一。但其他一些工作的出现正在向CUDA发起挑战,比如OpenAI推出的Triton,它在可用性、内存开销、AI编译器堆栈构建等方面具有一定的优势

- 放风筝杂记

心和

今天,我从平台买的风筝到了。正好是星期天,正好春暖,正好有和煦的微风,儿子自己挑的风筝,收到,他自然高兴,欢喜打开,安装好,我们俩一起去东边麦田里放风筝。我长这么大,还是第一次放飞风筝。儿子小,他把放风筝的任务交给了我,在我的记忆中,风筝开始要起跑才能飞起,我试了两次,不是这样。应该是边放飞边松拉线,风筝就上飞了,我放着轮里的线,它边随着线的增长而飘摇向上,直到我将线放的很长很长,它飞得很高很高,

- 元日杂记

花委尘

2019年的元旦,难得睡了个懒觉。醒来,朋友圈一片喜气洋洋迎新岁,各种群内红包漫天洒。我羡慕生活中这些无忧无虑,活色生香,离我似乎总远了一米。出门兜了一圈,天气倒随我,没有见雪为晴,而是一种逼仄的阴冷。说是白天,却有一种奇怪的亮,是老天爷一种似笑非笑,似哭非哭的表情。大概他也在尴尬着,摆不平雨雪风晴各路人马。我对这位老天爷很是无奈,因为他摆平了我。我在他面前谨小慎微,言听计从,可是他不偏爱我。自从

- 如何利用马桶时间?

琴弦X

琴弦一.读闲书马上、枕上、厕上。这是古人读闲书的三个指定位置。三日不读书,你就会有像没洗澡一样,一声脏污秽亏。古人还云:“有书真富贵,无事小神仙”。闲人读闲书,可以说是地上神仙,享尽人间清福。闲中觅伴书为上,身外无求睡最安,是非荣辱不到处,卷书一榻清昼眠。于是我总坐在马桶上翻个几页,不管是漫话杂志,还是画册小集,亦或是小诗杂记,还真有些,身心一起清的感觉。二.写杂记。趁着如此轻松,静谧之际,写上几

- GPU版pytorch安装

普通攻击往后拉

pythontips神经网络基础模型关键点

由于经常重装系统,导致电脑的环境需要经常重新配置,其中尤其是cudatorch比较难以安装,因此记录一下安装GPU版本torch的过程。1)安装CUDAtoolkit这个可以看做是N卡所有cuda计算的基础,一般都会随驱动的更新自动安装,但是不全,仍然需要安装toolkit,并不需要先看已有版本是哪个,反正下载完后会自动覆盖原有的cuda。下载网站两个:国内网站:只能下载最新的toolkit,但是

- 人工智能-GPU版本机器学习、深度学习模型安装

bw876720687

人工智能机器学习深度学习

背景1、在有Nvidia-GPU的情况下模型使用cuda加速计算,但是很有多模型的GPU和CPU版本安装方式不同,如何安装lgb\cat\xgb.2、为了让代码有普适性,如何自适应环境当中的设备进行CPU或者GPU的调整?解决方案问题一:安装GPU版本的LightGBMLightGBM默认不会安装GPU支持版,需要手动编译以启用GPU。以下是在Linux和Windows上编译GPU版本LightG

- 黄仁勋最新演讲全文:我忍受的一切挫折、痛苦和磨难淬炼了超能力|钛媒体AGI | 最新快讯...

深夜冒泡

媒体agi人工智能

“我们彻底改变了公司。我们也彻底改变了计算。”英伟达创始人、CEO黄仁勋(JensenHuang)钛媒体App获悉,当地时间6月15日,英伟达创始人、CEO黄仁勋(JensenHuang)参加美国加州理工学院第130届毕业典礼,并发表了一段题为“迎难而上抓住机会“(EmbraceChallengesandSeizeOpportunities)的主题演讲。黄仁勋畅谈了英伟达(NVIDIA)自1993

- 黄仁勋的思维世界:Nvidia的AI和游戏之王

AI小夏

人工智能游戏百度

在这个行业中,黄仁勋是一位举足轻重的人物,也是Nvidia的联合创始人之一。他因在创新方面的强大而富有远见的领导力而受到认可。从卑微的起点到领导一家改变了电子游戏和人工智能面貌的公司,黄仁勋的故事启迪了人们的雄心、韧性以及如何超前思考。早年生活和职业生涯黄仁勋出生于台湾,九岁时移居美国。在成长过程中,他的生活充满了辛劳和决心,这些品质后来成为他职业生涯的标志。随后,黄仁勋就读于俄勒冈州立大学,攻读

- 缩小模拟与现实之间的差距:使用 NVIDIA Isaac Lab 训练 Spot 四足动物运动

AI人工智能集结号

人工智能

目录在IsaacLab中训练四足动物的运动能力目标观察和行动空间域随机化网络架构和RL算法细节先决条件用法训练策略执行训练好的策略结果使用JetsonOrin在Spot上部署经过训练的RL策略先决条件JetsonOrin上的硬件和网络设置Jetson上的软件设置运行策略开始开发您的自定义应用程序由于涉及复杂的动力学,为四足动物开发有效的运动策略对机器人技术提出了重大挑战。训练四足动物在现实世界中上

- CUDA 编程入门(2):CUDA 调度模型

知识搬运工人

CUDAGPUCUDA

参考:CUDA编程入门(2):CUDA编程模型-知乎(zhihu.com)CUDA调度模型Block调度Block对应的物理硬件概念是SM,也就是说SM负责block中线程的执行,SM会为每个block分配需求的资源,比如寄存器,共享内存等,由于SM自身资源有限,因此它被分配到的block数量也是有限的,这取决于block中线程的资源需求。当所有的SM都饱和之后,剩下的blocks将会被暂时挂起,

- 病中杂记

Aaron_Swartz

*以前,总是认为自己喜欢运动,便可以疏忽对身体的照料。然,昨2日突染感冒,发烧。当夜甚是痛苦,整夜不得眠,欲求药而不得,只能忍着。中间起来好几回,都是弄水给自己喝。以至于两日不敢洗澡,衣物也不敢更换。白天到公司效率低下,然吾心中纵使有百般不愿,也只能独自承受,旁人亦不得见,意志消沉,天线落下。回到家中,暖气亦坏,其中心情,可想而知。但皆此种种,皆有因果,不造恶业,不得恶果。不做好事,焉得福报。回家

- Ubuntu 开机出现 recovering journal 无法进入图形界面解决流程(不通用,自用)

Artintel

学习ubuntu

远程连接进入命令行:rm-rf/etc/X11/xorg.confcp/etc/X11/xorg.conf.failsafe/etc/X11/xorg.confsudoservicelightdmstopsudoapt-getremovenvidia*cdjohn/qudong+cuda9.0\+\cudnn/sudochmoda+xnv.runsudo./nv.run-no-x-check-no

- Yolo-v3利用GPU训练make时发生错误:/usr/bin/ld: cannot find -lcuda

徐小妞66666

一.利用GPU训练Yolov3时,首先要修改MakeFile文件,修改格式如下:GPU=1(原来为0)CUDNN=1(原来为0)NVCC=/usr/local/cuda/bin/nvcc(新建,注意自己本机的地址)二.此时make产生错误/usr/bin/ld:cannotfind-lcuda1.查看MakeFile文件找到该行代码:LDFLAGS+=-L/usr/local/cuda/lib64

- 【环境搭建:onnx模型部署】onnxruntime-gpu安装与测试(python)(1)

2401_83703835

程序员python深度学习pytorch

cuda==10.2cudnn==8.0.3onnxruntime-gpu==1.5.0or1.6.0pipinstallonnxruntime-gpu==1.6.0###2.2方法二:onnxruntime-gpu不依赖于本地主机上cuda和cudnn在conda环境中安装,不依赖于本地主机上已安装的cuda和cudnn版本,灵活方便。这里,先说一下已经测试通过的组合:*python3.6,cu

- pytorch计算网络参数量和Flops

Mr_Lowbee

PyTorchpytorch深度学习人工智能

fromtorchsummaryimportsummarysummary(net,input_size=(3,256,256),batch_size=-1)输出的参数是除以一百万(/1000000)M,fromfvcore.nnimportFlopCountAnalysisinputs=torch.randn(1,3,256,256).cuda()flop_counter=FlopCountAna

- 使用TensorRT对YOLOv8模型进行加速推理

fengbingchun

DeepLearningCUDA/TensorRTYOLOv8TensorRT

这里使用GitHub上shouxieai的infer框架对YOLOv8模型进行加速推理,操作过程如下所示:1.配置环境,依赖项,包括:(1).CUDA:11.8(2).cuDNN:8.7.0(3).TensorRT:8.5.3.1(4).ONNX:1.16.0(5).OpenCV:4.10.02.cloneinfer代码:https://github.com/shouxieai/infer3.使用

- 华为云端畅玩《黑神话:悟空》

单车~

算法数据结构华为云服务器运维

在华为云端畅玩《黑神话:悟空》,其电脑配置最低要求如下28:操作系统:需要64位处理器和操作系统,如Windows1064-bit。处理器:IntelCorei5-8400/AMDRyzen51600。内存:16GBRAM。显卡:NVIDIAGeForceGTX10606GB/AMDRadeonRX5808GB。DirectX版本:11。存储空间:需要130GB可用空间,推荐使用固态硬盘(SSD)

- ONNX Runtime、CUDA、cuDNN、TensorRT版本对应

可keke

ML&DLpytorchdeeplearning

文章目录ONNXRuntime的安装ONNXRuntime与CUDA、cuDNN的版本对应ONNXRuntime与ONNX的版本对应ONNXRuntime、TensorRT、CUDA版本对应ONNXRuntime的安装官方文档注意,到目前为止,onnxruntime-gpu在CUDA12.x和CUDA11.x下的安装命令是不同的,仔细阅读官方文档。验证安装python>>>importonnxru

- 刘大杰《中国文学发展史》读书笔记48

小神仙记录薄

短篇小说的进展(一)严格地说起来,我国六朝时代的小说,还没有成形。这并不是因其内容的荒谬,而是因其形式与描写的拙劣与贫弱。六朝的作品,只是一些没有结构的残丛小语式的杂记,叙事没有布置,文笔亦极俗浅,实在还算不得小说。中国的文言短篇小说,在艺术上发生价值,在文学史上获得地位,是起于唐代的传奇。那些传奇,建立了相当完满的短篇小说的形式,由杂记式的残丛小语,变为洋洋大篇的文字,由三言两语的记录,变为非常

- apache ftpserver-CentOS config

gengzg

apache

<server xmlns="http://mina.apache.org/ftpserver/spring/v1"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="

http://mina.apache.o

- 优化MySQL数据库性能的八种方法

AILIKES

sqlmysql

1、选取最适用的字段属性 MySQL可以很好的支持大数据量的存取,但是一般说来,数据库中的表越小,在它上面执行的查询也就会越快。因此,在创建表的时候,为了获得更好的 性能,我们可以将表中字段的宽度设得尽可能小。例如,在定义邮政编码这个字段时,如果将其设置为CHAR(255),显然给数据库增加了不必要的空间,甚至使用VARCHAR这种类型也是多余的,因为CHAR(6)就可以很

- JeeSite 企业信息化快速开发平台

Kai_Ge

JeeSite

JeeSite 企业信息化快速开发平台

平台简介

JeeSite是基于多个优秀的开源项目,高度整合封装而成的高效,高性能,强安全性的开源Java EE快速开发平台。

JeeSite本身是以Spring Framework为核心容器,Spring MVC为模型视图控制器,MyBatis为数据访问层, Apache Shiro为权限授权层,Ehcahe对常用数据进行缓存,Activit为工作流

- 通过Spring Mail Api发送邮件

120153216

邮件main

原文地址:http://www.open-open.com/lib/view/open1346857871615.html

使用Java Mail API来发送邮件也很容易实现,但是最近公司一个同事封装的邮件API实在让我无法接受,于是便打算改用Spring Mail API来发送邮件,顺便记录下这篇文章。 【Spring Mail API】

Spring Mail API都在org.spri

- Pysvn 程序员使用指南

2002wmj

SVN

源文件:http://ju.outofmemory.cn/entry/35762

这是一篇关于pysvn模块的指南.

完整和详细的API请参考 http://pysvn.tigris.org/docs/pysvn_prog_ref.html.

pysvn是操作Subversion版本控制的Python接口模块. 这个API接口可以管理一个工作副本, 查询档案库, 和同步两个.

该

- 在SQLSERVER中查找被阻塞和正在被阻塞的SQL

357029540

SQL Server

SELECT R.session_id AS BlockedSessionID ,

S.session_id AS BlockingSessionID ,

Q1.text AS Block

- Intent 常用的用法备忘

7454103

.netandroidGoogleBlogF#

Intent

应该算是Android中特有的东西。你可以在Intent中指定程序 要执行的动作(比如:view,edit,dial),以及程序执行到该动作时所需要的资料 。都指定好后,只要调用startActivity(),Android系统 会自动寻找最符合你指定要求的应用 程序,并执行该程序。

下面列出几种Intent 的用法

显示网页:

- Spring定时器时间配置

adminjun

spring时间配置定时器

红圈中的值由6个数字组成,中间用空格分隔。第一个数字表示定时任务执行时间的秒,第二个数字表示分钟,第三个数字表示小时,后面三个数字表示日,月,年,< xmlnamespace prefix ="o" ns ="urn:schemas-microsoft-com:office:office" />

测试的时候,由于是每天定时执行,所以后面三个数

- POJ 2421 Constructing Roads 最小生成树

aijuans

最小生成树

来源:http://poj.org/problem?id=2421

题意:还是给你n个点,然后求最小生成树。特殊之处在于有一些点之间已经连上了边。

思路:对于已经有边的点,特殊标记一下,加边的时候把这些边的权值赋值为0即可。这样就可以既保证这些边一定存在,又保证了所求的结果正确。

代码:

#include <iostream>

#include <cstdio>

- 重构笔记——提取方法(Extract Method)

ayaoxinchao

java重构提炼函数局部变量提取方法

提取方法(Extract Method)是最常用的重构手法之一。当看到一个方法过长或者方法很难让人理解其意图的时候,这时候就可以用提取方法这种重构手法。

下面是我学习这个重构手法的笔记:

提取方法看起来好像仅仅是将被提取方法中的一段代码,放到目标方法中。其实,当方法足够复杂的时候,提取方法也会变得复杂。当然,如果提取方法这种重构手法无法进行时,就可能需要选择其他

- 为UILabel添加点击事件

bewithme

UILabel

默认情况下UILabel是不支持点击事件的,网上查了查居然没有一个是完整的答案,现在我提供一个完整的代码。

UILabel *l = [[UILabel alloc] initWithFrame:CGRectMake(60, 0, listV.frame.size.width - 60, listV.frame.size.height)]

- NoSQL数据库之Redis数据库管理(PHP-REDIS实例)

bijian1013

redis数据库NoSQL

一.redis.php

<?php

//实例化

$redis = new Redis();

//连接服务器

$redis->connect("localhost");

//授权

$redis->auth("lamplijie");

//相关操

- SecureCRT使用备注

bingyingao

secureCRT每页行数

SecureCRT日志和卷屏行数设置

一、使用securecrt时,设置自动日志记录功能。

1、在C:\Program Files\SecureCRT\下新建一个文件夹(也就是你的CRT可执行文件的路径),命名为Logs;

2、点击Options -> Global Options -> Default Session -> Edite Default Sett

- 【Scala九】Scala核心三:泛型

bit1129

scala

泛型类

package spark.examples.scala.generics

class GenericClass[K, V](val k: K, val v: V) {

def print() {

println(k + "," + v)

}

}

object GenericClass {

def main(args: Arr

- 素数与音乐

bookjovi

素数数学haskell

由于一直在看haskell,不可避免的接触到了很多数学知识,其中数论最多,如素数,斐波那契数列等,很多在学生时代无法理解的数学现在似乎也能领悟到那么一点。

闲暇之余,从图书馆找了<<The music of primes>>和<<世界数学通史>>读了几遍。其中素数的音乐这本书与软件界熟知的&l

- Java-Collections Framework学习与总结-IdentityHashMap

BrokenDreams

Collections

这篇总结一下java.util.IdentityHashMap。从类名上可以猜到,这个类本质应该还是一个散列表,只是前面有Identity修饰,是一种特殊的HashMap。

简单的说,IdentityHashMap和HashM

- 读《研磨设计模式》-代码笔记-享元模式-Flyweight

bylijinnan

java设计模式

声明: 本文只为方便我个人查阅和理解,详细的分析以及源代码请移步 原作者的博客http://chjavach.iteye.com/

import java.util.ArrayList;

import java.util.Collection;

import java.util.HashMap;

import java.util.List;

import java

- PS人像润饰&调色教程集锦

cherishLC

PS

1、仿制图章沿轮廓润饰——柔化图像,凸显轮廓

http://www.howzhi.com/course/retouching/

新建一个透明图层,使用仿制图章不断Alt+鼠标左键选点,设置透明度为21%,大小为修饰区域的1/3左右(比如胳膊宽度的1/3),再沿纹理方向(比如胳膊方向)进行修饰。

所有修饰完成后,对该润饰图层添加噪声,噪声大小应该和

- 更新多个字段的UPDATE语句

crabdave

update

更新多个字段的UPDATE语句

update tableA a

set (a.v1, a.v2, a.v3, a.v4) = --使用括号确定更新的字段范围

- hive实例讲解实现in和not in子句

daizj

hivenot inin

本文转自:http://www.cnblogs.com/ggjucheng/archive/2013/01/03/2842855.html

当前hive不支持 in或not in 中包含查询子句的语法,所以只能通过left join实现。

假设有一个登陆表login(当天登陆记录,只有一个uid),和一个用户注册表regusers(当天注册用户,字段只有一个uid),这两个表都包含

- 一道24点的10+种非人类解法(2,3,10,10)

dsjt

算法

这是人类算24点的方法?!!!

事件缘由:今天晚上突然看到一条24点状态,当时惊为天人,这NM叫人啊?以下是那条状态

朱明西 : 24点,算2 3 10 10,我LX炮狗等面对四张牌痛不欲生,结果跑跑同学扫了一眼说,算出来了,2的10次方减10的3次方。。我草这是人类的算24点啊。。

然后么。。。我就在深夜很得瑟的问室友求室友算

刚出完题,文哥的暴走之旅开始了

5秒后

- 关于YII的菜单插件 CMenu和面包末breadcrumbs路径管理插件的一些使用问题

dcj3sjt126com

yiiframework

在使用 YIi的路径管理工具时,发现了一个问题。 <?php

- 对象与关系之间的矛盾:“阻抗失配”效应[转]

come_for_dream

对象

概述

“阻抗失配”这一词组通常用来描述面向对象应用向传统的关系数据库(RDBMS)存放数据时所遇到的数据表述不一致问题。C++程序员已经被这个问题困扰了好多年,而现在的Java程序员和其它面向对象开发人员也对这个问题深感头痛。

“阻抗失配”产生的原因是因为对象模型与关系模型之间缺乏固有的亲合力。“阻抗失配”所带来的问题包括:类的层次关系必须绑定为关系模式(将对象

- 学习编程那点事

gcq511120594

编程互联网

一年前的夏天,我还在纠结要不要改行,要不要去学php?能学到真本事吗?改行能成功吗?太多的问题,我终于不顾一切,下定决心,辞去了工作,来到传说中的帝都。老师给的乘车方式还算有效,很顺利的就到了学校,赶巧了,正好学校搬到了新校区。先安顿了下来,过了个轻松的周末,第一次到帝都,逛逛吧!

接下来的周一,是我噩梦的开始,学习内容对我这个零基础的人来说,除了勉强完成老师布置的作业外,我已经没有时间和精力去

- Reverse Linked List II

hcx2013

list

Reverse a linked list from position m to n. Do it in-place and in one-pass.

For example:Given 1->2->3->4->5->NULL, m = 2 and n = 4,

return

- Spring4.1新特性——页面自动化测试框架Spring MVC Test HtmlUnit简介

jinnianshilongnian

spring 4.1

目录

Spring4.1新特性——综述

Spring4.1新特性——Spring核心部分及其他

Spring4.1新特性——Spring缓存框架增强

Spring4.1新特性——异步调用和事件机制的异常处理

Spring4.1新特性——数据库集成测试脚本初始化

Spring4.1新特性——Spring MVC增强

Spring4.1新特性——页面自动化测试框架Spring MVC T

- Hadoop集群工具distcp

liyonghui160com

1. 环境描述

两个集群:rock 和 stone

rock无kerberos权限认证,stone有要求认证。

1. 从rock复制到stone,采用hdfs

Hadoop distcp -i hdfs://rock-nn:8020/user/cxz/input hdfs://stone-nn:8020/user/cxz/运行在rock端,即源端问题:报版本

- 一个备份MySQL数据库的简单Shell脚本

pda158

mysql脚本

主脚本(用于备份mysql数据库): 该Shell脚本可以自动备份

数据库。只要复制粘贴本脚本到文本编辑器中,输入数据库用户名、密码以及数据库名即可。我备份数据库使用的是mysqlump 命令。后面会对每行脚本命令进行说明。

1. 分别建立目录“backup”和“oldbackup” #mkdir /backup #mkdir /oldbackup

- 300个涵盖IT各方面的免费资源(中)——设计与编码篇

shoothao

IT资源图标库图片库色彩板字体

A. 免费的设计资源

Freebbble:来自于Dribbble的免费的高质量作品。

Dribbble:Dribbble上“免费”的搜索结果——这是巨大的宝藏。

Graphic Burger:每个像素点都做得很细的绝佳的设计资源。

Pixel Buddha:免费和优质资源的专业社区。

Premium Pixels:为那些有创意的人提供免费的素材。

- thrift总结 - 跨语言服务开发

uule

thrift

官网

官网JAVA例子

thrift入门介绍

IBM-Apache Thrift - 可伸缩的跨语言服务开发框架

Thrift入门及Java实例演示

thrift的使用介绍

RPC

POM:

<dependency>

<groupId>org.apache.thrift</groupId>

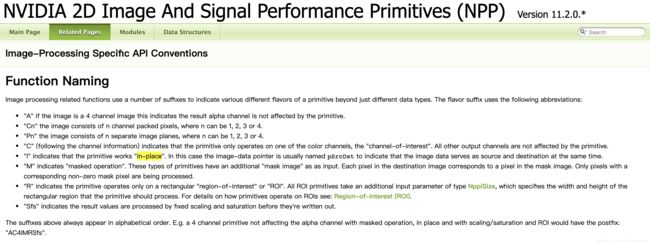

例如函数NppStatus nppiAbs_16s_C1IR_Ctx (Npp16s *pSrcDst, int nSrcDstStep, NppiSize oSizeROI, NppStreamContext nppStreamCtx)就支持in-place。

例如函数NppStatus nppiAbs_16s_C1IR_Ctx (Npp16s *pSrcDst, int nSrcDstStep, NppiSize oSizeROI, NppStreamContext nppStreamCtx)就支持in-place。![]()