大数据之Kerberos认证与kafka开启Kerberos配置

一、数据安全与Kerberos认证原理

数据安全的概念

- 数据安全 = 认证 + 授权

-

授权是指用户可以访问的资源,比如:授权用户张三不能访问ods层的表,可以访问dwd层和dws层的表。再比如java中基于角色的身份认证RBAC(Role-Based Access Control)基于角色的权限控制。通过角色关联用户,角色关联权限的方式间接赋予。比如大数据中使用的Sentry和Ranger的授权框架的权限管理。

-

认证主要是对用户的身份确认,比如最简单的用户的登录需要账户和密码;比如java的认证框架sa-token、Shiro、SpringSecurity等。

-

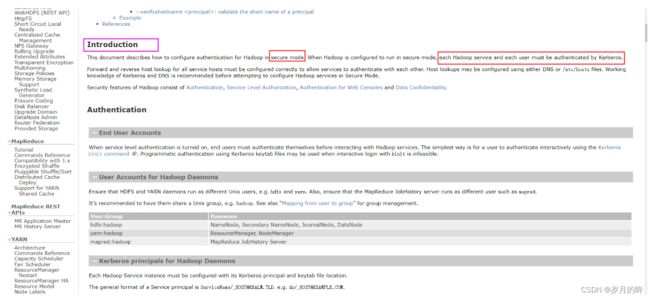

hadoop官网的认证主要是使用麻省理工MIT的kerberos认证的。

-

hadoop官网文档关于安全认证的相关介绍链接:https://hadoop.apache.org/docs/r3.2.2/hadoop-project-dist/hadoop-common/SecureMode.html

-

授权使用什么框架呢?目前授权,一般使用Sentry和Ranger来进行授权管理。比如目前比较强大的Ranger授权框架,可以精确都某张表的字段的操作,比如:可以定义张三用户可以访问某表的那些字段,那些字段无法访问。

Kerberos认证原理

Kerberos 概述

什么是 Kerberos

Kerberos 是一种计算机网络认证协议,用来在非安全网络中,对个人通信以安全的手段进行身份认证。这个词又指麻省理工学院为这个协议开发的一套计算机软件。软件设计上采用客户端/服务器结构,并且能够进行相互认证,即客户端和服务器端均可对对方进行身份认证。可以用于防止窃听、防止重放攻击、保护数据完整性等场合,是一种应用对称密钥体制进行密钥管理的系统。

Kerberos 术语

- Kerberos 中有以下一些概念需要了解:

1)KDC(Key Distribute Center):密钥分发中心,负责存储用户信息,管理发放票据。

2)Realm:Kerberos 所管理的一个领域或范围,称之为一个 Realm。

3)Principal:Kerberos 所管理的一个用户或者一个服务,可以理解为 Kerberos 中保存的一个账号, 其格式通常如下:primary/instance@realm

4)keytab:Kerberos 中的用户认证,可通过密码或者密钥文件证明身份,keytab 指密钥文件。

对以上的专业术语进行解释:

- 首先,所谓认证也就是用户的登录需要用户名和密码,这也是最基本的认证方式;那么KDC负责存储用户信息,也就是KDC内置的Database会存储用户的用户名和密码;那么kdc发放的票据是什么票据呢?这个票据是指某个用户访问服务时所需要的票据,相当于门票。

- Realme域又指的是什么呢?他指代的是Kerberos 所管理的一个领域或范围,所谓的领域也就是一系列的服务和用户。

- Principal是指Kerberos 所管理的一个用户或者一个服务,可以理解为 Kerberos 中保存的一个账号。

- 一个用户要想通过kerberos认证得需要一个账号和密码,同样的一个服务要想通过kerberos 认证也需要账号和密码;

- 格式 primary/instance@realm 三个部分,用户名or服务名 / 实例(服务主机名)@域名;例如:root/[email protected] 如下图:

Hadoop的认证使用的是Kerberos协议。

keytab:Kerberos 中的用户认证,可通过密码或者密钥文件证明身份,keytab 指密钥文件。

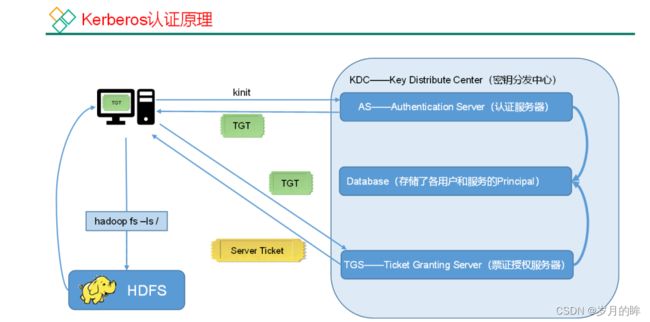

Kerberos 认证原理

-

AS: Authentication Server认证服务器,首先用户进行身份认证,kinit命令进行认证,然后输入密码;此时认证服务器会根据用户输入的账号和密码到数据库Database中查询,看是否正确,如果正确颁发临时的票据,这个票据就是TGT,它是Ticket Granting Ticket的缩写,这个票据名称为:申请票据的票据。

-

用户拿到这个用来申请服务票据的票据后,然后携带该票据TGT去访问票据授权服务器,然后票据授权服务器TGS去数据库中查询服务是否为合法的服务;

查询到相关服务名和秘钥后,颁发票证给用户。

-

用户拿到这个TG票证后然后才能访问我们的服务,比如上图拿到票证访问hdfs服务。这就是kerberos的基本认证原理。

二、Kerberos使用流程与kafka开启安全认证

查看kerberos服务

-

启动 KDC服务:

- systemctl status krb5kdc

-

若未启动 执行启动命令:

- systemctl start krb5kdc

-

启动 Kadmin,该服务为 KDC 数据库访问入口:

- systemctl start kadmin

-

查看kadmin服务状态

- systemctl status kadmin

创建 Kerberos 管理员用户

在 KDC 所在主机(hadoop102),执行以下命令,并按照提示输入密码,若已经创建,无需重复重复创建。

- kadmin.local -q “addprinc admin/admin”

Kerberos 使用概述

Kerberos 数据库操作

登录数据库并创建主体

1)本地登录(无需认证)

[root@warehouse ~]# kadmin.local

Authenticating as principal root/[email protected] with

password.

kadmin.local: (这里执行一些命令)

-

list_principals ==> 查看所有主体

-

addprinc test ==> 创建主体名称test

-

cpw test ==> 修改主体的密码

-

退出输入:exit

也可通过以下 shell 命令直接创建主体

[root@warehouse ~]# kadmin.local -q"addprinc test"

2)远程登录(需进行主体认证,认证操作见下文)

[root@warehouse ~]# kadmin —>按照提示输入密码

Authenticating as principal admin/[email protected] with

password.

Password for admin/[email protected]:

kadmin:

Kerberos 认证操作

1. 密码认证

1)使用 kinit 进行主体认证,并按照提示输入密码

[root@warehouse ~]# kinit test

Password for [email protected]:

2)查看认证凭证 klist

[root@warehouse keytab]# klist

Ticket cache: FILE:/tmp/krb5cc_0

Default principal: [email protected]

Valid starting Expires Service principal

2022-08-08T00:43:12 2022-08-09T00:43:12 krbtgt/[email protected]

2. 密钥文件认证

1)生成主体 test 的 keytab 文件到指定目录

[root@warehouse ~]# kadmin.local -q “xst -norandkey -k /etc/security/keytab/test.keytab [email protected]”

Authenticating as principal test/[email protected] with password.

Entry for principal [email protected] with kvno 3, encryption type aes256-cts-hmac-sha1-96 added to keytab WRFILE:/etc/security/keytab/test.keytab.

Entry for principal [email protected] with kvno 3, encryption type aes128-cts-hmac-sha1-96 added to keytab WRFILE:/etc/security/keytab/test.keytab.

Entry for principal [email protected] with kvno 3, encryption type des3-cbc-sha1 added to keytab WRFILE:/etc/security/keytab/test.keytab.

Entry for principal [email protected] with kvno 3, encryption type arcfour-hmac added to keytab WRFILE:/etc/security/keytab/test.keytab.

Entry for principal [email protected] with kvno 3, encryption type camellia256-cts-cmac added to keytab WRFILE:/etc/security/keytab/test.keytab.

Entry for principal [email protected] with kvno 3, encryption type camellia128-cts-cmac added to keytab WRFILE:/etc/security/keytab/test.keytab.

Entry for principal [email protected] with kvno 3, encryption type des-hmac-sha1 added to keytab WRFILE:/etc/security/keytab/test.keytab.

Entry for principal [email protected] with kvno 3, encryption type des-cbc-md5 added to keytab WRFILE:/etc/security/keytab/test.keytab.

注:-norandkey 的作用是声明不随机生成密码,若不加该参数,会导致之前的密码失效。

2)使用 keytab 进行认证

[root@warehouse ~]# kinit -kt /etc/security/keytab/test.keytab test

3)查看认证凭证

[root@warehouse keytab]# klist

Ticket cache: FILE:/tmp/krb5cc_0

Default principal: [email protected]

Valid starting Expires Service principal

2022-08-08T01:02:06 2022-08-09T01:02:06 krbtgt/[email protected]

3. 销毁凭证 kdestroy

Kafka配置Kerberos安全认证

1)创建用户和生成用户keytab

在安装 Kerberos的kdc服务的机器上进入 kadmin(Kerberos 服务端上使用 kadmin.local,安装了 Kerberos Client 的机器上可以使用 kadmin),然后执行如下命令分别创建服务端和客户端的 keytab:

# 创建服务端的keytab,在不同的机器上使用不同主机名对应的keytab文件,格式:principal/hostname@realm

[root@warehouse keytab]# kadmin

Authenticating as principal admin/[email protected] with password.

Password for admin/[email protected]:

kadmin远程登录数据库kadmin ==> 创建kafka-server的服务主体生成秘钥

kadmin: add_principal -randkey kafka-server/warehouse

WARNING: no policy specified for kafka-server/[email protected]; defaulting to no policy

Principal “kafka-server/[email protected]” created.

导出秘钥到对应的目录/etc/security/keytab/kafka-service.keytab ==> 生成的秘钥文件为kafka-service.keytab

kadmin: xst -k /etc/security/keytab/kafka-service.keytab kafka-server/[email protected]

shell命令的方式创建服务主体:kafka-client

$ kadmin.local -q “add_principal -randkey kafka-client”

Authenticating as principal admin/[email protected] with password.

WARNING: no policy specified for [email protected]; defaulting to no policy

Principal “[email protected]” created.

导出秘钥到指定的文件夹下

[root@warehouse keytab]# kadmin.local -q “xst -k /etc/security/keytab/kafka-client.keytab [email protected]”

Authenticating as principal admin/[email protected] with password.

Entry for principal [email protected] with kvno 2, encryption type aes256-cts-hmac-sha1-96 added to keytab WRFILE:/etc/security/keytab/kafka-client.keytab.

2)认证服务主体

kinit -kt /etc/security/keytab/kafka-server.service.keytab kafka-server/[email protected]

kinit -kt /etc/security/keytab/kafka-client.service.keytab kafka-client/[email protected]

3)Kerberos 相关配置

拷贝 krb5.conf 及kafka.keytab 文件都放到 Kafka 的 $KAFKA_HOME/config/kerberos 目录下(kerberos 目录需新建)。

这个路径:/opt/module/kafka/config/kerberos

$ mkdir $KAFKA_HOME/config/kerberos

$ cp /etc/security/keytab/kafka*.keytab $KAFKA_HOME/config/kerberos/

将krd5.conf也复制到$ KAFKA_HOME/config/kerberos目录下

# 将krd5.conf也复制到$KAFKA_HOME/config/kerberos目录下

$ cp /etc/krb5.conf $KAFKA_HOME/config/kerberos/

3)Kafka 服务端配置

1、修改server.properties

复制 $KAFKA_HOME/config/server.properties(复制动作能帮助我们在 认证/非认证 模式自由切换)重命名为 $KAFKA_HOME/config/server-sasl.properties

cd … 到config目录下

然后执行cp命令,如下所示:

[root@warehouse config]# cp server.properties server-sasl.properties

[root@warehouse config]# ll

【温馨提示】其中sasl.kerberos.service.name要和principal的名称相同

listeners=SASL_PLAINTEXT://0.0.0.0:19092

advertised.listeners=SASL_PLAINTEXT://warehouse:19092

security.inter.broker.protocol=SASL_PLAINTEXT

sasl.mechanism.inter.broker.protocol=GSSAPI

sasl.enabled.mechanisms=GSSAPI

sasl.kerberos.service.name=kafka-server

新建 kafka-server-jaas.conf 文件,该文件也放到 Kafka 的 $KAFKA_HOME/config/kerberos/ 目录下:

vim kafka-server-jaas.conf

KafkaServer {

com.sun.security.auth.module.Krb5LoginModule required

useKeyTab=true

//不同的主机,需修改成不同的keytab文件

keyTab="/opt/module/kafka/config/kerberos/kafka-server.service.keytab"

storeKey=true

useTicketCache=false

//不同的主机,需修改为本机的主机名

principal="kafka-server/[email protected]";

};

//Zookeeper client authentication,配置跟KafkaServer 一样,如果zookeeper开启了kerberos认证,就得加这段配置,我

这没开,所以先注释了

//Client {

// com.sun.security.auth.module.Krb5LoginModule required

// useKeyTab=true

// 不同的主机,需修改成不同的keytab文件

// keyTab="/opt/bigdata/hadoop/server/kafka_2.13-3.1.1/config/kerberos/kafka-server.keytab"

// storeKey=true

// useTicketCache=false

// 不同的主机,需修改为本机的主机名

// principal="kafka-server/[email protected]";

//};

2、修改kafka-server-start.sh

复制 bin/kafka-server-start.sh 脚本重命名为 bin/kafka-server-start-sasl.sh

$ cp $KAFKA_HOME/bin/kafka-server-start.sh $KAFKA_HOME/bin/kafka-server-start-sasl.sh

在倒数第二行增加如下配置(bin/kafka-server-start-sasl.sh):

export KAFKA_OPTS="-Dzookeeper.sasl.client=false -Dzookeeper.sasl.client.username=zk-server

-Djava.security.krb5.conf=/opt/module/kafka/config/kerberos/krb5.conf

-Djava.security.auth.login.config=/opt/module/kafka/config/kerberos/kafka-server-jaas.conf"

【温馨提示】如果 Zookeeper 开启 Kerberos 认证,则这里 zookeeper.sasl.client 就得设为 true。

4)Kafka 客户端配置

1、配置client.properties

该配置主要为了使用 bin/kafka-topics.sh、bin/kafka-console-consumer.sh、kafka-console-producer.sh 等命令。

新建 client.properties 文件,该文件也放到 Kafka 的 $KAFKA_HOME/config/kerberos 目录下:

执行命令

$ cat > $KAFKA_HOME/config/kerberos/client.properties <2、配置kafka-client-jaas.conf

新建 kafka-client-jaas.conf 文件,该文件也放到 Kafka 的 config/kerberos 目录下:

$ cat > $KAFKA_HOME/config/kerberos/kafka-client-jaas.conf <3、配置kafka-topics.sh等操作文件

复制 bin/kafka-topics.sh、bin/kafka-console-producer.sh、bin/kafka-console-consumer.sh 脚本,分别重命名为 bin/kafka-topics-sasl.sh、bin/kafka-console-producer-sasl.sh、bin/kafka-console-consumer-sasl.sh 执行一下命令:

$ cp $KAFKA_HOME/bin/kafka-topics.sh $KAFKA_HOME/bin/kafka-topics-sasl.sh

$ cp $KAFKA_HOME/bin/kafka-console-producer.sh $KAFKA_HOME/bin/kafka-console-producer-sasl.sh

$ cp $KAFKA_HOME/bin/kafka-console-consumer.sh $KAFKA_HOME/bin/kafka-console-consumer-sasl.sh

$ cp $KAFKA_HOME/bin/kafka-consumer-groups.sh $KAFKA_HOME/bin/kafka-consumer-groups-sasl.sh

在倒数第二行增加如下配置(bin/kafka-xxx.sh):

export KAFKA_OPTS="-Djava.security.krb5.conf=/opt/module/kafka/config/kerberos/krb5.conf

-Djava.security.auth.login.config=/opt/module/kafka/config/kerberos/kafka-client-jaas.conf"

【温馨提示】上面创建了两个keytab文件,但是权限都是一样,都可以操作所有,所以在企业生成环境中,可以考虑把客户端的用户权限控制一下。

5)将配置文件copy到其它机器上(单节点忽略此步)

# kafka kerberos配置

$ scp -r $KAFKA_HOME/config/kerberos hadoop-node2:$KAFKA_HOME/config/

$ scp -r $KAFKA_HOME/config/kerberos hadoop-node3:$KAFKA_HOME/config/

# kafka server启动脚本

$ scp $KAFKA_HOME/bin/kafka-server-start-sasl.sh hadoop-node2:$KAFKA_HOME/bin/

$ scp $KAFKA_HOME/bin/kafka-server-start-sasl.sh hadoop-node3:$KAFKA_HOME/bin/

# 【温馨提示】注意修改broker.id、advertised.listeners

# kafka server 配置

$ scp $KAFKA_HOME/config/server-sasl.properties hadoop-node2:$KAFKA_HOME/config/

$ scp $KAFKA_HOME/config/server-sasl.properties hadoop-node3:$KAFKA_HOME/config/

# topic操作

$ scp $KAFKA_HOME/bin/kafka-topics-sasl.sh hadoop-node2:$KAFKA_HOME/bin/

$ scp $KAFKA_HOME/bin/kafka-topics-sasl.sh hadoop-node3:$KAFKA_HOME/bin/

# 生产者

$ scp $KAFKA_HOME/bin/kafka-console-producer-sasl.sh hadoop-node2:$KAFKA_HOME/bin/

$ scp $KAFKA_HOME/bin/kafka-console-producer-sasl.sh hadoop-node3:$KAFKA_HOME/bin/

# 消费者

$ scp $KAFKA_HOME/bin/kafka-console-consumer-sasl.sh hadoop-node2:$KAFKA_HOME/bin/

$ scp $KAFKA_HOME/bin/kafka-console-consumer-sasl.sh hadoop-node3:$KAFKA_HOME/bin/

# 消费组

$ scp $KAFKA_HOME/bin/kafka-consumer-groups-sasl.sh hadoop-node2:$KAFKA_HOME/bin/

$ scp $KAFKA_HOME/bin/kafka-consumer-groups-sasl.sh hadoop-node3:$KAFKA_HOME/bin/

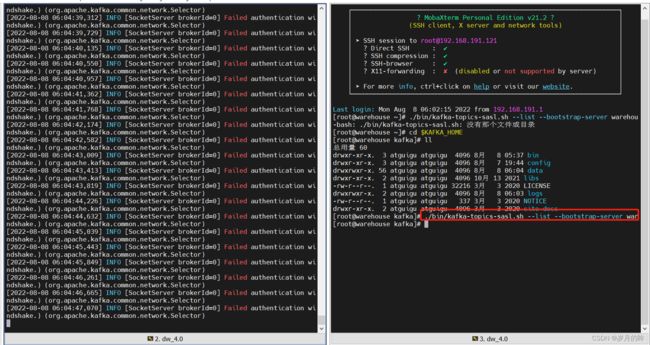

6)测试验证

1、查看topic 列表

运行 bin/kafka-server-start-sasl.sh 启动 Kafka 集群:

# 启动kafka

$ cd $KAFKA_HOME

$ ./bin/kafka-server-start-sasl.sh config/server-sasl.properties

# 还是跟之前的一样查询,会发现已经不能查询了

$ ./bin/kafka-topics-sasl.sh --list --bootstrap-server warehouse:19092

查询主题列表,服务端报的错误,无法查询证明安全认证生效了

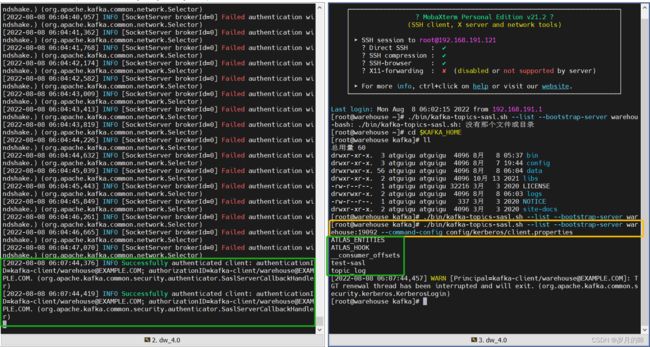

正确访问方式

$ cd $KAFKA_HOME

$ ./bin/kafka-topics-sasl.sh --list --bootstrap-server warehouse:19092 --command-config config/kerberos/client.properties

2、创建topic

$ cd $KAFKA_HOME

$ ./bin/kafka-topics-sasl.sh --create --topic test-sasl --bootstrap-server warehouse:19092 --partitions 1 --replication-factor 1 --config retention.ms=259200000 --command-config config/kerberos/client.properties

3、查看topic详情

$ cd $KAFKA_HOME

$ ./bin/kafka-topics-sasl.sh --bootstrap-server warehouse:19092 --describe --topic test-sasl --command-config config/kerberos/client.properties

4、删除topic

彻底删除topic:

1、删除kafka存储目录(server.properties文件log.dirs配置,默认为"/tmp/kafka-logs")相关topic目录

2、如果配置了delete.topic.enable=true直接通过命令删除,如果命令删除不掉,直接通过zookeeper-client 删除掉broker下的topic即可。

命令示例: kafka-topics.sh --delete --topic XXX --zookeeper localhost:2181

$ cd $KAFKA_HOME

$ ./bin/kafka-topics-sasl.sh --delete --topic test-sasl --bootstrap-server warehouse:19092 --command-config config/kerberos/client.properties

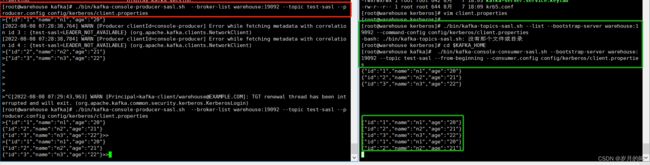

4、生产/消费

运行 kafka-console-producer-sasl.sh 生产消息:

$ cd $KAFKA_HOME

$ ./bin/kafka-console-producer-sasl.sh --bootstrap-server warehouse:19092 --topic test-sasl --producer.config config/kerberos/client.properties

-------------------------------------------

./bin/kafka-console-producer-sasl.sh --broker-list warehouse:19092 --topic test-sasl --producer.config config/kerberos/client.properties

-------------------------------------------

{"id":"1","name":"n1","age":"20"}

{"id":"2","name":"n2","age":"21"}

{"id":"3","name":"n3","age":"22"}

运行 bin/kafka-console-consumer-sasl.sh 消费消息:

$ cd $KAFKA_HOME

$ ./bin/kafka-console-consumer-sasl.sh --bootstrap-server warehouse:19092 --topic test-sasl --from-beginning --consumer.config config/kerberos/client.properties

#消费组

$ ./bin/kafka-console-consumer-sasl.sh --bootstrap-server warehouse:19092 --topic test-sasl --from-beginning --group test-sasl --consumer.config config/kerberos/client.properties

5、查看消费组积压

$ cd $KAFKA_HOME

$ ./bin/kafka-consumer-groups-sasl.sh --bootstrap-server warehouse:19092 --describe --group test-sasl --command-config config/kerberos/client.properties