Learning to See in the Dark

文章链接:https://arxiv.org/pdf/1805.01934.pdf github:https://github.com/cchen156/Learning-to-See-in-the-Dark

1.摘要

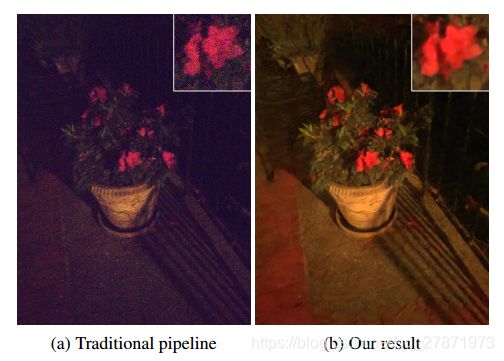

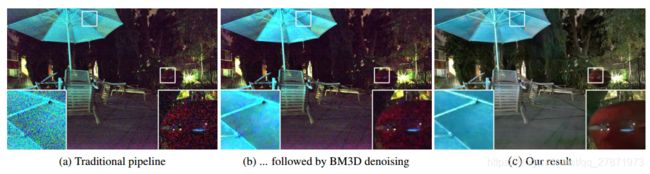

人们提出了各种图像去噪、去模糊和增强技术,但它们在极端条件下的效果是有限的,例如夜间视频速率成像。为了支持基于学习的低亮度图像处理管道的开发,我们收集了一个原始短曝光低光图像数据集,以及相应的长曝光参考图像。利用所提供的数据集,作者开发了一个基于全卷积网络端到端训练的低光图像处理基线模型。

大多数现有的低光图像处理方法都是在合成数据或没有ground truth的真实低光图像上进行评估的。目前还没有用于训练和测试技术的公共数据集,用于处理具有不同真实世界数据和ground truth的快速弱光图像。因此,作者收集了一个在低光照条件下快速曝光的原始图像的新数据集。每个弱光图像都有对应的长曝光高质量参考图像。我们在新数据集上展示了很有希望的结果:低光图像放大了300倍,成功的降噪和正确的颜色变换。作者训练深神经网络学习低光原始数据的图像处理管道,包括颜色变换、去噪、降噪和图像增强。通过对管道进行端到端的训练,避免了传统相机处理管道在这种情况下的噪声放大和误差积累。

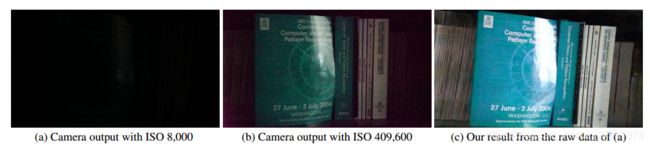

图像拍摄环境:黑暗的室内环境,相机的照度< 0:1勒克斯,索尼α7S II传感器暴露在1/30秒。

图像拍摄环境:黑暗的室内环境,相机的照度< 0:1勒克斯,索尼α7S II传感器暴露在1/30秒。(a)以iso8000摄影机拍摄的影像。(b)采用iso409,600摄影机拍摄的影像。图像存在噪声和颜色偏差。(c)我们的卷积网络产生的图像应用于(a)的原始传感器数据。

2.Related Work

Image denoising

图像去噪是低层次视觉研究中一个非常成熟的问题。提出了多种方法,如全变差、小波域处理、稀疏编码、核范最小化、3D变换域滤波等。这些方法通常基于特定的图像先验,如平滑度、稀疏度、低秩或自相似性。研究人员还探索了深度网络在去噪中的应用,包括叠加稀疏去噪自编码器深度自编码器、卷积网络等。当训练到一定的噪声水平时,这些数据驱动方法可以与最先进的经典技术(稀疏编码)对比。然而,大多数现有的方法都是在合成数据的基础上进行评估的,比如添加了高斯或椒盐噪声的图像。

Low-light image enhancement

现在研究中有多种技术来增强弱光图像的对比度。一个经典的选择是直方图均衡化,它平衡了整个图像的直方图。另一种广泛使用的技术是伽玛校正,它可以在压缩明亮像素的同时提高黑暗区域的亮度。更高级的方法执行更多的全局分析和处理,例如使用逆暗通道先验、小波变换、视网膜x射线模型。然而,这些方法通常假设图像已经包含了场景内容的良好表示。它们不显式地模拟图像噪声,并且通常作为后处理应用现成的去噪。相比之下,作者考虑的是极端低光成像,具有严重的噪声和颜色失真,超出了现有增强管道的工作条件。

3.See-in-the-Dark Dataset

作者收集了一个新的数据集,用于训练和基准标定原始弱光图像的单图像处理。该数据集包含5094张原始的短时间曝光图像,每一张都有对应的长曝光参考图像。多个短曝光图像可以对应同一个长曝光参考图像。例如,收集短曝光图像序列来评估突发去噪方法。序列中的每个图像都被算作一个不同的弱光图像,因为每个图像都包含真实的成像工件,对于训练和测试非常有用。SID中明显的长曝光参考图像数为424。数据集包含室内和室外图像。户外图像通常是在夜间,在月光或街灯下拍摄的。室外场景的相机照度一般在0.2lux到5lux之间。室内图像更暗。这些照片是在关着的房间里拍摄的,房间里的灯都是关着的,为了拍摄这些照片,房间里设置了微弱的间接照明。在室内场景中,相机的照度一般在0.03lux到0.3lux之间。

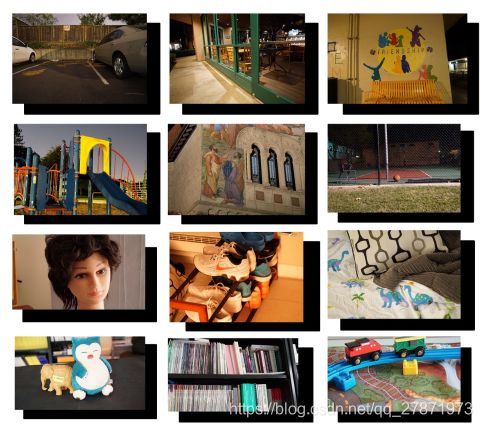

SID数据集。户外图片在最上面两排,室内图片在最下面两排。

SID数据集。户外图片在最上面两排,室内图片在最下面两排。

长曝光参考(ground truth)图像显示在前面;后面显示的是短曝光输入图(基本上是黑色)。

相机的照度一般在户外0.2 - 5lux之间,室内0.03 - 0.3lux之间。

4. Method

4.1. Pipeline

传统的图像处理方法从成像传感器获取原始数据后,采用白平衡、去噪、去噪、锐化、颜色空间转换、伽玛校正等模块。这些模块通常针对特定的摄像机进行调整。Jiang提议使用大量的局部、线性和学习型(L3)滤波器来近似现代消费者成像系统中发现的复杂非线性模型。然而无论是传统模型还是L3模型都无法成功处理快速低光成像,因为它们无法处理极低的信噪比。Hasinoff描述了智能手机相机的突发成像模型。这种方法可以通过对多幅图像进行对齐和混合而产生良好的效果,但是会带来一定程度的复杂性,例如,由于需要密集的对应估计,并且可能不容易扩展到视频捕获。

作者提出使用端到端学习来直接处理快速弱光图像。具体来说,我们训练一个全卷积网络(FCN)来执行整个图像处理算法。图3(b)说明了所述算法的结构。对于Bayer Raw,将输入打包到四个颜色通道中,并进行两倍的下采样(如上图)。对于X-trans类型的图像数据,数据被安排成6x6的块,可以通过交换相邻元素的方法将其分到九个通道里(图中没有显示)。然后减去图像的黑色像素并按照一定尺度对图像像素进行缩放,最后网络输出是12通道只有一半分辨率的图像数据,通过一个sub-pixel层可以恢复到原来的分辨率。

经过初步探索,作者重点研究了构成模型核心的全卷积网络的两种通用结构:一种是最近用于快速图像处理的多尺度上下文聚合网络(CAN),另一种是U-net。影响作者选择框架结构的另一个考虑因素是内存消耗:选择了能够在GPU内存中处理全分辨率图像的网络结构U-net。

放大比决定了输出的亮度。在我们的模型中,放大比是在外部设置的,作为管道的输入,类似于摄像机中的ISO设置。下图显示了不同放大倍数的效果。用户可以通过设置不同的放大系数来调整输出图像的亮度。在测试时,管道进行盲噪声抑制和颜色变换。网络将处理后的图像直接输出到sRGB空间。

SID数据集(Sony x100子集)中室内图像的放大系数对patch的影响。放大系数作为我们的模型的外部输入,类似于摄像机中的ISO设置。放大系数越高,图像越明亮。这个图显示了不同放大系数的模型输出。

SID数据集(Sony x100子集)中室内图像的放大系数对patch的影响。放大系数作为我们的模型的外部输入,类似于摄像机中的ISO设置。放大系数越高,图像越明亮。这个图显示了不同放大系数的模型输出。

4.2. Training

论文使用 L1 损失和 Adam 优化,从零开始训练,在训练期间,网络输入是原始的短曝光图像,在 sRGB 空间中的真实数据是相应的长曝光时间图像(由一个原始图像处理库 libraw 处理过得参考图像)。为每台相机训练一个网络,并将原始图像和参考图像之间曝光时间的倍数差作为的放大因子(例如:x100,x250,或x300)。在每次训练迭代中,随机裁剪一个512×512的补丁用于训练并利用翻转、旋转等操作来随机增强数据。

5. Experiments

作者在实验部分充分对比和模型和以往的算法,以及作者自己的框架内部一些不同结构的调整的效果。

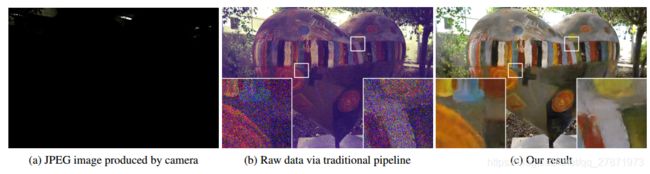

(a)由ISO 800光圈f/7.1,曝光1/30秒的富士胶片X-T2相机在夜间拍摄的图像;照相机的照度大约是1lux;(b)用传统管道处理原始数据不能有效地处理数据中的噪声和颜色偏差;c)作者从相同的原始数据中得到的结果。