深夜炸场!OpenAI 首次开发者日:新模型发布,支持 128K 上下文,价格直降,GPT 商店要来了

作者 | 袁滚滚 责编 | 屠敏

现场观察团、图片摄影 | Keven Liu

出品 | CSDN(ID:CSDNnews)

距离 ChatGPT 在去年 11 月 30 日低调上线,已经接近一周年。这期间 OpenAI 处在绝对领导地位,推动着全球进入了「大模型时代」,并开启了新一轮的创新创业热潮。

OpenAI 的首次 DevDay 开发者日活动,于今日北京时间 11 月 7 日凌晨 02:00 开始,Keynote 主论坛环节由 Sam Altman 主讲并在油管现场直播,配合现场的演示,展示了多款新产品的发布,整整 45 分钟,内容紧凑而真诚。

Keynote 亮点摘要:

OpenAI 开发者数据:全球超过 200 万开发者在使用 OpenAI 旗下的开发者服务,其中 90% 来自世界 500 强企业,目前 OpenAI 每周活跃用户超过一亿;

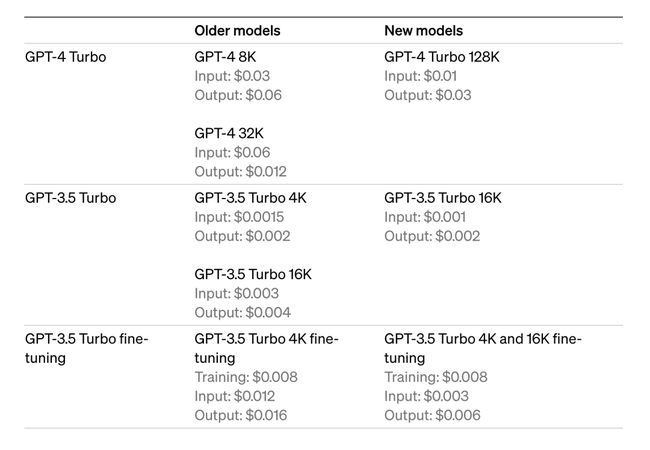

GPT-4 Turbo:最新发布 GPT-4 Turbo 支持 128K 上下文窗口,Token 的费用相较 GPT-4,低至原定价的 1/3 和 1/2;知识库更新至 2023 年 4 月;API 现在支持图片和文本输入;新版本中的 JSON 模式可以强制 GPT 以纯 JSON 格式响应;集成 DALL-E 3、语音合成等新能力。

版权保护功能:承诺为 API 用户与企业客户提供版权保护服务及侵权赔偿服务。

定制化 GPT & GPTs 应用商店:每个人都可以构建自己的 GPT,GPTs 应用商店即将于本月晚些时候正式发布,开发者可上传自己的 GPT 并获得收入。

Assistants API :开发者可以通过 Assistants API 提供的各类工具(检索、代码解释器、Python)、提供沙箱环境构建,高效创建 AI Agents。

多模态能力提升:GPT-4 Turbo with Vision、DALL-E 3 和 TextToSpeech 工具现已上线,发布语音合成模型 tts-1、tts-1-hd 和语音转文字模型 Whisper 3。

GPT-4 Turbo 正式发布,支持 128k 上下文窗口

今日发布的 GPT-4 Turbo,最大的改动在于知识库的更新截至 2023 年 4 月,相较于过往版本只收录了 2021 年 9 月前的世界知识,GPT-4 Turbo 拥有了更新的知识库。

另外就是 GPT-4 Turbo 支持 128k 上下文窗口,相当于 300 多页文本的内容。Altman 还强调本次优化模型性能后,与 GPT-4 相比还能够极大地压缩 Token 的使用成本。

GPT-4 Turbo 还加入了 JSON 模式,这确保模型将使用有效的 JSON 进行响应。新的 API 参数 response_format 使模型能够限制其输出,以生成语法正确的 JSON 对象。JSON 模式对于开发者在函数调用之外,在对话窗口就能完成 API 中生成 JSON。

此前网络中一直传言将在本次开发者日上正式发布 GPT-5,最终只见证了 GPT-4 Turbo 的到来。虽然不能消除开发者们对 GPT-5 不能及时发布的遗憾,但是也能感受到 OpenAI 在重大版本发布上的谨慎与克制。

GPT 商店即将上线:OpenAI 的生态野心

科技圈常常将 ChatGPT 出现,类比于苹果发布 iPhone 这类跨时代重大事件。在这次发布会的 GPTs 这部分,就能够感受到 OpenAI 想通过模型技术建立更大生态的雄心壮志。

根据 Sam Altman 的解释,GPTs 是针对特定目的进行自定义的 ChatGPT 版本,无需任何写代码的经验,完全靠自然语言的输入,就可以创造出属于自己的 GPTs。现场 OpenAI 提供了自定义 GPT 示例:Canva 和 ZapierAI ,通过非常简单的交互,就可以实现自定义 GPT 的生成。

目前部分自定义 GPT 已经支持 ChatGPT Plus 和企业用户试用。

除了在主论坛环节详细介绍 GPTs 生态之外,OpenAI 已经在官网上发布了博客文章,详细介绍 GPTs 的特性与设计理念。在官方发布的一段视频,展示了如何使用一个宠物医生 GPT 来解决狗狗日常护理的问题。

目前已经有 Amgen、Bain、and Square 等几家公司,已经开始使用 GPT 提供的 自定义 GPT 进入业务,预计将在近期向 API 用户和企业客户端用户全面开放。

同时,在本月晚些时候,OpenAI 将会推出 GPT 商店功能,主要用于分享用户构建的自定义 GPT 助手。

Assistants API:Agent 第一步

Assistants API 是帮助开发者在自己的程序中构建 Agent 的第一步,是一种专门构建的人工智能产品,具有特定的指令,利用额外的知识,并且可以调用模型和工具来执行任务。新的 Assistants API 提供了代码解释器和检索以及函数调用等新功能,可以处理你以前必须自己完成的大量繁重工作,并使你能够构建高质量的 AI 应用程序。

代码解释器:在沙盒执行环境中编写和运行 Python 代码,可以生成图形和图表,并处理具有不同数据和格式的文件。它允许开发者迭代运行代码来解决复杂的代码和数学问题等等。

检索:利用模型之外的知识来增强助手,例如专有领域数据、产品信息或用户提供的文档。这意味着开发者不需要计算和存储文档的嵌入,或实现分块和搜索算法。Assistants API 根据在 ChatGPT 中构建知识检索的经验,优化了要使用的检索技术。

函数调用:使助手能够调用你定义的函数并将函数响应合并到其消息中。

目前可以前往 Assistants Playground 来尝试 Assistants API Beta 版。

多模态能力,持续推进、全面开花

多模态作为当前模型团队重点关注和发展的技术,开发者可以通过文本转语音 API 从文本生成人类质量的语音。

开发者可以通过图像 API 将 DALL·E 3直接集成到他们的应用程序和产品中,并将 DALL·E-3 指定为模型。目前 Snap、可口可乐和 Shutterstock 等公司已使用 DALL·E 3 为其客户和活动生成图像和设计的服务。

与之前版本的 DALL·E 类似,该 API 包含内置审核功能,可帮助开发人员保护其应用程序免遭滥用。目前提供不同的格式和质量选项,每生成一张图像的起价为 0.04 美元,可以查看 API 中的 DALL·E 3 入门指南。

GPT-4 Turbo with vision,开发者可以通过 API 中的 gpt-4-vision-preview 来访问。OpenAI 计划为主要的 GPT-4 Turbo 模型提供视觉支持,价格取决于输入图像的大小,例如像素 1080×1080 的图像需要的成本为 0.00765 美元。

另外,其中 OpenAI 本次发布的 TTS 模型(文本转语音)提供可六种预设声音可供选择以及两种模型变体,tts-1 和 tts-1-hd. tts 都针对实时用例进行了优化,并 tts-1-hd 针对质量进行了优化。

这次 DevDay 中,Sam Altman 在紧凑的四十五分钟内,介绍了近期的多项重要更新和产品的未来愿景,本身就像是一个精炼了知识的大模型,不断输出高密度信息。

这场开发者日的新品发布,是否也让你们感到惊喜呢?

内容参考:

-

发布会回放:https://www.youtube.com/watch?v=U9mJuUkhUzk

-

DevDay:https://openai.com/blog/new-models-and-developer-products-announced-at-devday

-

GPTs:https://openai.com/blog/introducing-gpts

特邀现场观察团:Keven Liu

-

500px: https://500px.com/rongxinliu

-

Github: https://github.com/rongxin-liu