论文阅读[2022ICASSP]Global Optimization Solution for Dynamic Adaptive 360-Degree Streaming

1标题与作者

2022 ICASSP

Global Optimization Solution for Dynamic Adaptive 360-Degree Streaming

![论文阅读[2022ICASSP]Global Optimization Solution for Dynamic Adaptive 360-Degree Streaming_第1张图片](http://img.e-com-net.com/image/info8/afc2a4a8f030482fa51ecd47c56b6886.jpg)

2 背景

360度视频包含了整个周围空间的所有视觉信息,需要高清晰度(视频分辨率4K及以上)、高帧率(40帧/秒,fps及以上)和高比特率(10mbps及以上)来保证沉浸式用户体验和高质量体验(QoE)。上述需求导致360度流媒体视频的数据量是普通视频的数倍,传输可能会遇到带宽瓶颈。改进360度视频流方案以提高传输效率是当前的关键任务。

3挑战

1.360度帧的可变质量在质量自适应算法设计常被忽视;

2.大多数最先进的比特率选择方法没有考虑视频内容的异质性;

3.常用的视频质量预测设计不能反映高视频内容波动。如果没有合适的参数更新策略,在实际网络环境下,它们目前可能会导致质量下降。

4贡献

1提出了一种新的考虑360度视频特性的R-D模型与模型的参数更新策略以提高传输性能。

2提出了一种全局优化的自适应比特率控制算法,该算法使用R-D模型和视点精度来调整片段中每个tile的比特率。

5系统建模

5.1提出的优化算法

所提出的优化方案流程图如图1所示。

基本的360度流媒体策略包括视点预测、视频质量估计和tile级比特率选择部分。

在本文中,我们主要提出了新的视频质量估计方法和片级比特率选择方法。视点预测结果按照[3]提出的方法生成。

如图1所示,为了最大限度地提高传输效率,采用新的R-D模型、全局优化的比特率控制算法和模型参数更新策略,在不同的带宽和不同的QoE目标下提高用户QoE。

预测的视点和边缘区域因帧而异。为了避免由于预测误差而导致的预测未被观看区域可能落在视点或边缘区域内的问题,在未被观看区域内的图片将以更低的比特率Ro传输,以保证用户的QoE。

如图1所示,根据每个tile各自的R-D模型选择合适的比特率,可以进一步提高用户的QoE。

![论文阅读[2022ICASSP]Global Optimization Solution for Dynamic Adaptive 360-Degree Streaming_第2张图片](http://img.e-com-net.com/image/info8/79b13a0174674370bf1c8873a2ddc5b9.jpg)

5.2RD模型

为了得到R-D模型,kvazaar利用速率控制模式下的HEVC在JVET 360度视频测试序列[5]上进行视频编码实验。根据所提模型对不同区域的几个示例视频序列的R-D拟合曲线如图2所示。

![论文阅读[2022ICASSP]Global Optimization Solution for Dynamic Adaptive 360-Degree Streaming_第3张图片](http://img.e-com-net.com/image/info8/64deddeb3c764fec89627e5da8bb7d09.jpg)

从中可以看出,通过以下关系可以得到较好的拟合结果:

其中m、n为与源特征相关的模型参数。让

给定

![论文阅读[2022ICASSP]Global Optimization Solution for Dynamic Adaptive 360-Degree Streaming_第4张图片](http://img.e-com-net.com/image/info8/d693fe5a7b8c40cd8155ab340129ffb6.jpg)

第i个tile的失真表示如下:

![论文阅读[2022ICASSP]Global Optimization Solution for Dynamic Adaptive 360-Degree Streaming_第5张图片](http://img.e-com-net.com/image/info8/a264c3d6444d4be49d35be7e57c910d8.jpg)

不同区域的R-D模型分别表示视点、边缘和非视点区域的R-D模型。模型参数通常是内容相关的。

5.3 优化解决方案

视点区域的tile级比特率将被指定为Rv。边缘区域的片级比特率将被分配为较低的比特率Rl。比特率Rv和Rl将使用全局优化方法求解。在全局比特率分配算法中,效用首先被表示为下一段的期望质量,问题可以描述为

![论文阅读[2022ICASSP]Global Optimization Solution for Dynamic Adaptive 360-Degree Streaming_第6张图片](http://img.e-com-net.com/image/info8/f3d089eed4784a4b994973bf4f8a03f3.jpg)

其中CS是为tiles分配的预测可用比特率。然后可以构造为拉格朗日代价函数:

![论文阅读[2022ICASSP]Global Optimization Solution for Dynamic Adaptive 360-Degree Streaming_第7张图片](http://img.e-com-net.com/image/info8/e46374d7522342c1bd698faab3cb9525.jpg)

其中µ为拉格朗日乘子。通过求解Karush-Kuhn-Tucker (KKT)条件,可以得到Eq.(6)的最优解。通过求解Eq.(6),我们可以得到比特率集{br * i}如下:

![论文阅读[2022ICASSP]Global Optimization Solution for Dynamic Adaptive 360-Degree Streaming_第8张图片](http://img.e-com-net.com/image/info8/6248ec767251493d9c73be1115c7a305.jpg)

这样就可以生成比特率Rv和Rl。

5.4R-D模型参数更新

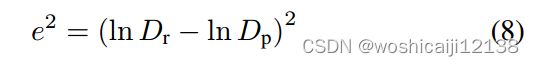

假设当前要编码的帧是第i帧,我们的目标是根据第i-1帧的编码统计量来估计参数。特别地,我们假设位于同一位置的瓦片的失真是Dr,并旨在最小化实际失真和估计失真Dp之间的差异,该差异可以表示为ln-Dr和ln-Dp之间的平方误差:

上式可采用自适应最小均方法(LMS)求解,可得mnew和nnew:

![论文阅读[2022ICASSP]Global Optimization Solution for Dynamic Adaptive 360-Degree Streaming_第9张图片](http://img.e-com-net.com/image/info8/2b98c8268491412d96b4cf61a003afbd.jpg)

5.5总结

![论文阅读[2022ICASSP]Global Optimization Solution for Dynamic Adaptive 360-Degree Streaming_第10张图片](http://img.e-com-net.com/image/info8/ee9202e8388c4168bcb5f3de8647047e.jpg)

在未查看区域的贴图将使用低得多的比特率以R0传输,以保证用户QoE。

边缘区域的比特率将被分配为较低的比特率Rl。

视点区域的瓦片级比特率将被指定为Rv。

(PS:算法流程可能有误,比特率Rv和Rl的结果由5.3的方法得出,那么第10步应该在第8和第9步之间,而不是之后。)

6实验结果

6.1实验配置

数据集:选择[8]中的视频数据集和网络轨迹生成流数据集。

比较算法:

L-FIX方法在不考虑观看行为的情况下请求比特率。

L-LR方法使用线性回归FoV预测和概率优化模型[8]来请求比特率。

L-Pen方法是“Pensieve”方法的一种改进的流框架[6]。

Alb1方法是不使用所提出的模型参数更新算法的消融方法。

6.2R-D优化方案的有效性

实验结果如图3所示,表明该方案优于其他方法,以更低的网络带宽浪费获得更高的渲染FoV质量。视场质量是指平均有效视场WS-PSNR,即瞬时视频质量度量。FoV比特率表示渲染FoV区域的贴图的平均比特率。结果表明,视场质量呈下降趋势,其主要原因是预测误差增大,预测精度降低。综合以上分析,我们将进一步使用一帧段长度流来评估QoE性能。(原文翻译,没看懂)

![论文阅读[2022ICASSP]Global Optimization Solution for Dynamic Adaptive 360-Degree Streaming_第11张图片](http://img.e-com-net.com/image/info8/23ede92946d44d4b8260b6fea7d53486.jpg)

6.3 QoE增益分析

详细的QoE增益如表1所示,包括FoV质量、FoV比特率、两个连续相邻片段之间的质量时间差、播放冻结长度和频率、预测精度和误差(FoV quality, the FoV bitrate, the quality temporal difference between two continuous adjacent segments, the playback freezing length and frequency, the prediction precision, and error.)。对比结果表明,本文提出的全局优化方案与R-D方法和低复杂度FoV预测方法相结合,能够优于现有算法,获得更高的QoE成绩。同时,该算法直接利用观测到的帧R-D模型和FoV预测结果获得最优解,进一步保证了QoE。

![论文阅读[2022ICASSP]Global Optimization Solution for Dynamic Adaptive 360-Degree Streaming_第12张图片](http://img.e-com-net.com/image/info8/566eb642935f411abd7c9b04d8978de8.jpg)

7评价

7.1 优点

提出了一种新的考虑360度视频特性的R-D模型,这种模型比较有启发性,可以通过该模型来衡量视频帧不同区域比特率选取对总体视频失真指标的影响;同时由于该模型不是线性的,还可以用来衡量视频比特率增长相同程度对视频失真指标的影响情况。

7.2 缺点

1本文可能由于篇幅原因,存在不少地方叙述不是特别清晰;

2未查看区域的贴图的传输比特率R0的设置没有经过特别的说明;

3没有考虑该系统处理流程的总体时延

参考

[5]Lisha Wang, Chenglin Li, Wenrui Dai, Junni Zou, and Hongkai Xiong, “Qoe-driven and tile-based adaptive streaming for point clouds,” in ICASSP 2021 - 2021 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP), 2021, pp. 1930–1934.

[6] Hongzi Mao, Ravi Netravali, and Mohammad Alizadeh, “Neural adaptive video streaming with pensieve,” in Proceedings of the Conference of the ACM Special Interest Group on Data Communication, New York, NY, USA, 2017, SIGCOMM ’17, p. 197–210, Association for Computing Machinery.

[8] M. Xu, C. Li, S. Zhang, and P. L. Callet, “State-of-the-art in 360° video/image processing: Perception, assessment and compression,” IEEE Journal of Selected Topics in Signal Processing, vol. 14, no. 1, pp. 5–26, 2020.