LLMs的Chain-of-Note(CoN)检索

英文原文地址:https://cobusgreyling.medium.com/chain-of-note-con-retrieval-for-llms-763ead1ae5c5

Chain-of-Note (CoN) 旨在通过解决噪声数据、不相关文档和domain场景来改进 RAG 实现。

2023 年 11 月 17 日

CoN 的要点

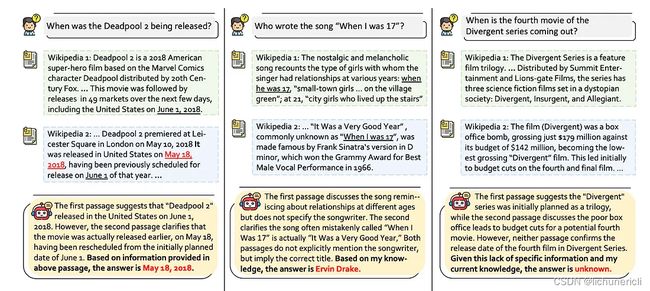

CoN 框架由三种不同类型组成,研究称之为阅读笔记。

考虑上图,类型(A)显示检索到的数据或文档回答查询的位置。因此,LLM 仅使用 NLG 来格式化所提供数据的答案。

类型(B)是检索到的文档不直接回答查询,但上下文洞察足以使LLMs将检索到的文档与其自己的知识相结合来推断答案。

类型(C)是检索到的文档不相关,并且LLMs没有相关知识来响应,这导致框架不会给出错误或错误的答案。

CoN 是一个自适应过程,或逻辑和推理层,其中直接信息与上下文推理和LLMs知识识别相平衡。

数据的四个方面

为了使模型具备生成NoC阅读笔记的能力,需要进行微调。

我们训练了一个 LLaMa-2 7B 模型,将笔记能力整合到 CON 中。

CoN不仅是一个提示模板,还包含一个针对笔记进行微调的模型。因此CoN可以看作是RAG和Fine-Tuning的结合。

这又回到了数据人工智能的概念和数据的四个方面,即数据发现、数据设计、数据开发和数据交付。

一般而言的 RAG 和具体的 CoN 可以被视为数据交付过程的一部分。但为了训练NoC模型,需要一个数据发现、数据设计和数据开发的过程。

对于这项研究,收集适当的训练数据至关重要。

每个阅读笔记的手动注释都是资源密集型的,因此研究团队采用最先进的语言模型来生成笔记。

这里我必须提一下,如果NoC要在企业环境中实施,AI加速的数据生产力工作室将是至关重要的。这种人机交互的过程对于具有清晰信号的相关训练数据非常重要。

CoN Template

下面显示了 LangSmith 游乐场的 CoN 模板。在此示例中,给定一个问题,查询维基百科并使用 OpenAI 和 Chain-of-Note 提示来提取答案。

对于标准 RAG,指令为:

Task Description: The primary objective is to briefly answer a specific question.

对于具有 CON 的 RALM,指令为:

Task Description:

1. Read the given question and five Wikipedia passages to gather relevant information.

2. Write reading notes summarizing the key points from these passages.

3. Discuss the relevance of the given question and Wikipedia passages.

4. If some passages are relevant to the given question, provide a brief answer based on the passages.

5. If no passage is relevant, direcly provide answer without considering the passages.

CoN的对于RAG的改善

Retrieval-Augmented Generation已成为LLMs的重要推动者。最值得注意的是,随着 RAG 的引入,模型幻觉得到了显着抑制,并且 RAG 还充当了模型性能的均衡器。请在此处阅读有关此内容的更多信息。

RAG 面临的挑战是确保在推理阶段向LLMs提供准确、高度简洁且上下文相关的数据。

检索不相关的数据可能会导致错误的响应,并可能导致模型忽视其固有知识,即使它拥有足够的信息来解决查询。

因此,Chain-of-Note(CoN)作为一种新方法,旨在提高 RAG 的弹性。特别是在 RAG 数据不包含与查询上下文相关的明确信号的情况下。

该研究的下图更详细地说明了 NoC 的实施。该框架主要构建了三种类型的阅读笔记……

CoN 框架为检索到的文档生成顺序阅读笔记,从而能够系统地评估从外部文档检索到的信息的相关性和准确性。

通过创建顺序阅读笔记,该模型不仅可以评估每个文档与查询的相关性,还可以识别这些文档中最关键和最可靠的信息。

此过程有助于过滤掉不相关或不太可信的内容,从而获得更准确且与上下文相关的响应。

最后

平衡

基于 LLM 的弹性企业级生成式 AI 实施的答案不是 RAG或模型微调。而是两者的结合,NoC 就是一个很好的例子。

语境

其次,上下文参考非常重要,数据提取中可供参考的信号越清晰越好。经过微调的模型提供了额外的上下文,以及检索到的文档和 NoC 提示模板。

数据

展望未来,数据以及高效且有效的数据发现和设计方法将变得越来越重要。我很想更深入地了解训练数据的结构。

总结

基于LLM的生成式人工智能实现的答案不是RAG或模型微调。而是两者的结合。因为上下文参考是非常重要的,从数据提取中的信号越清晰越好。经过微调的模型提供了额外的上下文,以及检索到的文档和NoC提示模板。数据与高效的数据发现和设计方法将变得越来越重要。