浅谈dropout--防止过拟合的方法

1 本周工作

通过学习论文,了解关于Dropout的相关知识

2 实验总结

(1)算法介绍

为了防止过拟合和提高泛化能力,在Neural Networks and Deep Learning中提到了几种方法,包括:early stopping、Data augmentation、正则化(Regularization)包括L1、L2(L2 regularization也叫weight decay),dropout。上周通过学习Hinton的论文了解了dropout这个方法。正则化方法是通过修改损失函数来提高过拟合能力的,而dropout是通过改变网络的结构来提高的,这是和正则化方法最本质的区别。

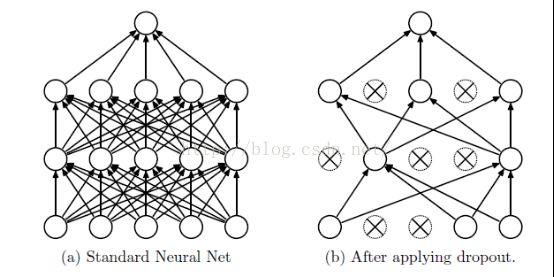

如图:

我们可以看出drop是指依一定的概率来临时的删除某些节点,但是他的权值会得到保留,因为在下次的工作时,他又可能被激活,本论文的特点是使用了梯度权值L2的上限摸,可得到比使用权值L2更好的效果,在克服过拟合之后,可以高效的整合不同的结构。Dropout是使用在监督学习中,他的核心思想是在训练中随机的删掉节点以及他们之间所属的关系。训练是删掉一些从thinnet中的指数数值,测试时减少过拟合促进测试的进行。通常表现在机器视觉,语义识别,文本分类,生物计算。因此在论文中采用的数据集是:

MNIST 、 TIMIT、 CIFAR-10 and CIFAR-100 、 Street View House Numbers data set (SVHN) 、 ImageNet、 Reuters-RCV1 、Alternative Splicing data set。其中每个点的概率都是P,并且是相互独立的,P可以是由验证集来取或者固定为0.5,但是文中对于输入来说是概率是接近于1的,论文中通过实验说去0.8的时候是最好的。

(2)模型描述

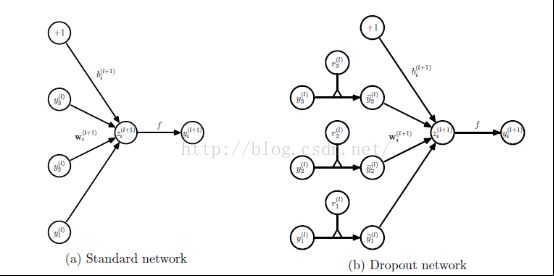

设神经网络具有l层,表示输入层的向量,表示从l层的输出向量,,是指权值和偏置。标准的前馈神经网络是:

从图中可以很形象的看出来上述公式的作用

(3)未解决问题

论文中选取概率采用了伯努利分布,正态分布,为什么,为什么不采用其他的?

可以删除节点,但是可以仿照突触的形成而增加节点吗?

如何加快训练速度,节省时间?

3参考文献

Neural Networks and Deep Learning

Dropout: A Simple Way to Prevent Neural Networks from Overftting

4 下周工作

通过论文,编写程序