E-COM-NET

首页

在线工具

Layui镜像站

SUI文档

联系我们

推荐频道

Java

PHP

C++

C

C#

Python

Ruby

go语言

Scala

Servlet

Vue

MySQL

NoSQL

Redis

CSS

Oracle

SQL Server

DB2

HBase

Http

HTML5

Spring

Ajax

Jquery

JavaScript

Json

XML

NodeJs

mybatis

Hibernate

算法

设计模式

shell

数据结构

大数据

JS

消息中间件

正则表达式

Tomcat

SQL

Nginx

Shiro

Maven

Linux

CUDA学习日记

vllm部署说明和注意事项

1、vllm所在docker镜像可去vllm官网提供的镜像地址拉取地址:UsingDocker—vLLMVllm镜像运行需要不同的

cuda

版本依赖,如上vllm/vllm-openai:v0.7.2需要

ai一小生

·

2025-03-17 14:59

python

人工智能

持续部署

Python

学习日记

-第二十九天-tcp(客户端)

系列文章目录tcp介绍tcp特点tcp客户端一、tcp介绍Tcp协议,传输控制协议是一种面向连接的、可靠的、基于字节流的传输层通信协议,由IETF的RFC793定义TCP通信需要经过创建连接、传输数据、终止连接三个步骤TCP通信模型中,在通信开始之前,一定要先建立相关的链接,才能发送数据,类似于生活中的“打电话”(注:之前学习的udp,在通信前,不需要建立相关的链接,只需要发送数据即可,类似于“写

差点长成吴彦祖

·

2025-03-17 14:55

python

pandas

tcp/ip

网络

CUDA

内核调优工具ncu的详细使用教程

NVIDIANsightCompute(ncu)是一款用于

CUDA

内核性能分析的工具,帮助开发者优化

CUDA

程序。以下是详细的使用教程和示例说明。

东北豆子哥

·

2025-03-17 09:52

CUDA

数值计算/数值优化

linux

高性能计算

麒麟银河桌面版,成功安装

cuda

12.6,mysql

一、要卸载并禁用nouveau驱动程序,可以按照以下步骤进行:1.确认nouveau驱动的当前状态:首先,你可以使用以下命令查看nouveau驱动是否正在运行:lsmod|grepnouveau如果有输出,说明nouveau驱动正在加载。2.临时禁用nouveau驱动:可以使用modprobe命令来临时禁用nouveau驱动(重启后会恢复加载):sudomodprobe-rnouveau3.永久禁

hitsz_syl

·

2025-03-17 07:37

mysql

银河麒麟

cuda

mysql创建新表,同步数据

importosimportargparseimportglobimportcv2importnumpyasnpimportonnxruntimeimporttqdmimportpymysqlimporttimeimportjsonfromdatetimeimportdatetimeos.environ[“

CUDA

_VISIBLE_DEVICES

hitsz_syl

·

2025-03-17 07:37

mysql

数据库

如何测试模型的推理速度

代码如下(示例):if__name__=="__main__":model=BiSeNet(backbone='STDCNet813',n_classes=2,export=True)model.

cuda

想要躺平的一枚

·

2025-03-17 02:59

AI图像算法

计算机视觉

NVIDIA下载老版本驱动/

CUDA

/Video Codec SDK的链接,以及一些解码参数说明

NVIDIA下载老版本驱动/

CUDA

/VideoCodecSDK的链接从别的网站抄过来的

CUDA

:https://developer.nvidia.com/

cuda

-toolkit-archive老驱动

landihao

·

2025-03-17 00:43

linux

PyTorch 环境搭建全攻略:

CUDA

/cuDNN 配置与多版本管理技巧

一、环境搭建前的准备工作1.硬件兼容性检测#检查NVIDIAGPU型号nvidia-smi#验证

CUDA

支持的ComputeCapabilitylspci|grep-invidia#查看

CUDA

版本兼容性矩阵

小诸葛IT课堂

·

2025-03-17 00:38

pytorch

人工智能

python

CMake Error at myplugins_generated_yololayer.cu.o.Debug,tensorrtx编译失败解决

system:ubuntu1804gpu:3060

cuda

:

cuda

11.4tensorrt:8.4使用项目tensorrtx进行yolov5的engine生成,之前在编译成功的配置为system:ubuntu1804gpu

雪可问春风

·

2025-03-16 08:11

BUG

人工智能

大模型的webui

exportXXX_LLM_C=~/xcore-llm/build/Releaseexport

CUDA

_VISIBLE_DEVICES=2,3export

CUDA

CXX=/usr/local/

cuda

-

Zain Lau

·

2025-03-16 05:26

人工智能

python

昇腾

Ascend

天数

linux(ubuntu)中Conda、

CUDA

安装Xinference报错ERROR: Failed to build (llama-cpp-python)

文章目录一、常规办法二、继续三、继续四、缺少libgomp库(最终解决)在Conda环境中安装libgomp如果符合标题情况执行的:pipinstall"xinference[all]"大概率是最终解决的情况。一、常规办法llama-cpp-python依赖CMake、Make和g++来编译,所以可能是缺少依赖或者环境配置不对。按照以下步骤排查问题并解决:1.确保Python版本符合要求llama

小胡说技书

·

2025-03-16 03:12

杂谈/设计模式/报错

Data/Python/大模型

linux

ubuntu

conda

大模型

python

Xinference

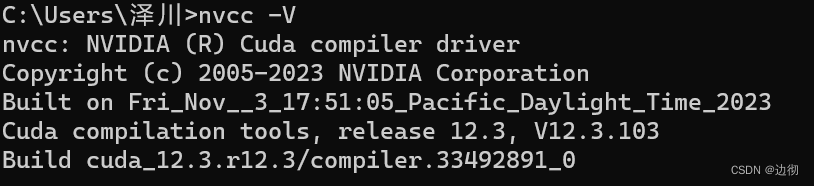

c++调用python代码,使用gpu

c++调用python,使用gpu加速1、首先要配置

cuda

和cudnn的环境1、cmd窗口下nvidia-smi,查看电脑可以支持的最高

cuda

版本。

AI改变视界

·

2025-03-16 01:55

c++

python

开发语言

大模型工程师

学习日记

(十五):Hugging Face 模型微调训练(基于 BERT 的中文评价情感分析)

1.datasets库核心方法1.1.列出数据集使用datasets库,你可以轻松列出所有HuggingFace平台上的数据集:fromdatasetsimportlist_datasets#列出所有数据集all_datasets=list_datasets()print(all_datasets)1.2.加载数据集你可以通过load_dataset方法加载任何数据集:fromdatasetsim

MMMMMMMay Love Code

·

2025-03-15 20:52

学习

bert

人工智能

深度学习

自然语言处理

全量微调

大模型工程师

学习日记

(十四):检索增强生成(RAG)

如何递归分割文本递归分割(recursively),这个文本分割器是用于通用文本的推荐工具。它接受一个字符列表作为参数。它会按顺序尝试在这些字符上进行分割,直到块足够小。默认的字符列表是["\n\n","\n","",""]。这样做的效果是尽可能保持所有段落(然后是句子,再然后是单词)在一起,因为这些通常看起来是语义上相关的文本块。文本如何分割:根据字符列表。块大小如何衡量:根据字符数量。下面我们

MMMMMMMay Love Code

·

2025-03-15 20:52

学习

langchain

深度学习

人工智能

开发语言

一文讲清楚

CUDA

与PyTorch、GPU之间的关系

CUDA

(ComputeUnifiedDeviceArchitecture)是由NVIDIA开发的一个并行计算平台和编程模型。

平凡而伟大.

·

2025-03-15 17:23

编程语言

人工智能

架构设计

pytorch

人工智能

python

深度学习-服务器训练SparseDrive过程记录

1、

cuda

安装1.1卸载安装失败的

cuda

参考:https://blog.csdn.net/weixin_40826634/article/details/127493809注意:因为/usr/local

weixin_40826634

·

2025-03-15 15:41

深度学习

服务器

人工智能

RTX4090性能释放与优化全攻略

内容概要作为NVIDIAAdaLovelace架构的巅峰之作,RTX4090凭借24GBGDDR6X显存与16384个

CUDA

核心,重新定义了4K光追游戏的性能边界。

智能计算研究中心

·

2025-03-14 22:13

其他

嵌入式人工智能应用- 第七章 人脸识别

嵌入式人工智能应用`文章目录嵌入式人工智能应用1人脸识别1.1dlib介绍1.2dlib特点1.3dlib的安装与编译2人脸识别原理2.1ResNet3代码部署3.1安装[

CUDA

Toolkit12.8

数贾电子科技

·

2025-03-14 19:16

嵌入式人工智能应用

人工智能

英伟达的ptx是什么?ptx在接近汇编语言的层级运行?

PTX(ParallelThreadeXecution)是英伟达

CUDA

架构中的一种中间表示形式(IR)语言。

AI-AIGC-7744423

·

2025-03-14 11:43

人工智能

保姆级教学——本地免费部署DeepSeek-R1模型并通过Python调用

DeepSeek-R1模型并通过Python调用的详细指南:一、环境准备(Windows/Linux/Mac通用)1.硬件要求最低配置:16GB内存+20GB可用磁盘空间推荐配置:NVIDIAGPU(显存≥8GB)+

CUDA

11.8

shuaige_shiwoa

·

2025-03-14 09:54

python+AI

python

开发语言

AI编程

ai

Python深度学习033:Python、PyTorch、

CUDA

和显卡驱动之间的关系

Python、PyTorch、

CUDA

和显卡驱动之间的关系相当紧密,它们共同构成了一个能够执行深度学习模型的高效计算环境。

若北辰

·

2025-03-14 01:00

Python深度学习

python

深度学习

pytorch

查看自己某个conda环境的Python版本的方法

再输入:activate

CUDA

90_torch110_tf1901激活环境。再输入:python-V#注意V是大写1

小剧场的阿刁

·

2025-03-13 20:30

conda

python

windows

本地部署时,如何通过硬件加速(如

CUDA

、TensorRT)提升 DeepSeek 的推理性能?不同显卡型号的兼容性如何测试?

本地部署DeepSeek模型的硬件加速优化与显卡兼容性测试指南一、硬件加速技术实现路径

CUDA

基础环境搭建版本匹配原则:根据显卡架构选择

CUDA

版本(如NVIDIARTX50系列需

CUDA

12+,V100

百态老人

·

2025-03-13 14:43

人工智能

科技

算法

vscode

一个基于LSTM的字符级文本生成模型的训练+使用(pytorch)

一、代码实现1.配置文件config.pyimporttorch#设备配置DEVICE=torch.device('

cuda

'iftorch.

cuda

.is_available()else'cpu')#

一只小铁柱

·

2025-03-13 12:04

lstm

pytorch

人工智能

PyTorch安装与环境配置终极指南:从零搭建高效深度学习开发环境(一)

一、环境搭建的核心意义与准备工作1.1深度学习环境的核心挑战深度学习开发环境涉及复杂的软件栈依赖关系:硬件兼容性:GPU型号(NVIDIA系列)与

CUDA

版本的匹配软件依赖链:Python版本→PyTorch

WHCIS

·

2025-03-13 12:02

python

pytorch

人工智能

深度学习

机器学习

windows11 环境 paddleOCR 环境配置

一、系统环境:操作系统:Windows11专业版显卡:RTX4080

CUDA

:

cuda

_12.6.2_560.94_windows.exe、cudnn-windows-x86_64-8.9.7.29_

cuda

12

一醉千秋

·

2025-03-13 08:27

python+银河麒麟

python

开发语言

离线安装tiny

cuda

nn

GitHub-NVlabs/tiny-

cuda

-nn:LightningfastC++/

CUDA

neuralnetworkframework在mac上递归clonetiny

cuda

nn仓库gitclone

GUSONGEN

·

2025-03-13 04:23

linux

运维

服务器

Windows编译tiny-

cuda

-nn时出现fatal error C1083: “crtdefs.h”: No such file or directory

首先确保安装了VisualStudio其次有可能是因为安装的VS设置的编译项默认为x86,与当前系统的

CUDA

的位数不一致。

龙雪zzZ

·

2025-03-13 03:50

windows

tiny-cuda-nn

Win11加wsl2安装anaconda

在Windows11中安装WSL2(Ubuntu20.04)并配置Anaconda环境-知乎(zhihu.com)使用的这篇帖子wsl2如何安装pipWindows下安装WSL2并配置

Cuda

、Miniconda

小方abc

·

2025-03-13 01:07

python

深度学习

开发语言

CUDA

12.1 cudnn9.0.1 python3.10.12配置TensorRT8.6.1,完成yolov12tensorRT推理完整过程

一、配置TensorRT8.6.11.下载TensorRT8.6.1包TensorRT完全依赖

CUDA

,因此下载其版本时一定要考虑

CUDA

的版本。

李卓璐

·

2025-03-13 01:33

算法实战

YOLO

开发ai模型最佳的系统是Ubuntu还是linux?

提供针对NVIDIAGPU的官方驱动支持,简化

CUDA

和cuDNN的配置流程(如nvidia-smi直接监控显存)。2.社区生态与长期维护(LTS)UbuntuLTS版本(如24

俺足

·

2025-03-12 22:18

人工智能

ubuntu

vLLM 部署大语言模型的系统选择策略

核心选型原则指标权重说明

CUDA

支持⭐⭐⭐⭐⭐直接影响GPU加速性能,需确保系统与NVIDIA驱动和

CUDA

工具链的兼容性软件源时效性⭐⭐⭐⭐系统需提供较新的Python、PyTorch等AI框架版本,

由数入道

·

2025-03-12 22:15

人工智能

语言模型

人工智能

自然语言处理

VLLM

CUDA

基础介绍

CUDA

基础介绍2月前阅读(6)原文一、GPU简介1985年8月20日ATi公司成立,同年10月ATi使用ASIC技术开发出了第一款图形芯片和图形卡,1992年4月ATi发布了Mach32图形卡集成了图形加速功能

Hansen Feng

·

2025-03-12 21:38

linux

vLLM框架:使用大模型推理框架

1.环境安装与配置1.1硬件要求GPU:支持

CUDA

11.8及以上(推荐NVIDIAA100/H100,RTX4090等消费级卡需注意显存限制)显存:至少20GB(运行7B模型),推荐40GB+(运行13B

CITY_OF_MO_GY

·

2025-03-12 17:12

人工智能

【Linux 22.4 ubuntu 安装

cuda

12.1 完整方案】

下载

cuda

12.1官网网址wgethttps://developer.download.nvidia.com/compute/

cuda

/12.1.1/local_installers/

cuda

_12.1.1

放飞自我的Coder

·

2025-03-12 01:15

linux

cuda

linux

ubuntu

C语言

学习日记

--循环,分支语句

C语言

学习日记

--循环分支语句题目一1.题目展示2.完成题目的过程中问题的出现(1)怎么多组输入3.代码展示4.问题的解决(1)关于多组输入此博客为学习记录,还请看官点点赞为我加油呀~~题目一1.题目展示

梦想成为大牛呀

·

2025-03-10 22:09

c语言

学习

开发语言

【大模型】DeepSeek-R1-Distill-Qwen部署及API调用

当前模型开源后,我们可以将其部署,使用API方式进行本地调用1.部署环境本文中的部署基础环境如下所示:PyTorch2.5.1Python3.12(ubuntu22.04)

Cuda

12.4GPURTX3090

油泼辣子多加

·

2025-03-10 17:29

大模型实战

算法

gpt

langchain

人工智能

opencv

cuda

例程 OpenCV和

Cuda

结合编程

本文转载自:https://www.fuwuqizhijia.com/linux/201704/70863.html此网页,仅保存下来供随时查看一、利用OpenCV中提供的GPU模块目前,OpenCV中已提供了许多GPU函数,直接使用OpenCV提供的GPU模块,可以完成大部分图像处理的加速操作。该方法的优点是使用简单,利用GpuMat管理CPU与GPU之间的数据传输,而且不需要关注内核函数调用参

weixin_44602056

·

2025-03-10 16:27

opencv

C++

利用

CUDA

与OpenCV实现高效图像处理:全面指南

利用

CUDA

与OpenCV实现高效图像处理:全面指南前言在现代计算机视觉领域,图像处理的需求日益增加。无论是自动驾驶、安防监控,还是医疗影像分析,图像处理技术都扮演着至关重要的角色。

快撑死的鱼

·

2025-03-10 16:25

C++(C语言)

算法大揭秘

opencv

图像处理

人工智能

linux 下

CUDA

+ Opencv 编程 之 CMakeLists.txt

CMAKE_MINIMUM_REQUIRED(VERSION2.8)PROJECT(medianFilterGPU)#

CUDA

packageFIND_PACKAGE(

CUDA

REQUIRED)INCLUDE

maxruan

·

2025-03-10 16:23

编程

图像处理

CUDA

opencv

linux

c++

cuda

Win11及

CUDA

12.1环境下PyTorch安装及避坑指南:深度学习开发者的福音

Win11及

CUDA

12.1环境下PyTorch安装及避坑指南:深度学习开发者的福音【下载地址】Win11及

CUDA

12.1环境下PyTorch安装及避坑指南本资源文件旨在为在Windows11操作系统及

郁云爽

·

2025-03-10 16:52

CUDA

编程之OpenCV与

CUDA

结合使用

OpenCV与

CUDA

的结合使用可显著提升图像处理性能。

byxdaz

·

2025-03-10 15:48

CUDA

opencv

人工智能

计算机视觉

Pycharm搭建

CUDA

,Pytorch教程(匹配版本,安装,搭建全保姆教程)_

cuda

12(1)

查看

cuda

版本输入set

cuda

查看环境变量!

2401_84557821

·

2025-03-10 08:56

程序员

pycharm

pytorch

ide

jupyter notebook参数化运行python

Updates(2019.8.1419:53)吃饭前用这个方法实战了一下,吃完回来一看好像不太行:跑完一组参数之后,到跑下一组参数时好像没有释放之占用的GPU,于是notebook上的结果,后面好几条都报错说

cuda

outofmemory

HackerTom

·

2025-03-10 02:11

乱搞

python

jupyter

notebook

win11编译llama_cpp_python

cuda

128 RTX30/40/50版本

Geforce50xx系显卡最低支持

cuda

128,llama_cpp_python官方源只有cpu版本,没有

cuda

版本,所以自己基于0.3.5版本源码编译一个RTX30xx/40xx/50xx版本。

System_sleep

·

2025-03-10 01:02

llama

python

windows

cuda

GPU编程实战指南03:

CUDA

开发快速上手示例,GPU性能碾压实测

上一节《GPU编程指南02:

CUDA

开发快速上手示例》中我们完成了一个使用GPU进行加减乘除四则运算的例子。

anda0109

·

2025-03-09 15:34

CUDA并行编程

linux

运维

服务器

DeepSeek R1-32B医疗大模型的完整微调实战分析(全码版)

DeepSeekR1-32B微调实战指南├──1.环境准备│├──1.1硬件配置││├─全参数微调:4*A10080GB││└─LoRA微调:单卡24GB│├──1.2软件依赖││├─PyTorch2.1.2+

CUDA

Allen_LVyingbo

·

2025-03-09 11:33

医疗高效编程研发

健康医疗

人工智能

python

记录 | python os添加系统环境变量

python中通过os来添加系统环境变量:#设置os系统环境变量os.environ['

CUDA

_VISIBLE_DEVICES']='0'os.environ['p2c']='1'os.environ

极智视界

·

2025-03-09 10:00

python

linux

os

系统环境变量

GPU编程实战指南01:

CUDA

编程极简手册

目录1.

CUDA

基础概念1.1线程层次结构1.2内存层次结构2.

CUDA

编程核心要素2.1核函数2.2内存管理2.3同步机制3.

CUDA

优化技巧3.1内存访问优化3.2共享内存使用3.3线程分配优化4.

anda0109

·

2025-03-09 09:20

CUDA并行编程

算法

安装

CUDA

12.1和torch2.2.1下的DKG

1.创建python虚拟环境setNO_PROXY=*condadeactivatecondaenvremove-nfindkgcondacreate-nfindkgpython=3.11condaactivatefindkgcondainstallpackagingsetuptoolspipuninstallnumpycondainstallnumpy=1.24.3请注意,DKG需要python

超级无敌大好人

·

2025-03-09 07:07

python

上一页

1

2

3

4

5

6

7

8

下一页

按字母分类:

A

B

C

D

E

F

G

H

I

J

K

L

M

N

O

P

Q

R

S

T

U

V

W

X

Y

Z

其他