小白的深度学习之路--关于感受野(Receptive field)

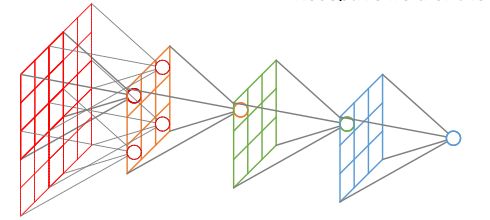

感受野(Receptive field)是卷积神经网络每一层输出的特征图(feature map)上的像素点在原始图像上的映射区域大小,可以理解为,神经网络中的某一个神经元对与输入样本的管辖范围。

在第一层卷积输出特征图像素的感受野大小等于滤波器的大小。深一层卷积层的感受野大小和他之前的所有层的滤波器有关。计算感受野大小时,忽略了边缘响应的影响,即不考虑padding

具体计算为

for layer in (top layer To down layer):

RF = ((RF -1)* stride) + fsize

其中,strides(i) = stride(1) * stride(2) * ...* stride(i-1),fsize表示滤波器大小。

下列python代码计算了VGG中各层的感受野大小

选自:http://www.cnblogs.com/objectDetect/p/5947169.html(鞠躬~)

#!/usr/bin/env python

net_struct = {'alexnet': {'net':[[11,4,0],[3,2,0],[5,1,2],[3,2,0],[3,1,1],[3,1,1],[3,1,1],[3,2,0]],

'name':['conv1','pool1','conv2','pool2','conv3','conv4','conv5','pool5']},

'vgg16': {'net':[[3,1,1],[3,1,1],[2,2,0],[3,1,1],[3,1,1],[2,2,0],[3,1,1],[3,1,1],[3,1,1],

[2,2,0],[3,1,1],[3,1,1],[3,1,1],[2,2,0],[3,1,1],[3,1,1],[3,1,1],[2,2,0]],

'name':['conv1_1','conv1_2','pool1','conv2_1','conv2_2','pool2','conv3_1','conv3_2',

'conv3_3', 'pool3','conv4_1','conv4_2','conv4_3','pool4','conv5_1','conv5_2','conv5_3','pool5']},

'zf-5':{'net': [[7,2,3],[3,2,1],[5,2,2],[3,2,1],[3,1,1],[3,1,1],[3,1,1]],

'name': ['conv1','pool1','conv2','pool2','conv3','conv4','conv5']}}

imsize = 224

def outFromIn(isz, net, layernum):

totstride = 1

insize = isz

for layer in range(layernum):

fsize, stride, pad = net[layer]

outsize = (insize - fsize + 2*pad) / stride + 1

insize = outsize

totstride = totstride * stride

return outsize, totstride

def inFromOut(net, layernum):

RF = 1

for layer in reversed(range(layernum)):

fsize, stride, pad = net[layer]

RF = ((RF -1)* stride) + fsize

return RF

if __name__ == '__main__':

print "layer output sizes given image = %dx%d" % (imsize, imsize)

for net in net_struct.keys():

print '************net structrue name is %s**************'% net

for i in range(len(net_struct[net]['net'])):

p = outFromIn(imsize,net_struct[net]['net'], i+1)

rf = inFromOut(net_struct[net]['net'], i+1)

print "Layer Name = %s, Output size = %3d, Stride = % 3d, RF size = %3d" % (net_struct[net]['name'][i], p[0], p[1], rf)

receptiveField.pyVGG网络在论文中提出:晓得滤波器大小有助于缩减网络参数。

以下节选自《Very Deep Convolutional Networks for Large-Scale Image Recognition》2.3

链接:https://papers.nips.cc/paper/4824-imagenet-classification-with-deep-convolutional-neural-networks.pdf

我们的ConvNet配置与ILSVRC-2012(Krizhevsky等,2012)和ILSVRC-2013比赛(Zeiler&Fergus,2013;Sermanet等,2014)表现最佳的参赛提交中使用的ConvNet配置有很大不同。不是在第一卷积层中使用相对较大的感受野(例如,在(Krizhevsky等人,2012)中的11×11,步长为4,或在(Zeiler&Fergus,2013;Sermanet等,2014)中的7×7,步长为2),我们在整个网络使用非常小的3×3感受野,与输入的每个像素(步长为1)进行卷积。很容易看到两个3×3卷积层堆叠(没有空间池化)有5×5的有效感受野;三个这样的层具有7×7的有效感受野。那么我们获得了什么?例如通过使用三个3×3卷积层的堆叠来替换单个7×7层。首先,我们结合了三个非线性修正层,而不是单一的,这使得决策函数更具判别性。其次,我们减少参数的数量:假设三层3×3卷积堆叠的输入和输出有CC个通道,堆叠卷积层的参数为3(32C2)=27C23(32C2)=27C2个权重;同时,单个7×7卷积层将需要72C2=49C272C2=49C2个参数,即参数多81%。这可以看作是对7×7卷积滤波器进行正则化,迫使它们通过3×3滤波器(在它们之间注入非线性)进行分解。