- (1-2)强化学习的理论基础:马尔可夫决策过程

码农三叔

强化学习从入门到实践人工智能大模型强化学习马尔可夫决策过程

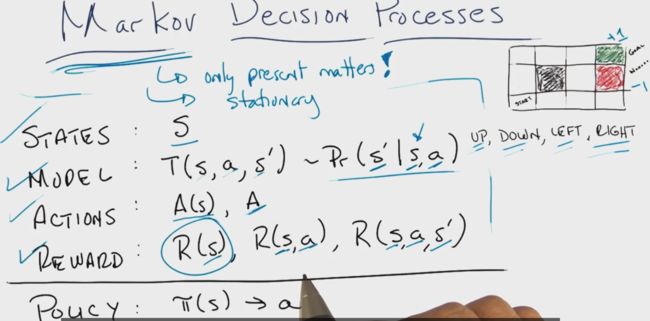

1.3强化学习的理论基础:马尔可夫决策过程强化学习的理论基础是马尔可夫决策过程(MarkovDecisionProcess,MDP)。MDP是一种数学模型,用于描述智能体在随机环境中进行决策的动态系统。它通过状态、动作、转移概率和奖励等元素,为强化学习提供了一个严谨的框架。1.3.1MDP的概念和定义马尔可夫决策过程(MarkovDecisionProcess,简称MDP)是强化学习的重要基石,它

- 【强化学习】强化学习算法 - 马尔可夫决策过程

人类发明了工具

RL强化学习分享算法数学建模强化学习马尔可夫决策

文章目录马尔可夫决策过程(MarkovDecisionProcess,MDP)1.MDP原理介绍2.MDP建模/实现步骤3.MDP示例:简单网格世界(GridWorld)马尔可夫决策过程(MarkovDecisionProcess,MDP)1.MDP原理介绍马尔可夫决策过程(MDP)是强化学习(ReinforcementLearning,RL)中用于对序贯决策(SequentialDecision

- 强化学习——MDP框架的搭建

愚者大大

强化学习人工智能算法机器学习

强化学习框架数学符号释义SSS指状态(state)空间AAA指动作(action)空间RRR指reward奖励,Rs=E[Rt+1∣St=s]R_s=E[R_{t+1}|S_t=s]Rs=E[Rt+1∣St=s]PPP指状态转移矩阵,其中的元素为:Pss′=P[St+1=s′∣St=s]P_{ss'}=P[S_{t+1}=s'|S_{t}=s]Pss′=P[St+1=s′∣St=s]γ\gamma

- 马尔可夫决策过程(MDP):从理论到实践的系统探讨

碳酸的唐

模型养成与叙述人工智能机器学习python

引言马尔可夫决策过程(MarkovDecisionProcess,MDP)作为现代决策理论的基石,为序贯决策问题提供了严格的数学框架。本文旨在系统探讨MDP的理论基础、求解算法及其实际应用,同时通过可视化方式直观展现MDP模型的形成过程与内在机制。MDP在强化学习、运筹学、控制理论等多个领域具有深远影响,已成为人工智能研究中不可或缺的理论工具。通过马尔可夫性质,MDP能够在保持计算可行性的前提下,

- IsaacLab最新2025教程(7)-创建Interactive Scene

Calm_dw

算法机器人人工智能python

在isaaclab中创建的强化学习训练环境有两种:directworkflow,风格与isaacgym一样。另外一种是manager-basedworkflow更加模块化,它主要是两部分包括仿真环境也就是即将介绍的interactivescene,与mdp的内容,比如奖励函数,observcation等等。这次介绍的interactivescene是用来加载各种asset,同时也包括了简易整体的运

- 强化学习系统学习路径与实践方法

豆芽819

tip学习人工智能机器学习深度学习强化学习

一、学习路径规划1.基础巩固阶段(1-2个月)必读教材:《ReinforcementLearning:AnIntroduction》(Sutton&Barto)第1-6章重点掌握:马尔可夫决策过程(MDP)、贝尔曼方程、动态规划(DP)、蒙特卡洛(MC)、时序差分(TD)算法。数学基础:概率论(期望、方差、条件概率)线性代数(矩阵运算、特征值)优化理论(梯度下降、凸优化)补充资源:MIT线性代数课

- 基于推理的强化学习智能体设计与开发

由数入道

人工智能人工智能多智能体强化学习知识推理

1.理论基础与核心概念1.1推理强化学习(Reasoning-EnhancedRL)定义核心思想:在传统强化学习的马尔可夫决策过程(MDP)基础上,引入符号推理、因果推断和知识引导机制,解决复杂环境中的长程依赖和稀疏奖励问题。数学建模:扩展MDP为R-MDP:⟨S,A,P

- 智能体在环境中学习和作出决策

由数入道

人工智能人工智能智能体深度学习

一、概述强化学习是一类通过与环境交互获取反馈并不断优化决策策略的机器学习方法。与监督学习和无监督学习不同,强化学习直接面向序列决策问题,核心目标是找到使智能体(Agent)在环境中获得最大化累积奖励(CumulativeReward)的策略。其理论基础通常以马尔可夫决策过程(MarkovDecisionProcess,MDP)为框架。MDP的五元组通常表示为(S,A,P,R,γ)(S,A,P,R,

- 强化学习(二)----- 马尔可夫决策过程MDP

Duckie-duckie

机器学习数据数据分析数据挖掘机器学习算法

1.马尔可夫模型的几类子模型大家应该还记得马尔科夫链(MarkovChain),了解机器学习的也都知道隐马尔可夫模型(HiddenMarkovModel,HMM)。它们具有的一个共同性质就是马尔可夫性(无后效性),也就是指系统的下个状态只与当前状态信息有关,而与更早之前的状态无关。马尔可夫决策过程(MarkovDecisionProcess,MDP)也具有马尔可夫性,与上面不同的是MDP考虑了动作

- Python强化学习,基于gym的马尔可夫决策过程MDP,动态规划求解,体现序贯决策

baozouxiaoxian

pythongymqlearningpython强化学习mdp动态规划求解马尔科夫决策过程

决策的过程分为单阶段和多阶段的。单阶段决策也就是单次决策,这个很简单。而序贯决策指按时间序列的发生,按顺序连续不断地作出决策,即多阶段决策,决策是分前后顺序的。序贯决策是前一阶段决策方案的选择,会影响到后一阶段决策方案的选择,后一阶段决策方案的选择是取决于前一阶段决策方案的结果。强化学习过程中最典型的例子就是非线性二级摆系统,有4个关键值,小车受力,受力方向,摆速度,摆角,每个状态下都需要决策车的

- 基于时序差分的无模型强化学习:Q-learning 算法详解

晓shuo

算法强化学习

目录一、无模型强化学习中的时序差分方法与Q-learning1.1时序差分法1.2Q-learning算法状态-动作值函数(Q函数)Q-learning的更新公式Q-learning算法流程Q-learning的特点1.3总结一、无模型强化学习中的时序差分方法与Q-learning 动态规划算法依赖于已知的马尔可夫决策过程(MDP),在环境的状态转移概率和奖励函数完全明确的情况下,智能体无需与环

- 2019-10-19 Lecture 4: Model-Free Prediction

BoringFantasy

Model-FreePredictionInterductionimage.png区别上节课讲已知MDP,使用动态规划方法来获得最优valuefunction和policy。ModelFree不知道环境如何运作,直接从经验中,从代理和环境的交互中更新valuefunction和policy。本节课将给定policy,不知道环境状态和valuefunction,评估policy可以获得多少rewar

- 马尔可夫决策过程(Markov decision process,MDP)

太阳城S

学习笔记马尔可夫决策过程MDP机器学习深度学习

文章目录马尔可夫决策过程(MDP)在机器学习中应用在机器学习中的引用示例引用:实例场景:机器人导航MDP的定义:引用示例:在此基础上更具体的描述,并给出每一步的推断计算过程场景描述:3x3网格中的机器人导航MDP的定义强化学习算法:Q-Learning具体实例与推断计算过程回合1(Episode1Episode1Episode1)回合2(Episode2Episode2Episode2)回合3(E

- 马尔可夫过程||马尔可夫奖励过程||马尔可夫决策过程——基本概念汇总

@Duang~

机器学习算法机器学习深度学习

马尔可夫过程MP:(S,P)马尔可夫奖励过程MRP:(S,P,R,γ)马尔可夫决策过程MDP:(S,A,P,R,γ)马尔可夫过程MP马尔科夫性:下一时刻状态只与当前时刻状态有关,与之前状态无关。状态转移矩阵:定义了状态到其后所有后继状态的转移概率。状态转移概率:矩阵中每行元素总和为1。马尔可夫过程可分为三类:1)时间、状态都离散——马尔科夫链2)时间连续、状态离散——连续时间的马尔科夫链3)时间、

- 王树森《深度强化学习》学习笔记

ustb_student

学习

基本概念马尔可夫决策过程(MDP)智能体(agent):强化学习的主体,由谁做动作或决策,谁就是智能体环境(environment):与智能体交互的对象,可以抽象的理解为交互过程中的规则或机理状态(state):每个时刻,环境都有一个状态,即对当前时刻环境的概括。状态是做决策的依据状态空间(statespace):所有可能存在状态的集合动作(action):智能体基于当前状态所做出的决策动作空间(

- 强化学习(四)动态规划——1

EasonZzzzzzz

强化学习动态规划算法

动态规划算法(DP):在马尔可夫决策过程(MDP)的完美环境模型下计算最优策略。但其在强化学习中实用性有限,其一是它是基于环境模型已知;其二是它的计算成本很大。但它在理论伤仍然很重要,其他的一些算法与动态规划算法(DP)十分相似,只是计算量小及没有假设环境模型已知。动态规划算法(DP)和一般的强化学习算法的关键思想都是基于价值函数对策略的搜索,如前所述,一旦我们找到满足贝尔曼最优方程的最优价值函数

- Gromacs相关(还未来得及看,留个坑)

病树前头

GromacsGromacs学习

[GROMACS]关于预平衡步骤的确定以及mdp文件中wall设置的提问[GROMACS]求助gromacs中的top文件生成问题几种生成有机分子GROMACS拓扑文件的工具Restraints自写脚本创建非标准残基蛋白的GROMACS拓扑GROMACS中文手册:第四章相互作用函数和力场GROMACS中文手册:第五章拓扑文件1particlescommunicatedtoPMErank10arem

- 详解强化学习(Reinforcement Learning)(基础篇)

RRRRRoyal

人工智能机器学习

强化学习(ReinforcementLearning)是机器学习的一个分支,主要研究智能体如何通过观察环境状态、执行动作和接收奖励来学习最优策略。强化学习的核心思想是通过持续与环境的交互来获得反馈并学习最优行为策略。1.强化学习的底层原理:强化学习的核心是马尔可夫决策过程(MarkovDecisionProcess,MDP),它由五个要素构成:状态空间、动作空间、状态转移概率、奖励函数和折扣因子。

- (9-4)基于深度强化学习的量化交易策略(OpenAI Baselines +FinRL+DRL+PyPortfolioOpt):构建交易环境

码农三叔

金融大模型人工智能深度学习机器学习python算法

9.7构建交易环境考虑到自动股票交易任务的随机性和互动性,在本项目中将金融任务建模为马尔可夫决策过程(MarkovDecisionProcess,MDP)问题。在训练过程观察股价的变化、执行操作以及奖励计算,使代理根据奖励调整其策略。通过与环境互动,交易代理将制定随着时间推移而最大化奖励的交易策略。本项目的交易环境基于OpenAIGym框架实现,根据时间驱动模拟的原则模拟实时股票市场,使用真实的市

- 算法随想录第三十九天打卡|62.不同路径 , 63. 不同路径 II

星曜366

算法

62.不同路径本题大家掌握动态规划的方法就可以。数论方法有点非主流,很难想到。代码随想录视频讲解:动态规划中如何初始化很重要!|LeetCode:62.不同路径_哔哩哔哩_bilibiliclassSolution(object):defuniquePaths(self,m,n):ifm==1andn==1:return1dp=[[0]*n]*mdp[0][0]=1forxinrange(m):f

- 强化学习应用(二):基于Q-learning的无人机物流路径规划研究(提供Python代码)

IT猿手

QlearningpythonTSP无人机python开发语言深度强化学习强化学习TSP

一、Q-learning简介Q-learning是一种强化学习算法,用于解决基于马尔可夫决策过程(MDP)的问题。它通过学习一个价值函数来指导智能体在环境中做出决策,以最大化累积奖励。Q-learning算法的核心思想是通过不断更新一个称为Q值的表格来学习最优策略。Q值表示在给定状态下采取某个动作所能获得的预期累积奖励。算法的基本步骤如下:1.初始化Q值表格,将所有Q值初始化为0。2.在每个时间步

- 强化学习应用(一):基于Q-learning的无人机物流路径规划研究(提供Python代码)

IT猿手

TSPQlearningpython无人机python开发语言深度强化学习强化学习Qlearning

一、Q-learning简介Q-learning是一种强化学习算法,用于解决基于马尔可夫决策过程(MDP)的问题。它通过学习一个价值函数来指导智能体在环境中做出决策,以最大化累积奖励。Q-learning算法的核心思想是通过不断更新一个称为Q值的表格来学习最优策略。Q值表示在给定状态下采取某个动作所能获得的预期累积奖励。算法的基本步骤如下:1.初始化Q值表格,将所有Q值初始化为0。2.在每个时间步

- 强化学习应用(七):基于Q-learning的物流配送路径规划研究(提供Python代码)

优化算法MATLAB与Python

Python优化算法python开发语言算法人工智能强化学习

一、Q-learning算法简介Q-learning是一种强化学习算法,用于解决基于马尔可夫决策过程(MDP)的问题。它通过学习一个值函数来指导智能体在环境中做出决策,以最大化累积奖励。Q-learning算法的核心思想是使用一个Q值函数来估计每个状态动作对的价值。Q值表示在特定状态下采取某个动作所能获得的预期累积奖励。算法通过不断更新Q值函数来优化智能体的决策策略。Q-learning算法的更新

- 强化学习应用(六):基于Q-learning的物流配送路径规划研究(提供Python代码)

优化算法MATLAB与Python

Python优化算法python开发语言算法人工智能强化学习

一、Q-learning算法简介Q-learning是一种强化学习算法,用于解决基于马尔可夫决策过程(MDP)的问题。它通过学习一个值函数来指导智能体在环境中做出决策,以最大化累积奖励。Q-learning算法的核心思想是使用一个Q值函数来估计每个状态动作对的价值。Q值表示在特定状态下采取某个动作所能获得的预期累积奖励。算法通过不断更新Q值函数来优化智能体的决策策略。Q-learning算法的更新

- 强化学习应用(五):基于Q-learning的物流配送路径规划研究(提供Python代码)

优化算法MATLAB与Python

Python优化算法python开发语言人工智能强化学习算法

一、Q-learning算法简介Q-learning是一种强化学习算法,用于解决基于马尔可夫决策过程(MDP)的问题。它通过学习一个值函数来指导智能体在环境中做出决策,以最大化累积奖励。Q-learning算法的核心思想是使用一个Q值函数来估计每个状态动作对的价值。Q值表示在特定状态下采取某个动作所能获得的预期累积奖励。算法通过不断更新Q值函数来优化智能体的决策策略。Q-learning算法的更新

- 强化学习应用(八):基于Q-learning的物流配送路径规划研究(提供Python代码)

优化算法MATLAB与Python

Python优化算法python开发语言人工智能强化学习算法

一、Q-learning算法简介Q-learning是一种强化学习算法,用于解决基于马尔可夫决策过程(MDP)的问题。它通过学习一个值函数来指导智能体在环境中做出决策,以最大化累积奖励。Q-learning算法的核心思想是使用一个Q值函数来估计每个状态动作对的价值。Q值表示在特定状态下采取某个动作所能获得的预期累积奖励。算法通过不断更新Q值函数来优化智能体的决策策略。Q-learning算法的更新

- 马尔科夫决策过程(Markov Decision Process)揭秘

アナリスト

机器学习人工智能深度学习动态规划

RL基本框架、MDP概念MDP是强化学习的基础。MDP能建模一系列真实世界的问题,它在形式上描述了强化学习的框架。RL的交互过程就是通过MDP表示的。RL中Agent对Environment做出一个动作(Action),Environment给Agent一个反馈(Reward),同时Agent从原状态()变为新状态()。这里的反馈可以是正、负反馈;Agent执行动作是根据某个策略(Policy)进

- 强化学习应用(三):基于Q-learning的物流配送路径规划研究(提供Python代码)

优化算法MATLAB与Python

Python优化算法python开发语言算法人工智能强化学习

一、Q-learning算法简介Q-learning是一种强化学习算法,用于解决基于马尔可夫决策过程(MDP)的问题。它通过学习一个值函数来指导智能体在环境中做出决策,以最大化累积奖励。Q-learning算法的核心思想是使用一个Q值函数来估计每个状态动作对的价值。Q值表示在特定状态下采取某个动作所能获得的预期累积奖励。算法通过不断更新Q值函数来优化智能体的决策策略。Q-learning算法的更新

- 强化学习应用(一):基于Q-learning的物流配送路径规划研究(提供Python代码)

优化算法MATLAB与Python

Python优化算法python开发语言人工智能算法

一、Q-learning算法简介Q-learning是一种强化学习算法,用于解决基于马尔可夫决策过程(MDP)的问题。它通过学习一个值函数来指导智能体在环境中做出决策,以最大化累积奖励。Q-learning算法的核心思想是使用一个Q值函数来估计每个状态动作对的价值。Q值表示在特定状态下采取某个动作所能获得的预期累积奖励。算法通过不断更新Q值函数来优化智能体的决策策略。Q-learning算法的更新

- 强化学习应用(二):基于Q-learning的物流配送路径规划研究(提供Python代码)

优化算法MATLAB与Python

Python优化算法python开发语言算法人工智能

一、Q-learning算法简介Q-learning是一种强化学习算法,用于解决基于马尔可夫决策过程(MDP)的问题。它通过学习一个值函数来指导智能体在环境中做出决策,以最大化累积奖励。Q-learning算法的核心思想是使用一个Q值函数来估计每个状态动作对的价值。Q值表示在特定状态下采取某个动作所能获得的预期累积奖励。算法通过不断更新Q值函数来优化智能体的决策策略。Q-learning算法的更新

- 戴尔笔记本win8系统改装win7系统

sophia天雪

win7戴尔改装系统win8

戴尔win8 系统改装win7 系统详述

第一步:使用U盘制作虚拟光驱:

1)下载安装UltraISO:注册码可以在网上搜索。

2)启动UltraISO,点击“文件”—》“打开”按钮,打开已经准备好的ISO镜像文

- BeanUtils.copyProperties使用笔记

bylijinnan

java

BeanUtils.copyProperties VS PropertyUtils.copyProperties

两者最大的区别是:

BeanUtils.copyProperties会进行类型转换,而PropertyUtils.copyProperties不会。

既然进行了类型转换,那BeanUtils.copyProperties的速度比不上PropertyUtils.copyProp

- MyEclipse中文乱码问题

0624chenhong

MyEclipse

一、设置新建常见文件的默认编码格式,也就是文件保存的格式。

在不对MyEclipse进行设置的时候,默认保存文件的编码,一般跟简体中文操作系统(如windows2000,windowsXP)的编码一致,即GBK。

在简体中文系统下,ANSI 编码代表 GBK编码;在日文操作系统下,ANSI 编码代表 JIS 编码。

Window-->Preferences-->General -

- 发送邮件

不懂事的小屁孩

send email

import org.apache.commons.mail.EmailAttachment;

import org.apache.commons.mail.EmailException;

import org.apache.commons.mail.HtmlEmail;

import org.apache.commons.mail.MultiPartEmail;

- 动画合集

换个号韩国红果果

htmlcss

动画 指一种样式变为另一种样式 keyframes应当始终定义0 100 过程

1 transition 制作鼠标滑过图片时的放大效果

css

.wrap{

width: 340px;height: 340px;

position: absolute;

top: 30%;

left: 20%;

overflow: hidden;

bor

- 网络最常见的攻击方式竟然是SQL注入

蓝儿唯美

sql注入

NTT研究表明,尽管SQL注入(SQLi)型攻击记录详尽且为人熟知,但目前网络应用程序仍然是SQLi攻击的重灾区。

信息安全和风险管理公司NTTCom Security发布的《2015全球智能威胁风险报告》表明,目前黑客攻击网络应用程序方式中最流行的,要数SQLi攻击。报告对去年发生的60亿攻击 行为进行分析,指出SQLi攻击是最常见的网络应用程序攻击方式。全球网络应用程序攻击中,SQLi攻击占

- java笔记2

a-john

java

类的封装:

1,java中,对象就是一个封装体。封装是把对象的属性和服务结合成一个独立的的单位。并尽可能隐藏对象的内部细节(尤其是私有数据)

2,目的:使对象以外的部分不能随意存取对象的内部数据(如属性),从而使软件错误能够局部化,减少差错和排错的难度。

3,简单来说,“隐藏属性、方法或实现细节的过程”称为——封装。

4,封装的特性:

4.1设置

- [Andengine]Error:can't creat bitmap form path “gfx/xxx.xxx”

aijuans

学习Android遇到的错误

最开始遇到这个错误是很早以前了,以前也没注意,只当是一个不理解的bug,因为所有的texture,textureregion都没有问题,但是就是提示错误。

昨天和美工要图片,本来是要背景透明的png格式,可是她却给了我一个jpg的。说明了之后她说没法改,因为没有png这个保存选项。

我就看了一下,和她要了psd的文件,还好我有一点

- 自己写的一个繁体到简体的转换程序

asialee

java转换繁体filter简体

今天调研一个任务,基于java的filter实现繁体到简体的转换,于是写了一个demo,给各位博友奉上,欢迎批评指正。

实现的思路是重载request的调取参数的几个方法,然后做下转换。

- android意图和意图监听器技术

百合不是茶

android显示意图隐式意图意图监听器

Intent是在activity之间传递数据;Intent的传递分为显示传递和隐式传递

显式意图:调用Intent.setComponent() 或 Intent.setClassName() 或 Intent.setClass()方法明确指定了组件名的Intent为显式意图,显式意图明确指定了Intent应该传递给哪个组件。

隐式意图;不指明调用的名称,根据设

- spring3中新增的@value注解

bijian1013

javaspring@Value

在spring 3.0中,可以通过使用@value,对一些如xxx.properties文件中的文件,进行键值对的注入,例子如下:

1.首先在applicationContext.xml中加入:

<beans xmlns="http://www.springframework.

- Jboss启用CXF日志

sunjing

logjbossCXF

1. 在standalone.xml配置文件中添加system-properties:

<system-properties> <property name="org.apache.cxf.logging.enabled" value=&

- 【Hadoop三】Centos7_x86_64部署Hadoop集群之编译Hadoop源代码

bit1129

centos

编译必需的软件

Firebugs3.0.0

Maven3.2.3

Ant

JDK1.7.0_67

protobuf-2.5.0

Hadoop 2.5.2源码包

Firebugs3.0.0

http://sourceforge.jp/projects/sfnet_findbug

- struts2验证框架的使用和扩展

白糖_

框架xmlbeanstruts正则表达式

struts2能够对前台提交的表单数据进行输入有效性校验,通常有两种方式:

1、在Action类中通过validatexx方法验证,这种方式很简单,在此不再赘述;

2、通过编写xx-validation.xml文件执行表单验证,当用户提交表单请求后,struts会优先执行xml文件,如果校验不通过是不会让请求访问指定action的。

本文介绍一下struts2通过xml文件进行校验的方法并说

- 记录-感悟

braveCS

感悟

再翻翻以前写的感悟,有时会发现自己很幼稚,也会让自己找回初心。

2015-1-11 1. 能在工作之余学习感兴趣的东西已经很幸福了;

2. 要改变自己,不能这样一直在原来区域,要突破安全区舒适区,才能提高自己,往好的方面发展;

3. 多反省多思考;要会用工具,而不是变成工具的奴隶;

4. 一天内集中一个定长时间段看最新资讯和偏流式博

- 编程之美-数组中最长递增子序列

bylijinnan

编程之美

import java.util.Arrays;

import java.util.Random;

public class LongestAccendingSubSequence {

/**

* 编程之美 数组中最长递增子序列

* 书上的解法容易理解

* 另一方法书上没有提到的是,可以将数组排序(由小到大)得到新的数组,

* 然后求排序后的数组与原数

- 读书笔记5

chengxuyuancsdn

重复提交struts2的token验证

1、重复提交

2、struts2的token验证

3、用response返回xml时的注意

1、重复提交

(1)应用场景

(1-1)点击提交按钮两次。

(1-2)使用浏览器后退按钮重复之前的操作,导致重复提交表单。

(1-3)刷新页面

(1-4)使用浏览器历史记录重复提交表单。

(1-5)浏览器重复的 HTTP 请求。

(2)解决方法

(2-1)禁掉提交按钮

(2-2)

- [时空与探索]全球联合进行第二次费城实验的可能性

comsci

二次世界大战前后,由爱因斯坦参加的一次在海军舰艇上进行的物理学实验 -费城实验

至今给我们大家留下很多迷团.....

关于费城实验的详细过程,大家可以在网络上搜索一下,我这里就不详细描述了

在这里,我的意思是,现在

- easy connect 之 ORA-12154: TNS: 无法解析指定的连接标识符

daizj

oracleORA-12154

用easy connect连接出现“tns无法解析指定的连接标示符”的错误,如下:

C:\Users\Administrator>sqlplus username/

[email protected]:1521/orcl

SQL*Plus: Release 10.2.0.1.0 – Production on 星期一 5月 21 18:16:20 2012

Copyright (c) 198

- 简单排序:归并排序

dieslrae

归并排序

public void mergeSort(int[] array){

int temp = array.length/2;

if(temp == 0){

return;

}

int[] a = new int[temp];

int

- C语言中字符串的\0和空格

dcj3sjt126com

c

\0 为字符串结束符,比如说:

abcd (空格)cdefg;

存入数组时,空格作为一个字符占有一个字节的空间,我们

- 解决Composer国内速度慢的办法

dcj3sjt126com

Composer

用法:

有两种方式启用本镜像服务:

1 将以下配置信息添加到 Composer 的配置文件 config.json 中(系统全局配置)。见“例1”

2 将以下配置信息添加到你的项目的 composer.json 文件中(针对单个项目配置)。见“例2”

为了避免安装包的时候都要执行两次查询,切记要添加禁用 packagist 的设置,如下 1 2 3 4 5

- 高效可伸缩的结果缓存

shuizhaosi888

高效可伸缩的结果缓存

/**

* 要执行的算法,返回结果v

*/

public interface Computable<A, V> {

public V comput(final A arg);

}

/**

* 用于缓存数据

*/

public class Memoizer<A, V> implements Computable<A,

- 三点定位的算法

haoningabc

c算法

三点定位,

已知a,b,c三个顶点的x,y坐标

和三个点都z坐标的距离,la,lb,lc

求z点的坐标

原理就是围绕a,b,c 三个点画圆,三个圆焦点的部分就是所求

但是,由于三个点的距离可能不准,不一定会有结果,

所以是三个圆环的焦点,环的宽度开始为0,没有取到则加1

运行

gcc -lm test.c

test.c代码如下

#include "stdi

- epoll使用详解

jimmee

clinux服务端编程epoll

epoll - I/O event notification facility在linux的网络编程中,很长的时间都在使用select来做事件触发。在linux新的内核中,有了一种替换它的机制,就是epoll。相比于select,epoll最大的好处在于它不会随着监听fd数目的增长而降低效率。因为在内核中的select实现中,它是采用轮询来处理的,轮询的fd数目越多,自然耗时越多。并且,在linu

- Hibernate对Enum的映射的基本使用方法

linzx0212

enumHibernate

枚举

/**

* 性别枚举

*/

public enum Gender {

MALE(0), FEMALE(1), OTHER(2);

private Gender(int i) {

this.i = i;

}

private int i;

public int getI

- 第10章 高级事件(下)

onestopweb

事件

index.html

<!DOCTYPE html PUBLIC "-//W3C//DTD XHTML 1.0 Transitional//EN" "http://www.w3.org/TR/xhtml1/DTD/xhtml1-transitional.dtd">

<html xmlns="http://www.w3.org/

- 孙子兵法

roadrunners

孙子兵法

始计第一

孙子曰:

兵者,国之大事,死生之地,存亡之道,不可不察也。

故经之以五事,校之以计,而索其情:一曰道,二曰天,三曰地,四曰将,五

曰法。道者,令民于上同意,可与之死,可与之生,而不危也;天者,阴阳、寒暑

、时制也;地者,远近、险易、广狭、死生也;将者,智、信、仁、勇、严也;法

者,曲制、官道、主用也。凡此五者,将莫不闻,知之者胜,不知之者不胜。故校

之以计,而索其情,曰

- MySQL双向复制

tomcat_oracle

mysql

本文包括:

主机配置

从机配置

建立主-从复制

建立双向复制

背景

按照以下简单的步骤:

参考一下:

在机器A配置主机(192.168.1.30)

在机器B配置从机(192.168.1.29)

我们可以使用下面的步骤来实现这一点

步骤1:机器A设置主机

在主机中打开配置文件 ,

- zoj 3822 Domination(dp)

阿尔萨斯

Mina

题目链接:zoj 3822 Domination

题目大意:给定一个N∗M的棋盘,每次任选一个位置放置一枚棋子,直到每行每列上都至少有一枚棋子,问放置棋子个数的期望。

解题思路:大白书上概率那一张有一道类似的题目,但是因为时间比较久了,还是稍微想了一下。dp[i][j][k]表示i行j列上均有至少一枚棋子,并且消耗k步的概率(k≤i∗j),因为放置在i+1~n上等价与放在i+1行上,同理