图神经网络:方法与应用综述

内容简介: 2

一、介绍(GCN基于CNN和图嵌入) 2

1.研究GNN的动机: 2

2.研究GNN的原因: 2

3.早期的GNN研究: 3

二、模型 4

2.1原始GNN 4

2.2 GNN的变体 5

2.2.1图类型 6

2.2.2传播类型(传播过程使用的方法) 6

2.2.3训练方法 8

2.3通用框架(将不同的模型集成到一个单一的框架中) 10

2.3.1消息传递神经网络(MPNN:message passing neural networks) 10

2.3.2非局部神经网络(NLNN:Non-local neural networks) 10

2.3.3图形网络(GN:Graph Networks) 10

三、 应用 11

3.1结构场景(Structural Scenarios) 11

3.1.1 物理方面(Physics) 11

3.1.2化学与生物学(Chemistry and Biology) 11

3.1.3知识图(Knowledge graph) 11

3.2非结构场景(Non-structural Scenarios) 12

3.2.1图像 12

3.2.2文本 12

3.3其他场景 12

3.3.1生成模型 12

3.3.2组合优化 13

四、4个开放性问题 15

(1) 浅层结构(Shallow Structure): 15

(2) 动态图(Dynamic Graphs) 15

(3) 非结构场景(Non-Structural Scenarios) 15

(4) 可扩展性(Scalability) 15

GNN综述

内容简介:

在过去的几年中,图形神经网络GNN已成为图域中机器学习任务的强大而实用的工具。 这一进步归功于表现力,模型灵活性和训练算法的进步。 在此综述中,我们对图神经网络进行了全面讲解。 对于GNN模型,我们介绍按图的类型,传播类型和训练类型来分类GNN的变体。 此外,我们还总结了几个一般框架工作,以统一表示不同的变体。 在应用分类方面,我们将GNN的应用划分为结构场景,非结构场景和其他场景,然后对每个场景中的应用进行详细介绍。 最后,我们提出四个开放性问题,指出图神经网络的主要挑战和未来研究方向,包括模型深度,可扩展性,处理动态图和非结构场景的能力。

一、介绍(GCN基于CNN和图嵌入)

1.研究GNN的动机:

- CNNs只能对常规的欧几里德数据(图片,文本)进行操作。将CNN应用到GNN有如下原因。CNN的关键是:局部连接、共享权重和使用多层。这些特点对于解决图域问题也具有重要意义。因为(1)图是最典型的局部连通结构。(2)与传统谱图理论相比,共享权降低了计算量。(3)多层结构是处理分层模式的关键,它能捕捉不同尺寸的特征。

- 图嵌入:基于网络的特点将网络中的一个节点映射成一个低维度向量,这样就可以衡量节点之间的相似度。DeepWalk、node2vec、 LINE、 TADW这些方法都使用了表征学习和图嵌入的思想,但是存在两个缺陷,(1)编码器中的节点之间没有共享参数,这意味着参数的数目随着节点数量线性增长,这导致计算效率低,(2)直接嵌入方法缺乏泛化能力,这意味着它们不能处理动态图形或推广到新的图形。

2.研究GNN的原因:

- 标准的神经网络(如CNNs和RNNs)因为它们是将节点的特征按特定的顺序堆叠所以不能正确地处理图形输入(图节点自然顺序)。为了完整地表示一个图,我们应该遍历所有可能的顺序作为模型(CNN和RNN)的输入,所以这时计算是非常冗余的,为了解决这个问题,GNN分别在每个节点上传播,忽略节点的输入顺序。

- 图中的边缘表示两个节点之间的相关性信息。在标准神经网络中,依赖信息被视为节点的特征。然而,GNN可以在图形结构的指导下进行传播,而不是将其作为特性的一部分使用。一般情况下,GNN通过其邻域状态的加权和来更新节点的隐藏状态。

- 推理是高级人工智能的一个非常重要的研究课题,人脑中的推理过程几乎是基于从日常经验中提取出来的图形。标准的神经网络可以通过学习数据的分布来生成合成图像和文档但它们仍然不能从大量的经验中学习推理图。GNN探索从场景图片和故事文档等非结构化数据生成图形,这可以成为更高层次人工智能的一个强大的神经模型。

3.早期的GNN研究:

(1)The graph neural network model:给出了早期图神经网络方法的形式化定义。

(2)Computational capabilities of graph neural networks:论证了图神经网络的逼近性质和计算能力。

(3)Geometric deep learning on graphs and manifolds using mixture model cnns:提出了一个统一的框架Monet,将cnn架构推广到非欧几里德域(图和流形)。该框架可以推广到几种图的谱方法。如Semi-supervised classifification with graph convolutional networks,“Diffusion-convolutional neural networks

以及关于流形Geodesic convolutional neural networks on riemannian manifolds、Learning shape correspondence with anisotropic convolutional neural networks

的一些模型。

(4)Geometric deep learning: going beyond euclidean data:对几何深度学习作了全面的回顾,介绍了它的问题、困难、解决办法、应用和今后的方向。

(5)Geometric deep learning on graphs and manifolds using mixture model cnns和Geometric deep learning: going beyond euclidean data:集中讨论把卷积推广到图或流形上

(6)Neural message passing for quantum chemistry:提出了消息传递神经网络(MPNN),它可以推广几种图神经网络和图卷积网络方法。给出了消息传递神经网络的定义,并说明了其在量子化学中的应用。[

(7)Non-local neural networks:提出了非局部神经网络(NLNN),它统一了几种“self-attention”式的方法。但模型没有在图表上明确定义。

(8)对于特定的应用领域,Neural message passing for quantum chemistry

和Non-local neural networks只给出了如何使用他们的框架推广其他模型的例子,他们没有提供对其他图神经网络模型的评论。

(9)Relational inductive biases, deep learning, and graph networks提出了图网络(GN)框架。该框架具有较强的推广到其他模型的能力,它的关系归纳偏差促进了组合泛化,这被认为是人工智能重要部分。

二、模型

2.1原始GNN

The graph neural network model:图神经网络(GNN)的概念在该文献中首次提出,它扩展了现有的神经网络来处理图域表示的数据。

缺陷:

- 迭代更新不动点的隐藏状态效率低。

- GNN在迭代中使用相同的参数,而大多数流行的神经网络在不同的层中使用不同的参数。

- 无法有效地对边的一些信息特征进行建模

- 如果我们关注节点的表示而不是图,则不适合使用固定点,因为在固定点中表示的分布将是非常平滑的值并且用于区分每个节点的信息量较少。

GNN的目标是学习每个节点的状态嵌入hv(state embedding),hv包含节点的邻域信息。

计算公式如下:

hv是节点v的s维向量,可用于产生输出ov(如节点标签)。

f是一个参数函数,称为局部转移函数,所有节点共享,并根据输入邻域更新节点状态。

g为描述输出产生方式的局部输出函数。

hv和ov定义如下

hv = f(xv, xco[v] , hne[v] , xne[v])

ov = g(hv, xv)

其中xv表示节点v的特征,xco[v]表示节点v的边的特征,hne[v]表示边的状态,xne[v]表示v邻域节点的特征

H,O,X和XN分别是通过堆叠所有状态,所有输出,所有特征和所有节点特征而构造的矢量。

H = F(H, X)

O = G(H, XN)

其中F全局转换函数和G全局输出函数分别是图中所有节点的f和g的堆叠而成

Ht+1 = F(Ht , X)其中Ht表示H的第t次迭代

2.2 GNN的变体

从以下三个方面分类GNN变体

- 图类型:重点关注在不同图形类型上操作,这些变体扩展了原始模型的表示能力。

- 传播类型:在传播步骤中列出了几种修改(卷积、门机制、注意机制和跳过连接),并且这些模型可以以更高的质量来学习表示。

- 训练方法:描述了使用高级训练方法的GNN变体,其提高了训练效率。

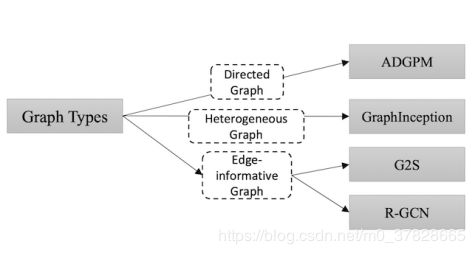

2.2.1图类型

(1)有向图:有向图比无向图包含更多的信息。在文献Rethinking knowledge graph propagation for zero-shot learning中,ADGPM使用两种权重矩阵Wp和Wc,以包含更精确的结构信息。

(2)异构图:异构图中有多种类型的节点。处理异构图的最简单方法是将每个节点的类型转换为一个与原始特征连接的单一热点特征向量。此外,在文献Deep collective classifification in heterogeneous information networks中,GraphInception将元路径的概念引入到异构图的传播中。使用元路径,我们可以根据邻居的节点类型和距离对其进行分组。对于每个邻居组,GraphInception将其视为同构图中的子图,以进行传播并连接来自不同同构图的传播结果,以进行集合节点表示。

(3)具有边信息的图:边具有权重或类型的信息。我们有两种方法处理这类图。方法一,我们可以将图形转换为二分图,其中原始边缘也成为节点,一个原始边缘被分成两个新边缘,这意味着边缘节点和开始/结束节点之间有两个新边缘。文献Graph-to-sequence learning using gated graph neural networks中的G2S使用这种方法。方法二,我们可以调整不同的权重矩阵用于不同类型的边的传播。当关系数量非常大时,r-GCN引入了两种正则化(基础和块对角分解),以减少用于建模关系量的参数数量。(R-GCN源于Modeling relational data with graph convolutional networks)

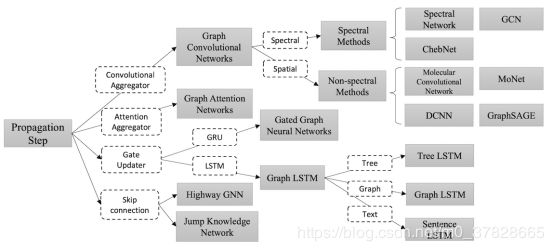

2.2.2传播类型(传播过程使用的方法)

(1)卷积:将卷积应用到图域的GCN,分为spectral approaches 和

non-spectral approaches。

关于spectral approaches(使用谱分解的方法,应用图的拉普拉斯矩阵分解进行节点的信息收集):

Spectral networks and locally connected networks on graphs:提出了spectral network,这种方法通过计算图Laplacian(拉普拉斯算子)的特征点,在Fourier(傅里叶)区域定义了卷积运算,这种操作会导致潜在的密集计算和非空间局部化滤波器。

Deep convolutional networks on graph-structured data:试图通过引入平滑系数的参数化来使光谱滤波器在空间上局部化。

Wavelets on graphs via spectral graph theory:认为gθ(Λ)可以用切比雪夫多项式Tk(x)的截断展开逼近,直至Kth阶。

Convolutional neural networks on graphs with fast localized spectral fifiltering

使用K局部化卷积来定义卷积神经网络,这可以消除计算拉普拉斯算子的特征向量的需要。

Semi-supervised classifification with graph convolutional networks

将分层卷积运算限制为K=1,以缓解极宽节点度分布图的局部邻域结构过拟合问题。

Bayesian semi-supervised learning with graph gaussian processes提出了一种基于高斯过程的贝叶斯方法来解决图上的半监督学习问题。该模型与谱滤波方法具有相似之处。

关于non-spectral approaches(直接使用图的拓扑结构,根据图的邻居信息进行信息收集):这类方法的主要挑战是定义不同大小邻域的卷积运算,并保持CNN的局部不变性。

Convolutional networks on graphs for learning molecular fingerprints:对不同度的节点使用不同的权重矩阵,该方法的主要缺点是不能应用于节点度较大的大规模图。

Diffusion-convolutional neural networks提出了扩散-卷积神经网络(DCNNs),在DCNNs中转换矩阵用于定义节点的邻域。

Learning convolutional neural networks for graphs提取每个节点的k个邻域并将其规范化。然后把规范化邻域作为卷积运算的接收域。

Geometric deep learning on graphs and manifolds using mixture model cnns 提出了非欧氏域上的空间域模型(MoNet),它可以概括几种先前的技术,流形上的Geodesic CNN (GCNN)和Anisotropic CNN (ACNN)以及图形上的GCN和DCNN都是MoNet的特例。

Inductive representation learning on large graphs提出了一个通用归纳框架GraphSAGE,该框架通过从节点的局部邻域抽取和聚合特征来生成嵌入,通过均匀抽样来构建固定大小的邻域集。该文献提出三个聚合函数:Mean aggregator、LSTM aggregator、Pooling aggregator。

(2)门机制:将门机制(例如GRU和LSTM)应用于以前的GNN模型的传播步骤中,以减少限制和改善信息在图形结构中的长期传播。gated graph neural network(GGNN)在传播步骤使用Gate Recurrent Units (GRU)。Improved semantic representations from tree-structured long short-term memory networks提出了对基本LSTM体系结构的两个扩展:Child-Sum Tree-LSTM和N-ary TreeLSTM。Conversation modeling on reddit using a graph-structured lstm中的graph-structured LSTM是N-ary TreeLSTM应用于图的一个例子。Cross-sentence n-ary relation extraction with graph lstms,基于关系提取任务提出了GraphLSTM的另一变体。Sentence-state lstm for text

representation提出了改进文本编码的Sentence LSTM (S-LSTM)。

(3)注意力机制

Graph attention networks提出了一个graph attention network(GAT),它将注意力机制纳入到传播步骤中。在文献中,节点-邻居对的计算使用并行计算,所以效率高;它可以通过指定邻域的权值来应用于不同度的节点;它可以很容易地应用于归纳学习问题。

(4)跳跃连接

为了获得更好的结果,许多应用程序展开或堆叠图形神经网络层,因为更多层(即k层)使得每个节点聚集来自邻居k的更多信息。但是在许多实验中更深的模型并不能提高性能甚至表现的更差,主要原因是噪声数据也会随之传播,Deep residual learning for image recognition中的残差网络(residual network)可以优化此问题。Semi-supervised user geolocation via graph convolutional networks提出了一种 Highway GCN,它使用类似于公路网的分层门,对于某些特定的问题使用多层神经网络可以有更好的结果。Representation learning on graphs with jumping knowledge networks研究了邻域聚集方案的性质及其局限性。提出了一种能学习自适应、结构感知表示的跳跃式知识网络(Jump Knowledge Network),跳跃知识网络在社会、生物信息学和引文网络的实验中表现良好,它还可以与GCN、GraphSAGE和GAT等模型相结合提高其性能。

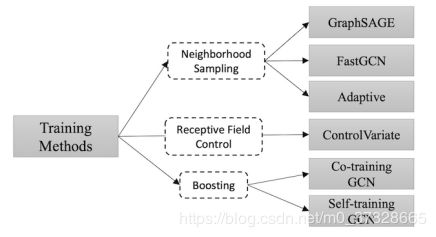

2.2.3训练方法

原始的GCN在训练和优化方法上存在一些缺点,具体来说,GCN需要全图Laplacian,图越大计算量越大。此外,第L层节点的嵌入是通过其在层L-1上的所有邻居的嵌入来递归计算的,所以,单个节点的接收域随层数呈指数增长,因此单个节点的梯度计算成本很高。最后,GCN被独立训练成一个固定的图,缺乏归纳学习的能力。

Inductive representation learning on large graphs中的GraphSAGE是对原GCN的全面改进,为了解决上述问题,GraphSAGE用可学习的聚集函数代替了全图Laplacian,这是将消息传递并推广到不可见节点的关键,此外,GraphSAGE使用邻居采样来减少接收域的增长。

Fastgcn: fast learning with graph convolutional networks via importance sampling中的FastGCN进一步改进了采样算法,FastGCN不对每个节点的邻居进行采样,而是直接对每个层的接收域进行采样。

与上面的固定采样方法相比,Adaptive sampling towards fast graph representation learning引入了参数化和可训练的采样器,用于在前一层上进行分层采样,此外,该自适应采样器可以找到最佳采样重要性并同时减少方差。

Stochastic training of graph convolutional networks with variance reduction

通过利用节点的历史激活作为控制变量,提出了一种基于控制 - 变量的GCN随机近似算法。该方法限制了1-hop邻域中的接收域,但使用历史隐藏状态作为可承受的近似值。

Deeper insights into graph convolutional networks for semi-supervised learning

重点关注GCN的局限性,其中包括GCN需要更多的标记数据来验证,而且还受到卷积滤波器的局限性的影响。为了解决这一问题,作者提出了Co-Training GCN和Self-Training GCN,以扩大训练数据集,前一种方法寻找训练数据的近邻,而后一种方法采用一种类似于增强(boosting)的方法。

2.3通用框架(将不同的模型集成到一个单一的框架中)

Neural message passing for quantum chemistry,将各种图神经网络和图卷积网络相结合,提出了消息传递神经网络(MPNN)。

Non-local neural networks提出了非局部神经网络(NLNN)。它统一几种self-attention

的方法。

Relational inductive biases, deep learning, and graph networks提出了图形网络(GN)统一了MPNN和NLNN方法以及许多其他变体,如Interaction Networks, Neural Physics Engine, CommNet, structure2vec , GGNN, Relation Network, Deep Sets and Point Net。

2.3.1消息传递神经网络(MPNN:message passing neural networks)

针对图的有监督学习算法的框架,概括了图卷积中的spectral approaches和

non-spectral approaches、gated graph neural networks(门控神经网络)、interaction networks(交互网络)、 molecular graph convolutions(分子图卷积)、deep tensor neural networks(深张量神经网络)等。

模型包含两个阶段:消息传递阶段和读出阶段。消息传递阶段(即传播步骤)运行于T个时间步骤,并根据消息函数和顶点更新函数定义。读出阶段使用读出函数计算整个图的特征向量。消息函数、顶点更新函数和读出函数可以具有不同的设置,MPNN框架可以通过不同的函数设置来概括几个不同的模型。

2.3.2非局部神经网络(NLNN:Non-local neural networks)

NLNN利用深度神经网络捕获远距离依赖关系。非局部操作是计算机视觉中经典的非局部平均操作的概括。 非局部操作将位置处的响应计算为所有位置处的特征的加权和。 这组位置可以是空间,时间或时空。 因此,NLNN可以被视为不同“自我关注”式方法的统一。

2.3.3图形网络(GN:Graph Networks)

该框架是对各种图神经网络、MPNN和NLNN方法的推广和扩展。关于GN,综述首先介绍了图的定义,然后描述了GN block、a core GN computation unit和计算步骤,最后介绍了它设计的基本原则。

图定义:图定义为三元组G=(u,H,E),u是一个全局属性,H是节点集合,E是边的集合。

GN块包含三个更新函数(φ)和三个聚合函数(ρ),其中ρ函数必须对其输入的序列保持不变,并且应该采用可变的参数。

计算步骤:略

设计原则:灵活的表示、可配置的块内结构和可组合的多块结构。

- 应用

图形神经网络在监督,半监督,无监督和强化学习设置的领域中广泛应用。将应用程序划分为三个场景:(1)数据具有明确关系结构的结构场景,例如物理系统,分子结构和知识图; (2)关系结构不明确的非结构场景包括图像,文本等; (3)其他应用场景,如生成模型和组合优化问题。

3.1结构场景(Structural Scenarios)

具体应用:社会网络预测,流量预测,推荐系统和图表示

3.1.1 物理方面(Physics)

模拟真实世界的物理系统是理解人类智力最基本的方面之一。通过将对象表示为节点,将关系表示为边,我们可以执行基于GNN的推理,以一种简化但有效的方式来讨论物体、关系和物理。

Interaction networks for learning about objects, relations and physics提出了交互网络(Interaction Networks)来预测和推断各种物理系统。 该模型以对象和关系作为输入,推理它们的相互作用,并应用作用和物理动力学来预测新状态。

Visual interaction networks: Learning a physics simulator from video提出视觉交互网络(Visual Interaction Networks),可以从像素进行预测。它从每个对象的两个连续输入帧中学习一个状态代码,然后,将它们的相互作用加到一个Interaction Net block,之后,状态译码器将状态码转换为下一步的状态。

Graph networks as learnable physics engines for inference and control提出了一种基于图形网络的模型,它可以执行状态预测或归纳推理。 推理模型将部分观察到的信息作为输入,并构造隐式系统分类的隐藏图。

3.1.2化学与生物学(Chemistry and Biology)

Molecular Fingerprints(分子指纹):计算分子指纹,即代表分子的特征向量,是计算机辅助药物设计的核心步骤。 传统的分子指纹是手工制作和固定的。 通过将GNN应用于分子图,我们可以获得更好的指纹。

Protein Interface Prediction(蛋白质界面预测):Protein interface prediction using graph convolutional networks专注于蛋白质界面预测这一任务,这是一个具有挑战性的问题,在药物发现和设计中具有重要应用。 所提出的基于GCN的方法分别学习配体和受体蛋白残基表示并将它们合并用于成对分类。

3.1.3知识图(Knowledge graph)

Knowledge transfer for out-of-knowledge-base entities : A graph neural network approach利用GNN来解决知识库完成(KBC:knowledge base completion)中的知识库外(OOKB:out-of-knowledge-base)实体问题。

Cross-lingual knowledge graph alignment via graph convolutional networks利用GCN来解决跨语言知识图对齐问题。 该模型将来自不同语言的实体嵌入到统一的嵌入空间中,并根据嵌入相似性对齐它们。

3.2非结构场景(Non-structural Scenarios)

简单地说,有两种方法将图神经网络应用于非结构场景:(1)结合来自其他领域的结构信息以改善性能,例如使用来自知识图的信息来缓解图像任务中的zero-shot问题; (2)推断或假设场景中的关系结构,然后应用模型来解决图上定义的问题,例如中文本建模为图形。

3.2.1图像

- 图像分类:GCN、GGNN、ADGPM、GSNN、

- 视觉推理

- 语义分割:Graph LSTM、GGNN、DGCNN、3DGNN

3.2.2文本

- 文本分类:GCN、GAT、DGCNN、Text GCN、Sentence LSTM

- 序列标记:Sentence LSTM、

- 神经机器翻译:Syntactic GCN、GGNN

- 关系提取:Tree LSTM、Graph LSTM、GCN

- 事件提取:Syntactic GCN

3.3其他场景

3.3.1生成模型

生成模型是一种训练模型进行无监督学习的模型,给模型一组数据,希望从数据中学习到信息后的模型能够生成一组和训练集尽可能相近的数据。 图片生成模型就是更具体的指向说给模型一组图片作为训练集让模型进行学习,希望模型生成一组和训练集图片尽可能相近的图片。

Netgan: Generating graphs via random walks,提出NetGAN,通过随机游动生成图,它将图的生成问题转化为以特定图的随机游动为输入的游走生成问题,并利用GAN结构训练出行走生成模型。

生成图保留了原始图的重要拓扑属性,但是生成过程中节点的数量无法改变,与原始图相同。

Graphrnn: Generating realistic graphs with deep auto-regressive models提出GraphRNN通过逐步生成每个节点的邻接向量来生成图的邻接矩阵,从而可以输出不同节点数的网络。

Molgan: An implicit generative model for small molecular graphs提出的MolGAN不是依次生成邻接矩阵,而是一次预测离散图结构(邻接矩阵),并利用置换不变判别器来解决邻接矩阵中的节点改变问题。

Learning deep generative models of graphs提出了一种模型,该模型顺序地生成边和节点,并利用图形神经网络来提取当前图形的隐藏状态,该状态用于在顺序生成过程期间决定下一步骤中的动作。

3.3.2组合优化

图的组合优化问题是一组NP问题,引起了各个领域科学家的广泛关注。 一些具体问题如旅行推销员问题(TSP)和最小生成树(MST)已经得到了各种启发式解决方案,最近,使用深度神经网络来解决这些问题已成为热点,并且由于其图形结构,一些解决方案进一步利用图形神经网络。

Neural combinatorial optimization with reinforcement learning首先提出了一种深度学习的方法来解决TSP问题。他们的方法由两部分组成:用于参数化奖励的指针网络和用于训练的策略梯度模块。 事实证明,这项工作可与传统方法相媲美。

Combinatorial optimization with graph convolutional networks and guided tree search直接使用GNN作为分类器,可以对具有成对边的图进行密集预测。 模型的其余部分帮助GNN做出各种选择并有效地进行训练。

四、4个开放性问题

- 浅层结构(Shallow Structure):

传统的深层神经网络由于具有更多的参数,可以叠加数百层以获得更好的性能,从而显着地提高了神经网络的表达能力,然而,图的神经网络往往是浅层的,大部分都是三层以下的。实验表明,叠加多个GCN层会导致过度平滑,也就是说,所有顶点都会收敛到相同的值。尽管一些研究人员设法解决了这个问题,但它仍然是GNN的最大限制。

- 动态图(Dynamic Graphs)

另一个具有挑战性的问题是如何处理具有动态结构的图形。静态图形是稳定的,因此可以对它们进行可行性建模,而动态图形则引入变化的结构。当边和节点出现或消失时,GNN不能自适应变化。动态GNN正在积极研究之中,我们相信它将成为通用GNN稳定性和适应性的一个重要里程碑。

- 非结构场景(Non-Structural Scenarios)

虽然我们已经讨论了GNN在非结构化场景中的应用,但是我们发现没有最优的方法来从原始数据生成图。在图域中,一些工作利用cnn获取特征映射,然后对其进行采样,形成作为节点的超像素,而另一些工作则直接利用一些对象检测算法来获取对象节点。在文本领域,一些工作采用句法树作为句法图,而另一些工作则采用全连通图。因此,找到最佳的图形生成方法将提供更广泛的领域,GNN可以在这些领域中做出贡献。

- 可扩展性(Scalability)

如何在社交网络或推荐系统等网络环境中应用嵌入方法对于几乎所有图形嵌入算法来说都是一个致命的问题,而GNN也不例外。 扩展GNN很困难,因为许多核心步骤在大数据环境中都是计算消耗。 关于这种现象有几个例子:首先,图形数据不是规则的欧几里德数据,每个节点都有自己的邻域结构,因此不能批量处理。 然后,当存在数百万个节点和边时,计算图拉普拉斯算子也是不可行的。 此外,我们需要指出缩放确定算法是否能够应用于实际应用。 有几项工作提出了解决这个问题的办法,我们正在密切关注这一进展。

附:

w.r.t. : with respect to 的缩写。是 关于;谈及,谈到的意思。

i.e. :也就是,亦即(源自拉丁文id est),换而言之。

e.g. = for example的意思,当句子中需要举例子时用