人工智能(AI)的未来令人充满期待,但目前却存在着一些问题,而且往往和道德伦理相关。机器学习在哪些方面让我们感到震惊?你能骗过一台机器吗?如果能,难度有多大?《终结者》里的Skynet(天网)和机器会真的出现在现实生活中吗?下面我们就来具体讨论一下。

强人工智能和弱人工智能

首先,我们需要区分两个概念:强人工智能和弱人工智能。强人工智能是一种有思考能力、有自我意识的假想机器,不仅能处理有针对性的任务,还可以学习新事物。

弱人工智能目前已经存在,具体应用于解决特定问题,如图像识别、汽车驾驶、下围棋等。弱人工智能就是我们称之为”机器学习”的东西。

目前我们还不知道是否能发明出强人工智能。根据专家调查,或许我们还得再等45年。但这真确实意味着”有朝一日”能实现强人工智能。比如,专家们还表示,融合能力将在40年内实现商业化 – 而50年前专家就这样说过。

可能出现什么问题?

目前还不清楚什么时候才能开发出强人工智能,但弱人工智能已经出现,并在许多领域进行应用。应用人工智能的领域每年都在增长。机器学习让我们不必明确编程就能处理实际任务;机器学习是从实例中进行学习。有关详细信息,请阅读机器学习工作原理(精简版)。

我们教会机器解决具体问题,由此产生的数学模型被称之为”学习”算法,但这种模型不可能突然发展出渴望奴役(或拯救)人类的思想。换句话说,我们不用担心弱人工智能产生出电影《终结者》中的天网。不过在有些方面仍然可能会出问题。

1. 不良企图

如果我们教一支无人机部队使用机器学习来杀人,结果符合道德标准吗?

去年围绕这个话题引发了一个小小的丑闻。谷歌参与了美国国防部的Project Maven军事计划,为其开发一款软件,旨在提高无人机打击的精准度。未来,这款软件可能有助于建立完全自主的武器系统。

结果,12名谷歌员工以辞职表示抗议,还有4,000名员工签署请愿书,要求公司放弃与军方的合同。人工智能、道德和IT领域的1000多名知名科学家联合发布了一封致谷歌的公开信,要求谷歌放弃该项目,支持禁止自主武器的国际协议。

2. 开发人员的偏见

就算机器学习算法的开发人员本意是好的,但他们中的很多人仍然希望能赚钱 – 也就是说,创建的算法是为了使开发人员获利,而不一定是为了社会的利益。例如,一些医疗算法可能会偏向于推荐昂贵的治疗方法,而不是首选最佳患者治疗方案。

有时候,社会本身对算法成为道德模范不感兴趣。例如,车速和车祸死亡率之间的权衡。我们可以将自动驾驶汽车的最高行驶速度限制在15英里/小时以下,这样几乎可以把车祸死亡率降至零,但这样却大大影响到汽车的其他优点。

3. 系统参数不一定涉及道德伦理

计算机在默认的情况下,对道德伦理一无所知。一种算法可以把国家预算与”最大化GDP/劳动生产率/预期寿命”的目标结合在一起,但如果没有在模型中编入伦理限制,则可能会取消对学校、收容所和环境的预算,因为这些机构不会直接增加GDP。

从更广范的目标出发,计算机可能会决定开除无工作能力的人,从而提高生产率。

重点是,必须在一开始就融入相关的道德伦理。

4. 伦理相对性

道德伦理随着时间而变化,有时候变更速度非常快。比如,对双性恋和跨性别(LGBT)的权利以及种族间通婚或跨种姓婚姻等问题的看法,可能在一代人内就发生重大变化。

道德伦理即便是在同一个国家的不同群体之间也会有所差异,更不用说在不同的国家了。比如在中国,将人脸识别功能用于大众监控已成为常态。但其他国家可能对这个问题有着截然不同的看法,实际决定可能取决于具体情况。

政治氛围也很重要。例如,反恐战争极大地改变了许多国家的一些道德规范和理念,速度快得令人难以置信。

5. 机器学习改变人类

例如,机器学习系统可推荐电影,机器学习会根据您对其他电影的评分,将您的偏好与其他用户进行对比,然后向您推荐电影。有些系统在这方面相当擅长。这只是人工智能直接影响人类的其中一个例子。

长期下来,您的偏好将因为电影推荐系统而被改变,兴趣范围也会缩小。没有电影推荐系统,有时候你得面对可能会遇到不好看的电影和不想看的电影类型。最终,你不再主动去研究自己喜欢哪些电影,而只是被动地接受系统推荐。

但可怕的是,我们甚至没有意识到计算机对我们的操控。电影的例子可能并没那么可怕,但要是运用到新闻和宣传中会怎样。

6. 虚假相关性

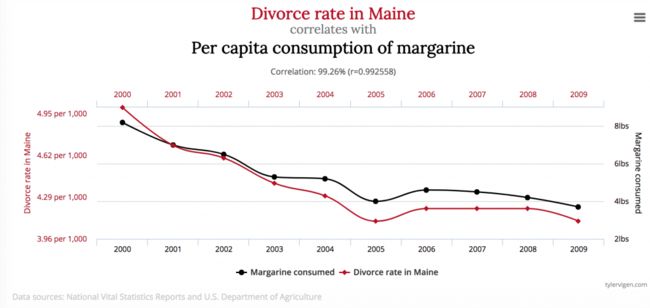

当完全彼此独立的事物表现出非常相似的行为时,就会产生一种虚假的关联,这会造成一种错觉,认为它们之间存在某种联系。比如,你会认为美国的人造黄油消费与缅甸州的离婚率有密切关系吗?

当然,我想任何一个正常人,只要有一定的经验学识和智力,都马上会发现这二者之间不可能有任何直接的联系。但数学模型并不具备这样的经验学识,它只是用来学习数据和对数据进行泛化的工具。

一个众所周知的例子如下:有一个计划用于对患者进行分类,确定急救程度。该计划得出的结论是未患哮喘的肺炎患者应优先于患有肺炎的哮喘患者进行急救。之所以有这样的结论,是因为该计划对数据进行研究后,得出的结论是,哮喘患者死亡的危险性较小,因此不应该作为优先事项处理。但事实上,哮喘患者的死亡率之所以非常低,原因是他们总是能在医疗机构得到急救,因为他们的病情有着非常高的死亡风险。

7. 反馈循环

相比虚假相关性,反馈循环更糟糕。反馈循环是指算法决策影响现实的情形,反过来又使算法确信其结论是正确的。

例如,加利福尼亚州的一项预防犯罪计划表明,警方应该根据犯罪率(即记录在案的案件数量)向非洲裔美国人社区派遣相应数量的警官。但最终会陷入到这样一个循环里:一个街区的警察数量越多,当地居民的报警数量增多(有些人会直接向在场的警官报警),警察会记录更多案件,犯罪率随之上升 – 而按照计划这就要往该区域派遣更多的警察,人们的报案数量就又增多,报案率上升,便又增加警察数量……

8. “被污染”或”毒化”的参考数据

算法学习的结果很大程度上取决于参考数据,这些数据构成了学习的基础。然而,数据很有可能会因为某种偶然情况或是个人意图而发生扭曲,即数据”被污染”(对于后一种情况,常称为”毒化”)。

下面是参考数据发生意外问题的例子。如果用作招聘算法培训样本的数据是从具有种族主义招聘实践的公司获得的,那么该算法也将带有种族主义色彩。

微软曾在推特上推出过一款聊天机器人,这款机器人能与任何聊天。但是微软的此个聊天项目却只进行了24小时就不得不停止,因为热心的网络用户迅速教会了聊天机器人发誓和背诵希特勒的《我的奋斗》。

下面是一个机器学习数据被毒化的例子。计算机病毒分析实验室有一款数学模型每天平均处理100万个文件,包括干净和有害的文件。随着威胁形势不断变化,模型也在不断更改,以反病毒数据库更新的形式提供给客户端上安装的产品。

黑客可以持续生成非常类似于干净文件的恶意文件,并将它们发送到实验室。这一操作会逐渐模糊干净和有害文件之间的界限,降低模型的质量,并可能最终导致误报。

这就是为什么卡巴斯基实验室采用多层安全模型,而不仅仅依赖于机器学习的原因。真人 – 即反病毒专家会始终监控机器的操作。

9. 机器欺骗

即便是一个功能齐备、依赖于正常数据的数学模型,如果工作原理一旦泄露,也会让恶人有空可钻。例如,有一组研究人员研发了一种可以欺骗人脸识别算法的特殊眼镜,这种眼镜会在图像中引入极小的失真,从而改变面部识别结果。

就算在似乎不涉及任何复杂因素的情况下,机器也很容易被外行所不知道的方法骗过。

此外,要想降低机器学习数学模型的能力,这些变化不一定要很大 – 人眼难以察觉的微小变化就足够了。

只要人类一直比大多数算法更聪明,人类就能够骗过机器算法。想想看在不远的未来,机器学习用于在机场分析行李X射线和搜查武器。但狡猾的恐怖分子可以在枪旁边放置某种形状的物体,从而使枪对机器隐形。

谁该负责?该怎样解决?

2016年,奥巴马政府的大数据工作组发布了一份报告,警告说:”在自动化决策中可能存在编码歧视”。该报告还呼吁创建遵循平等设计原则的算法。

说起来容易做起来难。

首先,机器学习数学模型很难测试和修复。人类会逐步评估常规程序,并知道如何对其进行测试。但是在机器学习中,一切都取决于学习样本的大小,而样本的数量是有限的。

例如:软件工程师JackyAlciné曾指出谷歌照片中的图像识别算法将他的黑人朋友归类为”大猩猩”。谷歌对此错误感到震惊,并向 Alciné表示歉意,承诺修复该错误。然而三年后,谷歌除了禁止在图像标记中使用”大猩猩”等类似词语外,并没有其他更好的解决方案。

Google Photo应用在识别到黑人时,会将其标记归类为大猩猩。这是真的!正如你想得,这确实是一个丑闻,谷歌承诺会修复算法。然而三年后,谷歌除了禁止在图像标记中使用”大猩猩”、”黑猩猩”或”猴子”等类似词语外,并没有其他更好的解决方案。

其次,机器学习算法的决策很难被理解和解释。神经网络会在其内部安排加权系数来得到答案。但其过程是怎样的?要怎样做才能更改答案?

2015年的一项研究显示,Google AdSense高薪工作广告的浏览次数,男性高于女性。亚马逊当天免费送货的服务,在非洲裔美国人社区(黑人社区)是享受不到的。对于这两种情况,两家公司均表示无法解释这些由算法做出的决定。

对此没法怪罪任何人。因此我们需要对机器人制定出一套新的法律法规来规范机器人的行为决策。2018年5月,德国人迈出了第一步,他们发布了世界上第一个自动驾驶汽车道德伦理指南。其中部分内容如下:

- 人类的安全始终优先于动物或其他财产

- 对于不可避免的事故,任何区别因素的歧视判断都是不允许的。

但对我们来说尤为重要的一条是:

- 自动驾驶系统要永远保证比人类驾驶员造成的事故少

显然,机器学习在个别任务的管理能力上确实比人类强,导致我们对机器学习的依赖程度越来越高。因此务必记住这些机器学习的缺陷和可能的问题,尽量在开发阶段就预测到所有可能存在的问题,并记得监控算法执行情况,避免情况变得不可收拾。

转载自:机器学习:9大挑战