论文笔记:Towards accurate multi-person pose estimation in the wild(G-RMI)

Towards accurate multi-person pose estimation in the wild

- 1、摘要

- 2、方法

- 2.1、人体检测

- 2.2、姿态估计

- 3、实验

- 4、总结

1、摘要

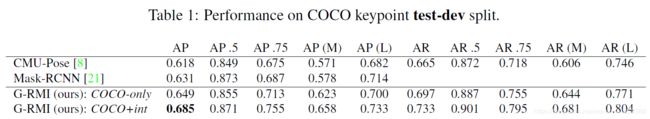

作者提出了新的自顶向下的多人姿态估计方法。首先使用 F a s t e r R C N N Faster~RCNN Faster RCNN 预测可能包含人体目标的边界框的位置和大小。然后估计每个提议边界框可能包含的关键点。使用全卷积 R e s N e t ResNet ResNet 预测每个关键点的密度热图和偏移量。为了合并输出,作者引入了一种新的聚合过程来获得高度定位的关键点预测。作者还使用了一种新形式的基于关键点的非最大值抑制,而不是更粗糙的框级非最大抑制,以及一种新形式的基于关键点的置信度得分估计,而不是框级得分。

2、方法

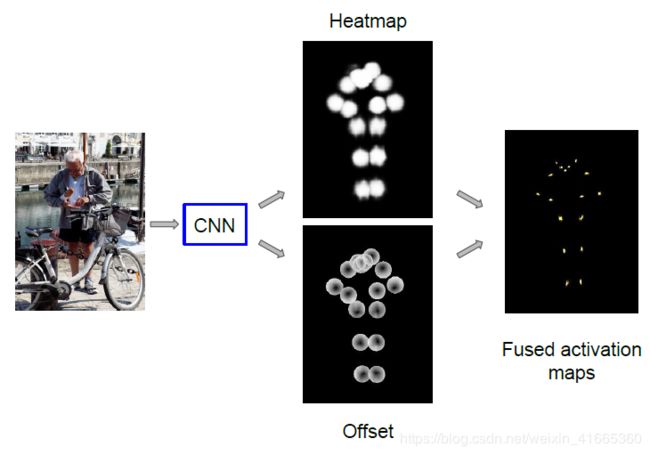

如图 1 1 1 所示为算法处理过程。

图 1 1 1 首先使用 F a s t e r R C N N Faster~RCNN Faster RCNN 检测人体目标,然后裁剪相应目标图像块,使用姿态估计器定位关键点,并且对相应提议重新打分。

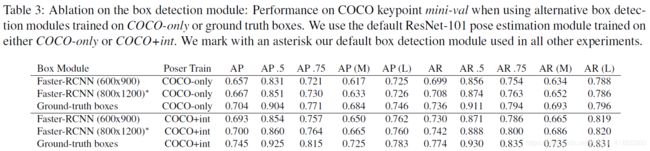

2.1、人体检测

使用空洞卷积替代的 R e s N e t − 101 ResNet-101 ResNet−101 作为 F a s t e r R C N N Faster~RCNN Faster RCNN 检测器网络主骨,输出步长等于 8 8 8 像素。

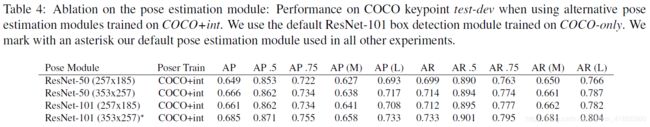

2.2、姿态估计

姿态估计器在给定人体边界框的基础上预测 17 17 17 个人体关键点。对于每个空间位置,首先分类它是否在每个关键点附近(称之为“热图”),然后预测二维局部偏移向量,以获得相应关键点位置的更精确估计。

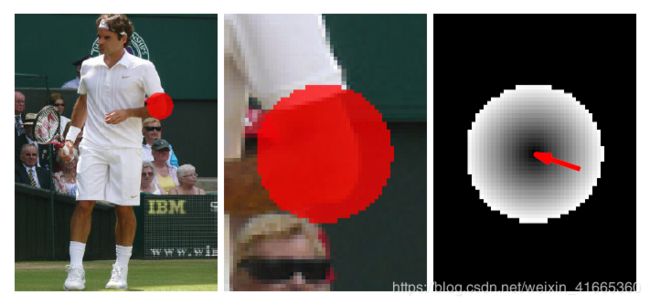

如图 2 2 2 所示,每个关键点对应 3 3 3 个输出通道。

图像裁剪:首先通过扩展人体检测器返回的盒子的高度或宽度,使所有盒子具有相同的固定纵横比,而不扭曲图像纵横比。然后进一步扩大框来包含图像上下文:评估时缩放因子等于 1.25 1.25 1.25,训练时,缩放因子在 1.0 1.0 1.0 到 1.5 1.5 1.5 之间。之后将图像高度调整为 353 353 353,图像宽度调整为 257 257 257。纵横比为 353 / 257 = 1.37 353/257=1.37 353/257=1.37。

热图和偏移预测:使用全卷积的 R e s N e t − 101 ResNet-101 ResNet−101 产生热图(每个关键点一个通道)和偏移(每个关键点两个通道, x x x 和 y y y),一共 3 K 3K 3K 个通道, K = 17 K=17 K=17 为关键点数量。使用空洞卷积产生 3 K 3K 3K 个预测,输出步长为 8 8 8 像素,并使用双线性插值上采样至 353 × 257 353\times257 353×257。

若第 k k k 个关键点定位于 x i x_i xi, f k ( x i ) = 1 f_{k}\left(x_{i}\right)=1 fk(xi)=1,否则为 0 0 0。对每个位置 x i x_i xi 每个关键点 k k k,计算概率 h k ( x i ) = 1 h_{k}\left(x_{i}\right)=1 hk(xi)=1,如果 ∣ ∣ x i − l k ∣ ∣ ≤ R | | x_{i}-l_{k}| | \leq R ∣∣xi−lk∣∣≤R,即,到第 k k k 个关键点的位置 l k l_k lk 在半径为 R R R 的盘内。生成 K K K 个这样的热图,为每个位置和关键点独立解决二分类问题。

除了热图,为每个位置 i i i 和每个关键点 k k k 生成 2 − D 2-D 2−D 偏移向量。 F k ( x i ) = l k − x i F_k(x_i)=l_k-x_i Fk(xi)=lk−xi。一共生成 k k k 个这样的向量场,分别为每个位置和关键点求解回归问题。

生成热图和偏移场后,将两者结合生成高度局部化激活图 f k ( x i ) f_k(x_i) fk(xi):

(1) f k ( x i ) = ∑ j 1 π R 2 G ( x j + F k ( x j ) − x i ) h k ( x j ) f_{k}\left(x_{i}\right)=\sum_{j} \frac{1}{\pi R^{2}} G\left(x_{j}+F_{k}\left(x_{j}\right)-x_{i}\right) h_{k}\left(x_{j}\right)\tag1 fk(xi)=j∑πR21G(xj+Fk(xj)−xi)hk(xj)(1)

其中, G ( ) G() G() 为双线性插值核。这是霍夫投票的形式:图像裁剪网格中的每个点 j j j 投下一张投票,并对每个关键点的位置进行估计,投票由它在相应关键点的影响盘中的概率加权得到。归一化因子等于盘面积,并确保如果热图和偏移是完美的,那么 f k ( x i ) f_k(x_i) fk(xi) 将是以第 k k k 个关键点的位置为中心的单位质量的 δ \delta δ 函数。

该过程如图 3 3 3 所示。

训练:使用两个卷积输出头,一个输出 s i g m o i d sigmoid sigmoid 函数产生概率热图 h k ( x i ) h_k(x_i) hk(xi)。训练目标是 0 0 0 和 1 1 1 组成的热图。相应的损失函数 L h ( θ ) L_h(\theta) Lh(θ) 分别是每个位置和关键点的 l o g i s t i c logistic logistic 损失之和。为加速训练,在 R e s N e t ResNet ResNet 第 50 50 50 层添加中间监督。

偏移损失为:

(2) L o ( θ ) = ∑ k = 1 : K ∑ i : ∥ l k − x i ∥ ≤ R H ( ∥ F k ( x i ) − ( l k − x i ) ∥ ) L_{o}(\theta)=\sum_{k=1 : K} \sum_{i :\left\|l_{k}-x_{i}\right\| \leq R} H\left(\left\|F_{k}\left(x_{i}\right)-\left(l_{k}-x_{i}\right)\right\|\right)\tag2 Lo(θ)=k=1:K∑i:∥lk−xi∥≤R∑H(∥Fk(xi)−(lk−xi)∥)(2)

其中, H ( u ) H(u) H(u) 为 H u b e r Huber Huber 鲁棒损失, l k l_k lk 为第 k k k 个关键点位置,仅计算每个关键点半径 R R R 的盘内的位置 x i x_i xi 的损失。最终损失函数为:

(3) L ( θ ) = λ h L h ( θ ) + λ o L o ( θ ) L(\theta)=\lambda_{h} L_{h}(\theta)+\lambda_{o} L_{o}(\theta)\tag3 L(θ)=λhLh(θ)+λoLo(θ)(3)

其中, λ h = 4 \lambda_h=4 λh=4, λ o = 1 \lambda_o=1 λo=1。计算一个 m i n i b a t c h minibatch minibatch 中所有图像的损失和,然后随机梯度下降。

模型训练中的一个重要考虑是,在热图损失的计算中,如何处理图像裁剪中存在多人的情况。当计算中间层的热图损失时,作者排除了背景人关键点周围盘中的贡献。当计算最后一层的热图损失时,我们只将前景人关键点周围盘内视为正的,而将其他一切视为负的,这迫使模型正确预测框中央人物的关键点。

姿态重打分:测试时,将模型用于每个图像裁剪,而不是仅依赖人检测器置信度。考虑每个关键点置信度。最大化位置,平均化关键点产生最终实例级姿态检测分数。

(4) score ( I ) = 1 K ∑ k = 1 K max x i f k ( x i ) \operatorname{score}(\mathcal{I})=\frac{1}{K} \sum_{k=1}^{K} \max _{x_{i}} f_{k}\left(x_{i}\right)\tag4 score(I)=K1k=1∑Kximaxfk(xi)(4)

基于 OKS 的非最大抑制:使用目标关键点相似度来度量两个候选姿态检测是否重叠。姿态估计器输出处的更精细的 O K S − N M S OKS-NMS OKS−NMS 更适合于确定两个候选检测是对应于 F P FP FP (同一个人的双重检测)还是 T P TP TP(两个人彼此非常接近)。

3、实验

4、总结

- 热图和偏移场生成方法

- 姿态重打分

- 基于 OKS 的非最大抑制