MTCT:Multi-Task Curriculum Transfer Deep Learning of Clothing Attributes

2016.12 on wacv (winter conference on application of computer version)

目的是为了将卖家秀训练的网络识别出买家秀

这篇文章主要用到了迁移学习transfer learning。

目前(2016.12)的顶尖的衣服识别网络FashionNet, DARN and DDAN

与DDAN/DARN和FashionNet的区别

1. 与DDAN:DDAN没有使用相同图片对(pair reltions)

2. 与DARN:DARN用到了同衣物图像对,但是网络结构中,只使用了FC来学习表达属性,以及接下来的属性分类。

3. 与Fashionnet:MTCT不需要使用landmark,这些属性位置的标注信息,因此对数据的要求更开放

关于要解决的问题的定义

每件衣服的图片有一系列的元标签(如衣物类别,领型),属于多标签识别任务 multi-label recognition problem

原来的数据source images是从网店上获取的online shopping,有卖家秀属性;目标数据target images是相应的留言栏中得到的买家秀自拍照selfie,数量少。但是有助于迁移学习的是怎么得到是图片有成对的对应关系。

元标签相对于衣物是局部的关系be localised to image regions; 不同风格的照片之间是全局的关系holistic image-level。

困难与方案

1. 同样是有两个数据域,two-domains。同时,其中一个域的数据缺少人工标注训练数据。这里使用多任务联合训练网络结构,抓取潜在属性间关系的方法。

2. 对于细粒度属性,是使用MTCT多任务网络对属性建模。

3. 同时,学习策略上采用先易后难的“课程学习”的方法。

属性域的问题

除了图片样式和背景差异明显外,数据域不同的两个额外的潜在含义还包括:

首先是标注信息在不同域中不同。

免费网上爬取的数据属性的精度不如人工标注的准确度高

数据集的问题

源数据集的图片比目标域的图片多,图片数量的不一致(控制图片及标注数量的情况下,有可能出现)

相同属性被标注为不同的类别。

cross-domain pair relation对不同数据域的编码很重要

网络结构

Multi-task regression networks 用于人脸建模,这篇文章使用了与之相似的想法——使用网络学习一种衣物多任务区分性网络。

使用多任务网络,相比于独立属性建模的方式,用到了更少的需要学习的参数,不容易过拟合。Compared to independent attribute modelling, such multi-tasklearning also involves a smaller number of to-be-learned model parameters andthus with a lower model overfitting risk towards the given training data,beyond modelling mutual relations among different types of attributes and theircommon representations.

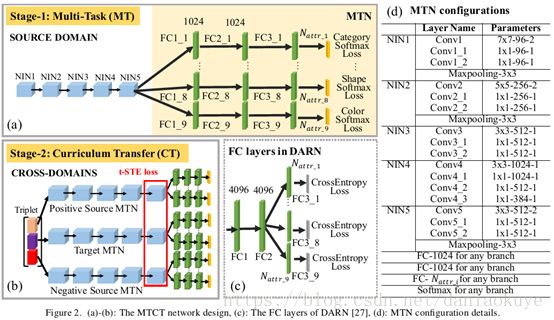

这个网络MTN有5个堆叠的NIN卷积网络单元,和属性个数相同的平行分支。每个分支是三个FC层来模拟相应的类别属性,使用softmax对各类别分类。

在这里之所以三层FC,是因为需要针对特征有表征学习,这是不同于DARN网络的地方。

Cross-domaintransfer learning

克服买家秀数据量少的困难,作者使用的方法是上图中的CT方法课程迁移学习:人和动物学习东西的策略是先易后难,逐步的学习,而不是盲目的随机获取。

针对这篇文章要解决的问题,难易程度的排序有:卖家秀图多质高样式多,比买家秀给力。局部和全局特征相比,局部的是具体特征;全局的是相互对应的目标对,是抽象的,holistic (cross-domain pairing) and local annotations (source domainattributes)。

迁移的思想

是:使次目标简单些,使用递进学习方法(subsequent incremental learning),这甚至都符合心理学中的中间值策略consistent with the notion of adaptive value of starting indevelopmental psychology。迁移时,主要是迁移神经网络学得的关于目标的又与具体数据不相干的目标(衣物)特征信息,特别是深度神经网络中的低维度信息。

具体方式是:构建三元组{源图片,目标中相同图片作为正样本,目标中不同图片作为负样本}然后使用trilet loss,计算loss所用的特征为最后一层卷积层结果.

最后使用的时候,只使用迁移后的目标网络.

关于数据:

细粒度的衣物属性包括:种类,扣子,颜色,长度,款式,形状,领子,袖长,袖子形状.

这些属性的特征空间不一样大,即可选空间不一样

这些属性间的差异可能很微小,subtle,纤维和棉料.

属性标注是整幅图层面上的,没有确切的位置,所以是弱监督分类

如果数据是网店展示的和街拍照片,又有很大的差异.

实施细节

fast rcnn提取衣物,然后裁剪出来。

评价方法:

Deep Domain Adaptation Network (DDAN):可跨域的特征识别方法,通过得到两个域的中间状态学习特征。capable of learning domain invariant features by particularlyaligning middle level representations of two domains

Dual Attribute-aware Ranking Network (DARN):通过属性标注以及跨域的特征对来学习

FashionNet:多任务识别

对于MTCT模型,有以下4种方式:

不迁移学习:直接将源数据训练的网络应用在目标数据中。这可以秀出神经网络的强大的泛化能力。

JAN:使用DARN作为基础,将DARN在源数据集中训练,直接在目标数据集中测试。

Uniteddomains:将源数据集和目标数据集合并,特征的泛化能力可以因为数据变多进一步提高。

微调的方法:经典的vanilla transfer learning,即fine-tuning

MTCT:这篇文章的方法

结果:

MTN(NoAdpt)比r JAN(NoAdpt) (DARN)有更好的泛化能力,说明多任务学习有助于提高精度。

MTN(UD)好于MTN(NoAdpt),说明源数据集和目标数据集差异大时,学习目标数据集中的特征是有必要的

MTN(FTT)要更好一些,fine-tune可提高精度有论文有相似的证明,此文中,先从源数据集中训练,再在街拍数据集中训练。有由易到难的训练策略。不过这种方式,没有用到图片对的这一有利信息。

这就是MTCT,由易到难,多层次信息。

训练数据大小对训练结果的影响

多个模型,选取原数据集的部分数据子集{100%,75%, 50%, 10%}用于训练,看他们几个的表现。