windows平台下安装配置Hadoop

安装配置流程

1.下载Hadoop软件:http://archive.apache.org/dist/hadoop/core/

此处下载版本hadoop-2.7.7,解压至目录(D:\job\hadoop\hadoop-2.7.7)

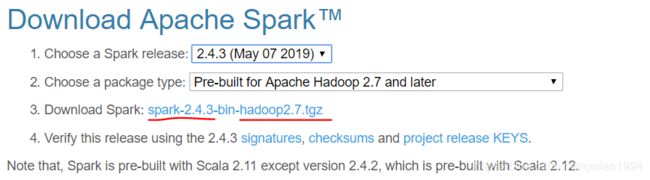

注:如果后续要安装Spark,那么最好安装和Spark版本对应的Hadoop版本

查看hadoop/spark对应版本:http://spark.apache.org/downloads.html

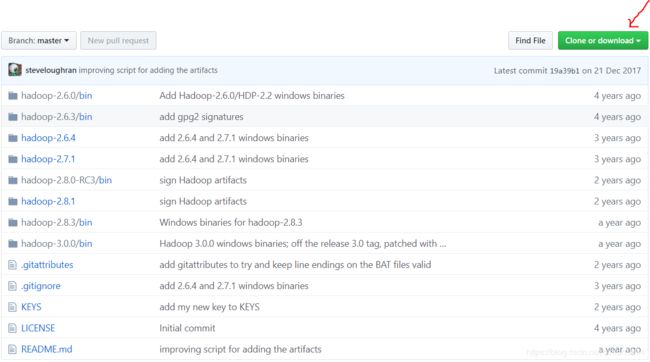

2.下载其他相关文件(编译后的二进制文件):https://github.com/steveloughran/winutils

文件解压缩后将其中hadoop-2.7.1下的bin目录移至此处(D:\job\hadoop\hadoop-2.7.7),去覆盖原有的bin目录

因为原有的bin目录下没有文件(winutils + hadoop.dll)

注:替换的文件版本要与下载的Hadoop保持对应

其他下载地址:https://pan.baidu.com/s/1o7YTlJO(文件名:hadooponwindows-master)

将目录hadooponwindows-master/bin移至此处(D:\job\hadoop\hadoop-2.7.7),去覆盖原有的bin目录

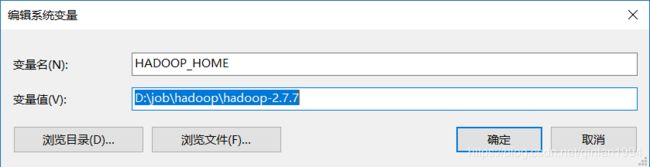

3.配置系统变量和环境变量

(1)系统变量:(变量名)HADOOP_HOME (变量值)D:\job\hadoop\hadoop-2.7.7

(2)环境变量(Path):%HADOOP_HOME%\bin

![]()

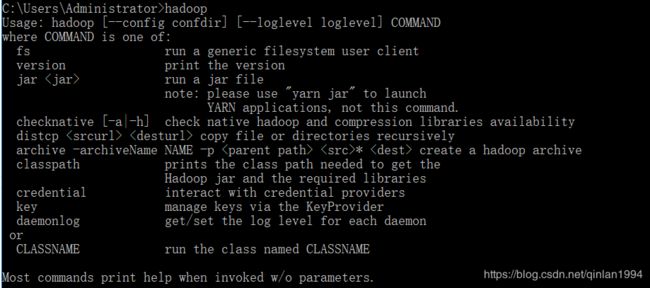

测试:调出CMD,输入hadoop,不报错则配置成功

4.将文件D:\job\hadoop\hadoop-2.7.7\bin\hadoop.dll复制到以下位置

D:\job\hadoop\hadoop-2.7.7\sbin

C:\Windows\System32

5.修改Hadoop配置文件

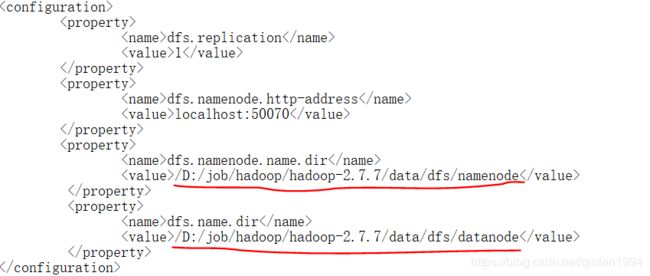

在修改前创建以下目录: D:\job\hadoop\hadoop-2.7.7\data

D:\job\hadoop\hadoop-2.7.7\data\dfs

D:\job\hadoop\hadoop-2.7.7\data\dfs\namenode

D:\job\hadoop\hadoop-2.7.7\data\dfs\datanode

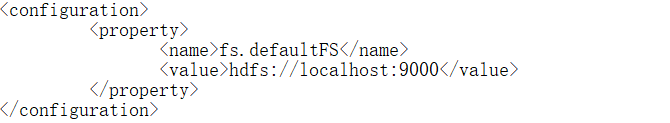

(1)编辑目录D:\job\hadoop\hadoop-2.7.7\etc\hadoop下的core-site.xml文件

(2) 编辑目录D:\job\hadoop\hadoop-2.7.7\etc\hadoop下的hdfs-site.xml文件

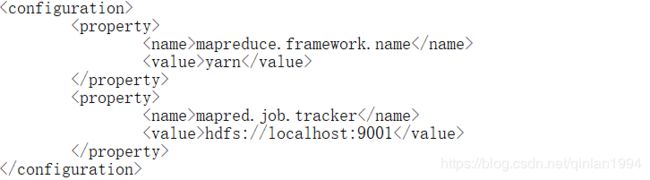

(3) 编辑目录D:\job\hadoop\hadoop-2.7.7\etc\hadoop下的mapred-site.xml文件

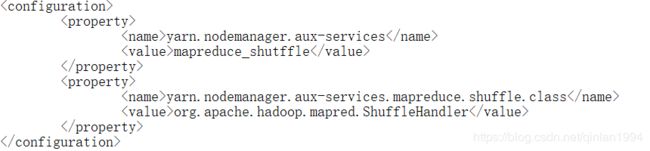

(4) 编辑目录D:\job\hadoop\hadoop-2.7.7\etc\hadoop下的yarn-site.xml文件

(5) 编辑目录D:\job\hadoop\hadoop-2.7.7\etc\hadoop下的hadoop-env.cmd文件

![]()

![]() 注:JAVA_HOME表示Java JDK的安装目录(安装Hadoop前必须安装JVM)

注:JAVA_HOME表示Java JDK的安装目录(安装Hadoop前必须安装JVM)

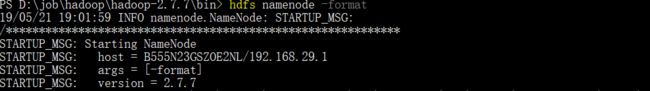

6.格式化HDFS(调出CMD,输入命令hdfs namenode -format)

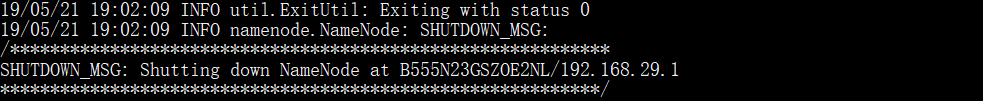

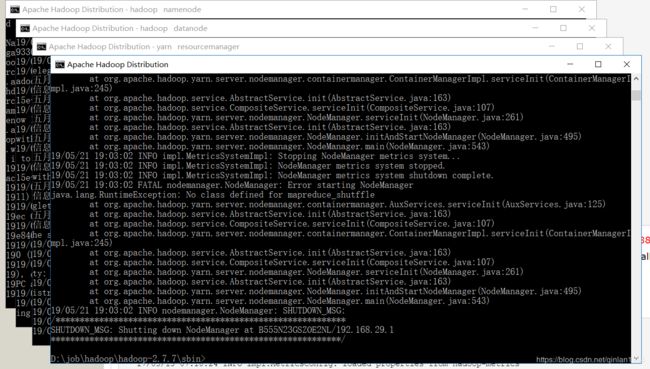

7.开启四个进程(切换至目录D:\job\hadoop\hadoop-2.7.7\sbin下,以管理员身份输入命令start-all.cmd)

测试是否开启成功:输入命令jps

8.测试Hadoop DFS

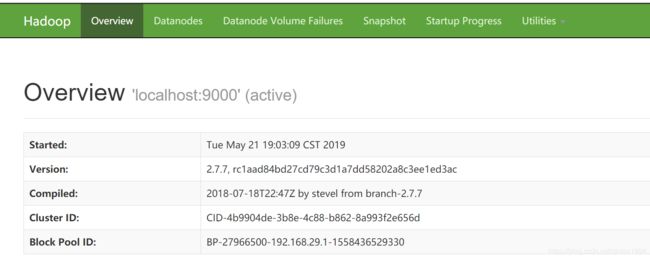

在浏览器地址栏中输入:http://localhost:50070查看Hadoop状态

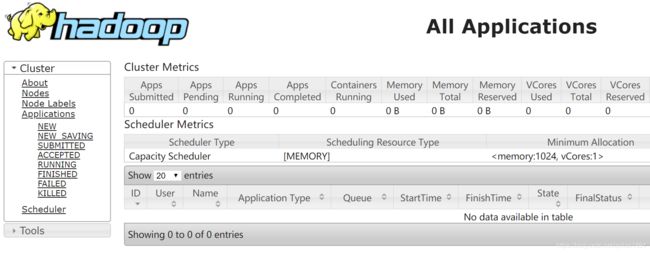

在浏览器地址栏中输入:http://localhost:8088查看集群状态

参考博客:https://www.jianshu.com/p/7dec5b348540