- 实战演练:用 AWS Lambda 和 API Gateway 构建你的第一个 Serverless API

实战演练:用AWSLambda和APIGateway构建你的第一个ServerlessAPI理论千遍,不如动手一遍!在前面几篇文章中,我们了解了Serverless的概念、FaaS的核心原理以及BaaS的重要作用。现在,是时候把这些知识运用起来,亲手构建一个简单但完整的Serverless应用了。本次实战,我们将使用AmazonWebServices(AWS)这个主流的云平台,结合它的两个核心Se

- orb-slam run rgbd data

hetongqiyue

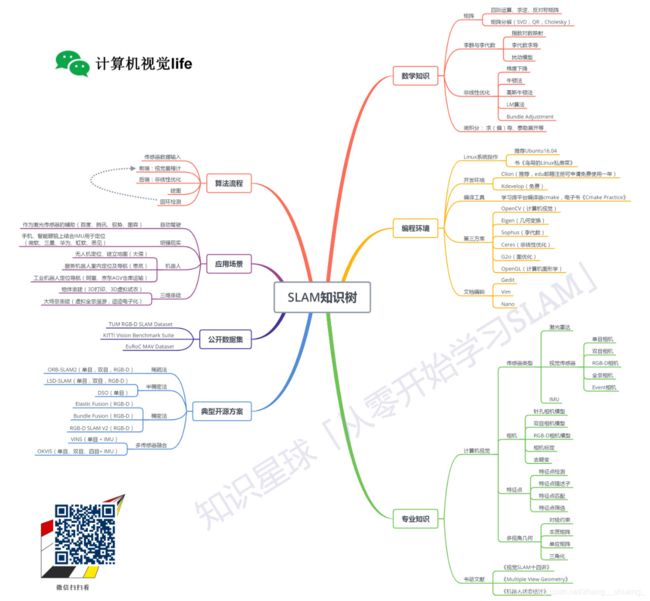

计算机视觉slam

TUM数据集准备+RGB-D运行从这个网址下载tum数据集[http://vision.in.tum.de/data/datasets/rgbd-dataset/download]并且解压缩。使用python脚本关联RGB图像和深度图像[associate.py],[http://vision.in.tum.de/data/datasets/rgbd-dataset/tools].我们已经提供了一

- Docker 与 Serverless 架构:无服务器环境下的容器化部署

you的日常

容器技术Docker性能优化实践dockerserverless架构容器

Serverless(无服务器)架构作为云计算领域的革命性范式,以其无需管理服务器、按需付费、自动伸缩的特性,正在改变着应用开发和部署的方式。然而,传统的函数即服务(Function-as-a-Service,FaaS),如AWSLambda,在运行时环境、部署包大小和复杂依赖管理方面存在一定的局限性。幸运的是,Docker容器的出现为Serverless带来了新的活力。容器的强大可移植性和环境一

- PL-SLAM: Real-Time Monocular Visual SLAM with Points and Lines

PL-SLAM文章目录PL-SLAM摘要系统介绍综述方法综述LINE-BASEDSLAM一、基于线的SLAM二、基于线和点的BA三、全局重定位使用线条初始化地图实验结果说明位姿求解三角化LSD直线检测算法**一、核心原理**⚙️**二、实现方法****三、应用场景**⚖️**四、优缺点与优化****优缺点对比****总结**End摘要译文——众所周知,低纹理场景是依赖点对应的几何计算机视觉算法的主

- Serverless成本优化实战:从资源浪费到精准管控的架构演进

知识产权13937636601

计算机serverless架构云原生

本文系统解析Serverless架构下的成本构成黑洞,揭示函数计算、存储服务、API网关等模块的资源浪费真相。基于电商、社交、物联网等行业的真实账单数据,深度剖析冷启动损耗、配置冗余、日志存储三大核心成本痛点。结合AWSLambda、阿里云函数计算等平台的最佳实践,给出冷启动优化、智能伸缩策略、存储分层设计等12项关键优化方案,并展望AI预测调度、多云成本博弈等前沿技术方向,为企业节省60%以上的

- AWS Cognito项目实战指南:集成用户管理与自定义电子邮件功能

一一MIO一一

本文还有配套的精品资源,点击获取简介:本项目涉及利用AWSCognito服务,创建一个基于云端的用户身份验证和管理应用。通过集成Cognito用户池,项目支持社交登录和自定义用户身份保护,同时涉及通过AWSLambda发送自定义电子邮件通知,增强用户体验。项目采用TypeScript编程语言,提升代码的可维护性和可读性,为开发者提供一个学习AWS无服务器认证解决方案的实践案例。1.AWSCogni

- 机器人系统导航里程计介绍

Xian-HHappy

机器人机器人人工智能算法里程计

一、引言在移动机器人的研究与应用领域,精准且实时地确定机器人的位置与姿态是实现其自主功能的关键。里程计作为达成这一目标的核心技术之一,在移动机器人的自主导航、路径规划、定位以及地图构建等诸多关键领域扮演着举足轻重的角色。随着机器人技术的持续演进,里程计已蜕变成为移动机器人实现SLAM(同步定位与地图构建)功能的基石。它通过对各类传感器所采集数据的精细计算与处理,运用增量式递推的策略,实时推算出机器

- AWS Lambda与RDS连接优化之旅

t0_54manong

编程问题解决手册aws云计算个人开发

在云计算的时代,AWSLambda与RDS的结合为开发者提供了高效且灵活的解决方案。然而,在实际应用中,我们常常会遇到一些性能瓶颈。本文将通过一个真实案例,探讨如何优化AWSLambda与RDS之间的连接,以提高API的响应速度。背景介绍最近,我们在AWS上部署了一个使用Dotnet6开发的API,它通过APIGateway暴露给外部,并连接到同VPC内的MySQLAuroraRDS数据库。部署前

- VINS-Mono 开源项目安装与使用指南

劳丽娓Fern

VINS-Mono开源项目安装与使用指南VINS-Mono项目地址:https://gitcode.com/gh_mirrors/vi/VINS-MonoVINS-Mono是一个专为单目视觉惯性系统设计的实时SLAM框架,旨在提供高精度的视觉惯性里程计。本指南将带你深入了解其目录结构、启动文件以及配置文件,帮助你快速上手并应用此项目。目录结构及介绍VINS-Mono的项目结构清晰地组织了不同的组件

- AWS 监控和管理服务 CloudWatch

wumingxiaoyao

BigDataaws大数据云计算CloudWatch日志监控

AWS监控和管理服务CloudWatch什么是CloudWatchCloudWatch工作原理CloudWatchlog收集方法通过AWSLambda发送日志到CloudWatchLogs使用CloudWatchLogsAgent发送日志通过AWSSDK或API将日志发送到CloudWatchLogs通过CloudWatchAgent将应用和系统日志发送到CloudWatchLogsCloudWa

- PHP云原生与Serverless架构深度实践

seopthonshentong

云原生phpserverless

在前六篇系列教程的基础上,本文将深入探讨PHP在云原生和Serverless环境下的高级应用,帮助开发者构建可扩展、高可用的现代化PHP应用。1.ServerlessPHP架构Bref与AWSLambda集成bash#安装Brefcomposerrequirebref/brefphpartisanvendor:publish--tag=serverless-configserverless.yml

- ROS的学习链接整理 (基于古月居)

辣椒炒月饼

学习机器人自动驾驶

机器人控制与仿真:http://wiki.ros.org/roscontrol机器人即使定位与地图建模:http://wiki.ros.org/gmappinghttp://wiki.ros.org/hectorslam机械臂相关学习:http://moveit.ros.org/斯坦福大学公开课———机器人学:https://www.bilibili.com/video/av4506104/交通大

- (02)Cartographer源码无死角解析-(72) 2D后端优化→OptimizationProblem2D-约束残差、landmark残差

江南才尽,年少无知!

机器人cartographerslam自动驾驶增强现实

讲解关于slam一系列文章汇总链接:史上最全slam从零开始,针对于本栏目讲解(02)Cartographer源码无死角解析-链接如下:(02)Cartographer源码无死角解析-(00)目录_最新无死角讲解:https://blog.csdn.net/weixin_43013761/article/details/127350885文末正下方中心提供了本人联系方式,点击本人照片即可显示WX→

- cartographer官方指导文件说明---第3章 cartographer前端算法流程介绍

从小练武功

前端算法

cartographer官方指导文件说明第3章cartographer前端算法流程介绍3.1ScanMatch扫描匹配扫描匹配(ScanMatching)是Cartographer中实现局部SLAM的核心技术,它通过优化算法将当前激光扫描数据对齐到子图地图中。下面从计算过程、数学模型、参数配置等多个维度进行全面解析:3.1.1扫描匹配工作流程完整处理流程低置信度高置信度原始扫描数据运动畸变校正体素

- 3.3 里程计在SLAM中的应用

小慧1024

ROS1快速入门指南ros机器人linux

启动仿真环境roslaunchwpr_simulationwpb_corridor_hector.launch可视化结果如图所示在Riz建图中存在问题换一种方式建图roslaunchwpr_simulationwpb_corridor_gmapping.launch由于历程计的参与,地图被顺利建成

- SLAM面试笔记(5) — ROS面试

几度春风里

SLAM项目实战面试机器人ros自动驾驶

目录1ROS概述2ROS通信机制问题:服务通信概念问题:服务通信理论模型问题:参数服务器概念问题:参数服务器理论模型问题:参数服务器实现函数3ROS常用命令4常见面试题问题:roslaunch和rosrun区别?问题:什么是ROS?问题:ROS中的节点是什么?问题:ROS的消息通信机制是什么?问题:如何创建ROS的工作空间?问题:ROS中常用的机器人控制库有哪些?问题:ROS中如何进行机器人导航?

- nerf-slam论文复现

搬砖者(视觉算法工程师)

gitpython深度学习

nerf-slam实现三维重建详细的在我文档里面(有图片步骤)TableofContentsInstallDownloadDatasetsRunCitationLicenseAcknowledgmentsContactInstallClonerepowithsubmodules:gitclonehttps://github.com/ToniRV/NeRF-SLAM.git--recurse-sub

- STM32和树莓派的分工

⚙️修正版:典型硬件组合与通信流程(以移动机器人为例)1.硬件分工:大脑vs四肢角色硬件运行软件核心任务是否直接运行ROS决策大脑树莓派4B/JetsonNanoUbuntu+ROS运行SLAM、导航、视觉识别等复杂算法✅是实时四肢STM32F4FreeRTOS/裸机读取电机编码器、控制电机PWM❌否传感器/执行器电机、激光雷达、IMU-执行动作/采集数据-2.为什么需要STM32?树莓派无法直接

- 第5.4章 SLAM实战:使用std::chrono计算传感器消息时间戳

行知SLAM

机器人工程师带你入门SLAMunixc++自动驾驶人工智能

在机器人及自动驾驶定位中,传入的IMU和激光的消息都需要判断其数据的正确性,其中,主要会判断消息的开机时间和观测时间,其中开机时间主要通过调用chrono的函数计算,观测时间主要由GPS的时间来获得(GPS观测时间已由上篇文章总结GPS时间计算)。std::chrono是C++11引入的时间处理库,提供了高精度、类型安全且跨平台的时间计算功能。它主要包含三个核心概念:duration:表示时间间隔

- 《用Java 8新特性重构代码:让项目更简洁高效》

Tech_Jia_Hui

Java8新特性java重构开发语言

1.Lambda表达式:简化匿名内部类1.1传统方式vsLambda表达式1.2集合遍历对比1.3事件监听器简化2.StreamAPI:革命性的集合操作2.1基本Stream操作示例2.2数值流操作2.3分组和分区3.Optional:优雅处理null3.1基本Optional用法3.2Optional实践示例4.方法引用:更简洁的Lambda4.1四种方法引用类型4.2方法引用实践5.新的日期时

- 基于AWS无服务器架构的区块链API集成:零基础设施运维实践

AWS官方合作商

awsserverless架构web3区块链

引言区块链开发常面临节点部署、网络维护和扩展性挑战。本文将介绍如何通过AWS全托管服务构建高可用的区块链API层,无需自建节点、无需管理服务器,实现快速接入主流区块链网络(如以太坊、比特币),并保证企业级安全性与扩展性。graphLRA[前端应用]-->B[AmazonAPIGateway]B-->C[AWSLambda]C-->D[AmazonManagedBlockchain]C-->E[Bl

- 【SLAM】基于拓展卡尔曼滤波实现激光雷达传感器和角点提取的机器人定位附matlab代码

matlab科研社

机器人matlab数据结构

✅作者简介:热爱科研的Matlab仿真开发者,擅长数据处理、建模仿真、程序设计、完整代码获取、论文复现及科研仿真。往期回顾关注个人主页:Matlab科研工作室个人信条:格物致知,完整Matlab代码及仿真咨询内容私信。内容介绍自主移动机器人定位是机器人学研究的核心问题之一。本文探讨了基于拓展卡尔曼滤波(EKF)融合激光雷达传感器数据和角点提取技术实现机器人定位的方法。通过深入分析激光雷达传感器的工

- 【ROS2】slam_toolbox建图详解

郭老二

ROSROS2SLAM

【ROS】郭老二博文之:ROS目录1、简介1)安装sudoaptinstallros-$ROS_DISTRO-slam-toolbox2)源码https://github.com/SteveMacenski/slam_toolbox3)官网https://joss.theoj.org/papers/10.21105/joss.027832、启动2.1启动slam_toolboxslam_toolb

- Python中日志输出配置

亚林瓜子

python开发语言logawslambdacloudwatchexception

问题在AWSlambdaPython中怎么样打印日志?Pythonimportlogginglogging.basicConfig()logging.getLogger("sqlalchemy.engine").setLevel(logging.INFO)logger=logging.getLogger()logger.setLevel(logging.INFO)上面是全局配置主要是如下配置:lo

- 视觉slam--框架

猿饵块

人工智能

视觉里程计的框架传感器VO--frontendVO的缺点后端--backend后端对什么数据进行优化利用什么数据进行优化的后端是怎么进行优化的回环检测建图建图是指构建地图的过程。构建的地图是点云地图还是什么信息的地图?建图并没有一个固定的形式和算法,地图的构建形式不是固定的,需要视SLAM的应用需求而定。

- 视觉slam十四讲实践部分记录——ch2、ch3

kikikidult

slam学习slamc++笔记

ch2一、使用g++编译.cpp为可执行文件并运行(P30)g++helloSLAM.cpp./a.out运行二、使用cmake编译mkdirbuildcdbuildcmake..makeCMakeCache.txt文件仍然指向旧的目录。这表明在源代码目录中可能还存在旧的CMakeCache.txt文件,或者在构建过程中仍然引用了旧的路径。我们需要彻底清理并重新开始。详细解决步骤步骤1:彻底清理源

- 【2D与3D SLAM中的扫描匹配算法全面解析】

Unpredictable222

SLAM算法自动驾驶自主导航算法opencvpclSLAMICPNDT

引言扫描匹配(ScanMatching)是同步定位与地图构建(SLAM)系统中的核心组件,它通过对齐连续的传感器观测数据来估计机器人的运动。本文将深入探讨2D和3DSLAM中的各种扫描匹配算法,包括数学原理、实现细节以及实际应用中的性能对比,特别关注激光雷达SLAM中的典型方法。一、扫描匹配数学基础与核心原理1.1刚体变换的数学表示扫描匹配的核心是求解刚体变换,在2D和3D空间中有不同的数学表示:

- cv::FileStorage用法

Feliz Da Vida

c++c++开发语言opencv

cv::FileStorage是OpenCV中的一个类,用于读取和写入结构化数据(如YAML、XML、JSON)。它非常适合保存和加载诸如:相机内参(K、D)位姿(R、T)IMU数据配置参数向量、矩阵、图像、列表等常见用途保存相机标定参数(标定后得到的.yml文件)配置文件读写(如SLAM、AR、CV项目)记录检测结果或轨迹数据使用示例✅1.写入YAML文件#includeusingnamespa

- 《视觉SLAM十四讲》自用笔记 第二讲:SLAM系统概述

BandieraRosa

slam笔记

在rm队伍里作为算法组梯队队员度过了一个赛季,为了促进和负责其他工作的算法组成员的交流,我决定在接下来的半个学期里(可能更快)读完这本书,并将其中的部分理论应用于我自制的雷达导航小车上。以下为第二讲的部分笔记:第二讲SLAM系统概述2.0目标1.理解一个视觉SLAM框架由哪几个模块组成,各模块的任务是什么。2.搭建编程环境,为开发和实验做准备2.1相机单目相机:只使用一个摄像头。无法通过单张照片获

- 【深度学习新浪潮】如何入门三维重建?

小米玄戒Andrew

深度学习新浪潮图像处理基石深度学习人工智能图像处理计算机视觉python视觉几何opencv

入门三维重建算法技术需要结合数学基础、计算机视觉理论、编程实践和项目经验,以下是系统的学习路径和建议:一、基础知识储备1.数学基础线性代数:矩阵运算、向量空间、特征分解(用于相机矩阵、变换矩阵推导)。几何基础:三维几何(点、线、面的表示)、射影几何(单应矩阵、本质矩阵、基础矩阵)、李群与李代数(SLAM中的位姿优化)。概率与统计:贝叶斯估计、概率图模型(SLAM中的状态估计)、随机过程(滤波算法如

- [黑洞与暗粒子]没有光的世界

comsci

无论是相对论还是其它现代物理学,都显然有个缺陷,那就是必须有光才能够计算

但是,我相信,在我们的世界和宇宙平面中,肯定存在没有光的世界....

那么,在没有光的世界,光子和其它粒子的规律无法被应用和考察,那么以光速为核心的

&nbs

- jQuery Lazy Load 图片延迟加载

aijuans

jquery

基于 jQuery 的图片延迟加载插件,在用户滚动页面到图片之后才进行加载。

对于有较多的图片的网页,使用图片延迟加载,能有效的提高页面加载速度。

版本:

jQuery v1.4.4+

jQuery Lazy Load v1.7.2

注意事项:

需要真正实现图片延迟加载,必须将真实图片地址写在 data-original 属性中。若 src

- 使用Jodd的优点

Kai_Ge

jodd

1. 简化和统一 controller ,抛弃 extends SimpleFormController ,统一使用 implements Controller 的方式。

2. 简化 JSP 页面的 bind, 不需要一个字段一个字段的绑定。

3. 对 bean 没有任何要求,可以使用任意的 bean 做为 formBean。

使用方法简介

- jpa Query转hibernate Query

120153216

Hibernate

public List<Map> getMapList(String hql,

Map map) {

org.hibernate.Query jpaQuery = entityManager.createQuery(hql);

if (null != map) {

for (String parameter : map.keySet()) {

jp

- Django_Python3添加MySQL/MariaDB支持

2002wmj

mariaDB

现状

首先,

[email protected] 中默认的引擎为 django.db.backends.mysql 。但是在Python3中如果这样写的话,会发现 django.db.backends.mysql 依赖 MySQLdb[5] ,而 MySQLdb 又不兼容 Python3 于是要找一种新的方式来继续使用MySQL。 MySQL官方的方案

首先据MySQL文档[3]说,自从MySQL

- 在SQLSERVER中查找消耗IO最多的SQL

357029540

SQL Server

返回做IO数目最多的50条语句以及它们的执行计划。

select top 50

(total_logical_reads/execution_count) as avg_logical_reads,

(total_logical_writes/execution_count) as avg_logical_writes,

(tot

- spring UnChecked 异常 官方定义!

7454103

spring

如果你接触过spring的 事物管理!那么你必须明白 spring的 非捕获异常! 即 unchecked 异常! 因为 spring 默认这类异常事物自动回滚!!

public static boolean isCheckedException(Throwable ex)

{

return !(ex instanceof RuntimeExcep

- mongoDB 入门指南、示例

adminjun

javamongodb操作

一、准备工作

1、 下载mongoDB

下载地址:http://www.mongodb.org/downloads

选择合适你的版本

相关文档:http://www.mongodb.org/display/DOCS/Tutorial

2、 安装mongoDB

A、 不解压模式:

将下载下来的mongoDB-xxx.zip打开,找到bin目录,运行mongod.exe就可以启动服务,默

- CUDA 5 Release Candidate Now Available

aijuans

CUDA

The CUDA 5 Release Candidate is now available at http://developer.nvidia.com/<wbr></wbr>cuda/cuda-pre-production. Now applicable to a broader set of algorithms, CUDA 5 has advanced fe

- Essential Studio for WinRT网格控件测评

Axiba

JavaScripthtml5

Essential Studio for WinRT界面控件包含了商业平板应用程序开发中所需的所有控件,如市场上运行速度最快的grid 和chart、地图、RDL报表查看器、丰富的文本查看器及图表等等。同时,该控件还包含了一组独特的库,用于从WinRT应用程序中生成Excel、Word以及PDF格式的文件。此文将对其另外一个强大的控件——网格控件进行专门的测评详述。

网格控件功能

1、

- java 获取windows系统安装的证书或证书链

bewithme

windows

有时需要获取windows系统安装的证书或证书链,比如说你要通过证书来创建java的密钥库 。

有关证书链的解释可以查看此处 。

public static void main(String[] args) {

SunMSCAPI providerMSCAPI = new SunMSCAPI();

S

- NoSQL数据库之Redis数据库管理(set类型和zset类型)

bijian1013

redis数据库NoSQL

4.sets类型

Set是集合,它是string类型的无序集合。set是通过hash table实现的,添加、删除和查找的复杂度都是O(1)。对集合我们可以取并集、交集、差集。通过这些操作我们可以实现sns中的好友推荐和blog的tag功能。

sadd:向名称为key的set中添加元

- 异常捕获何时用Exception,何时用Throwable

bingyingao

用Exception的情况

try {

//可能发生空指针、数组溢出等异常

} catch (Exception e) {

- 【Kafka四】Kakfa伪分布式安装

bit1129

kafka

在http://bit1129.iteye.com/blog/2174791一文中,实现了单Kafka服务器的安装,在Kafka中,每个Kafka服务器称为一个broker。本文简单介绍下,在单机环境下Kafka的伪分布式安装和测试验证 1. 安装步骤

Kafka伪分布式安装的思路跟Zookeeper的伪分布式安装思路完全一样,不过比Zookeeper稍微简单些(不

- Project Euler

bookjovi

haskell

Project Euler是个数学问题求解网站,网站设计的很有意思,有很多problem,在未提交正确答案前不能查看problem的overview,也不能查看关于problem的discussion thread,只能看到现在problem已经被多少人解决了,人数越多往往代表问题越容易。

看看problem 1吧:

Add all the natural num

- Java-Collections Framework学习与总结-ArrayDeque

BrokenDreams

Collections

表、栈和队列是三种基本的数据结构,前面总结的ArrayList和LinkedList可以作为任意一种数据结构来使用,当然由于实现方式的不同,操作的效率也会不同。

这篇要看一下java.util.ArrayDeque。从命名上看

- 读《研磨设计模式》-代码笔记-装饰模式-Decorator

bylijinnan

java设计模式

声明: 本文只为方便我个人查阅和理解,详细的分析以及源代码请移步 原作者的博客http://chjavach.iteye.com/

import java.io.BufferedOutputStream;

import java.io.DataOutputStream;

import java.io.FileOutputStream;

import java.io.Fi

- Maven学习(一)

chenyu19891124

Maven私服

学习一门技术和工具总得花费一段时间,5月底6月初自己学习了一些工具,maven+Hudson+nexus的搭建,对于maven以前只是听说,顺便再自己的电脑上搭建了一个maven环境,但是完全不了解maven这一强大的构建工具,还有ant也是一个构建工具,但ant就没有maven那么的简单方便,其实简单点说maven是一个运用命令行就能完成构建,测试,打包,发布一系列功

- [原创]JWFD工作流引擎设计----节点匹配搜索算法(用于初步解决条件异步汇聚问题) 补充

comsci

算法工作PHP搜索引擎嵌入式

本文主要介绍在JWFD工作流引擎设计中遇到的一个实际问题的解决方案,请参考我的博文"带条件选择的并行汇聚路由问题"中图例A2描述的情况(http://comsci.iteye.com/blog/339756),我现在把我对图例A2的一个解决方案公布出来,请大家多指点

节点匹配搜索算法(用于解决标准对称流程图条件汇聚点运行控制参数的算法)

需要解决的问题:已知分支

- Linux中用shell获取昨天、明天或多天前的日期

daizj

linuxshell上几年昨天获取上几个月

在Linux中可以通过date命令获取昨天、明天、上个月、下个月、上一年和下一年

# 获取昨天

date -d 'yesterday' # 或 date -d 'last day'

# 获取明天

date -d 'tomorrow' # 或 date -d 'next day'

# 获取上个月

date -d 'last month'

#

- 我所理解的云计算

dongwei_6688

云计算

在刚开始接触到一个概念时,人们往往都会去探寻这个概念的含义,以达到对其有一个感性的认知,在Wikipedia上关于“云计算”是这么定义的,它说:

Cloud computing is a phrase used to describe a variety of computing co

- YII CMenu配置

dcj3sjt126com

yii

Adding id and class names to CMenu

We use the id and htmlOptions to accomplish this. Watch.

//in your view

$this->widget('zii.widgets.CMenu', array(

'id'=>'myMenu',

'items'=>$this-&g

- 设计模式之静态代理与动态代理

come_for_dream

设计模式

静态代理与动态代理

代理模式是java开发中用到的相对比较多的设计模式,其中的思想就是主业务和相关业务分离。所谓的代理设计就是指由一个代理主题来操作真实主题,真实主题执行具体的业务操作,而代理主题负责其他相关业务的处理。比如我们在进行删除操作的时候需要检验一下用户是否登陆,我们可以删除看成主业务,而把检验用户是否登陆看成其相关业务

- 【转】理解Javascript 系列

gcc2ge

JavaScript

理解Javascript_13_执行模型详解

摘要: 在《理解Javascript_12_执行模型浅析》一文中,我们初步的了解了执行上下文与作用域的概念,那么这一篇将深入分析执行上下文的构建过程,了解执行上下文、函数对象、作用域三者之间的关系。函数执行环境简单的代码:当调用say方法时,第一步是创建其执行环境,在创建执行环境的过程中,会按照定义的先后顺序完成一系列操作:1.首先会创建一个

- Subsets II

hcx2013

set

Given a collection of integers that might contain duplicates, nums, return all possible subsets.

Note:

Elements in a subset must be in non-descending order.

The solution set must not conta

- Spring4.1新特性——Spring缓存框架增强

jinnianshilongnian

spring4

目录

Spring4.1新特性——综述

Spring4.1新特性——Spring核心部分及其他

Spring4.1新特性——Spring缓存框架增强

Spring4.1新特性——异步调用和事件机制的异常处理

Spring4.1新特性——数据库集成测试脚本初始化

Spring4.1新特性——Spring MVC增强

Spring4.1新特性——页面自动化测试框架Spring MVC T

- shell嵌套expect执行命令

liyonghui160com

一直都想把expect的操作写到bash脚本里,这样就不用我再写两个脚本来执行了,搞了一下午终于有点小成就,给大家看看吧.

系统:centos 5.x

1.先安装expect

yum -y install expect

2.脚本内容:

cat auto_svn.sh

#!/bin/bash

- Linux实用命令整理

pda158

linux

0. 基本命令 linux 基本命令整理

1. 压缩 解压 tar -zcvf a.tar.gz a #把a压缩成a.tar.gz tar -zxvf a.tar.gz #把a.tar.gz解压成a

2. vim小结 2.1 vim替换 :m,ns/word_1/word_2/gc

- 独立开发人员通向成功的29个小贴士

shoothao

独立开发

概述:本文收集了关于独立开发人员通向成功需要注意的一些东西,对于具体的每个贴士的注解有兴趣的朋友可以查看下面标注的原文地址。

明白你从事独立开发的原因和目的。

保持坚持制定计划的好习惯。

万事开头难,第一份订单是关键。

培养多元化业务技能。

提供卓越的服务和品质。

谨小慎微。

营销是必备技能。

学会组织,有条理的工作才是最有效率的。

“独立

- JAVA中堆栈和内存分配原理

uule

java

1、栈、堆

1.寄存器:最快的存储区, 由编译器根据需求进行分配,我们在程序中无法控制.2. 栈:存放基本类型的变量数据和对象的引用,但对象本身不存放在栈中,而是存放在堆(new 出来的对象)或者常量池中(字符串常量对象存放在常量池中。)3. 堆:存放所有new出来的对象。4. 静态域:存放静态成员(static定义的)5. 常量池:存放字符串常量和基本类型常量(public static f