支持向量机

线性可分支持向量机与硬间隔最大化

函数间隔与几何间隔

用点到超平面的距离来衡量预测为正类的确信度:

点距离超平面,离得越远越确信,离得越近越不确信。

使用点到超平面的举例表示预测的确信程度。

函数间隔:

w x + b 的符号与类标记 y 的符号是否一致,可以用来表示分类是否正确。

用量y(w·x+b)来表示分类的正确性及确信度。

|w·x+b|可以相对的表示点 x 离超平面的远近,因为该值与x到超平面的真正距离成正比例。

函数间隔表示的就是分类的正确性与确信度。

超平面(w, b)与样本点(xi, yi)的函数间隔为:

yi * (w·xi+b)

所有样本点到超平面函数间隔距离的最小值。

函数间隔如何变成几何间隔:

对分离超平面的法向量w加些约束。

例如,对w加入规范化||w||=1,使得间隔是确定的。

||w|| 是 法向量 w 的L2 范数。

点到超平面的几何距离(分别在超平面正/负侧)公式:

函数间隔和几何间隔关系和区别:

||w||=1 时,几何间隔和函数间隔相等。

超平面参数w和b成比例改变,超平面不变时,

函数间隔也按此比例改变,而几何间隔不变。

间隔最大化

我们的目标是求几何间隔最大的分离超平面。

分离超平面可以有无穷多个,但是几何间隔最大的分类超平面是唯一的。

间隔最大化的直观解释:

找到几何间隔最大的超平面意味着,以充分大的确信度对训练数据进行分类。

如何求几何间隔最大的分离超平面:

问题转换:

在约束条件下的最优化问题。

求最大的 1/||w|| 的问题,转换为最小化 1/2 ||w||(2), 另外附带有一个约束条件。

逻辑回归

决策树

解决哪些问题:

分类和回归

实现手段:

基于特征对实例进行分类。

决策树的抽象:

可以认为是规则的集合。

也可以认为是定义在特征空间与类空间上的条件概率分布。

优点:

模型可解释性强,分类速度快。

模型的学习和样本的预测:

学习是建立决策树的过程,预测是利用决策树模型对样本进行分类的过程。

3个步骤:

特征选择、决策树的生成和决策树的修剪。

决策树的构成:

结点:

内部节点,叶子节点。

内部节点表示特征,叶子节点表示分类。

一个内部节点表示一个特征取值,也表示一个条件。

有向边:

从根节点到叶节点的一条路径代表一条规则。

决策树性质:

把决策树看成一个if then规则。

它具有互斥完备性。

决策树与条件概率分布:

特征空间划分:

把特征空间划分成很多单元。

一个单元对应一个分类,对应一个小的特征空间。

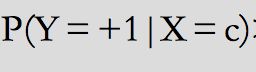

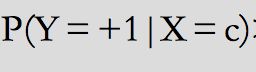

条件概率公式:

决策树学习:

已知N个样本,n个特征,K个分类。

需要什么样的决策树:

能很好分类训练数据,但同时具有很好的泛化能力。

决策树学习是由训练数据集估计条件概率模型。

6逻辑斯蒂回归与最大熵模型

最大熵模型

最大熵原理

用约束条件来确定概率模型的集合。

最大熵原理也可以表述为在满足约束条件的模型集合中选取熵最大的模型。

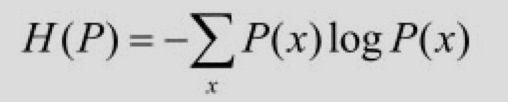

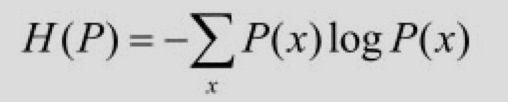

熵的定义:

熵与随机变量的取值个数成正比。

概率分布的越均匀,熵越大。

最大熵原理:

1、概率模型首先必须满足约束条件(已有的事实)

2、不确定的部分都是“等可能的”。

对随机变量的概率分布进行估计(学习):

通过最大熵原理,我们进行“均匀估计”。

最大熵模型的定义

最大熵原理推导得出最大熵模型。

假设分类模型是一个条件概率分布P(Y|X),X表示输入,Y表示输出。

特征和分类的联合分布:

v(X, Y)示训练数据中样本(X,Y)出现的频数

N表示训练样本容量

特征 P(X)的经验分布:

v(X=x)表示训练数据中输入x出现的频数

特征函数(featurefunction):

f(X,Y)描述输入x和输出y之间的某一个事实。

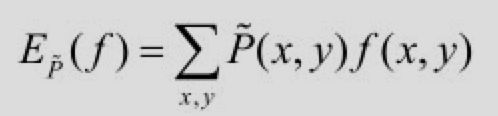

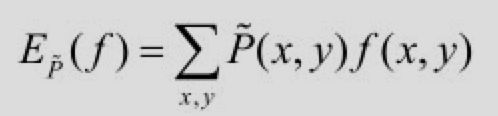

特征函数f(X,Y)关于经验分布P~ (X,Y)的期望值:

特征函数f(X,Y)关于模型P(Y|X)与经验分布P(X)的期望值:

根据条件概率公式两个期望值相等(模型的约束):

该式子就是模型P(Y|X)的约束条件。

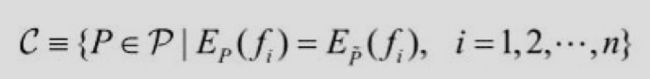

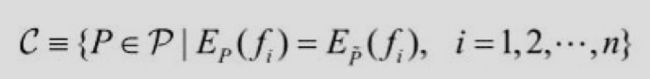

如果能找出n个特征函数fi(X,Y),i=1,2,…,n,那么就有n个约束条件

最大熵模型定义:

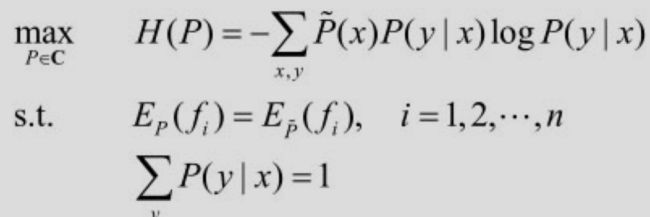

所有约束条件:

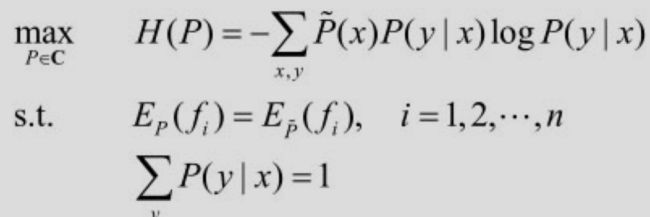

条件熵:

模型集合中条件熵H(P)最大的模型称为最大熵模型。

此处需要确认:约束是一系列约束,而最大熵模型是约束中的其中一个?

最大熵模型的学习

形式化为约束最优化问题:

给定的训练数据集T={(x1,y1),(x2,y2),…,(xN,yN)}

特征函数fi(X,Y),i=1,2,…,n。

步骤:

大部分推导省略

1、引进拉格朗日乘子w0,w1,定义拉格朗日函数

2、求解对偶最优化问题得到原始最优化问题的解(拉格朗日对偶性)

3、求解L(P,w)关于P的极小化问题

4、再求解L(Pw,w)关于w的极大化问题

隐马尔可夫模型

基本概念

定义

是关于时序的概率模型,

描述由一个“隐藏的马尔可夫链”随机生成“不可观测的状态随机序列”,

再由各个不可观测的状态生成一个观测而产生“观测随机序列”的过程。

“一个状态”--> “一个观测”,观测组成“随机序列”,即“观测序列”,

序列的一个位置又可以看成是一个“时刻”。

隐马尔可夫模型的概率分布组成:

初始概率分布

状态转移概率分布

观测概率分布。

隐马尔可夫模型的参数组成:

Q 状态集合:

N个状态。

注:每个状态都可以被观测,每个状态下都有M个观测结果(先验的)。

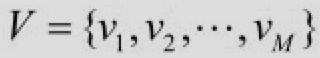

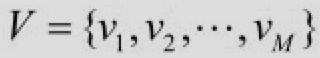

V 观测集合:

M个观测。

注:与N个关系:

并非简单的一一对应,一个状态下可以有多个观测。

I 状态序列 :

长度为T

注: T也代表T个时刻,每个时刻发生了一次状态转移。

状态序列分别由每个时刻的状态组成,

与状态的数量没有联系,即N是状态的个数,而T是状态之间按照状态转义矩阵转移T次。

因为状态间的转移是状态转义矩阵随机进行的,

实际的状态转移序列是有的状态间发生了转义,而有的状态间没有发生转义。

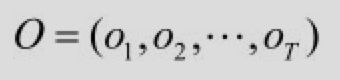

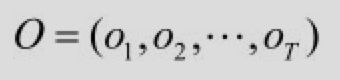

O 观测序列:

长度为T

注:每发生依次状态的转义都会对应一个观测结果,

T个时刻的状态转移对应的观测结果组成了一个观测序列。

即先有状态,再有观测结果。

而状态序列,和观测序列是按照时间推移同步生成。

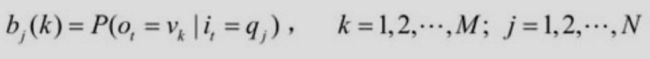

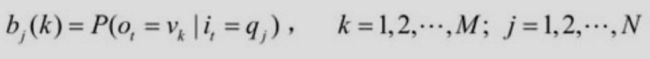

B 观测概率矩阵:

状态到观测的概率组合数: N个状态 * M个观测。

每个状态下的每个观测都有自己的先验概率。

b j(k)观测概率:

状态条件下观测的概率。

A 状态转移概率矩阵:

a ij状态间转移概率:

状态i到j的转移,

对应着时刻t到他t+1的转移。

注:不要被此处的t迷惑,因为状态转移本身就是需要跨两个时刻的。

矩阵形状是NxN的原因是N个状态间都会发生转移,如果先验中肯定没有转移

则定义为0。

π 是初始状态概率向量:

初始状态的时刻是t=1。

t=1时刻N个状态都有一个概率。

注:状态转移面临一个问题,即第一次状态发生,

转移转移系统第一次以哪一种概率来选择状态。

笔者注:

π 和 A决定状态序列,B决定观测序列。

{π, A, B} 构成了马尔科夫模型的三要素。

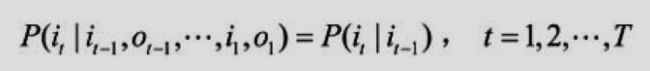

隐马尔科分模型的假设:

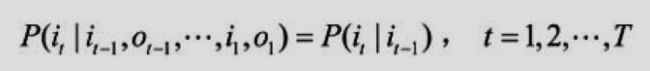

1、齐次马尔可夫性假设

假设隐藏的马尔可夫链在任意时刻t的状态只依赖于其前一时刻的状态,

与其他时刻的状态及观测无关,也与时刻t无关。

注:白话,状态只与前一个状态有关

2、观测独立性假设

假设任意时刻的观测只依赖于该时刻的马尔可夫链的状态,

与其他观测及状态无关

注:白话,当前观测结果只与当前状态有关。

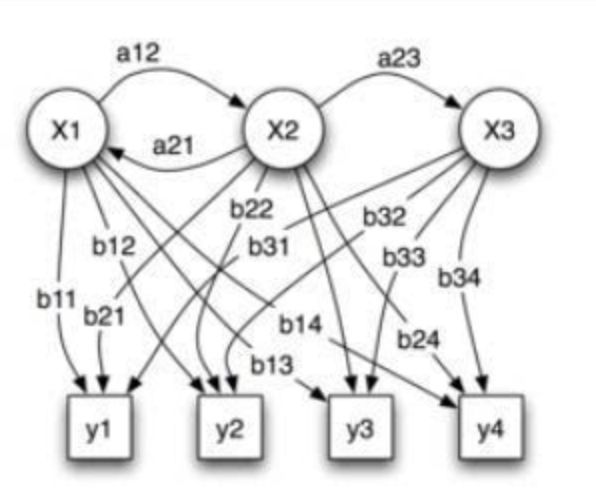

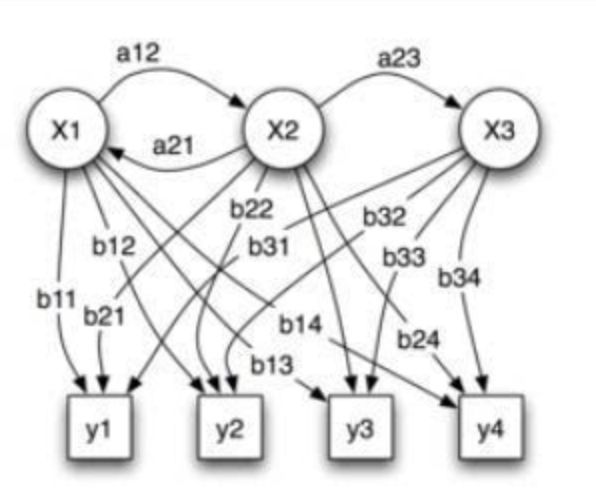

模型图例(来自于数学与算法之美):

模型的初始状态,没有表达出迁移过程。

X: 表示状态, y: 表示观测。

a: 迁移概率,b:观测概率