1. 安装必要组件

pip install django-haystack

pip install whoosh

ImportError: cannot import name 'six' from 'django.utils'错误,解决方法

2. 集成

项目的setting.py文件下INSTALLED_APPS加入haystack

在setting.py文件中配置全局搜索引擎

# 全文检索框架的配置

HAYSTACK_CONNECTIONS = {

'default': {

# 使用whoosh引擎

'ENGINE':'haystack.backends.whoosh_backend.WhooshEngine',

# 索引文件路径

'PATH': os.path.join(BASE_DIR,'whoosh_index'),

}

}

3.生成索引文件

在你需要搜索的app应用目录(我这里叫goods)下新建一个search_indexes.py文件,在其中定义一个商品索引类。填入如下代码

from haystackimport indexes

from apps.goods.modelsimport GoodsSKU

# 索引类名格式:模型类名+Index

# 指定对于某个类的某些数据建立索引

class GoodsSKUIndex(indexes.SearchIndex, indexes.Indexable):

# 索引字段 use_template=True指定根据表中的哪些字段建立索引文件的说明放在一个文件中

text = indexes.CharField(document=True,use_template=True)

def get_model(self):

# 返回你的模型类

return GoodsSKU

# 建立索引的数据

def index_queryset(self, using=None):

return self.get_model().objects.all()

这里只要改两个地方,一个是类名,另外一个是get_model中返回你要搜索的模型类

在templates下面新建目录search/indexes/goods,search/indexes是固定的,goods对应你的app名字,然后新建一个goodssku_text.txt的文件,命名前面的goodssku是你模型类的小写,后面的_text.txt是固定格式,里面写入代码

# 指定根据表中的哪些字段建立索引数据

{{ object.name }} # 根据商品的名称建立索引

{{ object.desc }} # 根据商品的简介建立索引

{{ object.goods.detail }} # 根据商品的详情建立索引

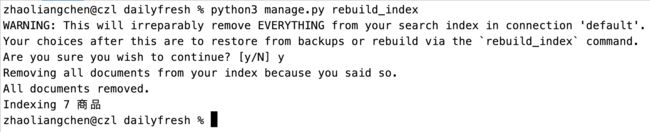

然后生成索引文件python3 manage.py rebuild_index

生成成功!

4. 搜索结果

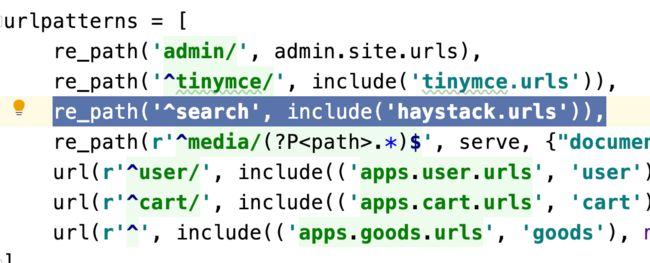

urlpatterns内配置re_path('^search', include('haystack.urls')),

search目录内创建search.html,作为显示搜索结果的页面

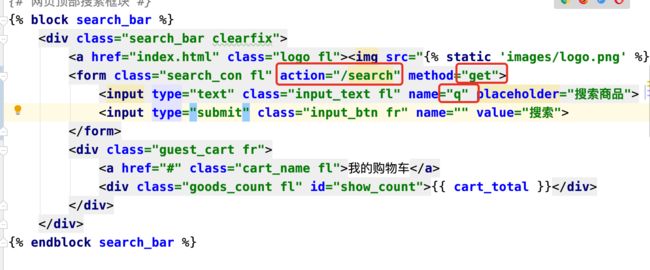

在提交搜索的页面中,搜索提交一定要用form表单形式,请求路径为search,method一定要是get,搜索内容的input的name要设置成q

点击标题进行提交时,会通过haystack搜索数据。

搜索出结果后,haystack会把搜索出的结果传递给templates/search目录下的search.html,传递的上下文包括:

query:搜索关键字

page:当前页的page对象 –>遍历page对象,获取到的是SearchResult类的实例对象,对象的属性object才是模型类的对象。

paginator:分页paginator对象

通过setting.py里面的HAYSTACK_SEARCH_RESULTS_PER_PAGE 可以控制每页显示数量。

5. 改变分词方式,使用结巴分词

安装jieba模块pip install jieba

进入/site-packages/haystack/backends/目录中,创建ChineseAnalyzer.py文件,贴入以下代码:

import jieba

from whoosh.analysis import Tokenizer, Token

class ChineseTokenizer(Tokenizer):

def __call__(self, value, positions=False, chars=False,

keeporiginal=False, removestops=True,

start_pos=0, start_char=0, mode='', **kwargs):

t = Token(positions, chars, removestops=removestops, mode=mode, **kwargs)

seglist = jieba.cut(value, cut_all=True)

for w in seglist:

t.original = t.text = w

t.boost = 1.0

if positions:

t.pos = start_pos + value.find(w)

if chars:

t.startchar = start_char + value.find(w)

t.endchar = start_char + value.find(w) + len(w)

yield t

def ChineseAnalyzer():

return ChineseTokenizer()

复制whoosh_backend.py文件,改名成whoosh_cn_backend.py

修改以下代码,头文件先引入from .ChineseAnalyzer import ChineseAnalyzer

代码中找到analyzer=StemmingAnalyzer()替换成analyzer=ChineseAnalyzer()

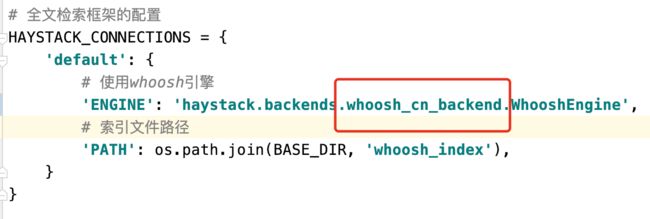

最后修改项目的配置文件: