论文学习笔记《Arbitrary-Oriented Ship Detection through Center-Head Point Extraction》

这是一篇2021刚刚挂在arXiv上的论文,作者提出了一种center-head point extraction based detector(命名为CHPDet)的网络,以实现遥感图像中的任意方向船舶检测。同时提出了一种新的用于固定ground sample distance(GSD)遥感图像中多类任意定向船舶检测的数据集,称为FGSD2021。最后在两个船舶检测数据集(即FGSD2021和HRSC2016)上进行了相关的实验。

论文链接:Arbitrary-Oriented Ship Detection through Center-Head Point Extraction

Abstract 摘要

遥感图像中的船舶检测在各种应用中起着至关重要的作用,近年来受到越来越多的关注。然而,现有的多角度船舶检测方法通常是在一组预定义的旋转锚框上发展起来的。这些预定义的框不仅导致不准确的角度预测,而且还引入额外的超参数和高计算成本。此外,现有的检测方法还没有充分利用船舶尺寸的先验知识,影响了检测精度的提高。针对上述问题,本文提出了一种基于头部中心点的检测器(CHPDet)来实现遥感图像中任意方向的船舶检测。我们的CHPDet模型将任意方向的船舶表示为带有头部点的旋转框,利用方向不变模型(OIM)生成方向不变特征映射。通过关键点估计来确定舰船的中心。然后,回归出船舶的尺寸和中心点。最后,我们使用target size(这里应该是先验框的方法)来微调结果。此外,本文还提出了一种新的固定地面采样距离(GSD)遥感图像中任意方向舰船检测数据集FGSD2021。在两个船舶检测数据集(即FGSD2021和HRSC2016)上的实验结果表明,我们的CHPDet达到了最先进的性能,能够很好地区分船首和船尾。代码和数据集将公开。

一、Introduction 介绍

基于高分辨率光学遥感图像的船舶检测在非法走私、港口管理、目标侦察等领域有着广泛的应用。最近几十年来,船舶检测受到了越来越多的关注,并得到了广泛的研究。然而,由于遥感图像中船舶的任意方位、密集停放场景和复杂背景,使得船舶检测成为一项极具挑战性的任务。为了处理多方向性问题,现有的方法通常使用一系列预定义的锚点,这有以下缺点。

1.角度回归不准确。

图1(a)-(d)展示了任意定向船舶的四种不同表示。由于遥感图像中的船舶通常是条带状的,因此IOU的分数对边界框的角度非常敏感。如图1(e)所示,GT框是宽高比为10:1的船舶边界框。红色旋转框是通过将GT框旋转5°的小角度来生成的。可以观察到,如此小的角度变化将这两个盒子之间的IoU减少到0.63。因此,基于锚点的检测器通过IoU分数定义正锚点和负锚点,通常会遇到不同锚点之间的不平衡问题,从而导致检测性能退化。此外,船舶的角度是一个周期函数,在边界(0°或180°处)是不连续的,如图1(f)所示。这种不连续性还会导致性能下降。

2.超参数过多和计算成本高

现有方法通常使用定向边界框作为锚来处理旋转的对象,从而引入过多的超参数,如框大小、纵横比和方向角。注意,这些超参数必须手动调整以适应新的场景,这限制了这些方法的泛化能力。预定义的基于锚的方法通常需要大量的锚框。例如,在RRPN中,在旋转的锚框中使用了6个不同的方向,并且在其特征图上的每个像素上总共有24个锚。在计算IoU分数和执行非极大值抑制(NMS)算法时,大量的锚盒会引入过多的计算开销。

3.未充分利用船舶的先验信息。

以往的船舶检测器大多直接采用与遥感和场景文本检测相同的旋转检测算法。然而,遥感图像中的舰船有其独特的特点。通过对遥感图像中某类船舶的地面样本距离(GSD)进行归一化处理,发现该类船舶在遥感图像中具有相对固定的尺寸范围。船的大小和船头的位置是探测的重要线索。然而,现有的方法没有充分利用这些先验信息。

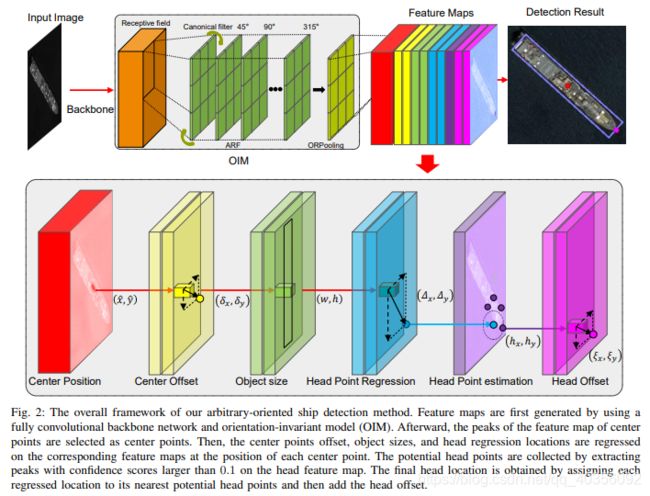

基于自然场景中的无锚点探测器CenterNet,本文提出了一种one-stage、无锚点、无NMS的遥感图像中任意方向船舶检测方法。我们把船描述成旋转的盒子,上面有一个代表方向的头部点。具体地说,方向不变特征映射首先由方向不变模型生成。然后,选择中心特征图的峰值作为中心点,在每个中心点的相应特征映射上回归偏移、对象大小和头部位置。最后,利用目标大小调整分类分数。我们的CHPDet的架构如图2所示。

(图2翻译:本文的总体框架是面向任意目标的船舶检测方法。首先利用完全卷积骨干网和方向不变模型(OIM)生成特征映射。然后选取中心点特征图的峰值作为中心点。然后,在每个中心点位置的相应特征地图上回归中心点偏移、对象大小和头部回归位置。通过在头部特征图上提取置信度大于0.1的峰值来收集潜在的头部点。最终的头部位置是通过将每个回归位置分配给其最近的潜在头部点,然后添加头部偏移来获得的。)

本文的主要贡献总结如下。

- 我们开发了一个one-stage,无锚船舶探测器CHPDet,具体来说,我们使用旋转框与头部点代表船舶。这种表示方法通过将角度回归任务转化为关键点估计任务来解决角度周期性问题,并将角度范围扩展到[0°-360°),从而可以区分船首和船尾。

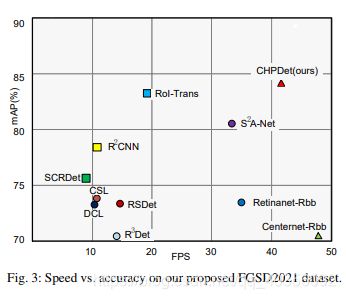

- 引入方向不变模型(OIM)生成方向不变特征映射,设计了一种基于先验信息的检测结果细化方法。在两个船舶检测数据集上的大量实验结果表明,我们的CHPDet在速度和精度上都达到了SOTA,如图3所示。

- 我们提出了一个新的数据集FGSD2021,用于固定GSD下遥感图像中多类任意方向的船舶检测。该数据集可以方便地利用船舶尺寸的先验知识,促进遥感船舶检测的实际应用。

二、Related work

在这一部分中,我们简要回顾了水平目标检测、旋转目标检测和遥感船舶检测的主要工作。

A. 水平目标检测

近年来,深度卷积神经网络(DCNN)已发展成为一种强大的特征表示学习工具,并在水平目标检测方面取得了显著的进展。现有的目标检测方法通常将目标表示为水平框,如图1(a)所示。根据检测方法的不同,基于深度学习的目标检测方法大致可以分为two-stage, single-stage, and multi-stage。two-stage检测器(例如,RCNN、Fast RCNN、Faster RCNN、Mask RCNN、R-FCN)使用预处理方法生成object proposals,并从生成的建议中提取特征以预测类别。相反,single-stage检测器(例如,YOLO系列、SSD、RetinaNet)没有预处理步骤,直接对特征图进行分类预测。多级探测器(例如,cascade RCNN,HTC)进行了多重分类和回归,从而显著提高了精度。综上所述,两级和多级探测器通常可以获得更好的性能,但单级探测器通常更具时间效率。与上述anchor-based的方法相比,anchor-free可以避免锚的要求,成为近年来新的研究热点。例如,CornerNet使用左上角点和右下角点在特征地图的每个位置检测对象。CenterNet将对象建模为中心点,并执行关键点估计以找到中心点并回归对象大小。FCOS预测了四个距离、一个中心分数和一个分类分数,并在特征图的每个位置来检测对象。上述方法在一般的目标检测任务中取得了显著的改进。然而,这些检测器只能生成水平边界框,这限制了它们的适用性。

B. 任意方向的目标检测

任意方向探测器广泛应用于遥感和场景文本图像中。大多数检测器使用旋转的边界框或四边形来表示多方向的对象,如图1(b)(c)所示。RRPN提出了旋转区域建议网络来提高区域建议的质量。在R2CNN中,生成了一个水平感兴趣区域(RoI)来同时预测水平框和旋转框。RoI-Trans将水平RoI转化为旋转RoI(rooi)。在SCRDet和RSDet中,新的损失函数被用来解决方向包围框( oriented bounding boxes)的边界问题。在R3Det中,针对特征失准问题,提出了一种改进的one-stage旋转检测器。在CSL和DCL中,角度回归被转化为处理边界问题的分类任务。在S2A网络中,提出了一种完全卷积层来对齐特征以获得更好的性能。上述方法需要一组锚箱进行分类和回归。这些锚点引入了过多的超参数,限制了泛化能力,并引入了过多的计算开销。目前,人们提出了几种无锚点的任意定向检测器(如O2D-Net和X-LineNet),通过预测一对相交线来检测定向对象。然而,这些方法所使用的特征不是 rotation-invariant,其性能仍然落后于anchor-base检测器。

C. 遥感图像中的船舶检测

与遥感图像中的其他物体不同,船舶是长条形的,具有较大的长宽比。一般来说,船舶的外形是一个近似五边形,两条平行的长边,船头的位置比较明显。因此,通过对遥感图像的GSD进行归一化处理,使得遥感图像中某类船舶具有相对固定的尺寸范围。

传统的船舶检测器一般采用由粗到细的结构,包括生成候选船舶和消除虚警两个阶段。例如,Shi等人首先通过将船舶视为异常来生成候选船舶,然后使用AdaBoost方法对这些候选船舶进行区分。Yang等人提出了一种基于显著性的候选区域生成方法,并使用支持向量机(SVM)对这些候选区域进行进一步分类。Liu等人引入了一个RRoI池层来提取旋转区域的特征。在R2PN中,作者提出了一种旋转区域建议网络来生成具有船舶方位角信息的arbitrary-proposals。上述检测器都基于一组锚点,不能充分利用船舶的先验信息。

三、PROPOSED METHOD

本节详细介绍了CHPDet的体系结构。该方法由6个模块组成,包括任意方向的船舶表示模块、特征提取模块、中心点检测模块、尺寸回归模块、头部点估计模块和概率细化模块。所有的船都是用带有一个头部点的旋转框来表示的。首先利用骨架和方向不变性模型(OIM)提取方向不变性特征映射,然后通过提取中心点和头部点来检测船舶,并对每个中心点的大小进行回归。最后,基于先验信息对检测结果进行细化。CHPDet的总体框架如图2所示。

A. 任意方向的船舶表示

如图1所示,由于包含了过多的冗余背景区域,因此广泛使用的水平边界框不能直接应用于任意方向的船舶检测任务。另外,由于任意方向的船舶长宽比大,停留密集,采用水平包围盒的NMS算法容易产生漏检。为此,许多方法将船舶表示为旋转边界框,这些框用5个元组(cx,cy,w,h,θ)参数化,其中(x,y)是旋转边界框中心的坐标,w和h分别是船舶的宽度和长度。角度θ∈[0°,180°)是长边相对于y轴的方向。这种表示可能导致边界情况附近的回归不一致问题。最近,一些检测器用4个顺时针方向的顶点来表示对象,这些顶点由8个元组(xa,ya,xb,yb,xc,yc,xd,yd)参数化。(xc,yc)是旋转边界框中心的坐标,w和h是船舶的宽度和长度,(xh,yh)是船舶头部点的坐标。由于四个角点的顺序,这种表示也会引入回归不一致性。为了避免上述不一致性问题,我们将船舶表示为两点及其相应的大小,并用6个元组(xc,yc,w,h,xh,yh)参数化。(xc,yc)是旋转边界框中心的坐标,w和h是船舶的宽度和长度,(xh,yh)是船舶头部点的坐标。船的方向是由连接中心和船头决定的。这种表示方法将不连续的角度回归转化为连续的关键点估计。这种表示法还将角度表示的范围扩展到[0°,360°,并使网络能够区分船首和船尾。

B.特征提取

输入空间的大小为(W,H,3),最终的输出特征图是(W/S,H/S,C+9),其中S是输出的步长,C是类别数。在本文中,我们将默认的步幅值设置为4。几个不同的主干(例如,deep layer aggregation (DLA)和hourglass network (Hourglass)可用于从图像中提取特征。我们遵循CenterNet的方法,用可变形卷积代替普通卷积,在输出头前添加256通道3×3卷积层,从而增强DLA。hourglass network由两个连续的hourglass module组成。Each hourglass module includes 5 pairs of down and up convolutional networks with skip connections(作者没有放图,而且不太能理解这个描述,后来我又去翻了这两个网络模型,个人觉得在目标检测领域用的不多,建议再铺垫一下)。这种网络通常产生更好的关键点估计性能。

从这些主干生成的特征不是任意方向的,而遥感图像中的船舶是以任意方向分布的。为了缓解这种不一致性,我们引入了一种方向不变模型(OIM),该模型由两个模块组成:active rotating filters (ARF) and oriented response pooling (ORPooling)。

(很遗憾的是这两个模块博主没有搞懂,所以这里就不放上相关的解释了,有需要的自己去扒原论文吧)

C.中心点检测

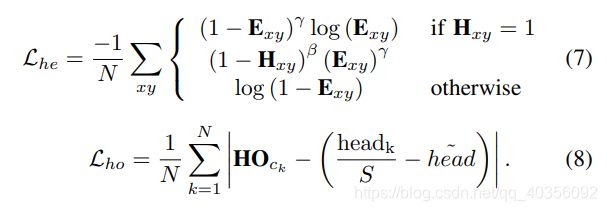

中心点的检测方法有点像密集人群计数,他对target map中的每个点都加上了一个二维高斯核函数,如果两个高斯核属于具有重叠区域的同一类,则取特征图中每个像素处的最大值。在训练的时候,只有中心点是正样本,其他点都是负样本,这可能会导致正负样本之间的巨大不平衡。为了处理不平衡问题,我们使用了variant focal loss:

其中γ和β是focal loss的超参数,N是图像 I 中的对象数,作用是归一化。我们在实验中根据经验设置γ=2和β=4,参考Cornernet论文中的设置。我们提取值大于或等于其8连通邻域的位置作为检测中心点。将峰值点的值作为其置信度的度量,并将特征图中的坐标作为获取其他属性的索引。图4(a)显示了中心和热图的可视化。

为了输出步长引起的量化误差,作者还使用了一个存储偏移量的特征图local offset feature maps,最终的中心点的计算公式就是:

![]()

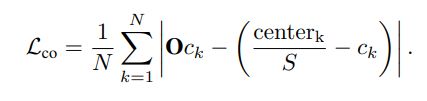

需要注意的是,所有的类别都共享相同的偏移预测,以减少计算复杂性。利用L1损失计算偏移量。中心点偏移量的损失就是:

D.尺寸回归

E. 头部点预测

我们执行两个步骤来更好地估计头部点。(个人理解:这里作者使用了两种方法来计算头部点的损失,这样可以更加细化头部点的预测)

1.基于回归的头部点预测

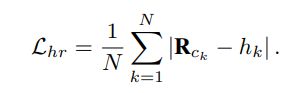

这里使用L1损失来计算

2. 自上而下的预测

分别使用variant focal loss和L1 loss来计算主干网络生成的Head point heatmap和local offset heatmap的损失。(头部点的预测用variant focal loss,然后头部点偏移量的损失用L1 loss)

自下而上的头部点估计与中心点检测相同。注意,在中心点检测中,每个类别都有一个中心点热图,而在头部点估计中,所有类别都共享一个头部点热图。(上述操作步骤的详细解释)我们提取所有置信度H0(x,y)>0.1的点作为一个潜在的峰点,然后通过添加偏移量(ξx,ξy)来细化潜在的head点位置。图4(b)显示了头部点热图。

最后,作者引入了一系列的加权因子来平衡各部分的贡献,在实验中设置参数为 λo = 1, λs = 0.1, λhr = 1, λhe = 1, and λho = 1。我们设置λs=0.1,因为损失的范围是从0到输出大小h/S。总的损失函数就是:

在测试阶段,我们首先提取每个类别的输出中心热图C上的中心点。我们使用3×3最大池层来获得峰值点,并选择前100个峰值作为潜在的中心点。每个中心点位置用整数坐标cˆ=(ˆx,yˆ)表示。然后取出中心点位置对应特征图上的偏移量(δx,δy)、尺寸(w,h)和头部点回归量(∆x,∆y)。我们还选取了 output center heatmaps上所有得分Ex,y>0.1的头部点,然后将每个回归后的位置headr = (ˆx + ∆x, ˆy + ∆y)分配给最近检测到的关键点作为头部点(hˆx, hˆy),然后加入头部点偏移量(ξx,ξy)来细化头部点估计。(注意理解这一段,我们可以对比yolo系列中的做法,yolo使用网格grid cell来分割整个特征图,每个框会被分配到某一个网格中,然后加上x和y的偏移量,w和h的偏移量;这里使用中心点来代替网格grid cell,每个预测的头部点会被分配到相应中心点上,然后同样加上头部点的偏移量)

最后我们用这六个参数来表示旋转框:

至于方向,我们使用连接中心点和头部点的直线来确定目标的方向。

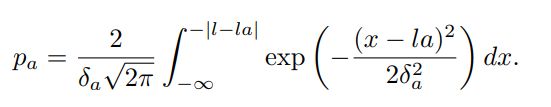

F.根据尺寸细化概率

通过对遥感图像的GSD进行归一化处理,使地面上相同大小的物体在所有图像中具有相同的大小。由于遥感图像中某一类型的目标通常有一个相对固定的大小范围,因此目标的大小是识别目标的重要线索。我们提出了一种基于船舶尺寸先验知识的目标置信度调整方法。如图4(d)所示,假设被检测框的类别为a,原始置信度为Sa,假设被检测船的长度服从正态分布,a类长度的均值和标准差为La,δa,则目标属于a的概率为pa,即。(参考图片,这就是一个简单的正态分布)

为了减少超参数,我们假设标准差与各类船舶的平均值成正比(δa = La × λ),那么就可以将两个概率相乘以获得最终检测置信度,pˆa=pa×Sa。

四、EXPERIMENTS

我们在FGSD2021数据集和公共HRSC2016数据集上评估了我们的方法。在本节中,我们首先介绍数据集和实现细节,然后进行消融实验,并将我们的网络与几种最先进的方法进行比较。

A.数据集

1.HRSC2016

HRSC2016数据集是一个具有挑战性的遥感图像船舶检测数据集,它收集了谷歌地球上的六个著名港口。训练集、验证集和测试集分别包括436张图像和1207个样本,181张图像和541个样本,444张图像和1228个样本。该数据集的图像大小范围为300×300到1500×900。该数据集包括三个级别的任务(即L1、L2和L3),这三个任务分别包含1个类、4个类和19个类。此外,该数据集中还给出了船舶的头部位置。在[44][30][27]之后,我们对任务L1的方法进行了评估。我们在训练阶段使用训练集和验证集,并在测试集上评估检测性能。

2.FGSD2021

现有的船舶数据集HRSC2016有以下缺点。首先,GSD是未知的,所以我们不能通过地面上物体的实际大小来获得图像中物体的大小。二是图像尺寸很小,与实际遥感图像检测任务不符。为了解决这些问题,我们提出了一个新的船舶检测数据集FGSD2021,该数据集具有固定的GSD。

我们的数据集是通过从公开的Google Earth收集高分辨率卫星图像开发的,Google Earth覆盖了一些著名的港口,如Dandiego、Kitsap Bremerton、Norfolk、Pearl Harbor, and Yokosuka。我们通常会在不同的日期获取同一个端口的多张图像,也有一些图像来自HRSC2016数据集。我们收集了636张标准化GSD图像,每像素1米。我们的数据集中的图像非常大,通常一个图像覆盖整个端口。图像宽度为157-7789像素,平均宽度为1202像素,高度为224-6506像素,平均高度为1205像素。我们的FGSD2021数据集分为424个训练图像和212个测试图像。训练集用于训练阶段。在测试集上评价了该方法的检测性能。FGSD2021包括5274个标记目标和20个类别。我们使用labelimg工具来标记船舶,角度范围是[0°,360°,主方向是船首方向。

B.实施细节

我们的网络是在PyTorch上用Intel Core i7-8700K CPU,NVIDIA RTX 2080Ti GPU实现的。我们使用Adam方法作为优化器,初始学习率设置为2.5×10−4。我们的网络训练了140个epoch,在第90个epoch学习率开始下降。在训练阶段,我们使用随机旋转、随机翻转和颜色抖动来增强数据。为了保持图像的GSD,我们以820的步长将所有图像裁剪成1024×1024个切片,并将其调整为512×512。将所有切片的检测结果进行融合,恢复原始图像的检测结果。最后,我们使用IoU阈值为0.15的旋转非最大值抑制(RNMS)来丢弃重复检测。在单个NVIDIA RTX 2080Ti GPU上测量了该网络的速度。

C.评估指标

框之间的IoU用于区分检测结果。采用平均平均精度(mAP)和头部方向精度来评价任意方向探测器的性能。

1.IOU

IoU是将重叠区域除以两个框的并集区域的结果。我们采用DOTA中的评估方法来计算IOU。

2.mAP

我们所有的实验都采用PASCAL VOC2007 metrics来计算mAP

3.头部方向精度

之前算法的预测角范围为0°~180°,不能区分船首和船尾。以两个旋转盒之间的IOU为基础的mAP作为唯一的评价标准,不能反映首位方向的准确性。为了解决这个问题,我们定义了一个额外的评估首尾方向的方法。即与GT相差小于10度就被认为是正样本TP。

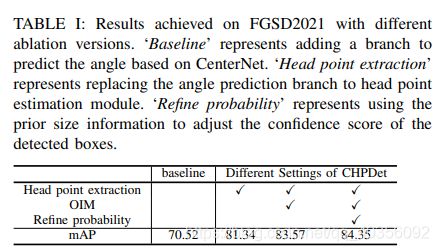

D.消融实验

1.CenterNet as baseline

作为一个anchor-free检测器,CenterNet 使用关键点估计以找到中心点,并在每个中心点位置回归对象大小。为了实现任意方向的船舶检测,我们增加了一个额外的分支来预测角度,称为CenterNet-Rbb。CenterNet Rbb使用DLA34作为主干,将船舶表示为带角度的旋转框,并使用L1损失函数优化角度回归特征图。我们设置加权因子λangle=0.1来平衡这些部分的贡献,因为损失的范围是从0到180。如表1所示,CenterNet Rbb实现了70.52的mAP,这表明我们的baseline达到了competitive performance。

FGSD2021在不同消融方式下获得的结果。“Baseline”表示基于CenterNet添加分支来预测角度。“Head point extraction”表示将角度预测分支替换为头部点估计模块。“Refine probability”表示使用先验大小信息来调整检测框的置信度。

2.Effectiveness of head point estimation

用头部点估计模块代替角度预测分支后,整体mAP由70.52提高到81.34。这是一个显著的改进,充分证明了头点估计方法的有效性。此外,头部点估计只引入了3个额外的channels feature maps 和0.7ms的速度延迟。为了进一步验证头部点估计对中心点检测和尺寸检测的促进作用,我们将GT和预测框的所有角度设置为0°。与CenterNet Rbb相比,CHPDet的mAP从84.4上升到88.0。这说明头部点估计相当于多任务联合训练。它加强了对网络的监督,提高了网络的性能。

3.Effectiveness of orientation-invariant model

我们在主干网络的末端加入一个方向不变的模型,并保持其他设置不变,以验证其有效性。如表1所示,与标准主干相比,具有方向不变模型的主干将mAP提高了约2个百分点,达到83.57,而只引入了2.6 ms的速度延迟。我们认为标准主干不是rotation-invariant,相应的特征对于角度是敏感的。因此,OIM的参与提高了目标与相应特征之间的一致性,不仅提高了角度预测的精度,而且提高了中心点检测和尺寸回归的精度。

4.Refine probability according to size

在我们设计的网络中,船舶的尺寸信息被用来提高被检测盒子的可信度。表1显示了测试集上不同消融版本的mAP值。可以观察到,基线模型达到了最低的mAP。当提高图像分辨率或使用更好的主干时,精度得到提高。当结合先验尺寸信息时,性能得到了提高。对低分辨率图像的影响更为明显,如从83.57到84.35,在地图上大约增加了1个百分点。结果表明,先验尺寸信息可以提高分类精度。

我们设置了一个方差系数来调整大小对概率的影响。在FGSD2021数据集中,每个类别的实际长度是确定的。例如,Ticonderoga-class cruiser的长度是172.8米。因此,我们使用该类型船舶的长度la乘以系数r作为该类型船舶的均方误差δa,δa=la×r。方差系数将影响分类精度。当系数较大时,不同类别之间的概率差异较小,船舶的尺寸大小对类别置信度的影响较小,反之亦然。从表二可以看出,当系数很小时,就相当于用大小作为分类对象的主要信息。但是,它会降低精确度。随着系数的增大,精度逐渐提高,当系数大于0.5时,系数对精度影响不大。当我们将所有类别作为一个类别处理,并去除类别对检测结果的影响时,mAP分别为89.33、89.52和89.74。同时,通过加入先验信息来调整分类置信度,在1024×1024分辨率图像下对20类目标检测得到88.95map,这表明加入先验信息后,几乎所有的分类都是正确的。

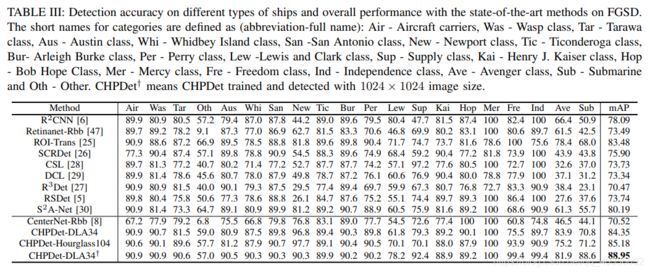

5. Bow direction accuracy

从表三可以看出,我们的CHPDet的艏向精度分别达到97.84、98.14和98.39。这表明,在检测到的TP中,几乎所有船舶的船首方向都是正确的。如图7所示,粉色点代表正确的头部点,绿色点代表错误的头部点。我们的检测算法可以很好的检测出所有类型的舰船的艏向,包括航空母舰、两栖舰船。只有少数船头和船尾相似的船舶或潜艇从鸟瞰的角度来看,船头的方向是相反的。

E.Comparison with other methods

在本节中,我们将我们的方法与其他具有代表性的船舶探测器进行比较,包括RetinaNet Rbb ROI-trans2、RRCNN、CSL、DCL、RSDet、SCRDet3和S2ANet4。为了公平比较,我们在DOTA数据集上使用了原始代码的默认设置,使用了相同的数据扩充策略,并且在所有实验中训练了大致相同的epoch.

1.Results on FGSD2021

图6示出了使用不同方法的若干检测结果。如第一行所示,所有其他方法都有误分类或虚警,S2A-Net有不准确的角度预测,而我们的方法精确地检测到它们。对于图6第二排的密集停船场景,所有参与对比的检测器至少损失了两艘潜艇,而我们的方法不受密集停船场景的影响。图6的第三排是具有复杂背景的港口。注意,两艘船不是在水里而是在干船坞上。ROI trans和S2A-Net没有检测到目标,SCRDet的边界框不准确。与这四种方法相比,我们的方法能更好地检测复杂背景下的舰船,对复杂环境具有更强的鲁棒性。

从表三可以看出,在19.2fps的速度下,ROI-trans的准确率为83.48,而在41.7fps的速度下,我们算法的准确率比ROI-trans高1.02个百分点。我们的算法在两倍于ROI传输速度的情况下达到了最高的精度。当使用高分辨率图像时,精度可大幅度提高,达到88.95。为了进一步验证预测的准确性,我们逐步提高IoU阈值。从表四可以看出,当IOU阈值逐渐增大时,其他检测器的性能明显下降,而我们的检测器下降幅度相对较小。当IOU阈值增加到0.8时,CHPDet的mAP保持在72.28。这表明我们的检测器可以得到比其他算法更高质量的旋转盒。

2.Results on HRSC2016

在HRSC2016数据集上,我们的方法和一些最新方法的性能比较结果如表五所示。(这里作者的描述和图片不符,后期我去验证一下R2CNN[6]的主干网络是VGG16还是Resnet101)。RRPN将精度提高到79.08。ROI Trans引入了一个显著的性能改进,精确度为86.20。R3Det使用渐进回归方法将性能从86.20提升到89.26。S2A-Net对齐功能可在90.17的精度下实现更好的性能。我们的方法取得了最好的性能,精确度为90.55

五、结论

本文充分利用船舶的先验知识,提出了一种one-stage和anchor-free的检测框架,用于从遥感图像中检测任意方位的船舶。该方法通过提取船舶的中心、头部来检测船舶,并利用旋转不变的特征对每个中心点的船舶尺寸进行回归。与anchor-based的方法相比,CHPDet避免了复杂的锚的设计和计算,并且可以在很大范围内精确地预测角度[0°-360°]。实验结果表明,与现有的船舶检测器相比,该方法具有更好的检测精度和效率,特别是在复杂情况下。

六、Write in the end

这篇论文貌似这几天才挂到arXiv上,有点rainbow的意思,但是从创新性和准确率方面来看,我觉得还是有很多可以思考的地方。后续我会补上对这篇论文的一些思考和个人的见解~