图小样本学习方法调研

基于图网络的few-shot detection论文总结(上) - Kristina王的文章 - 知乎 https://zhuanlan.zhihu.com/p/217431724

这几天读了一些关于用图网络对少样本进行目标检测的论文,发现今年顶会接收的关于此方向的文章有点“换汤不换药”的味道。

1、《Knowledge Graph Transfer Network for Few-Shot Recognition》AAAI 2020

是一篇关于知识图谱迁移网络小样本识别的论文。

Abstract

Few-shot learning 是在训练样本足够的情况下,从很少的样本中学习新的类别。这项任务的主要挑战是新类别容易被对象的颜色、纹理、形状或背景上下文(即特殊性)所决定,这些特征对于给定的少量训练样本来说是不同的(也即深度学习模型从少量的训练样本中学不到有效的通用的特征),但对于相应的类别则不常见(如下图)。幸运的是,我们发现基于类别的传递信息分类可以帮助学习新的类别,从而避免新类别被专有的特征所控制。此外,加入不同类别之间的语义关联(incorporating semantic correlations)可以有效地规范这种信息传递。在这项工作中,我们以结构化知识图谱(structured knowledge graph)的形式表示语义相关性(semantic correlations),并将该图集成到深度神经网络中,以通过新颖的知识图谱迁移网络(KGTN)促进少样本学习。具体来说,通过使用对应类别的分类器权重初始化每个节点,学习了一种传播机制,通过图自适应地传播节点消息,探索节点之间的交互,并将基类别的分类器信息传递给新类别的分类器信息。在ImageNet数据集上的大量实验表明,与目前领先的竞争对手相比,本文提出的算法性能有所提高。此外,我们构建了一个ImageNet-6K数据集,该数据集涵盖了更大规模的类别,即6000个类别,在该数据集上的实验进一步证明了我们提出的模型的有效性。

例如:

图解:SGM和我们提出的模型的可视化结果。 第一列显示了不同类别的唯一训练样本。 接下来的三列显示了两个模型都正确分类的示例。最后三列显示了被SGM模型错误分类(过拟合)但被我们模型正确分类的样本。可以看出,SGM模型可以很好地对与训练图像高度相似的样本进行分类,但在外观差异较大的样本中失败。 相比之下,我们提出的模型在更多外观模式上显示出出众的性能。

Method

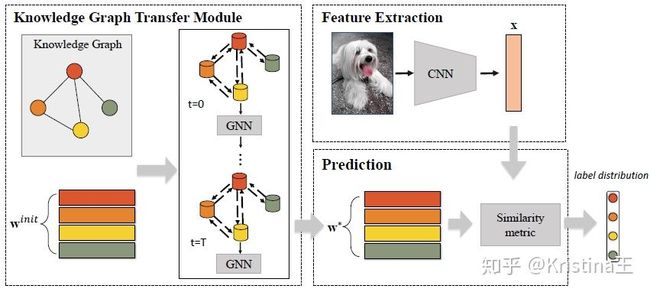

图解:本文提出的知识图谱迁移网络(KGTN)模型。主要包含特征提取模块、知识图谱迁移模块、预测模块。它结合了类别相关性的先验知识,有助于探索所有类别的分类器权重之间的相互作用,从而更好地学习新类别的分类器权重。

其中, 是可学习的参数,在训练前随机初始化。在每次迭代t时,每个节点k都会聚合来自其相关节点的消息,以使这些节点的参数向量可以帮助优化其参数向量。这样,节点k和k0之间的高度相关性促使消息从k0传播到k,否则会抑制传播。然后,框架将汇总后的特征向量和上一次迭代的隐藏状态作为输入,通过门控机制更新相应的隐藏状态。这样,模型就倾向于采用相关性更强的消息来更新当前节点的参数。通过T次迭代,我们可以得到最终的隐藏状态。最后,利用一个简单的输出网络来预测分类器的权值。

KGTN模型设计的关键是知识图传递模块,在此模块中,我们加入了一个图神经网络,在卷积网络的基础上,通过语义关联的指导来探索原型(分类器权重)的知识传递。

Knowledge Graph Transfer Module:我们将分类器权重建模成一个图,其中节点表示分类器权重,边表示它们的语义相关性。然后,利用控制门图神经网络(Gated Graph Neural Network (GGNN) )在节点之间更新和传播信息。

给定包含K = Kbase + Knovel类别的数据集(Kbase和Knovel表示基类和新类的数量),我们使用图 编码所有类别之间的关系,其中节点 表示类别( 表示类别节点的特征信息),边 表示类别i和j之间的关联(邻接矩阵)。

Prediction with different similarity metrics:用不同的相似度指标进行预测。

分类器 可以实现为相似度度量。我们考虑三个相似度指标来评价: 内积、余弦相似度和皮尔逊相关系数。

Experiment

Graph Construction

知识图对不同类别之间的关联进行编码。它可以根据不同的先验知识来构建。在这里,我们介绍了两种知识,即语义相似度( semantic similarity)和类别层次(category hierarchy)。

Semantic similarity:

特定类别的语义词很好地承载了其语义信息,两个类别的语义距离编码了它们的相关性。 换句话说,如果两个类别的语义距离较小,则它们之间的相关性较高,否则,它们之间的相关性就较低。首先利用此属性来构造图。 具体来说,给定具有语义词wi和wj的两个类别i和j,我们首先使用GloVe模型(Pennington,Socher和Manning 2014)提取其语义特征向量fw i和fw j,然后计算其欧几里得距离dij。 然后,我们应用一个单调递减函数aij 将距离映射到相关系数aij。

Category hierarchy:

范畴层次通过不同层次的概念抽象对范畴关联进行编码。一般来说,从一个类别到另一个类别的距离表示它们之间的相关性,其中距离小表示相关性高,而距离大则表示相关性低。在这项工作中,我们也利用基于WordNet(Miller 1995)的知识来构造图。具体来说,在给定i和j两类情况下,我们将节点i到j的最短路径计算为距离dij,并应用类似的单调递减函数将距离映射到相关系数aij。

Datasets:

与以往的低分辨率图像和新类别的few-shot基准不同,我们考虑具有较多基类和新颖类别的更现实的数据集:ImageNet Few-Shot(ImageNet-FS)数据集。为了进一步验证我们的方法,我们构建了更具挑战性的数据集ImageNet-6K,它涵盖了5,000个新颖类别。

miniImageNet:包含100类共60000张彩色图片,其中每类有600个样本,每张图片的规格为84×8484 \times 8484×84。通常而言,这个数据集的训练集和测试集的类别划分为:80:2080:2080:20。相比于CIFAR10数据集,miniImageNet数据集更加复杂,但更适合进行原型设计和实验研究。

小样本学习数据集:

小样本学习数据集_追随梦想,实现梦想-CSDN博客blog.csdn.net

当小样本遇上机器学习 fewshot learning:

当小样本遇上机器学习 fewshot learningblog.csdn.net

一口气读完这篇文章,发表一下个人意见(勿喷):

(a)在构造图中使用的两个模型,GloVe模型与WordNet,我个人觉得并没有什么新意,跟几年前那种语义嵌入并没有区别啊?只是把语义嵌入到图网络?反而觉得这样做使得算法以及模型都复杂了。这样做与不采用图网络性能提升的空间有多大???

(b)流程图中整体是怎么训练的?整个流程图画的非常模糊不清,训练时,是怎么反馈调节的?等等等等。。。测试时,图网络输出的就仅仅是分类器的权重,难道拿分类器的权重与特征提取模块得到的图像的特征向量做一个相似度量就可以了???还有参数怎么传递的?loss函数呢?很多东西没有讲清楚。

(c)miniImageNet数据集中的语义相似度凭借的是什么原则?举个栗子,难道是标签中的自行车和摩托车的单词相似度还是物体类别的相似?我都开始怀疑Reviewers的水平了。。。。只希望作者尽快公开代码,来消除我的疑惑。。。

(d)针对少样本目标检测的模型与算法有很多啊,不要为了发文章而非得弄出点“新颖”的东西,使得问题复杂化。既然投顶会,得真正有底气去讲清楚算法啊。看完这篇文章,总结着总结着就不想总结了。。。。

2、《Semantics-Preserving Graph Propagation for Zero-Shot Object Detection》2020 TIP

Abstract:

大多数现有的目标检测模型都局限于从先前看到的类别中检测目标,这种方法对于稀有或新颖的类别往往变得不可行。因此,在本文中,我们在zero-shot learning的背景下探索物体检测,即Zero-Shot Object Detection(ZSD),以同时识别和定位新类别中的物体。现有的ZSD算法通常基于一种严格的映射传输策略,该策略存在明显的视觉语义差距。为了弥补这一缺陷,我们提出了一种基于图卷积网络(GCN)的保持语义的ZSD图传播模型。更具体地说,我们开发了一个图构建模块,以通过利用类别节点之间的各种相关性来灵活地构建类别图。接下来是两个保留语义的图传播模块,这些模块增强了类别和区域表示形式。利用多步骤图传播过程,可以有效利用先验类别图中所表现出的语义描述和结构知识,提高学习投影函数的泛化能力。对三种常用的目标检测数据集的可见/不可见分割的实验表明,该方法优于最新的ZSD方法。

3、《Few-Shot Image Recognition with Knowledge Transfer》2019 ICCV

Abstract

人类只需浏览一些新类别的例子,就能很好地识别这些新类别的图像。一个可能的原因是,他们从先验知识中获得了一些关于这些类别的外部区分性视觉信息。受此启发,我们提出了一种新颖的知识传输网络体系结构(KTN),用于少张图像识别。所提出的KTN模型将视觉特征学习,知识推断和分类器学习共同结合到一个统一的框架中,以实现最佳兼容性。首先,基于余弦相似度优化的卷积神经网络,学习新颖类别的视觉分类器。 为了充分探索先验知识,然后开发了语义-视觉映射网络来进行知识推断,这使得能够从基本类别中推断出新颖类别的分类器。最后,我们设计了一种自适应融合方案,通过有效整合上述知识和视觉信息来推断所需的分类器。在两个广泛使用的Mini-ImageNet和ImageNet Few-Shot基准上进行了广泛的实验,以评估该方法的有效性。结果表明,与现有的方法相比,该方法具有良好的性能,特别是在1-shot和2-shot任务上。

PS:感觉这篇文章跟第一篇思路差不多,但是比第一篇讲的清楚一点。

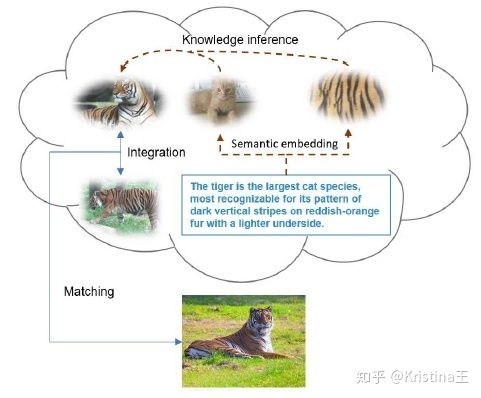

例如:

给定一个有标签的老虎图像,人们对老虎有一定的先验知识(如“猫种”和“暗竖条纹”),然后进行知识推理(knowledge inference),生成有区别的老虎视觉信息。该方法模拟了这一过程,提高了few-shot 的识别性能。

核心思想

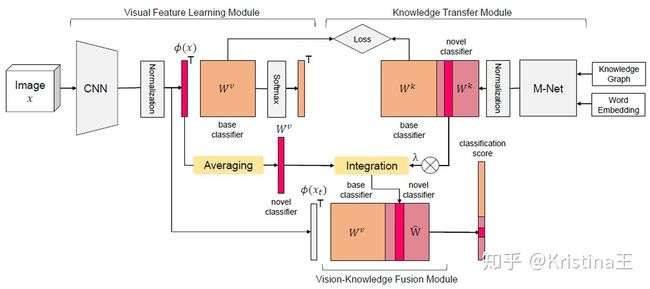

本文提出一种基于语义信息的小样本学习算法(KTN)。作者称其为知识迁移(Knowledge Transfer),但其实就是利用目标的标签包含的语义信息作为一种先验知识,来辅助目标分类。整个模型分成视觉特征学习模块(Visual Feature Learning Module),知识迁移模块(Knowledge Transfer Module)和视觉-知识融合模块(Vision-Knowledge Fusion Module),整个网络的结构如下图所示。

本文提出的用于few-shot 图像识别的知识传输网络体系结构(KTN)的说明

参考:

论文阅读笔记《Few-Shot Image Recognition with Knowledge Transfer》blog.csdn.net